|

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">大模型的长期记忆一直是"甜蜜的负担"——功能强大但成本高昂。浙江大学团队推出的LightMem系统,通过模仿人脑的三层记忆架构(感知记忆→短期记忆→长期记忆),实现了"鱼与熊掌兼得":在GPT-4o和Qwen模型上,准确率提升最高10.9%,同时token消耗降低117倍,API调用减少159倍。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">AI的智慧不在堆砌算力,而在优雅地过滤噪声、分割语义、异步整合。当AI学会了"睡觉",它可能也学会了"选择"——而有选择的记忆,才是有立场的智能。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;display: table;color: rgb(255, 255, 255);background: rgb(15, 76, 129);">当ChatGPT"失忆"时,你的职业生涯在冒险ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">想象这样一个场景:ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">你是一位产品经理,过去三个月一直在和AI助理讨论新产品战略。某天你问它:"我们之前决定砍掉的那个功能是什么?"ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">它回答:"抱歉,我不记得我们讨论过砍掉功能。"ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">你惊出一身冷汗——那是一个关键决策,现在你必须翻遍聊天记录,或者更糟,凭记忆重新推演。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">这不是科幻,这是当下AI助理的真实困境。 更讽刺的对比是:你的大脑能清晰记得十年前某个夏日午后,朋友随口提到的一句话;而ChatGPT,可能刚过半小时就"忘了"你说过喜欢喝拿铁。 这不是大模型"不够聪明",而是现有记忆系统"太过笨重"。想象你雇了一个助理,每次对话他都要把所有聊天记录从头读一遍——包括"今天天气不错"这种废话。他确实记性很好,但速度奇慢,而且每次"回忆"都要收费。 这不是小问题。当Siri忘记你的咖啡偏好,你笑笑就过去了。但当你的AI私人助理忘记你三个月前布置的战略任务,或者把你对竞品A的评价错误关联到竞-品B——这可能导致决策灾难。记忆,是AI从'工具'进化为'伙伴'的最后一道门槛。 现在,浙江大学团队提出的LightMem,试图用一个反直觉的思路破局:让AI学会"遗忘"——准确说,是学会像人脑一样,优雅地过滤、分层、异步处理记忆。 结果令人震撼:在保持甚至提升准确率的前提下,token消耗降低117倍,API调用减少159倍,运行速度提升12倍。 如果每1k token成本0.01美元,处理500个长对话场景: 成本降低98%,准确率反而提升8%。 这不是简单的工程优化,而是一场关于"记忆哲学"的范式革命。

一、记忆系统的"不可能三角":准确、实时、经济,只能选两个?1.1 当前记忆系统如何"烧钱"又"误事"让我们先剖析现有LLM记忆系统的三大致命伤: 致命伤1:冗余信息的无差别囤积 想象你每天记日记,但连"呼吸了3000次"、"眨眼了1.2万次"都要写下来。荒谬吗?但这正是当前AI记忆系统的做法。 研究团队在分析真实对话数据后发现:长对话中超过60%的token是冗余的——寒暄、确认、重复表述、礼貌性过渡语。这些信息不仅浪费存储和计算资源,更致命的是会触发"lost in the middle"现象: 斯坦福大学2023年的研究证明,当上下文超过10k tokens时,LLM对中间部分信息的提取准确率下降超过30%。模型像是在噪声中迷失,反而找不到关键记忆。

类比:如果说记忆是寻宝,冗余信息就是把金币和沙子混在一起。沙子越多,找到金币的概率越低。 致命伤2:僵化切分导致的"语义撕裂" 现有系统通常按固定规则切分记忆单元: - • 按"对话轮次"切(每次一问一答存一条)→ 太细碎,上下文断裂

- • 按"会话session"切(一整天的对话存一条)→ 太粗糙,主题混杂

问题在于:语义边界是流动的,不是机械的。一个30轮的对话可能包含5个主题(工作、家庭、健康、旅行、美食),也可能就一个话题深聊。 固定切分的后果: - • 把"讨论周末去哪玩"和"讨论项目deadline"混在一起 → 检索时噪声干扰,准确率下降

- • 或者把一个连贯的战略讨论拆成30个碎片 → API调用暴增,成本失控

类比:这就像按页数给小说分章节,而不是按情节转折。读者看得云里雾里。 致命伤3:在线更新的"边跑边修车"困境 为了保证记忆"实时性",现有系统在每次对话后都立即更新记忆库: 这就像边开车边修车:实时更新带来严重的推理延迟(实验显示可达5-10秒),用户体验灾难性下降。 更糟的是,由于缺乏"全局视角",系统容易做出错误决策: 真实案例:用户说"我喜欢喝拿铁",三天后说"我今天喝了美式"。系统误判为冲突,删除了"喜欢拿铁"的记忆——实际上两者并不矛盾,一个是偏好,一个是临时行为。

这种不可逆的误删除,在长期交互中会累积成"记忆黑洞"。 1.2 深层矛盾:计算机逻辑 vs 生物智能这三大问题暴露了一个根本性困境:当前LLM记忆系统是用"计算机的逻辑"在模拟"人脑的功能"。 两种哲学的碰撞,造就了今天的"不可能三角": 那么,有没有可能跳出这个三角?

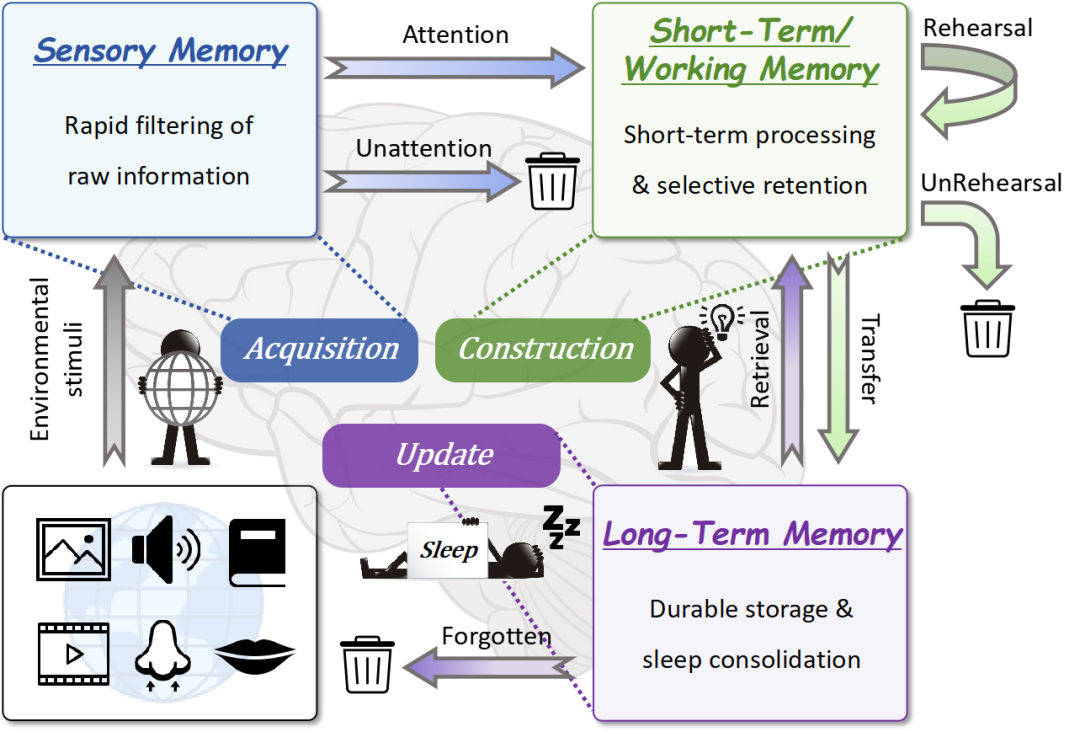

二、向人脑取经:数十亿年演化的智慧2.1 Atkinson-Shiffrin模型:记忆的"三层滤网"1968年,心理学家Atkinson和Shiffrin提出了影响深远的人类记忆模型:  第一层:感知记忆(Sensory Memory)— 瞬时存储,快速过滤 你的眼睛每秒接收约1000万bit信息,但99%在0.5秒内被遗忘。只有"突出的"、"意外的"信息能通过这道门槛。 第二层:短期记忆(Short-term Memory)— 工作缓存,语义整合 通过第一层的信息,在短期记忆中停留数十秒到数分钟,这里进行语义理解、关联和暂存,容量有限(著名的"7±2"法则)。 第三层:长期记忆(Long-term Memory)— 持久存储,睡眠巩固 真正重要的信息被转存到长期记忆。关键发现:这个转存过程主要发生在睡眠时——2013年《Physiological Reviews》的研究证明,大脑在睡眠的慢波期重放白天的记忆,进行重组、抽象、建立连接。 2.2 人脑效率的两个秘密这个三层架构隐藏着两个反直觉的智慧: 智慧1:分层过滤,而非一刀切压缩 人脑不是简单地"压缩所有信息",而是分三次过滤,每层有不同标准: 用信息论的语言:熵(不确定性)高的信息优先保留。 举例:"今天下雨了"这句话: 智慧2:时间解耦,而非强一致性 人脑的记忆整理发生在睡眠时——这是一种"最终一致性"架构,而非"强一致性"。 这种设计的妙处:避免了"边跑边系鞋带"的尴尬,把耗时的深度处理挪到离线时段,清醒时段的响应速度可以最大化。 类比:分布式系统早已证明:强一致性(实时同步)成本高昂,最终一致性(允许短暂延迟)才是扩展性的基石。生命在数十亿年的演化中,早已"发现"了这个真理。

三、LightMem的三层架构:当AI学会了"睡觉"但问题来了:模仿人脑,说起来容易做起来难。 过去十年,无数团队尝试过"类脑记忆系统": - •MemoryOS构建了一整个"记忆操作系统",包含短期、中期、长期三层

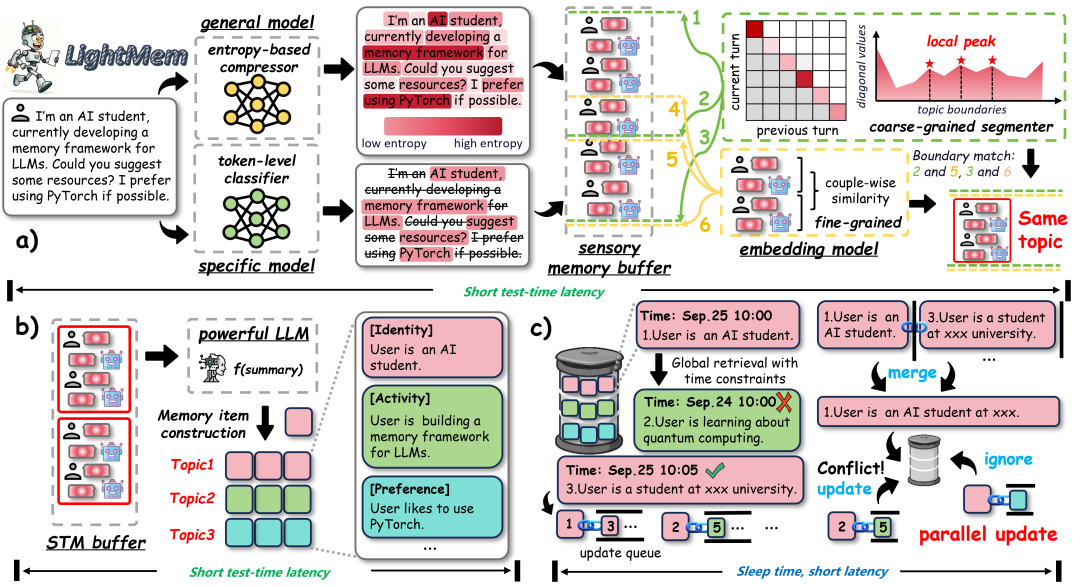

它们都比朴素方法更强,但都逃不开一个诅咒:越像人脑,就越复杂;越复杂,就越慢;越慢,就越不实用。 浙大团队的突破在于:他们没有追求"完全模拟",而是抓住了人脑记忆的三个核心原则,然后用最轻量的方式实现它们。  这三个原则是: 3.1 Light1:认知启发的感知记忆 — "熵过滤"的极简主义第一个反直觉:压缩掉50%的信息,准确率不降反升 LightMem在信息进入系统前,先进行"熵过滤": 核心算法(简化版):

对于每个token x_i:

计算 P(保留 x_i | 上下文) = 条件熵(x_i)

如果 P > 动态阈值τ:

保留

否则:

删除

这在做什么?计算每个token在给定上下文下的"意外程度"(信息量)。 具体案例: 原始对话: 用户:"我的狗叫Rex,它是一只非常可爱、活泼、聪明的金毛犬。" 熵过滤后: 保留:"我的狗 Rex 金毛"

删除:"叫"、"它是一只"、"非常"、"可爱"、"活泼"、"聪明"、"的"、"犬"

为什么? - • "Rex"是专有名词,无法从上下文预测 → 高熵 → 保留

- • "非常可爱聪明"是陈词滥调,可从"狗"预测 → 低熵 → 删除

震撼的实验结果: 在LongMemEval数据集(500个长对话,平均11万tokens)上: - •压缩率50%-80%时,直接用压缩后的文本做问答,准确率与原始文本相当

- • 某些场景下,60%压缩率的准确率(67.68%)甚至高于80%压缩率(66.67%)

这说明什么? LLM的认知瓶颈不在信息量,在信息质量。过多的冗余信息不仅无益,反而像"认知噪声"干扰模型的推理。 类比:如果说传统系统是"拍4K全景视频记录生活",LightMem是"写关键词子弹笔记"——后者看似信息少,但检索时更精准,回忆时更高效。 技术细节:LightMem使用LLMLingua-2作为压缩模型,这是一个轻量级BERT模型(仅400MB),在单张GPU上实时处理,几乎不增加系统开销。

3.2 Light2:主题感知的短期记忆 — 让语义边界"涌现"第二个反直觉:不要按固定规则切分,让主题边界自己"冒出来" 传统做法: - • 方案B:每个session存一次(如一天的对话)

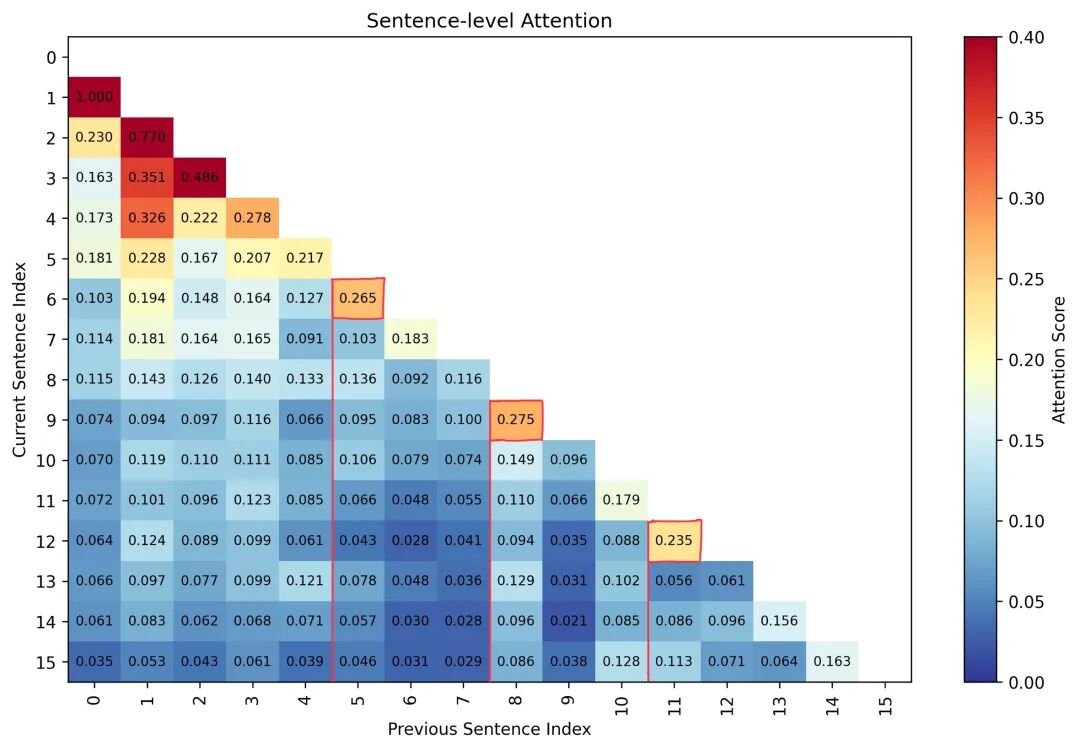

LightMem做法:让话题的转折点自动"涌现" 技术原理:构建对话的句子级注意力矩阵  核心观察:当某一句对前面所有句子的注意力都很低,突然出现"局部峰值"时,这通常是话题转折点。 为什么这样做? 格式塔心理学告诉我们:"整体大于部分之和"。同一主题内的对话句子,语义上相互支撑、相互解释,适合作为一个整体进行总结。如果强行把不同主题混在一起,会产生"语义纠缠": 反例(传统固定切分): 段落1(5轮对话):

- 轮1-3: 讨论项目deadline

- 轮4-5: 突然转到讨论周末旅行计划

AI总结:"用户关心项目进度和旅行安排的时间冲突"

这是错误理解!两个话题没有关联,只是恰好在5轮窗口内。 正例(LightMem主题分割): 段落1(3轮): 项目deadline讨论

段落2(7轮): 周末旅行计划

段落3(4轮): 健康饮食建议

分别总结,互不干扰

实验验证: 团队在LongMemEval上人工标注了话题边界(以session为准),测试不同分割方法: 更重要的是效率提升: - • 相比固定"每session切分",准确率提升6-8%

类比:传统方法像用尺子按固定间距切蛋糕,LightMem像一个熟练的糕点师,沿着奶油花纹的天然分界线下刀——既美观又合理。

3.3 Light3:睡眠时更新 — "最终一致性"的记忆哲学第三个反直觉:延迟更新比实时更新更准确,更快 这是LightMem最激进也最优雅的设计。 传统在线更新的困境: 时刻T1: 插入记忆A → 检查与旧记忆的冲突 → 更新 → 重建索引 (耗时3秒)

时刻T2: 插入记忆B → 检查A和其他记忆 → 更新 → 重建索引 (耗时3秒)

时刻T3: 插入记忆C → 检查A、B和其他 → 更新 → 重建索引 (耗时3.5秒)

...

总延迟: 线性累积

而且,由于记忆之间存在依赖(B的更新可能影响A的状态),必须串行执行,无法并行。 LightMem的"睡眠式"离线更新: 在线阶段(清醒时 / 白天): 离线阶段(睡眠时 / 夜间): 第1步:构建更新队列(可并行)

对每个记忆条目i:

找出所有比它新、且语义相似度>0.8的条目

构建其"更新队列" Q(i)

第2步:执行更新决策(可并行)

对每个记忆条目i:

让LLM审视 Q(i) 中的所有候选更新源

判断:保持、更新、合并还是删除

第3步:批量写入

一次性更新数据库

为什么离线更新更好? - 1.可并行化:每个记忆的更新队列相互独立,可以多线程处理

实测:8线程并行,相比串行快12倍 - 2.有全局视角:不是"看到一个新信息就急着更新",而是"收集一段时间的所有新信息,再统一决策"

避免了前面提到的"拿铁 vs 美式"误判 - 3.可以"深度思考":在线更新为了速度,只能用简单规则(如相似度阈值);离线可以用复杂推理

例如:让LLM分析"这两条记忆是矛盾、互补还是无关?"

真实案例对比: 场景:用户在3个月内说了: - • Week 6: "今天尝试了微辣火锅,还不错"

传统在线更新: Week 6: 检测到"尝试辣"与"不吃辣"冲突 → 删除"不吃辣" ❌

Week 10: 新插入"接受中辣" ✓

最终记忆: "用户能接受中辣"(丢失了口味变化的历史)

LightMem离线更新: 睡眠时:

LLM分析三条记忆的时序关系

判断:这不是冲突,是口味偏好的演变

操作:保留三条,增加"口味偏好:从不吃辣逐渐接受中辣"的抽象记忆

最终记忆:完整保留演变历程 ✓

实验结果: 关键洞察:1.57%的准确率轻微下降,换来了12倍的速度提升和18%的记忆完整性提升。这是一个明智的trade-off。 类比:传统系统像24小时不停整理书架的强迫症患者(又累又容易出错);LightMem像每天正常工作,每晚花1小时系统整理的人——后者效率和生活质量都更高。

四、当数据说话:三个"不可能"都被打破了4.1 在最严格的基准上碾压所有基线LongMemEval是目前最严格的长期记忆基准: - • 500个长对话,平均115k tokens(相当于一本中篇小说)

- • 6类问题:时序推理、多会话关联、知识更新、单用户偏好等

对比方法: - •Full Text:直接把所有对话塞进上下文(baseline)

- •LangMem:LangChain的官方记忆模块

GPT-4o-mini 作为backbone: | | | | |

|---|

| | | | | | | | | | | | | | | | | | | | | LightMem | 68.6% | 28↓57× | 18↓55× | 284↓18× |

Qwen-30B 作为backbone: | | | | |

|---|

| | | | | | | | | | | LightMem | 70.2% | 32↓58× | 20 ↓49× | 417 ↓13× |

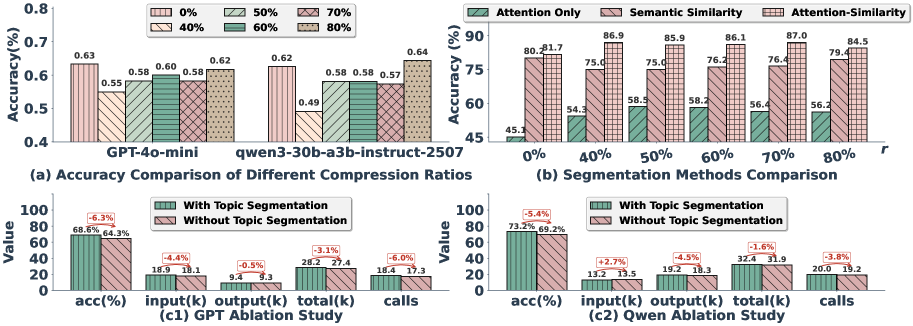

这些数字意味着什么? 假设你要部署一个AI客服系统,每天处理1000个长对话: 成本对比(按GPT-4o-mini定价 $0.15/1M input tokens): 一年节省成本: $86,000 而且用户体验更好(响应更快),准确率更高(减少客诉)。 4.2 三个反直觉发现,推翻三个主流假设发现1:压缩越多,不一定越差 — 推翻"信息完整性假设"  横轴:压缩率r (0.4=保留40%, 0.8=保留80%)

纵轴:问答准确率 震撼结论: - • r=0.6(保留60%)时,GPT-4o准确率达到峰值67.68%

- • r=0.8(保留80%)时,准确率反而下降到66.67%

为什么? 多余的信息不是中性的,是有害的。它们触发两种负面效应: - 1.注意力稀释:LLM的注意力像聚光灯,光束越分散,照不清关键部分

- 2.中间遗忘:过长文本中,模型对中间部分的记忆显著下降("lost in the middle")

类比:如果记忆是一个聚光灯舞台,太多道具(冗余信息)会让主角(关键信息)被淹没。极简主义舞台设计,反而让观众(LLM)更容易聚焦。 这颠覆了什么? 过去五年,整个行业在追求"更长的上下文窗口": LightMem证明:长度的军备竞赛可能是伪命题,关键在信息的'有效密度'。一个精心过滤的10k tokens,可能胜过一个充满噪声的100k tokens。 发现2:主题分割的"涌现"优于固定规则 — 推翻"机械切分假设" 对比三种切分策略在GPT-4o上的表现: 核心发现: - • 相比"每5轮",准确率提升9.3%,API调用减少8.7倍

- • 相比"每session",准确率提升6.8%,API调用仅略减(但内存单元更精准)

分类准确率分析: 在6类问题中,主题分割对"多会话推理"和"时序推理"的提升最显著: 为什么多会话和时序推理提升最大? 这两类问题最依赖"语义连贯性"。固定切分会把一个跨越多轮的连贯讨论拆散,或者把无关的话题强行捆绑。主题分割保证了"该在一起的在一起",检索时噪声更少。 类比:这就像图书馆分类:按"书的厚度"分类(机械),还是按"学科主题"分类(语义)?后者显然更利于读者找书。 发现3:睡眠式更新的"最终一致性"更可靠 — 推翻"强一致性假设" 对比在线更新和离线更新的微观效果: 实验设计: - • 选取100个包含"记忆演变"的对话(如口味改变、观点转变)

klab(0.144521 0.00000657141 0.00000288337 / 0.5);text-indent:0px;border-collapse:collapse;text-align:left;line-height:1.75;font-family:-apple-system-font, BlinkMacSystemFont, "Helvetica Neue", "PingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size:16px;color:rgb(63, 63, 63);min-width:404px;"> | | | | |

|---|

| | 19%❌ | | | | 离线睡眠 | 89%✓ | 4%✓ | | | |