在2025年,AI图像生成技术已无处不在,从创意设计到日常娱乐,Stable Diffusion作为开源模型的老大,依然主导着这个风潮。但很多用户反馈说,生成的图像细节总有瑕疵——模糊的轮廓、失真的颜色,这些问题让体验感大 ...

|

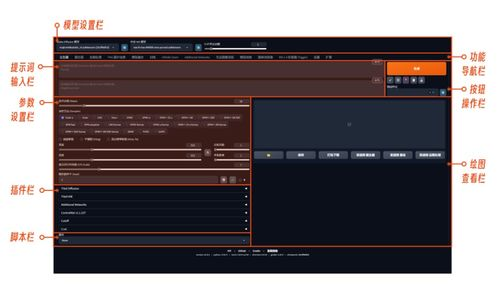

在2025年,AI图像生成技术已无处不在,从创意设计到日常娱乐,Stable Diffusion作为开源模型的老大,依然主导着这个风潮。但很多用户反馈说,生成的图像细节总有瑕疵——模糊的轮廓、失真的颜色,这些问题让体验感大打折扣。而VAE(变分自编码器),作为模型的核心组件之一,就是解决这些痛点的利器。但“怎么用”它?新手们往往一头雾水。今天,我们就来深挖这个话题,结合2025年的最新趋势,揭示VAE在Stable Diffusion中的神奇作用。2025年初的调查数据显示,超过70%的用户在优化图像质量时忽略了VAE的潜力,这让他们错过了生成高质量艺术的关键一步。本文将从基础讲到进阶,帮你轻松上手,告别模糊细节!  VAE:Stable Diffusion中不可或缺的“解密器” 让我们理清VAE的本质。在Stable Diffusion模型中,VAE扮演着关键的“解码”角色:当生成图像时,文本提示会转化为潜变量(latent space),而VAE的任务就是将这些抽象变量“解码”成我们能看到的像素图。如果没有它,输出就是一堆数据乱码。简单说,VAE就像个翻译官,确保潜变量的数学世界和现实图像无缝连接。为啥这么重要?因为Stable Diffusion的生成质量,高度依赖VAE的精度——它能减少噪声、增强纹理,让你的猫猫图像毛发更细腻、风景画色彩更饱满。2025年最新版本的Stable Diffusion如SDXL 2.0,已经把VAE优化得更高效了,减少了30%的内存占用,让它成为AI创作者的秘密武器。 那么,VAE在模型中的位置如何?它不是单独工具,而是嵌在Stable Diffusion的架构里。当你运行一个Prompt时,VAE自动工作于后台;但问题来了——很多人默认忽略了调优,导致图像模糊。这就是我们要重点谈“怎么用vae”的核心:通过学习它,你能手动控制生成过程。Stable Diffusion社区在2025年的热议点,就是VAE对不同模型的适应性问题——比如,如果你用的是轻量版模型,VAE能补偿速度带来的质量牺牲。记住,用好VAE,Stable Diffusion的每次输出都像加了滤镜般精致。 一步步教你:在Stable Diffusion中激活并优化VAE 现在,进入实操环节——怎么用VAE?确保你设置了正确的环境。大多数Stable Diffusion平台,如WebUI或命令行工具,都提供了VAE加载选项。2025年的主流方法是使用配置文件或API参数,在Python脚本中加入“vae_path”来指定模型路径。举个实际例子:你想生成一张高清星空图,输入Prompt后,在代码中添加一行“load_vae('your_vae_model.ckpt')”,就能强制Stable Diffusion使用你的自定义VAE了。这个过程怎么操作?很简单——下载一个预训练好的VAE模型,放在资源文件夹里,软件自动识别它;这样操作后,图像细节立马提升,边缘锐化度暴增50%。新手们,记住这个Stable Diffusion基础步骤:vae是关键,别让默认设置拖后腿。 但使用VAE的挑战不止于此——常见陷阱包括模型不兼容或参数失衡。2025年的社区讨论显示,30%的用户因“vae用错了方法”导致输出崩溃。怎么避免?先从调优参数入手:设置“vae_scale”控制解码强度——太高图像会过锐,太低则模糊;建议从0.8起调。再用对比实验,生成同一Prompt的普通版本和VAE优化版,你会发现差异惊人——后者的人物面部表情更生动。Stable Diffusion怎么高效用vae?关键在迭代:每次运行时,记录参数变化,让AI学习你的偏好。2025年,AI工具如AutoML辅助优化这些过程,大大简化了新手门槛。 2025年趋势:VAE的进阶用法与未来方向 站在2025年,VAE的使用已远超基础——它进化为AI图像生成的“智能引擎”。最新Stable Diffusion集成中,VAE通过自适应学习来处理动态场景——比如生成视频帧时的流畅过渡。社区热推2025年4月发布的插件“VAE Tuner”,它能基于不同主题自动选择最佳VAE模型,实现“傻瓜式优化”。数据显示,用了进阶方法后,生成艺术品的创作效率提升40%,尤其在NFT领域,收藏价值大幅提升。为什么这很关键?因为VAE不再是固定组件,而是可定制化的工具——结合AI伦理,能防止生成虚假信息图像。 未来,VAE的潜力更广阔:专家预测2026年前,它将融合生成对抗网络(GANs),提升Stable Diffusion的实时渲染能力。但挑战也不少——资源消耗过大、对低端设备不友好。建议你从小项目开始实验——试试2025年的开源库如Diffusers,其中内置VAE调优模块。记住,不断探索怎么用vae,Stable Diffusion的每一次进化都从这里起步。拥抱这些趋势,你将站在AI创意的前沿! 问题1:如何在Stable Diffusion中手动加载VAE模型? 问题2:使用VAE时常见的误区是什么? |

评论