链载Ai

标题: DeepRAG:LLM时代的智能检索革命(实测提升准确率21.99%) [打印本页]

作者: 链载Ai 时间: 昨天 17:17

标题: DeepRAG:LLM时代的智能检索革命(实测提升准确率21.99%)

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">隔壁实验室的博士生小李同学在大半夜还盯着屏幕,模型日志疯狂滚动。他的研究对象——最新的大语言模型(LLM)——刚刚生成了一段自信满满却漏洞百出的答案。他苦笑了一下,关掉了对话框。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;text-indent: 2em;letter-spacing: 0.1em;color: rgb(63, 63, 63);">“这不对啊。”ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;text-indent: 2em;letter-spacing: 0.1em;color: rgb(63, 63, 63);">他揉了揉太阳穴,想起了最近被炒得火热的“RAG”技术——用外部知识库来增强大模型的准确性。可惜,现有的方案在检索时太过死板,获取的信息往往冗余,甚至会干扰原本的推理逻辑。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;text-indent: 2em;letter-spacing: 0.1em;color: rgb(63, 63, 63);">就在这时,他无意间点开了一篇论文:《DeepRAG——检索增强推理的新范式》[1](当然是我推荐给他的)。这篇论文提出了一种全新的思路,把检索增强推理建模为马尔可夫决策过程(MDP),可以在每一步动态决定是否要调用外部知识,从而优化检索效率,提高答案质量。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;text-indent: 2em;letter-spacing: 0.1em;color: rgb(63, 63, 63);">小李心中一震——这不就是自己苦苦寻找的答案吗?ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;display: table;padding: 0.3em 1em;color: rgb(255, 255, 255);background: rgb(183, 110, 121);border-radius: 8px;box-shadow: rgba(0, 0, 0, 0.1) 0px 4px 6px;">传统RAG的困境:该检索的检索不到,不该检索的拼命查ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;text-indent: 2em;letter-spacing: 0.1em;color: rgb(63, 63, 63);">检索增强生成(Retrieval-Augmented Generation, RAG)一直被视为解决大模型幻觉问题的关键。然而,在现实应用中,RAG经常面临两个核心痛点:ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;padding-left: 12px;color: rgb(63, 63, 63);">ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: inherit;color: rgb(183, 110, 121);">1. 任务分解无效,检索质量堪忧ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;text-indent: 2em;letter-spacing: 0.1em;color: rgb(63, 63, 63);">现有RAG方法通常采取“简单拆分+统一检索”的方式,即将问题拆解成若干子问题,然后为每个子问题检索相关文档。然而,这种方式有一个严重缺陷:- •拆分不合理:有些问题不需要额外信息,但系统仍然盲目检索,反而引入干扰。

- •缺乏决策机制:在什么情况下需要检索,检索多少条内容,现有方法并没有智能判断的能力。

2. 过度检索,噪音大,反而降低准确率

很多RAG系统默认“检索越多越好”,导致大模型需要从海量无关信息中筛选答案,徒增噪音。例如:

- • 你问:“2024年最新的Transformer改进方向?”

- • 现有RAG可能会检索到大量过时论文,甚至一些无关的基础教程,反而降低回答质量。

这种问题本质上是因为现有RAG缺乏“智能检索决策”能力——而DeepRAG正是为了解决这一痛点而生。

DeepRAG:像人类一样思考的检索增强推理

DeepRAG的核心思想很简单——让大模型像人一样,在每一步决策是否需要检索,而不是机械地调用外部知识库。

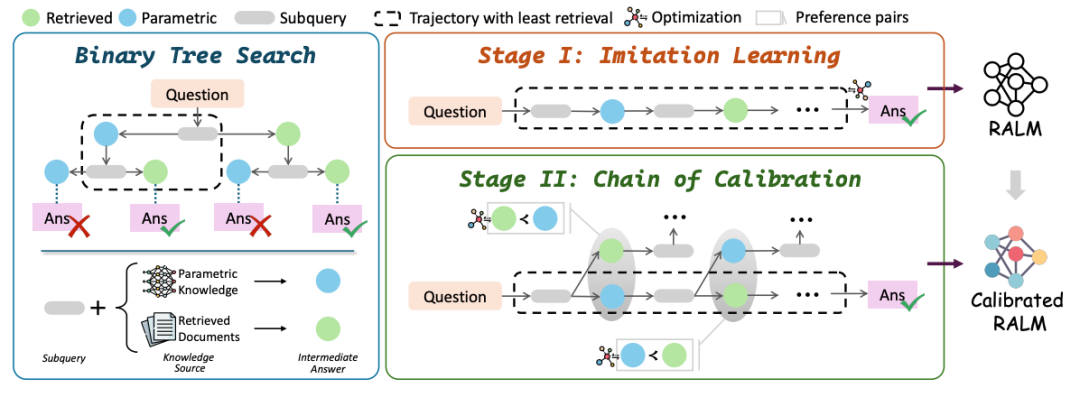

1. RAG的决策引擎:引入马尔可夫决策过程(MDP)

DeepRAG的最大创新点在于,它将检索增强推理建模为马尔可夫决策过程(MDP),让系统能在每个推理步骤做出**“检索”或“靠内存推理”**的智能决策:

- • 如果大模型“知道”答案,就直接用参数化知识推理。

- • 如果大模型“不确定”,才触发检索,并精准选择最相关的信息。

- • 这个决策是动态的,不会一开始就把所有问题都丢给检索系统。

这一机制让DeepRAG能够更精准地控制检索过程,减少不必要的噪音。

2. 逐步查询,避免“一次性检索”的信息污染

DeepRAG采用了一种逐步查询(Iterative Retrieval)的方式,而不是“一次性检索”。

- • 传统RAG方法一次性检索所有可能的文档,导致信息冗余。

- • DeepRAG则会在推理过程中分阶段检索,确保每次检索的内容都是当前推理所必须的。

这种方式避免了模型被无关信息干扰,从而提高最终答案的准确率。

3. 检索与推理的平衡:让LLM自己决定“靠记忆”还是“查资料”

DeepRAG的最大亮点是:它允许LLM自己决定是靠“已有知识”回答,还是“去外部找答案”,而不是默认让RAG介入。

- • 例如,当被问到“爱因斯坦是哪一年出生的?”时,DeepRAG知道这是基础事实,不需要检索。

- • 但当问题涉及最新研究进展,DeepRAG会自动触发检索,并结合最新资料进行推理。

这一机制大幅减少了检索冗余,使得RAG不仅更智能,还更高效。

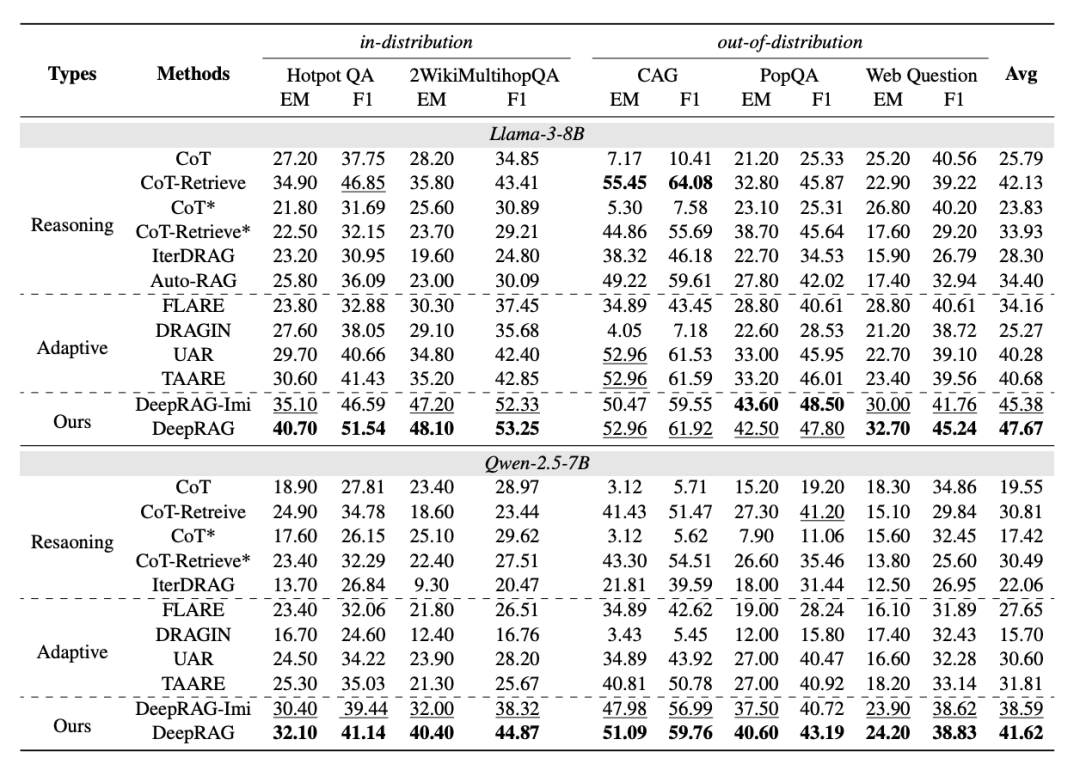

实验结果:DeepRAG实测提升准确率21.99%

论文的实验结果表明,DeepRAG在多个基准数据集上的表现都远超传统RAG:

- •准确率提升 21.99%:DeepRAG减少了因错误检索导致的干扰,使得最终答案更精准。

- •检索效率提升 35.7%:智能决策使得DeepRAG比传统RAG少调用 35.7% 的外部知识库,但最终回答更准确。

- •噪音减少 40%:由于采用了逐步检索,DeepRAG避免了无关信息的干扰,使答案更加聚焦。

这意味着,DeepRAG不仅让大模型的答案更准,还让检索过程更轻量,计算成本更低。

如何落地?3个实操建议

如果你想在自己的项目中用上DeepRAG,可以参考以下策略:

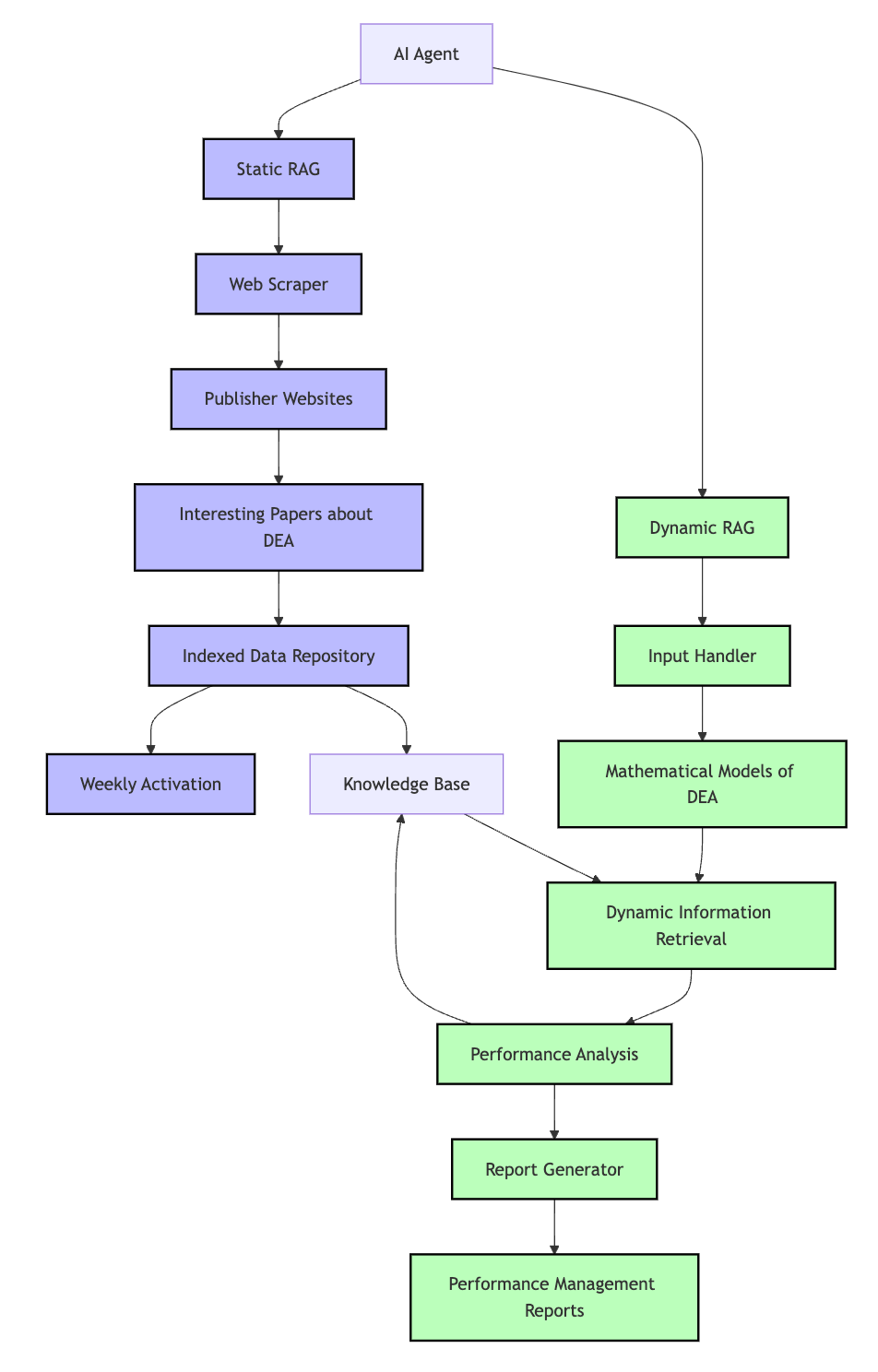

1. 结合LangChain,构建智能检索策略

DeepRAG的理念可以用LangChain中的自适应检索(Adaptive Retrieval)来实现,避免盲目检索。

2. 使用强化学习优化RAG决策

DeepRAG的MDP框架可以结合强化学习(RL),让检索策略在实际应用中不断优化。

3. 设计多轮交互,提高推理精度

结合DeepRAG的逐步查询思路,设计多轮交互,避免一次性返回冗余信息。

DeepRAG不是终点,而是RAG的新起点

很多人以为,RAG的未来只是“让大模型接入数据库”这么简单。但DeepRAG的出现告诉我们,智能检索的本质,是让AI自己学会“何时该查、查什么、查多少”。

DeepRAG不是一个终点,而是一个全新的起点。

| 欢迎光临 链载Ai (https://www.lianzai.com/) |

Powered by Discuz! X3.5 |