AI 应用的竞争焦点正从“模型能力”转向“知识工程”。Claude Skills 通过渐进式披露机制和可执行代码,让 AI 像人类学习技能一样,无需每次都从零开始。这标志着从“教 AI”到“为 AI 搭建认知脚手架”的范式转变。未来不属于最会用 AI 的人,而属于最会“教 AI 学习”的人——那些能将隐性知识结构化的“知识架构师”。

作为产品经理,你用 Claude 生成了一份完美的季度报告:配色、字体、数据呈现都恰到好处。

第二天开启新对话,要求类似的月度分析时,结果却令人失望:品牌色偏离、图表风格不一、标题层级混乱。你不得不重新解释:“记住,主色调是#2E5BFF,图表用 recharts,标题用 Inter 字体...”

这已经是第 37 次了。

开发者的处境更显尴尬。你已经反复教导 Claude 代码风格、项目架构和部署流程,但每次新建对话,它就像失忆般忘记 TypeScript 严格模式,或把测试文件放错位置。

据估算,中度 AI 用户每周花费 2-4 小时在“重复教导”上。这不仅是效率问题,更是尊严问题——你在为一个永远记不住的“学徒”打工。

问题不在 AI 不够聪明,而在我们教导的方式有误。

Claude Sonnet 4.5 能写诗、编程、分析金融数据、设计 UI,堪称全能。但在具体工作中,为什么总是“差那么一点”?

这源于根本矛盾:上下文成本与专业深度的博弈。

大语言模型的训练目标是“在海量数据中学习通用模式”,这赋予了它广博的知识面。但当你需要“精通公司特定财务流程的专家”时,通才只能给出“大致正确”的建议。

要让 Claude 真正理解业务,理论上需要将所有相关知识塞进提示词。但现实是:

更深层的问题是:某些任务根本不适合“生成”完成。

比如,让 Claude 用自然语言生成“对 1000 个数字排序”的算法,就像让建筑工人现场手工制砖——理论上可行,实际低效且不可靠。而预写的排序脚本,能确保结果既确定又高效。

LLM 的非确定性输出与任务可靠性的需求,构成了难以调和的张力。

这就是 Claude Skills 要解决的核心:如何让通用模型在特定领域表现得像训练有素的专家,而非每次都从零开始的新手?

Claude Skills 的创新不在让模型“更聪明”,而在让它不必每次都从零开始聪明。

传统提示工程如同要求 AI “背诵整本百科全书”并在对话中默写,这显然不现实。

Skills 采用不同思路:为 AI 建立“个人图书馆”,教导它按需查阅。

这就是“渐进式披露”——不一次性塞满信息,而是分层按需加载。

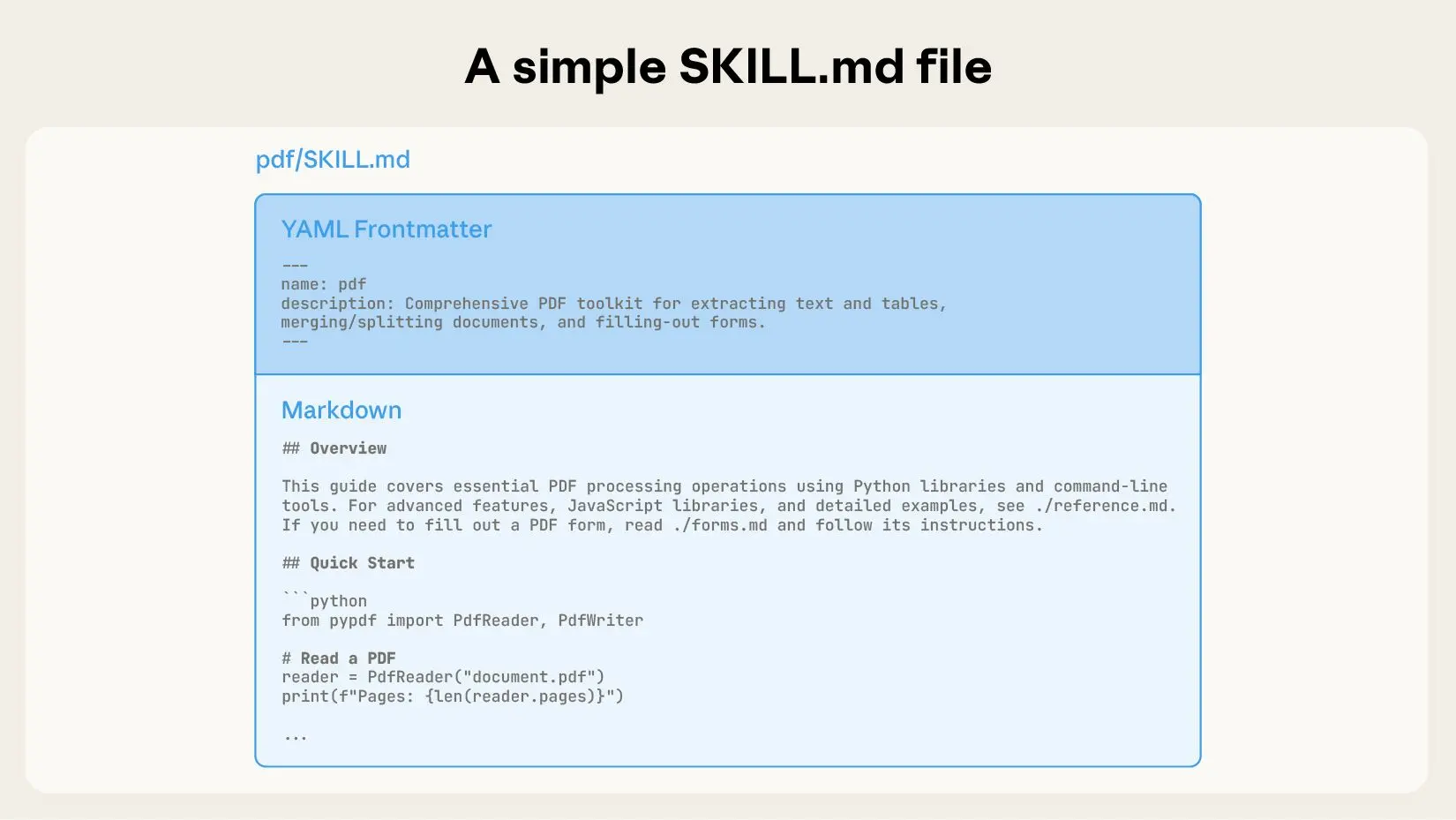

以 Anthropic 提供的 PDF 处理 Skill 为例,解析这一机制:

---

name DFProcessing

DFProcessing

description:ExtracttextandtablesfromPDFfiles,fillforms,mergedocuments.UsewhenworkingwithPDFfilesorwhentheusermentionsPDFs,forms,ordocumentextraction.

---当用户说“从这个 PDF 提取表格”,Claude 识别关键词“PDF”并触发相应 Skill。此时通过bash命令读取SKILL.md完整内容:

# PDF Processing

## Quick Start

Use pdfplumber to extract text from PDFs:

```python

import pdfplumber

with pdfplumber.open("document.pdf") as pdf:

text = pdf.pages[0].extract_text()For advanced form filling, see FORMS.md.

**这是“书的目录和核心章节”**——提供核心指令与工作流程。

**总结**:第二层是“知道如何做”的步骤指南,仅在需要时进入上下文。

*SKILL.md 文件的基本结构:YAML 前置元数据 + Markdown 正文指令*

#### **第三层:资源与代码(按需加载,理论上无限制)**

若任务涉及表单填写,Claude 会进一步读取 `FORMS.md`:

pdf-skill/

├── SKILL.md (主指令)

├── FORMS.md (表单填写指南)

├── REFERENCE.md (详细 API 参考)

└── scripts/

└── fill_form.py (表单填充脚本)

精妙之处在于:**脚本可直接执行,而不必加载到上下文中**。

例如,`fill_form.py` 用于提取 PDF 表单字段。当 Claude 执行:

```bash

python scripts/fill_form.py document.pdf只有脚本输出(如“发现 5 个字段:姓名、地址、日期...”)进入上下文,脚本本身的数百行代码零 token 消耗。

总结:第三层是“可执行工具”,它们工作但不占用阅读带宽。

| 知识加载 | ||

| Token 消耗 | ||

| 可扩展性 | ||

| 可靠性 | ||

| 复用性 |

用编程类比:传统提示词是解释执行(每次重新解析),Skills 是 JIT 编译(按需编译,高效复用)。

若仅将 Skills 视为“更好的提示词管理工具”,便错过了其革命性意义。

传统提示词工程的心智模型:将 AI 视为“服从指令的执行器”。编写提示词如同下达命令:“做这个,按此格式,注意那些细节...”

Skills 的心智模型:将 AI 视为“学习中的学徒”。你不是下命令,而是搭建“认知脚手架”——提供工具、参考手册、最佳实践,让它自主判断何时使用何种工具。

这不只是术语差异,而是控制权的转移:

设想你是一位木匠:

Skills 让 AI 从“被动执行者”进化为“主动工具使用者”。

更深层的洞见:

人类学习技能时,部分操作会固化为“肌肉记忆”——如骑自行车,无需每次都思考“左脚蹬、右脚蹬”,动作已自动化。

Skills 中的可执行代码,就是 AI 的“肌肉记忆”。

对比两种实现方式:

方式 A:让 LLM 生成代码(现场思考)

用户:帮我对这个 PDF 的表单字段排序

Claude:(思考)我需要先读取 PDF...用什么库?pdfplumber?PyPDF2?...好的,编写脚本...

(生成数十行代码,消耗数千 tokens,可能包含错误)方式 B:调用 Skill 中的脚本(肌肉记忆)

用户:帮我对这个 PDF 的表单字段排序

Claude:(识别 PDF 任务,加载 PDF Skill)

(执行 scripts/extract_fields.py,0.1 秒返回结果,0 token 消耗,100% 可靠)当任务需要确定性、高性能时,不应让 AI“现场发挥”,而应调用“肌肉记忆”。

这也是 Anthropic 特别强调之处:Skills 可包含可执行代码,且代码运行在安全的虚拟机环境中。

若觉得 AI 领域概念混乱——Tools、Functions、Skills、MCPs、Agents、Subagents...——并非你的错觉,行业快速迭代确实导致“概念增生”。

通过清晰框架理解 Skills 的定位。

将完整 AI 应用系统想象成“人”:

+-------------+

| Agents | (大脑:决策与编排)

| (子代理编排) |

+------+------+

|

+--------+--------+

| |

+----v----+ +-----v----+

| Skills | | MCP | (感官:连接外部)

| (技能库) | | (数据接口)|

+---------+ +----------+场景:用户要求:“分析公司上季度销售数据,生成 Excel 报告”

1. Agent 接收任务,分解步骤:

- 需要获取销售数据 → 触发 MCP(连接数据库)

- 需要生成 Excel → 触发 Skills(加载 Excel Skill)

2. MCP Server 执行:

- 查询 PostgreSQL,返回销售数据(5000 条记录)

3. Agent 将数据传给 Excel Skill:

- 加载 excel-skill/SKILL.md(指令)

- 执行 excel-skill/scripts/pivot_table.py(生成透视表,不消耗 token)

- 根据指令应用公司品牌样式

4. 生成最终报告,展示给用户关键点:

另有两个概念需要厘清:

用餐桌类比:

在描绘美好愿景前,需正视 Skills 面临的挑战。这些不仅是技术问题,更是对整个 AI 应用范式的考验。

Skills 的触发依赖 AI 的“判断”:通过元数据的description决定是否加载某个 Skill。

但存在不确定性:

真实用户反馈(来自 Hacker News):

“已多次遇到 Claude 本应使用某个 Skill 却未使用,或使用一半后忘记...”

这表明:Skills 让 AI 更强大,但也使其行为更不可控。

Skills 的质量上限取决于文档水平。

若 SKILL.md 逻辑混乱、指令模糊,AI 同样会犯错。而编写优质 Skill 需要:

这对许多团队是挑战——如果连给人看的文档都写不好,给 AI 的 Skill 大概率也不理想。

正如前文提及,AI 领域概念繁多:

开发者的困惑真实存在:

“该用 MCP 还是 Skill?Subagent 与 Skill 有何区别?为何又要发明新概念?”

尽管这些概念各有侧重,但缺乏统一标准带来了学习与迁移成本。

但这些挑战,恰恰指向未来的机会...

现在,抽离技术细节,审视 Skills 背后真正重要的内涵。

过去两年,AI 行业的竞争逻辑是:谁的模型参数更多、训练数据更大、算力更强,谁就能获胜。

但随着模型能力触及 S 曲线顶部,边际收益递减效应显现:

这意味着什么?

未来 AI 应用的竞争力,将更多取决于“知识库的质量与组织方式”,而非单纯的模型参数规模。

如同互联网时代,最终胜出的不是“谁的服务器更多”,而是“谁的信息架构更合理”(Google 的 PageRank、亚马逊的推荐系统)。

Skills 揭示的路径:

这对中小团队是重大利好——无需与 OpenAI 比拼算力,只需比竞争对手更擅长“知识工程”。

Skills 的创建过程,本质是将隐性知识转化为显性知识的过程。

何为隐性知识?

这些知识往往“只可意会,不可言传”,存在于经验丰富的专家脑中。

Skills 倒逼我们将这些知识“可言传”:

这带来惊人推论:

未来最有价值的职业技能之一,是“知识架构师”——那些能将专家隐性知识,结构化为 AI 可理解、可执行 Skills 的人。

他们不一定是最强程序员,但具备:

文档工程师、知识管理专家、技术写作者——这些曾被认为“不如编码高级”的职业,可能在 AI 时代迎来价值重估。

这是最关键的认知反转。

当你为工作流程创建 Skill 时,必须:

此过程本身,就是对自身认知的深度优化。

Skills 不是让 AI 学习,而是强迫你学会“教学”——而教学是最好的学习。

换言之:

AI 只是放大器。你的知识架构能力才是被放大的对象。

Skills 的可组合性,预示更宏大的趋势:AI 能力的模块化与标准化。

想象未来:

这就是“AI 能力的乐高化”——并非每次从零训练模型,而是组装现有能力模块。

但这带来新挑战:

Anthropic 已在布局:提供 Claude Console,让开发者“查看、创建、升级 Skill 版本”,这是在为生态系统搭建基础设施。

Box:“Skills 教会了 Claude 如何处理 Box 内容。用户可将存储的文件转换为 PowerPoint 演示文稿、Excel 电子表格和 Word 文档,这些文档都遵循他们组织的标准——节省了数小时的工作。”

Notion:“借助 Skills,Claude 可与 Notion 无缝协作——让用户更快地从问题转向行动。在复杂任务上减少提示词调试,获得更可预测的结果。”

读到这里,你可能想问:“听起来不错,但我该从哪里开始?”

回顾过去一个月与 AI 的交互:

这些就是你的第一批 Skill 候选。

勿试图创建“包罗万象”的超级 Skill。从简单、聚焦的场景起步:

示例:品牌色 Skill

---

name: Brand Colors

description: Use company brand colors in any design or visualization task. Trigger when user mentions "our brand", "company colors", or creates visual content.

---

# Brand Colors

## Color Palette

-Primary:#2E5BFF(蓝色,用于主要按钮和标题)

-Secondary:#7C3AED(紫色,用于次要元素)

-Accent:#10B981(绿色,用于成功提示)

-Neutral:#6B7280(灰色,用于正文)

## Usage Rules

-背景与文字对比度必须 ≥4.5:1(WCAG AA 标准)

-主色占比 60%,辅色 30%,强调色 10%

-数据可视化优先使用主色系的渐变如此简单。但这 17 行的 Skill,让你不再每次重复输入品牌色。

创建 Skill 后,实际使用并观察:

关键:用 Claude 本身帮助优化 Skill。询问:

“我这个 Skill 写得如何?有哪些需要改进的地方?”

当 Skill 稳定后,识别其中“适合用代码实现”的部分。

判断标准:

将这些部分写成 Python/JavaScript 脚本,放入scripts/文件夹,在 SKILL.md 中说明调用时机。

从明天起,当进行任何重复性工作时,问自己:

“这个流程,我能否将其 Skills 化?”

这个问题本身,就是你思维升级的开始。

它会让你:

如果说 2023 年的 AI 竞争是“谁能买得起最强 GPU”,那么 2025 年的竞争正转向“谁更擅长设计认知工具”。

Claude Skills 的推出,表面是产品功能,实质是信号:模型能力竞争已近饱和,生态能力竞争才刚刚开始。

未来属于那些能够:

你无需是最强程序员,无需拥有最大 GPU 集群,你需要成为优秀的“知识架构师”。

当别人还在为“如何编写更好的提示词”苦恼时,你已在为 AI 打造“专业工具箱”。

这才是 AI 时代真正的竞争力。

最讽刺的是:我们以为 AI 将取代人类,但 Skills 告诉我们,AI 最需要的,恰恰是最“人性化”的能力——将经验转化为知识,将混沌结构为秩序,将直觉翻译为逻辑。

这些,只有人类能做。

| 欢迎光临 链载Ai (https://www.lianzai.com/) | Powered by Discuz! X3.5 |