ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">Meta的开源大语言模型Llama 3一经发布,便引爆了AI圈,号称“迄今为止最好的开源大模型”,Llama 3本次开源了70B和8B两个小参数模型,同时官方发布了在多项基准测试中的评测结果,其结果显示,Llama 3在同类模型中表现优异。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">那么问题来了,Llama 3自己评测的结果是否客观?除了国外的主流开源和闭源模型之外,Llama 3对比国内主流模型,实际表现又如何?ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">近日,SuperBench团队在前不久发布的《SuperBench大模型综合能力评测报告》基础上加测了Llama 3新发布的两个模型,测试了Llama 3在语义(ExtremeGLUE)、代码(NaturalCodeBench)、对齐(AlignBench)、智能体(AgentBench)和安全(SafetyBench)五个评测集中的表现,具体情况如下:ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">1. 我们在上次评测的14个模型基础上新增了Llama 3的70B和8B两个模型,对于闭源模型,我们选取API和网页两种调用模式中得分较高的一种进行评测。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">2. 根据我们的评测结果,可以得出以下主要结论:- ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">Llama 3-70B版本在各个评测集上均差于GPT-4系列模型以及Claude-3 Opus等国际一流模型,在语义、代码两项评测中距离榜首差距最大,智能体评测中表现最好,排名第5;但考虑到模型参数量的差异,Llama 3-70B整体表现还是不错的。

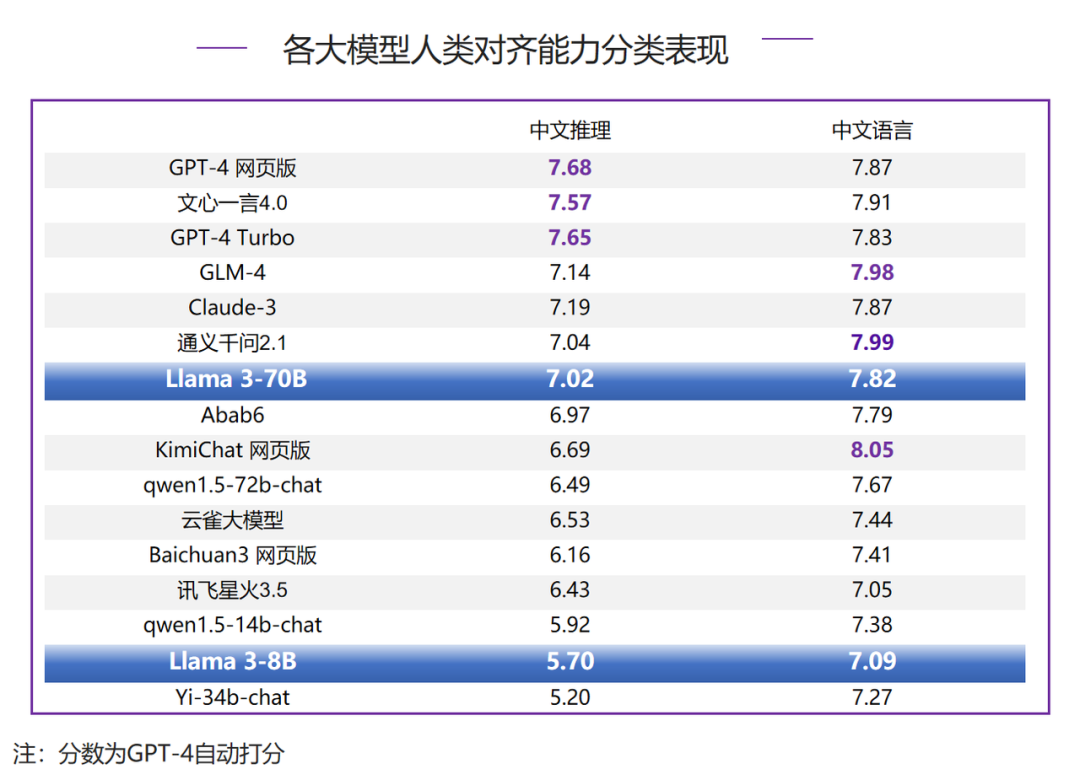

- ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">和国内大模型对比,Llama 3-70B在五项评测中超过了大多数国内模型,只落败于GLM-4和文心一言。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;background-color: rgb(255, 255, 255);color: rgb(48, 48, 48);line-height: 1.75em;font-weight: 400;box-sizing: border-box;font-style: normal;text-align: justify;">*说明:SuperBench以中文能力评价为主评测结果

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: inherit;text-wrap: wrap;color: rgb(255, 104, 39);font-size: 18px;">PART/1 语义评测整体表现:

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;vertical-align: middle;width: 100%;height: auto;"/>

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;vertical-align: middle;width: 100%;height: auto;"/>在语义理解能力评测中,Llama 3-70B排名第6,落后Claude-3、GPT-4系列模型以及国内大模型GLM-4和文心一言4.0,距离榜首Claude-3仍有一定差距(相差8.7分),但是领先国内其他模型,整体处于第二梯队的榜首位置。

分类表现:

Llama 3-70B在语义理解的分类评测中表现最好的是数学,分数超过GPT-4系列模型,排名第4;在阅读理解和知识-科学两项评测中均表现也不错,均排名第6,其中阅读理解和榜首差距最小,只有4.3分差距;但是在知识-常识评测分数较低,获得60.9分,与榜首Claude-3有18.9分差距。

PART/2 代码评测

整体表现:

在代码编写能力评测中,Llama 3-70B排名第7,得37.1分,差于GPT-4系列模型和Claude-3等国际一流模型,以及GLM-4、文心一言4.0和讯飞星火3.5等国内模型;和GPT-4 Turbo差距较大,分差达到了13.7分。值得一提的是,Llama 3-8B的代码通过率超过了KimiChat网页版、云雀大模型等国内大模型。

分类表现:

Llama 3-70B在代码编写能力的分类评测中均表现一般,排名6-8位,和GPT-4系列模型以及Claude-3有较大差距,其中在英文代码指令-python评测中,Llama 3-70B和榜首的GPT-4 Turbo差距更是达到了20.3分;另外从本次评测中来看,Llama 3-70B并未表现出明显的中英文差距。

PART/3 中文对齐评测

整体表现:

在人类对齐能力评测中,Llama 3-70B排名第7,依然差于GPT-4系列模型和Claude-3;国内模型中,除文心一言4.0和GLM-4之外,通义千问2.1也在对齐评测中略超过Llama 3-70B;但是Llama 3-70B和排在前面的各家模型差距不大,距离榜首的GPT-4网页版仅有0.35分差距。

分类表现:

Llama 3-70B在中文推理评测中排名第7,和第一梯队的GPT-4系列模型以及文心一言4.0相差约0.6分;在中文语言评测中排名第8,但是和GPT-4系列模型、Claude-3分差较小,处于同一梯队,和榜首的KimiChat网页版也只有0.23分的差距。Llama 3-70B在逻辑推理以及数学计算两项评测中分列第7和第6,明显差于GPT-4系列模型和文心一言4.0,和Claude-3分差不大。Llama 3-70B在综合问答、角色扮演和专业能力三项评测中均超过了8分,其中综合问答更是拿到了8.65的高分,获得榜首;角色扮演排名第4,超过了GPT-4系列模型和Claude-3,在国外模型中表现最好;专业能力差于GPT-4系列模型,好于Claude-3,排名第6;在其他维度评测中,基本任务7.75分,排名第5;中文理解得分6.63分,分数相对较低。PART/4 智能体评测

在作为智能体能力评测中,国内外大模型在本能力下均表现欠佳,Llama 3-70B在横向对比中表现不错,仅差于Claude-3、GPT-4系列模型以及国内模型GLM-4,排名第5。

Llama 3-70B在数据库(DB)、知识图谱(KG)、网上购物(Webshop)三个评测项中均进入了top3,但是距离榜首仍有一定差距;在操作系统(OS)、网页浏览(M2W)中也表现不错 ,排名第4和第5;情境猜谜(LTP)表现得0.5分,表现相对最差。

PART/5 安全评测

整体表现:

在安全能力评测中,Llama 3-70B得86.1分,排名第7,和排在前面的文心一言4.0、GPT-4系列、GLM-4等模型分数差距不大。

Llama 3-70B在安全能力的各分类评测中,偏见歧视(UB)在横向对比中表现相对最好,排名第4,其他评测排名在第7位及以后,但是和排在前面的模型分差不大,心理健康(MH)、隐私财产(PP)、身体健康(PH)均和榜首差距在3分之内。

SuperBench官网:

https://fm.ai.tsinghua.edu.cn/superbench/#/

SuperBench以往推送:

1. SuperBench大模型综合能力评测报告

2. 2024年,如何避免「国内百模,家家第一」乱象