链载Ai

标题: 解密o1模型:50美元重现百万美元级实验 [打印本页]

作者: 链载Ai 时间: 7 小时前

标题: 解密o1模型:50美元重现百万美元级实验

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;padding-top:8px;padding-bottom:8px;margin:1em 4px;line-height:26px;color:black;">o1模型发布后,有人花50美元重现了可能价值百万美元的实验结果。

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.75px;text-wrap: wrap;border-style: none;display: block;width: auto;"/>

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.75px;text-wrap: wrap;border-style: none;display: block;width: auto;"/>

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);">OpenAI最近发布了o1模型家族,并公布了一张展示测试时计算量缩放规律的图表。这张图表引发了研究人员的极大兴趣,因为它揭示了模型性能如何随测试时计算量的增加而提升。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);">然而,不知是有意还是刻意还是无意,OpenAI并没有标注x轴!ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);">这留下了一个巨大的悬念。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);">就像给了大家一张藏宝图,却不告诉你起点在哪里。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);">50美元的复刻之旅

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);">此时,主打一个不服Hugh Zhang 跳了出来,他决定接受这个挑战!ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);">并且他最终只用了公开的o1-mini API,就尝试重现出了这个图表。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.75px;text-wrap: wrap;background-color: rgb(255, 255, 255);text-align: center;">

左边是OpenAI的原图,右边是Hugh的复刻版。

算得上惊人的相似,对吧?

但是,怎么做到的呢?这就要说到token控制的艺术了。

token控制:让AI"按量思考"

Hugh发现,o1-mini API并不允许直接控制测试时使用的token数量。但他想出了一个巧妙的方法:告诉模型你希望它思考多长时间。

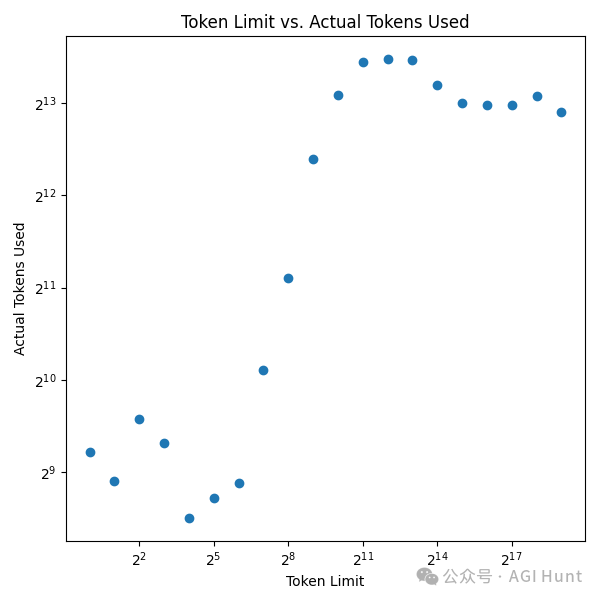

这张图展示了请求的token数量与实际使用的token数量之间的关系。有趣的是,在2^4到2^11的范围内,模型似乎能较好地"听话"。

而其他的请求token 数量下,o1 就不搭理他了。

但是,Hugh还发现了一个有趣的现象:

在这个范围内,o1-mini实际使用的token数量总是比请求的多约8倍!这就像你点了一份饭,餐厅总是给你上8份。

可能是新融资让OpenAI 太有钱了吧!

突破限制:自一致性方法来救场

但是,仅靠这种方法,Hugh最多只能让模型使用到2^14(约16K)个token。为了进一步扩展,他借鉴了自一致性论文中的方法:多次采样,然后进行多数投票。

这个方法确实带来了一些初步的收益,但很快就遇到了瓶颈。

廉价重现昂贵实验

在这个过程中,Hugh发现了一件令人兴奋的事:重现这个图表的成本出奇地低。

对于最大规模的推理运行,每个问题使用2^17个token,乘以30个2024年AIME问题,总共约400万个token。按照每100万输出token 12美元的价格,最大规模的运行只花费了约50美元!

就这样,原本可能需要耗费数百万美元的实验,现在只需要50美元就能重现关键结果。

实验的局限

然而,Hugh的实验也揭示了一些局限性:

如图所示,自一致性方法似乎在达到约70%的准确率后就停止了增长,这与OpenAI原图的结果非常接近。

这个结果与过去的研究一致,表明多数投票法在某个点会达到饱和。这意味着,如果我们想要进一步提升模型性能,可能需要探索其他方法。

Hugh推测,强制模型在token空间中思考更长时间可能比重复采样和多数投票更有效。

考虑到重现实验的低成本,这可能是一个值得进一步探索的方向。

| 欢迎光临 链载Ai (https://www.lianzai.com/) |

Powered by Discuz! X3.5 |

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.75px;text-wrap: wrap;border-style: none;display: block;width: auto;"/>