|

有没有好奇过:LLM背后的数学原理是啥?OpenAI前首席科学家Ilya提供了一种理论解释。

(1)Ilya 是谁?

全名Ilya Sutskever,深度学习教父 Hinton 的学生,AlexNet的作者,深度学习革命的开创者,拥有最强的远见力和最坚定的深度学习信仰,深度学习启蒙者,帮助 OpenAI 及时⾛上 Transformer 路线,是OpenAI的灵魂人物。

履历: 2012年:提出AlexNet模型,开创图像识别新章,AlexNet被认为是计算机视觉领域最有影响力的论文之一 2013年:共同创办的DNNresearch被Googleicon收购 2014年:提出了序列到序列学习(Sequence To Sequence)的神经网络变体,开创了语言翻译革命(谷歌icon翻译的基础) 2015年:放弃了谷歌的数百万美元的工作,成为非营利组织OpenAI的联合创始人 2018年:Sutskever领导了GPT-1的开发,后来发展成了GPT-2、GPT-3和ChatGPT。 2021年:Sutskever领导了DALL-E 1(图像生成模型)的开发。 2023年11月18日,Ilya策划下,OpenAI董事会宣布辞退Greg Brockman和CEO Sam Altman,一场震惊世界的“斗争”上演,AI届的“911”。随后,Sam在在全体员工和投资人支持下重返OpenAI。 2024年5月15日,Ilya Sutskever离开OpenAI

(2)他们为什么斗? GPT-4发布后,效果超出预期,同时也让一部分人对AI发展前景担忧。 对于迅速发展的AI的态度,大致有三派:危机派、加速派与对齐派。 ① 危机派:对AI技术严重警惕,AI可能对人类社会产生极大威胁,主张暂停AI技术继续研发。代表人物 Elon Musk,2023年3月29日,他牵头发布“暂停AI联署信”。 ② 加速派:受 E/acc(有效加速主义)思潮影响,人类应该无限制地推进AI等前沿技术的加速研发,最终促进人类进化。人类社会的公共部门(政府、NGO、科学家协会)无法管理AI,应该充分放手让AI 加速,AI系统会自我进化到相互制衡状态。代表人物,OpenAI CEO Sam Altman。 ③ 对齐派:主张减缓AGI(通用人工智能)技术的研发速度,提升对技术的公共效益、伦理讨论、人文价值的重视,在AI研发过程中引入人文的价值判断,确保AI技术不会失控,对人类社会的产生威胁。代表人物GeoffreyHinton和学生Ilya Sutskever。

除了GPT-4,还有更厉害的OpenAI秘密研发的Q-Star项目,OpenAI内部对项目是否继续进行争议较大。 众说纷纭,重点是观念不同

于是,对齐派为了阻止加速派,Ilya Sutskever发动这场“政变”或“闹剧”、“恶意收购”,希望OpenAI回到非赢利机构的使命,"AI向善"。

Ilya Sutskever是一个彻头彻尾的理想主义者ingFang SC", "Microsoft Yahei";font-size: 16px;letter-spacing: normal;text-wrap: wrap;background-color: rgb(255, 255, 255);">。 2023年11月22日,Sam Altman和Greg Brockman重回OpenAI,这场斗争以加速派获胜而结束。

Ilya Sutskever被踢出董事会。 沉寂一段时间后,2024年5月15日,Ilya Sutskever终于决定离开OpenAI。

Sam Altman对Ilya Sutskever 离职的看法: ingFang SC", "Hiragino Sans GB", "Microsoft YaHei", "Helvetica Neue", Helvetica, Arial, sans-serif;font-size: 16px;letter-spacing: normal;text-align: left;text-wrap: wrap;">“Ilya 和 OpenAI 即将分道扬镳,这对我来说是非常悲伤的一件事。Ilya 是我们这一代人中最伟大的思想家之一,是我们这个领域的指路明灯,也是我们的挚友。他的才华和远见众所周知;他的热情和同情心鲜为人知,但同样重要。 没有他,就没有现在的 OpenAI。虽然他要去做一些对他个人有意义的事情,但我永远感激他在这里所做的一切,并致力于完成我们共同开始的使命。我很高兴,在这么长的时间里,我能够接近这样一位真正杰出的天才,这样一位专注于为人类创造美好未来的人。” 2024年6月19日,Ilya Sutskever宣布创立自己的公司SSI(Safe Superintelligence Inc.),继续实施超级对齐计划。 提高性能的同时,确保安全性始终处于领先地位。 新公司所追求的安全、保障和进步不会受到短期商业压力的影响。 (3)Ilya为什么如此顾忌AI安全? OpenAI前首席科学家Ilya到底看到了什么,才会对AI安全如此顾忌?公开信息较少,先从Ilya一次公开演讲说起。

2023年10月3日,Ilya 曾在伯克利大学做过一次演讲,题为《一个无监督学习的理论》(A Theory of Unsupervised Learning) Ilya 揭示了大模型核心原理,生动描述无监督序列学习机制时,兴奋之情溢于言表。 超级对齐团队的前成员 Leopold Aschenbrenner 发表了一篇长达 165 页的文章《Situation Awareness》,初步揭示OpenAI 内部目睹 GPT 模型指数级进化时的震撼和隐忧。

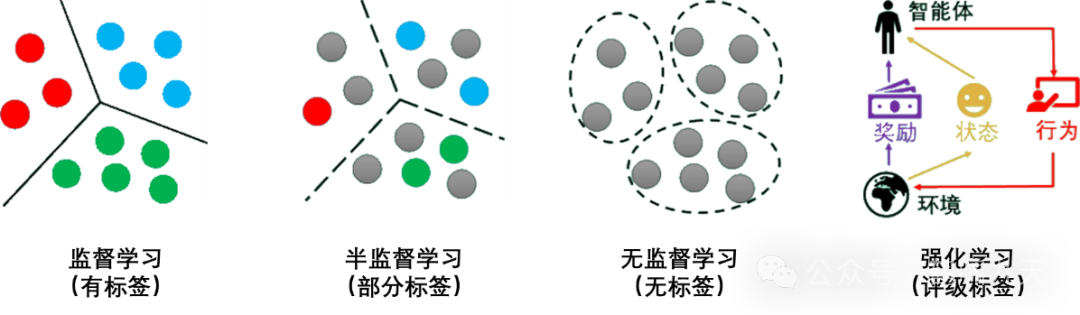

这部分回答了 Ilya 看到了什么的问题,而 Ilya 本人一直缄默。 数学告诉我们:只要数据足够大,远远超过模型规模,那么模型就会有出色表现(低训练误差,低测试误差)。 看来,题海刷得好,考试差不了。 机器学习有几大方向:监督学习、无监督学习、半监督学习以及强化学习

这些方向的理论基础是什么? (4)监督学习 – 万能逼近定理

监督学习理论基础

理论 综上: 监督学习背后的理论保证:

低训练误差+大训练集=模型泛化能力

模型规模一定要小于数据规模,否则,根本不用做「压缩」或抽象,不去找规律,全部死记硬背了。死记硬背的模型没有泛化能力。 当然,题海再大,只是死记硬背,不去归纳总结,脑容量再大、「记忆力」再强,也只是一个填鸭式学霸,缺乏真正的学习应变的能力(叫做「泛化」能力)。 只有当大脑袋里面的「小聪明」不要太高(聪明反被聪明误),才会被迫去总结规律,提炼精华(业内叫「压缩」),从题海中学到真本事。 这就是为什么:模型规模不能太大,不能给模型太多的投机取巧的空间。 Ilya: 大数据 + 低训练误差,监督学习的制胜法宝,有数学证明为保证。

(5)无监督学习 – 分布匹配

但是无监督学习呢?如何为无监督学习寻找到坚实的数学基础? 无监督学习似乎缺乏类似的理论支撑。 但是,Ilya 发现一种叫做「分布匹配」(distribution matching)范式,让无监督学习也获得数学保障。 思考 无监督学习学习的是数据内在特征,如从一堆没有标签的猫狗图片中,自动归纳出猫和狗的共同特征。 这对以后分类猫狗确实有帮助,但如果这堆图片是完全随机的涂鸦,乱成一团,监督学习还能学到什么吗? 就算学到了猫长胡须狗长尾巴这些知识,对别的任务(如识别交通标志)有什么用呢?

透过现象看本质。 比如 GPT 这种分布匹配是一种特殊的模式规律匹配。不同的是,匹配的不是具体字符串或词串(token sequence),而是词与词之间的关系,即语言规律性,类似于语义结构。 Ilya 认为,这种分布匹配才是无监督学习获得智能的本质。 不管是文本、图像还是语音都有内在的分布规律性,而无监督学习能发现、匹配和对齐这些分布规律。 所以,图片不能太随机,数据集不能都是涂鸦,得有一定规律,无监督学习才能抓住隐藏共性。

Ilya 提供的新视角:

这个视角似乎为无监督学习的有效性提供一种解释。 Ilya 进一步解释,分布匹配是如何给无监督学习提供理论保证。 机器翻译领域,曾是监督学习的天下,依赖 对齐后的平行语料,但如果没有双语语料,怎么从两种语言的书籍中学习双语翻译? 分布匹配 只要两种语言原生数据足够丰富,一种语言的输入作为条件就能几乎唯一地确定另一种语言的翻译等价物。 而且,这个原理不仅适用于机器翻译,还适用于语音识别、图像转换等各种 AI 任务。 2015 年,Ilya 就独立发现了这个思路, 并对其数学原理(Kolmogorov 复杂性,简称K 氏复杂性)产生了浓厚兴趣。 原理: 「压缩」理论,无监督学习是在寻找最优的数据压缩方法 无监督学习也能搞定各种语言的机器翻译,甚至任何从输入到输出的转换任务 把无监督学习看作是一个数据压缩问题,从数学上理解无监督学习为什么有效,在任务执行上使之与监督学习处于同等地位。 好的无监督学习算法应该找到数据的最简洁表示(即 K 氏复杂度),同时又能最大限度地利用这种表示来完成下游任务。

数学上,真正的K 氏复杂度不可计算,没法为每份文件都找到最完美的暗号。 但可以训练一个大型神经网络 (如 GPT) 来近似这个过程。因为理论上神经网络可以拟合任何函数,包括「生成文件的最短指令」这个函数。通过不断调整网络的参数,就可以逐步逼近最优的压缩方案。 K 氏复杂度代表压缩的理论极限,任何实际压缩算法都不可能超越它。

虽然这个极限不可达,但它为评判无监督学习算法提供了一个基准。 这就是K 氏复杂度和无监督学习的联系。 核心思想清晰:压缩是无监督学习的本质,而追求最简洁的压缩,就是追求最优的无监督学习。 将传统的独立建模(如英语模型、汉语模型;再如,语言模型、视觉模型,等等)提升到了大一统的关联建模的高度。 在这个范式下,无监督学习的目标不再是单纯地压缩单一群体的数据,而是寻找数据之间的联系。 这种跨模式、跨模态的学习,才是通用人工智能的高级形态。 关键思想: K(Y|X)变成了K(X,Y),条件建模被 Ilya 换成了序列建模,从而论证了 GPT 的大一统。

|