前段时间一位前同事说微调了一个SRE领域的专属大模型(基于 DeepSeek 架构的 7B 参数量模型,经过 LoRA 微调,专为运维领域任务设计。强化了三块能力:自动化脚本生成、系统监控分析、故障排查与根因定位),趁这两天放假打算部署体验一下。- 选择阿里云GPU服务器作为部署环境,本机MAC电脑实在跑不起来。

- GPU的配置建议:系统盘至少100G,内存60G。

- 通过docker镜像的方式将依赖组件打包安装。组件信息如下:

实例支持以下GPU实例规格族: gn6e、ebmgn6e gn7i、ebmgn7i、ebmgn7ix gn7e、ebmgn7e、ebmgn7ex ebmgn8v、ebmgn8is

镜像:选择以Ubuntu 20.04操作系统为例。在GPU实例上使用vLLM容器镜像,需要提前在该实例上安装Tesla驱动且驱动版本应为535或更高,建议您通过ECS控制台购买GPU实例时,同步选中安装GPU驱动。

2、远程连接GPU实例,推荐一款AI 终端神器Warp(强烈建议).sudoapt-getupdatesudoapt-get-yinstallca-certificatescurlsudoinstall-m0755-d/etc/apt/keyringssudocurl-fsSLhttp://mirrors.cloud.aliyuncs.com/docker-ce/linux/ubuntu/gpg-o/etc/apt/keyrings/docker.ascsudochmoda+r/etc/apt/keyrings/docker.ascecho\"deb[arch=$(dpkg--print-architecture)signed-by=/etc/apt/keyrings/docker.asc]http://mirrors.cloud.aliyuncs.com/docker-ce/linux/ubuntu\$(./etc/os-release&&echo"$VERSION_CODENAME")stable"|\sudotee/etc/apt/sources.list.d/docker.list>/dev/nullsudoapt-getupdatesudoapt-getinstall-ydocker-cedocker-ce-clicontainerd.io 4、执行以下命令,检查Docker是否安装成功。 5、执行以下命令,安装nvidia-container-toolkit。 curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \

&& curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \

sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \

sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list

sudo apt-get update

sudo apt-get install -y nvidia-container-toolkit

6、设置Docker开机自启动并重启Docker服务。 sudo systemctl enable docker

sudo systemctl restart docker

sudosystemctlstatusdocker 8、执行以下命令,拉取vLLM镜像。 sudo docker pull egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.8.2-pytorch2.6-cu124-202503289、执行以下命令,运行vLLM容器。 sudodockerrun-d-t--net=host--gpusall\--privileged\--ipc=host\--namevllm\-v/root:/root\egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.8.2-pytorch2.6-cu124-20250328 10、执行以下命令,查看vLLM容器是否启动成功。 git lfsclonehttps://www.modelscope.cn/phpcool/DeepSeek-R1-Distill-SRE-Qwen-7B.git

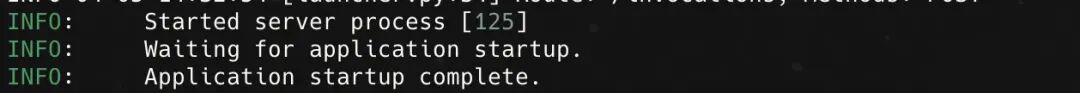

vllmserve/root/DeepSeek-R1-Distill-SRE-Qwen-7B--tensor-parallel-size1--max-model-len2048--enforce-eager 如下所示,表示vLLM推理服务已启动。

curlhttp://localhost:8000/v1/chat/completions\-H"Content-Type:application/json"\-d'{"model":"/root/DeepSeek-R1-Distill-SRE-Qwen-7B","messages":[{"role":"system","content":"你是一位智能运维助手。"},{"role":"user","content":"如何优化服务器的存储性能以提高数据读写速度?"}]}'大模型已经部署起来了,后续会通过一些实际的日志模拟线上故障,测试一下这个模型对故障根因分析的识别情况。再做更多的分享。 |