书接上文,咱们继续来聊聊数据嵌入和向量化。

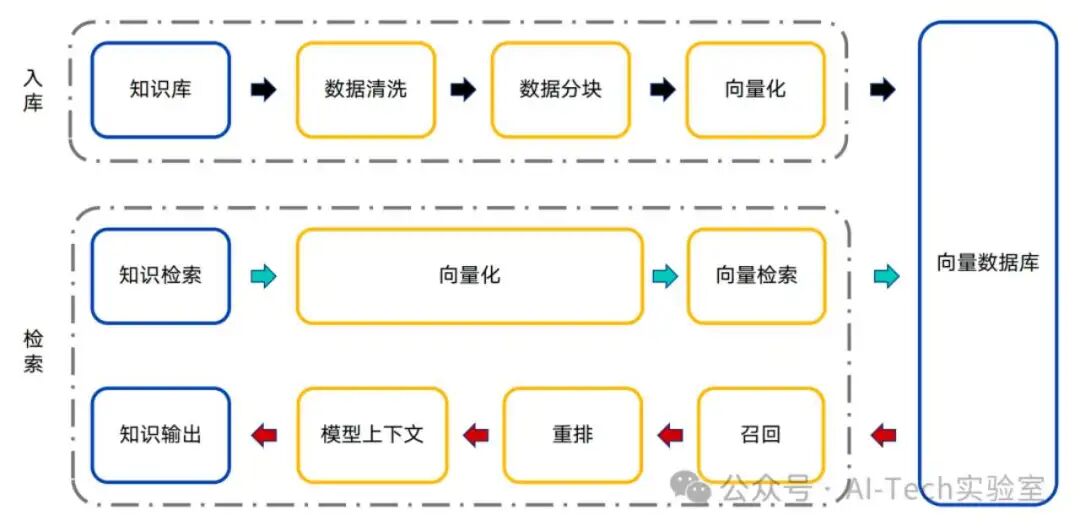

我们知识库的数据经过清洗和分块后,就需要进行向量化,然后存储在向量数据库中。

完整的RAG流程如下:

向量长啥样

密集向量一般会有64 ~ 1536个维度,维度越多,能表示的精度越高,但相应的存储和计算成本越高。

# 原文

“AI-Tech实验室”

# 密集向量

[

0.11878310581111173,

0.9694947902934701,

0.16443679307243175,

0.5484226189097237,

0.9839246709011924,

0.5178387104937776,

0.8716926129208069,

0.5616972243831446,

...

]

为啥要向量化

传统的数据检索采用的是关键字匹配的方法。

但是精度有限,无法理解近义词、同义词。

# 原文

北京紫禁城中有大约186万件文物。

# 关键词检索

Q: 紫禁城有多少文物

A: 186万件

# 近义词、同义词检索效果较差

Q: 故宫有多少文物

A:不知道

换个说法,基本上传统的搜索策略就不行了。

向量在存储中的样子大概长这样:

语义上越相近的内容,距离越接近

通过向量检索,我们就可以极大地提升数据召回的精度了。

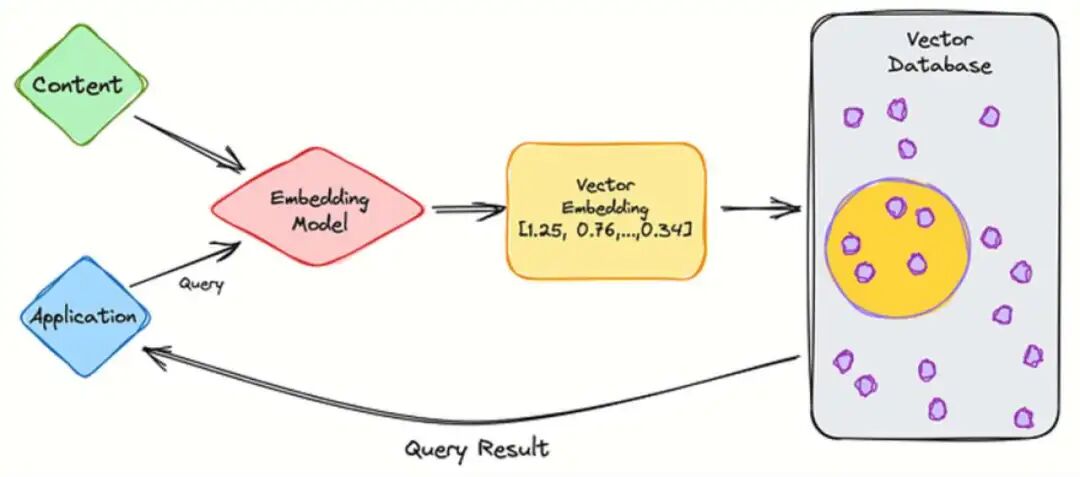

如何向量化

一般需要用到Embedding Model (嵌入模型)。

嵌入模型也是一种预训练模型,通过预先训练,能够理解词跟词之间的关联关系。

常见的嵌入模型:

当然国内各大AI厂商也有自己的嵌入模型。

比如:

Qwen3-Embedding

Doubao-embedding

通过本地部署或者调用API的方式即可使用。

importOpenAIfrom'openai';

constopenai =newOpenAI({

apiKey:"sk-xxxxxx",

baseURL:'https://dashscope.aliyuncs.com/compatible-mode/v1',

});

constembedding =async(text) => {

constresponse =awaitopenai.embeddings.create({

model:"text-embedding-v4",

input: text,

});

returnresponse.data[0].embedding;

};

向量化之后,需要把数据存储到向量数据库中,常见的向量数据库:

| |

|---|

| 通过RedisSearch 模块,也原生支持向量检索 |

| 是面向下一代的生成式AI向量数据库,同时也具备云原生的特性 |

| 是一个为 GenAI 应用程序构建的开源向量数据库 |

| 一个开源的向量数据库。 可以快速基于Python和JavaScript构建内存级LLM应用 |

| |

| 是一个开源的矢量数据库,具有健壮、可拓展、云原生以及快速等特性 |

如果是个人本地学习,建议使用Milvus Lite作为向量数据库。

密集向量与稀疏向量

我们在使用Coze、dify、FastGPT这类智能体平台搭建知识库的时候,往往会遇到一些名词,比如:全文检索、混合检索、语义检索等。这都是啥意思?

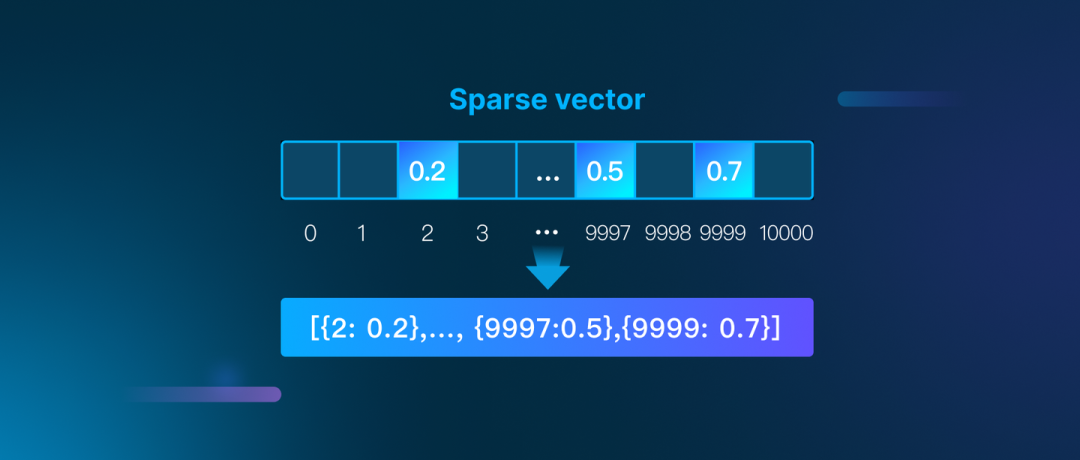

稀疏向量

上面提到的向量示例和向量嵌入模型,基本上都属于密集向量

# 密集向量

# 所有的维度都是连续有值的

[

0.11878310581111173,

0.9694947902934701,

0.16443679307243175,

0.5484226189097237,

0.9839246709011924,

0.5178387104937776,

0.8716926129208069,

0.5616972243831446,

...

]

# 稀疏向量

# 大多数维度值为0,只有少数维度有值,看起来比较“稀疏”

[{

0:0,

1:0,

...

34:0.5,

35:0,

...

443:0,

444:0.6

445:0,

...

5364:0.4

}]

# 通常表示的时候会去掉0维度的向量

[{

34:0.5,

444:0.6,

5364:0.4

}]

TF-IDF / BM25算法

TF-IDF算法通过对全文进行统计算法,最终把文档转化为一组稀疏变量。

其中:

TF指的是某个词在全文中出现的“词频”,出现次数越多,TF越大IDF称为逆向文档频率,某个词出现的频率越多,IDF权重越低,比如“好的,没问题”这种词虽然出现频率很高,但其实没有检索的实际意义,出现频率更少的更有可能是实际有意义的词汇。

BM25是TF-IDF的演进算法

咱们不需要特别去理解BM25的算法细节,只需要知道:

BM25是一种通过统计公式计算关键词关联度的算法

既:它其实并不理解文章的意思,但通过某种统计规律“猜出”查询关键词和原文的关联关系。

平时大家见到的“全文检索”,大概率就是基于BM25的稀疏变量检索方法。

SPLADE

SPLADE Model也是一个预训练模型,它利用现有的语言模型基于人工标注的搜索/排序数据进行训练,得到最终的结果。

因此,通用数据的处理上,SPLADE 一定比简单的 BM25 表现好。

但是咱们制作知识库,一般都是使用企业内部的私有知识,跟SPLADE的预训练数据并不一致,所以效果也不一定就比BM25更好。

具体使用哪种策略,要根据实际的业务场景决定。

混合检索、全文检索、语义检索

其实通过上面的内容,大家应该也能猜到大概了。既:

语义检索:其实对应的就是密集向量检索(Dense Embedding)全文检索:对应的是稀疏向量检索(Sparse Embedding)

举个例子

现在有一个关于“雪花啤酒”的知识库,分段存储在向量数据库中

# 知识库分段内容

[{

name:'对于消费者而言,雪花代表了高性价比和多元化的选择,从日常佐餐到潮流聚会均可覆盖。'

},{

name:'国际:百威、科罗娜、喜力(在华通过雪花渠道销售)。'

},{

name:'品牌历史起源于1957年成立的沈阳啤酒厂。1994年华润收购沈阳啤酒厂,并与SABMiller合作成立华润雪花,正式进入啤酒行业。'

},

{

...

}]

# Step1: 文本嵌入

# 使用Embedding Model + SPLADE进行向量化嵌入。

# vector是密集向量

# sparse是稀疏向量

[

{

name:'对于消费者而言,雪花代表了高性价比和多元化的选择,从日常佐餐到潮流聚会均可覆盖。',

vector: [

0.11878310581111173,

0.9694947902934701,

...

],

sparse: [{

34: 0.32,

67: 0.64

...

}]

},

{

name:'国际:百威、科罗娜、喜力(在华通过雪花渠道销售)。',

vector: [

0.9992090731236536,

0.8248790611809487,

...

],

sparse: [{

342: 0.42,

679: 0.641

...

}]

},

{

name:'品牌历史起源于1957年成立的沈阳啤酒厂。1994年华润收购沈阳啤酒厂,并与SABMiller合作成立华润雪花,正式进入啤酒行业。',

vector: [

0.8761291569818763,

0.07127366044153227,

...

],

sparse: [{

3: 0.21,

437: 0.22

...

}]

},

];

# 用户问题

雪花啤酒成立时间?

# Step2:查询问题向量化

{

name:'雪花啤酒成立时间?',

vector: [

0.3761291569818763,

0.12127366044153227,

...

],

sparse: [{

5: 0.41,

35: 0.62

...

}]

}

# Step3: 语义检索

# 语义检索结果

# 分数越低代表距离越近,相关度越高。

{

score: 0.512241005897522,

name:'雪花啤酒(Snow Beer)是中国最知名的啤酒品牌之一,隶属于华润雪花啤酒(中国)有限公司,由华润集团与全球啤酒巨头SABMiller合资创立。'

},

{

score: 0.5282324552536011,

name:'雪花啤酒以“年轻化、多元化”为品牌战略,主要产品包括主流系列、高端系列及国际品牌。'

},

{

score: 0.5613145232200623,

name:'品牌历史起源于1957年成立的沈阳啤酒厂。1994年华润收购沈阳啤酒厂,并与SABMiller合作成立华润雪花,正式进入啤酒行业。'

}

# Step4: 全文检索

# 全文检索结果

# 分数越高,相关性越大

{

score: 0.31,

name:'自2006年起,雪花销量连续多年全球第一,2022年销量约1100万千升,占中国啤酒市场约30%份额。'

},

{

score: 0.52,

name:'品牌历史起源于1957年成立的沈阳啤酒厂。1994年华润收购沈阳啤酒厂,并与SABMiller合作成立华润雪花,正式进入啤酒行业。'

},

{

score: 0.11,

name:'雪花推行“零碳工厂”计划,减少水资源消耗和碳排放,并开展“雪花勇闯'

}

# Step5: 排序后返回

# 最终结果

# 通过综合加权排序后得到最终结果

# 并召回完整的分段

A: 雪花啤酒(Snow Beer)是中国最知名的啤酒品牌之一...的详细介绍:

1. 品牌历史与发展

起源:雪花啤酒的前身是沈阳啤酒厂,成立于1957年。1994年,华润集团收购沈阳啤酒厂,正式进入啤酒行业,并与SABMiller合作成立华润雪花。

快速扩张:通过兼并收购地方品牌...保持至今。

国际化:2018年...国际化布局。

...

结语

我们在实际搭建知识库的时候,往往会采取多种向量检索和存储的方案。通过多路召回“海选”出每个小组的TopK个结果,然后进入淘汰赛阶段,优中选优,找到关联度最高的结果。