|

接着上一篇文章,有朋友问到一些使用ollama相关的一些问题,总结下供大家参考。顺便吐槽下大模型瞎扯的事儿。

安装ollama本体,ollama本体下载国内网有点吃力,有需要的朋友可以在公众号回复:ollama.windows和ollama.mac获取对应的安装包百度网盘链接。

- 大模型下载,模型下载国内网是可以的(通过ollama pull <模型名称> 或者 ollama run <模型名称>),很快。即使看到类似服务器响应过久的提示失败了也可以再试一下。有需要的朋友可以在公众号回复:ollama.model获取百度网盘链接,里面有llama2 7B模型和nomic-text-embed模型。llama2是用于大语言对话的,embed是用来理解你的笔记的。

- Windows用GPU, ollama windows默认直接会调用GPU的,不需要额外的设置。有兴趣的朋友可以看下这篇官方的blog,https://ollama.com/blog/windows-preview

-

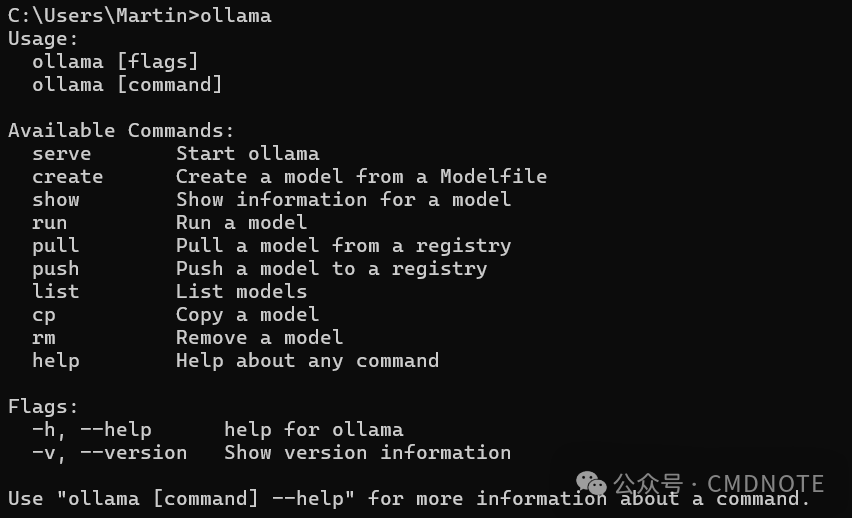

ollama命令,在cmd里输入ollama回车,就能看到ollama的一些基本命令

ollama serve - 启动ollama服务器

ollama list - 列出已下载的所有模型,存在你的的"C:\Users\%username%\.ollama\models"里,如果没有改过位置的话

ollama run <模型名称> - 在cmd里跑xx模型,把<模型名称>替换成你要用的模型,可以通过list命令看每个模型叫什么

ollama rm <模型名称> - 删除xx模型

最近使用的时候还发现一些有趣的点,想到可能会影响以后的习惯。

发现瞎扯:最近用的时候发现大模型瞎扯的能力依然很强。一旦发现他开始瞎扯就重新开始新的对话我感觉有点帮助。

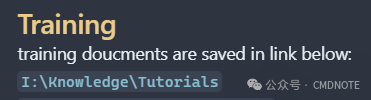

精简笔记 vs 提供更多的信息:之前记笔记我会习惯性的有一点省略,速度快比较重要。比如下面这个例子,人一眼就能知道Training相关的内容存在I盘这个位置,但是当我把这一页笔记发给llama2后问他Tranining相关的内容在哪他并不知道,可能是模型比较小或者设置原因。

但换个角度想,现在大模型理解要比人看的快,如果这个笔记要被大模型去用,那提供更多的信息可能会更有用?。不过这也可能增加超Token限制的可能性,同时我也希望笔记不要太罗嗦以至于影响可读性,需要平衡一下。

可能的优化方式:提升问答的准确性我感觉还是需要一定的优化。最近我还有在玩字节的扣子Coze,这东西是字节版的GPTs,他里面有个workflow挺有意思的。现在这些大模型靠的是“猜”,传统的编程主要是完成预设好的任务。光靠AI猜不明白,那我就先通过一定逻辑编程,预处理一些信息,再交给大模型去理解和总结,Coze的workflow+LLM我感觉就有点这个意思。比如obsidian里有各种tag,可以先找出所有有“#渲染”标签的文章,然后再在这些文章里去筛选然后总结,出来的结果应该会比把所有笔记都丢给LLM好得多。

Obsidian Copilot应该已经用LangChain做了一些优化了,也许可以再深挖一下?。另外Coze的workflow是低代码的形式,低代码好啊,这两天正好看到篇文章说ComfyUI for everything,ComfyUI+Obsidian+LLM我觉得可以,哈哈哈。

希望以上的内容能对大家有所帮助,欢迎各种交流?~

|