什么是 Ollama?Ollama 是一个用于在本地运行大型语言模型 (LLM) 的开源框架。它支持多种平台,包括 Windows、Linux 和 macOS。 Ollama 的主要功能包括: Ollama 的优势包括: 易于使用:Ollama 提供简单的命令行界面,即使是没有经验的用户也可以轻松使用。 高性能:Ollama 使用高效的 C++ 代码编写,可以充分利用您的硬件资源。 可扩展性:Ollama 支持多种 LLM 模型,并且可以扩展以支持新的模型。

Ollama 的使用场景包括: 研究:Ollama 可用于研究人员开发和测试新的 LLM 模型。 教育:Ollama 可用于教育工作者向学生介绍 LLM 技术。 商业:Ollama 可用于企业开发 LLM 驱动的应用程序。

Ollama 的官方网站:https://ollama.com/ 为什么 Ollama 能够脱颖而出?Ollama 能够脱颖而出,主要有以下几个原因: 易用性: Ollama 提供简单的命令行界面,即使是没有经验的用户也可以轻松使用。 高性能: Ollama 使用高效的 C++ 代码编写,可以充分利用您的硬件资源。 可扩展性: Ollama 支持多种 LLM 模型,并且可以扩展以支持新的模型。 活跃的社区: Ollama 拥有一个活跃的社区,可以为用户提供帮助和支持。 免费开源: Ollama 是免费开源的,任何人都可以自由使用和修改。 以下是一些具体的原因: Ollama 提供了一个简单的命令行界面,即使是没有经验的用户也可以轻松使用。 这与其他 LLM 框架形成鲜明对比,这些框架通常需要用户编写复杂的代码。 Ollama 使用高效的 C++ 代码编写,可以充分利用您的硬件资源。 这意味着 Ollama 可以比其他 LLM 框架更快地运行 LLM 模型。 Ollama 支持多种 LLM 模型,并且可以扩展以支持新的模型。 这使得 Ollama 能够满足各种用户的需求。 Ollama 拥有一个活跃的社区,可以为用户提供帮助和支持。 这对于初学者和经验丰富的用户都非常有帮助。 Ollama 是免费开源的,任何人都可以自由使用和修改。 这使得 Ollama 成为一个非常具有吸引力的选择。

总而言之,Ollama 是一个易于使用、高性能、可扩展且免费开源的 LLM 框架。这些因素使得 Ollama 能够脱颖而出。 在 Windows 上使用 Ollama欢迎迈入 AI 和 ML 的新时代!接下来,我们将带你完成上手的每一步,还会提供一些实用的代码和命令示例,确保你一路畅通。 步骤 1:下载和安装1:访问 Ollama Windows Preview 页面,下载OllamaSetup.exe安装程序。 2:双击文件,点击「Install」开始安装。 在 Windows 中安装 Ollama

3:安装完成之后,就可以开始在 Windows 上使用 Ollama 了。

步骤 2:启动 Ollama 并获取模型要启动 Ollama 并从模型库中获取开源 AI 模型,请按以下步骤操作: 1:在「开始」菜单中点击 Ollama 图标,运行后会在任务栏托盘中驻留一个图标。

从开始菜单中启动 Ollama 2:右键点击任务栏图标,选择「View log」打开命令行窗口。

3:执行以下命令来运行 Ollama,并加载模型: ollamarun[modelname]  运行 qwen:4b 模型 运行 qwen:4b 模型

执行以上命令后,Ollama 将开始初始化,并自动从 Ollama 模型库中拉取并加载所选模型。一旦准备就绪,就可以向它发送指令,它会利用所选模型来进行理解和回应。 记得将modelname名称换成要运行的模型名称,常用的有: 运行 7B 至少需要 8GB 内存,运行 13B 至少需要 16GB 内存。 步骤 3:使用模型如前所述,Ollama 支持通过各种各样的开源模型来完成不同的任务,下面就来看看怎么使用。

输入文字开始与 qwen 模型对话 步骤 4:连接到 Ollama API我们不可能只通过命令行来使用,将应用程序连接到 Ollama API 是一个非常重要的步骤。这样就可以把 AI 的功能整合到自己的软件里,或者在 LobeChat / AnythingLLM 这类的前端工具中进行调用。

以下是如何连接和使用 Ollama API 的步骤: 1:右击点击任务栏图标,选择「Quit Ollama」退出后台运行。

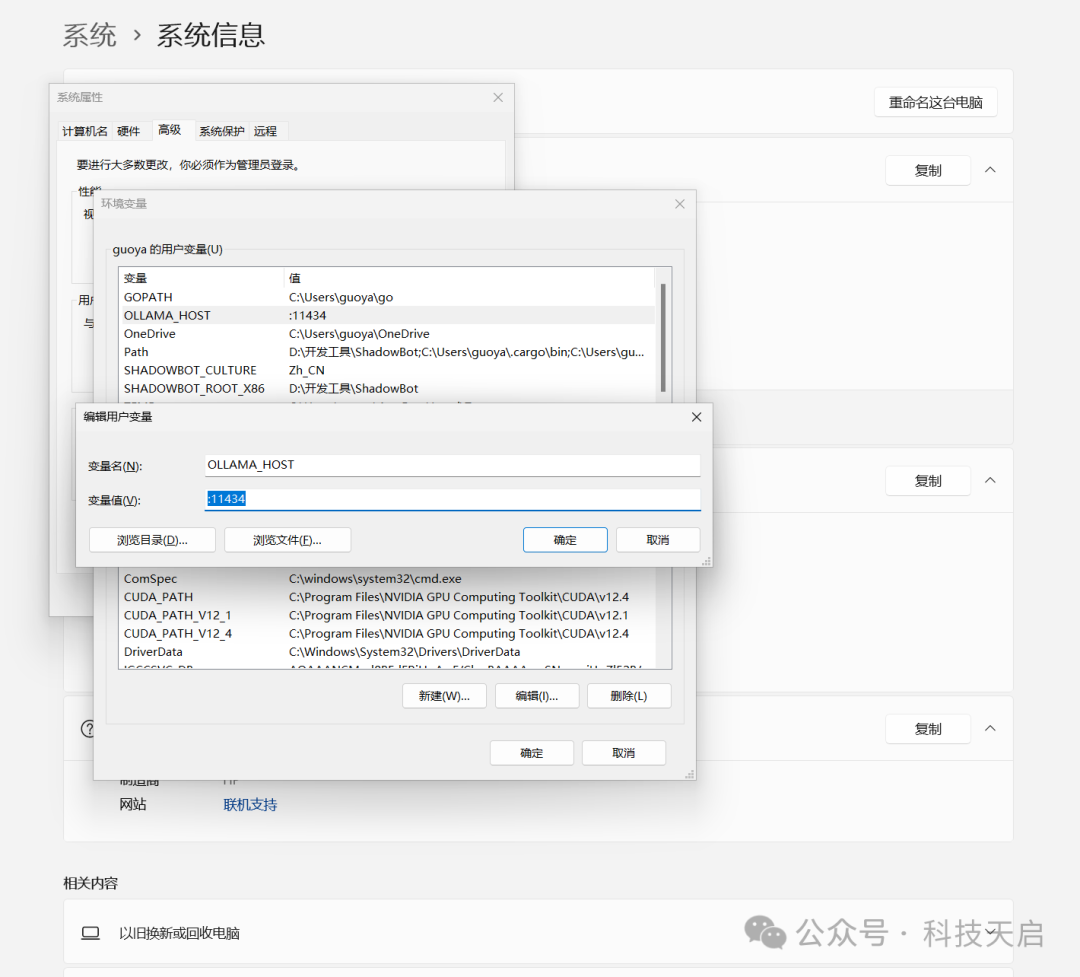

2:使用Windows + R快捷键打开「运行」对话框,输出以下命令,然后按Ctrl + Shift + Enter以管理员权限启动「环境变量」。 C:\Windows\system32\rundll32.exesysdm.cpl,EditEnvironmentVariables 3:要更改侦听地址和端口,可以添加以下环境变量: 变量名:OLLAMA_HOST 变量值(端口)::11434

指定 Ollama API 侦听地址和端口

只填写端口号可以同时侦听(所有) IPv4 和 IPv6 的:11434端口。 要使用 IPv6,需要 Ollama 0.0.20 或更新版本。

4:如果安装了多个模型,可以通过OLLAMA_MODELS变量名来指定默认模型。

5:更改完之后,重新运行 Ollama。然后在浏览器中测试访问,验证更改是否成功。

验证 API 工作状态 验证 API 工作状态

6 示例 API 调用:要使用 Ollama API,可以在自己的程序里发送 HTTP 请求。下面是在「终端」里使用curl命令给 Gemma 模型发送文字提示的例子: curlhttp://192.168.50.123:11434/api/generate-d'{"model":"qwen:4b","prompt":"海洋美吗?"}'

Ollama API 调用示例

Ollama 的常用命令有:# 查看 Ollama 版本ollama -v

# 查看已安装的模型ollama list

# 删除指定模型ollama rm [modelname]

# 模型存储路径# C:\Users\<username>\.ollama\models

按照上述步骤,并参考命令示例,你可以在 Windows 上尽情体验 Ollama 的强大功能。不管是在命令行中直接下达指令,通过 API 将 AI 模型集成到你的软件当中,还是通过前端套壳,Ollama 的大门都已经为你敞开。 Ollama on Windows 的最佳实践要让 Ollama 在 Windows 上充分发挥最大潜力,需要注意以下几点最佳实践和技巧,这将帮助你优化性能并解决一些常见问题: 优化 Ollama 的性能:检查硬件配置:确保你的设备满足 Ollama 推荐的硬件要求,尤其是运行大型模型时。如果你有 NVIDIA 或 AMD GPU,还可以享受 Ollama 提供的自动硬件加速,大幅提升计算速度。 更新驱动程序:保持显卡驱动程序为最新版本,以确保与 Ollama 的兼容性和最佳性能。 释放系统资源:运行大型模型或执行复杂任务时,请关闭不必要的程序,释放系统资源。 选择合适模型:根据任务需求选择合适的模型。大参数模型虽然可能更准确,但对算力的要求也更高。对于简单任务,使用小参数模型更有效率。

|