|

开源预训练的大型语言模型(LLMs)展现出强大的语言理解和生成能力,使它们在多种任务中取得巨大成功。然而,在现实世界中处理复杂问题时,开源预训练的大型语言模型(如GPT-3和GPT-4)表现出强大的语言理解和生成能力,但与商业模型(如ChatGPT和GPT-4)相比,它们的性能仍有较大差距。作为智能体,LLMs需要具备任务规划、长期记忆和利用外部工具的能力。为了提升LLMs的智能体能力,提出了多种方法,包括构建特定于智能体的数据和对模型进行微调,以及设计有效的提示来激活LLMs的推理能力。 开源LLMs和商业LLMs的智能体性能,总体得分是几个agent任务的平均准确度

针对7B和13B模型进行了探索,提出了一种使用GPT-4构建特定于智能体数据的全面方法,通过使用构建的数据进行监督微调,对于这些参数数量相对较少的模型,监督微调可以显著减少智能体任务中的幻觉输出和格式错误。此外,多路径推理和任务分解等技术可以有效降低问题的复杂性,并增强LLMs作为智能体的性能。 - 通过监督微调(Supervised Fine-Tuning, SFT)来提高智能体能力。这种方法通过在多样化的数据集上训练LLMs,使其能够反映智能体与环境之间的互动行为,从而根本性地提升LLMs的能力。

构建agent数据的过程,对于任务规划和外部工具使用能力,分别采用两种策略

- 受“思维链”(Chain of Thought)启发,提出了一种结合任务分解和回溯的多路径推理方法,以有效降低问题复杂性并增强LLMs作为智能体的性能。任务分解利用LLMs的任务规划能力,将复杂任务分解为更小的子任务。而多路径推理则允许模型在每个推理步骤中生成多个可行的动作,并使用一个判断模型来选择最佳动作。这种方法可以有效地降低问题复杂性,并提高LLMs作为智能体的性能。

任务分解的过程,规划模型将整个任务分解成几个小的子任务。

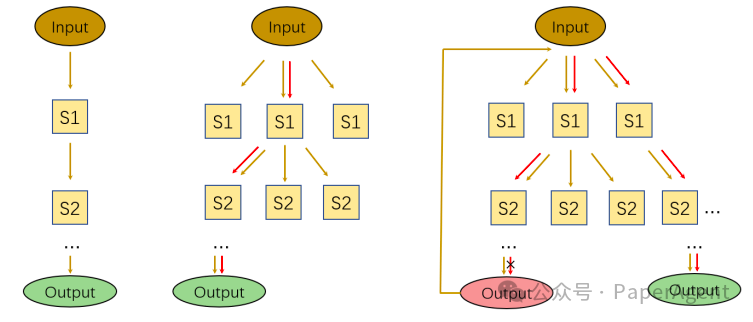

不同推理方法的比较,从左到右分别是输入输出(IO)、思维树(ToT)和提出的方法

在AgentBench基准上选择了五个agent任务进行评估,包括ALFWorld、WebShop、Mind2Web、操作系统和数据库操作。实验结果表明,通过使用GPT-4构建的特定于智能体的数据进行监督微调,可以显著提高LLMs在agent任务上的性能,尤其是在减少幻觉输出和格式错误方面。在AgentBench任务上使用不同指令调整数据集对大型语言模型(LLMs)进行微调的实验结果。使用llama2-7b-chat作为基础模型

此外,通过引入多路径推理和任务分解技术,可以有效地简化复杂任务,帮助LLMs找到最优解。

ReAct方法和提出的方法在agent任务推理中的比较示例,展示了在网络商店和家务任务中的行动和观察。

EnhancingtheGeneralAgentCapabilitiesofLow-ParameterLLMsthroughTuningandMulti-BranchReasoninghttps://arxiv.org/pdf/2403.19962.pdf |