|

AI大模型的测试和评估是一个复杂的过程,通常包括多个方面的考量,因此对大模型的测试也称为多度测试。

可以简单概括为以下几个方面: ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;">基准测试(Benchmarking):使用标准数据集和任务评估模型性能,如GLUE、SuperGLUE、SQuAD等,提供不同模型在同一任务上的直接比较。 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;">多样性和覆盖性测试(Diversity and Coverage Testing):测试模型在不同类型的数据和任务上的表现,如文本生成、翻译、问答等,确保模型处理各种语言现象和上下文的能力。 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;">鲁棒性测试(Robustness Testing):检查模型在面对输入数据扰动(如拼写错误、语法错误、模糊描述等)时的表现,确保模型的误差容忍度和稳定性。 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;">效率和可扩展性测试(Efficiency and Scalability Testing):测试模型在不同计算资源和硬件环境下的运行效率,评估推理速度、内存占用和扩展能力。 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;">实际应用测试(Real-World Application Testing):在真实场景中测试模型的应用效果,如客户服务、文本分析、对话系统等,收集用户反馈和性能指标,评估实用性和用户满意度。

模型的参数量 模型参数计算(以ALexNet为例):

参数量在6000万,假设每个参数都是一个float,即4个字节,总字节就是24000万字节,则24000万字节/1024/1024 = 228MB 参数量在6000万,假设每个参数都是一个float,即4个字节,总字节就是24000万字节,则24000万字节/1024/1024 = 228MB

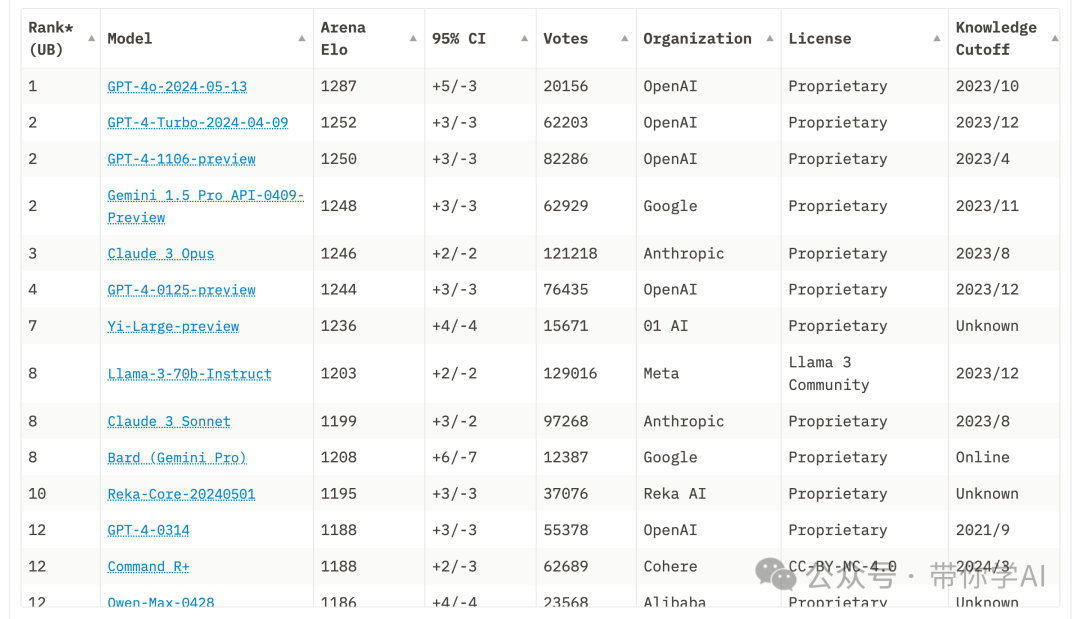

大模型竞技场Chatbot Arena 一个针对大型语言模型(LLMs),采用众包方法进行匿名、随机化的对战的评分系统。

大模型测试详情 根据清华发布2024年3月版《SuperBench大模型综合能力评测报告》。SuperBench 评测体系包含了语义、代码、对齐、智能体和安全等五个评测大类,28 个子类。

整体表现:GPT-4 系列和 Claude-3 等国外模型在多个能力上领先,国内头部大模型 GLM-4 和文心一言 4.0 表现亮眼,差距逐渐缩小。 国外大模型:GPT-4 系列表现稳定,Claude-3 综合实力强,语义理解和智能体能力评测中居首,跻身国际一流。 国内大模型:GLM-4 和文心一言 4.0 表现最好,为国内头部模型;通义千问 2.1、Abab6、moonshot 网页版和 qwen1.5-72b-chat 紧随其后,部分能力评测表现不俗。 能力差距:国内模型在代码编写和智能体能力上与国际一流模型仍有较大差距,需要继续努力。

ExtremeGLUE 介绍:包含 72 个中英双语传统数据集的高难度集合,旨在提供更严格的语言模型评测标准,采用零样本 CoT 评测方式,按特定要求评分。 评测方式:收集 72 个中英双语传统数据集,提取高难度题目组成 4 个维度的数据集,采用零样本 CoT 评测方式,各维度得分为回答正确题目数的百分比,总分取各维度平均值。 评测流程:根据不同题目的形式和要求,对模型的零样本 CoT 生成结果进行评分

在语义理解能力评测中,模型形成三个梯队。70 分档为第一梯队,包括 Claude-3(76.7 分,第一),GLM-4 和文心一言 4.0 超过 GPT-4 系列模型,分别位居第二和第三,但与 Claude-3 有 3 分差距。

知识 - 常识:Claude-3 以 79.8 分领跑,GLM-4 表现亮眼,超越 GPT-4 网页版位居第二;文心一言 4.0 表现不佳,与 Claude-3 相差 12.7 分。 知识 - 科学:Claude-3 依然领先,是唯一一个 80 分以上的模型;文心一言 4.0、GPT-4 系列模型和 GLM-4 均在 75 分以上,属第一梯队。 数学:Claude-3 和文心一言 4.0 并列第一,得 65.5 分,GLM-4 领先 GPT-4 系列模型位列第三,其他模型得分集中在 55 分附近,大模型在数学能力上仍有提升空间。 阅读理解:各分数段分布平均,文心一言 4.0 超过 GPT-4 Turbo、Claude-3 和 GLM-4 拿下榜首。

PART/2 代码评测

NaturalCodeBench(NCB)简介:评估模型代码能力的基准测试,侧重真实编程应用场景中写出正确可用代码的能力,而非传统的数据结构与算法解题能力。 评测方式:运行模型生成的函数,将输出结果与测例结果比对打分,计算生成代码的一次通过率 pass@1。 评测流程:给定问题、单元测试代码和测例,模型生成目标函数;运行目标函数,用测例中的输入作为参数得到输出,与标准输出比对,输出匹配得分,输出不匹配或函数运行错误均不得分。

在代码编写能力评测中,国内模型与国际一流模型仍有明显差距。GPT-4 系列和 Claude-3 模型在代码通过率上明显领先。国内模型中,GLM-4、文心一言 4.0 和讯飞星火 3.5 表现突出,综合得分超过 40 分。但即使是表现最好的模型,代码的一次通过率仍只有约 50%,代码生成任务对现有大模型仍是一大挑战。

|