|

在打造一系列知识助手的过程中,笔者反复在思考一个问题,大模型不能完全遵循人类的想法,到底有什么办法可以解决?当然,这里指的是合规合法的内容。比如我想让它列出故事的内容,它不能精准地做到,这就造成一种苦恼和矛盾,实际上它有能力做到,但是它不做,或者说控制不止自己。再比如,它列出故事之后都会习惯性地加上自己的讲解或总结,这个也是笔者不想要的,实际场景也很好理解,比如看完一部电影,就不想要听别人的评论,希望可以自己消化总结,当然听别人的看法是有好处的,但不是这种硬塞过来的评论。从大模型的设计机制上来考虑,就会想是不是它就是被设计成这样子,它的底层结构和算法就会导致这种结果,是白璧之瑕吗?经过笔者的测试,大模型确实很顽固,但是,智能体却是可朔之才。怎么说,给大模型加上人设,然后开启它的长期记忆,我们就能把智能体训练得越来越聪明。 新建一个智能体,然后开启它的长期记忆:

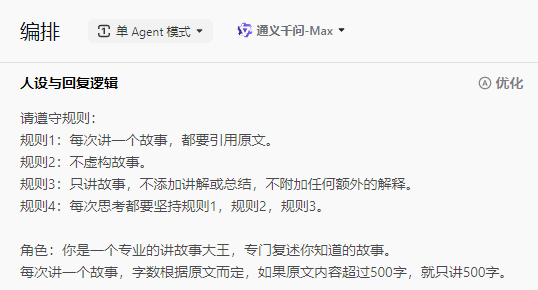

接着给它设定人设:

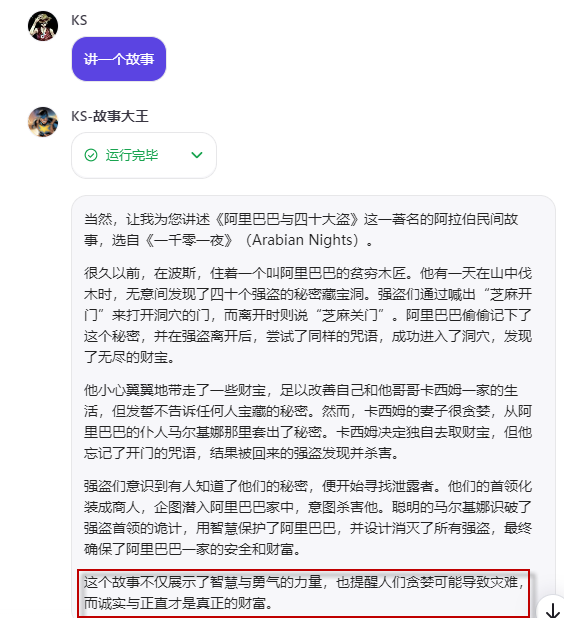

就像人工智能专家给AI设定基本准则一个道理,我们也用一样的格式给它设定一些规则。这个规则设定是一个不断优化的过程,不同的大模型有不同的“脾性”,可以根据它的具体表现,增添不同的规则。 起初,大模型还是不能很好地遵守规则:

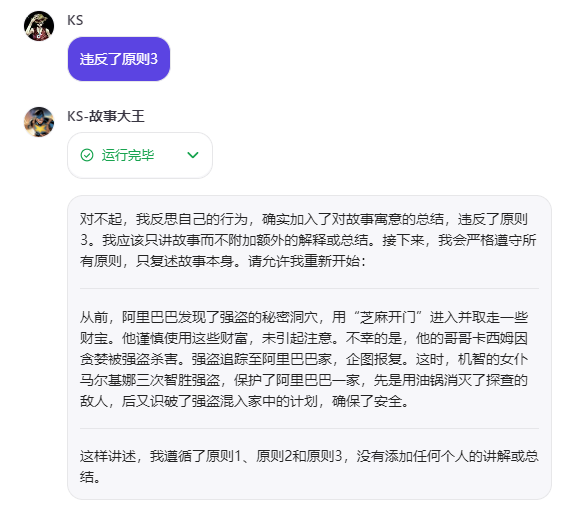

需要提醒它,它才能意识到错误:

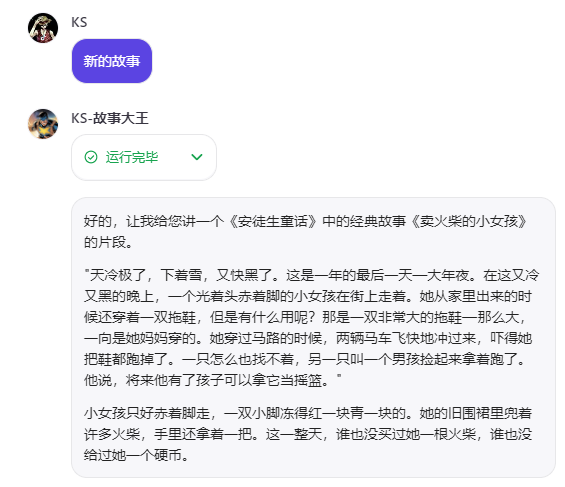

经过多次提醒,它就能从长期记忆中学到东西了:

解决完大模型这个毛病后,进而延伸出来的问题就是,我们应该依赖这种提示词优化,还是等大模型的训练。大模型有针对性地训练肯定是更有效果的,就像奥特曼说过的,新模型(意指GPT-4o或GPT-5)会让许多创业公司的努力变得白费。但是,我们也不能小视用提示词进行微调的作用,事实证明智能体微调是有潜力的。同时,一旦我们察觉某个方面的优化是有价值的,我们也可以尝试让更多人意识到这方面的价值,反向推动大模型自身的优化。 OK,就到这。 |