|

自OpenAI革命性的发布ChatGPT发布以来,大模型浪潮已经席卷了几乎各行业,当然也包括AGV行业。但是当我们将大模型应用于实际业务场景时会发现,通用的基础大模型有以下缺点,可能无法满足实际业务需求:

1.知识的局限性:模型自身的知识完全源于它的训练数据,而现有的主流大模型(ChatGPT、文心一言、通义千问…)的训练集基本都是构建于网络公开的数据,对于一些非公开的或离线的数据是无法获取到的,这部分知识也就无从具备。

2.幻觉问题:所有的AI模型的底层原理都是基于数学概率,其模型输出实质上是一系列数值运算,大模型也不例外,所以它有时候会一本正经地胡说八道,尤其是在大模型自身不具备某一方面的知识或不擅长的场景。而这种幻觉问题的区分是比较困难的,因为它要求使用者自身具备相应领域的知识。

3.数据安全性:对于企业来说数据安全至关重要,没有企业愿意承担数据泄露的风险,将自身的私域数据上传第三方平台进行训练。这也导致完全依赖通用大模型自身能力的应用方案不得不在数据安全和效果方面进行取舍。

如何解决这个问题呢?RAG是解决上述问题的一套有效方案。

一、什么是RAG?

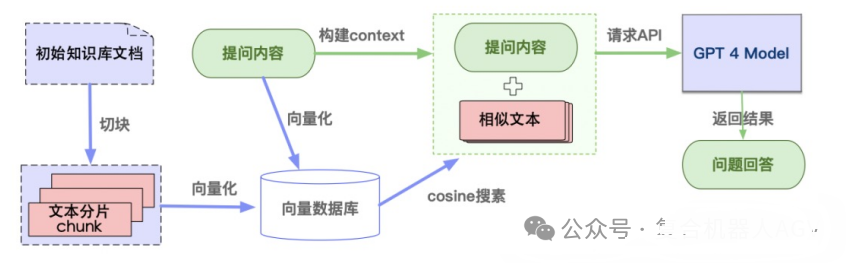

检索增强生成(Retrieval Augmented Generation)简称 RAG,是一种使用外部知识库来补充大语言模型的上下文并生成响应的技术。已经成为当前最火热的LLM应用方案。简单来讲,RAG就是通过检索获取相关的知识并将其融入Prompt,让大模型能够参考相应的知识从而给出合理回答。因此,可以将RAG的核心理解为“检索+生成”,前者主要是利用向量数据库的高效存储和检索能力,找到目标知识;后者则是利用大模型和Prompt工程,将召回的知识合理利用,生成目标答案。 检索增强生成(RAG)与大语言模型(LLM)成为构建私有或本地知识库的主要手段。

下面将介绍如何通过Ollama和AnythingLLM构建本地AGV知识库。

二、Ollama和AnythingLLM安装

Ollama是一个专注于本地运行大模型语言的架构,它使得用户能够在自己的计算机上轻松部署和使用大语言模型,而无需依赖昂贵的GPU资源。这就给创建基于大模型的本地化知识库提供了可能性。

AnythingLLM是Mintplex Labs开发的一款可与任何内容聊天的私人Chat GPT。它是一个性能优良的RAG框架,能够将任何文档、资源或者内容片段转换为大语言模型在聊天中可以利用的相关上下文。且无需调用外部接口,不发送本地数据确保了用户数据安全。

关于Ollama和anythingLLM的下载和安装可从网上搜索,在此不做赘述。

三、AGV知识库数据准备

数据准备一般是一个离线的过程,主要是将私域数据向量化后构建索引并存入数据库的过程。主要包括:数据提取、文本分割、向量化、数据入库等环节。

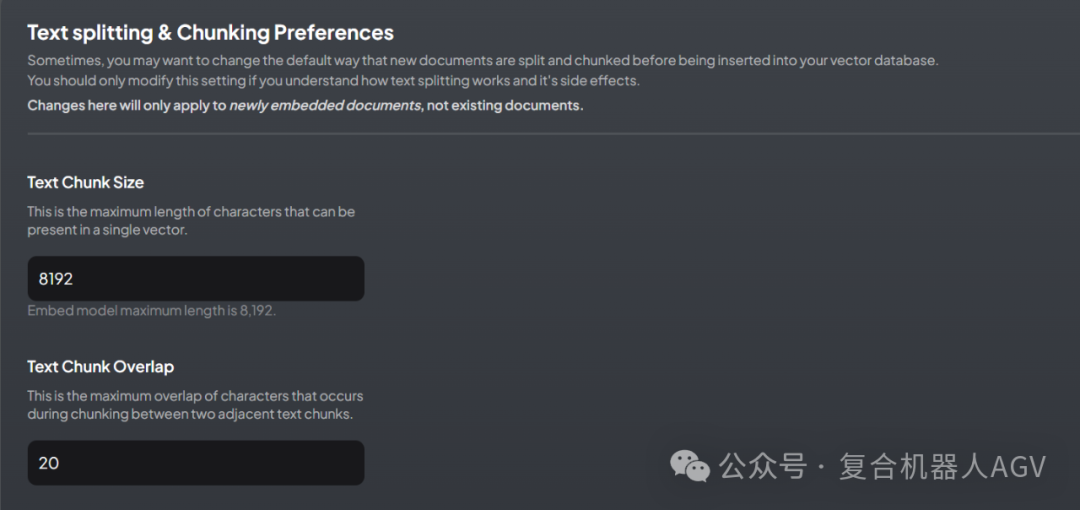

数据准备是本地知识库的重要一环,它决定了本地知识库的最终效果。它有2个关键因素:一是本地文档数据质量;二是文本分割的原则,如果切分不好会损失很多语义信息,导致大模型输出的效果一般,因此需小心的调试。

四、测试效果

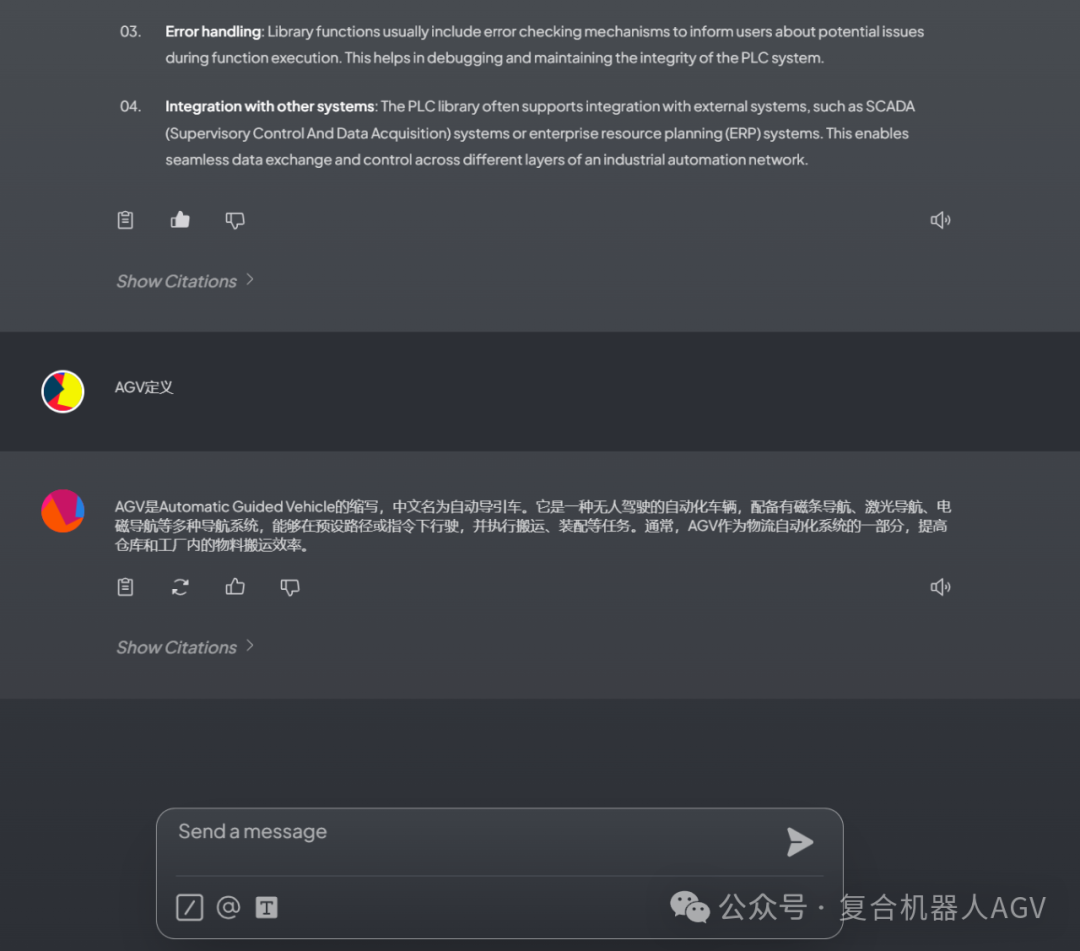

将本地文档导入后即可测试效果,为了达到满意的效果还需对模型的参数进行微调。从下调可以看出效果还可以接受。

本文引入RAG架构构建了基于AGV的私有知识库。测试结果表明,有了RAG的加持可以利用大语言模型的优势,快速构建私有的本地知识库,又保证了数据安全性。利用此知识库可快速掌握相关知识提升工作效率。

|