|

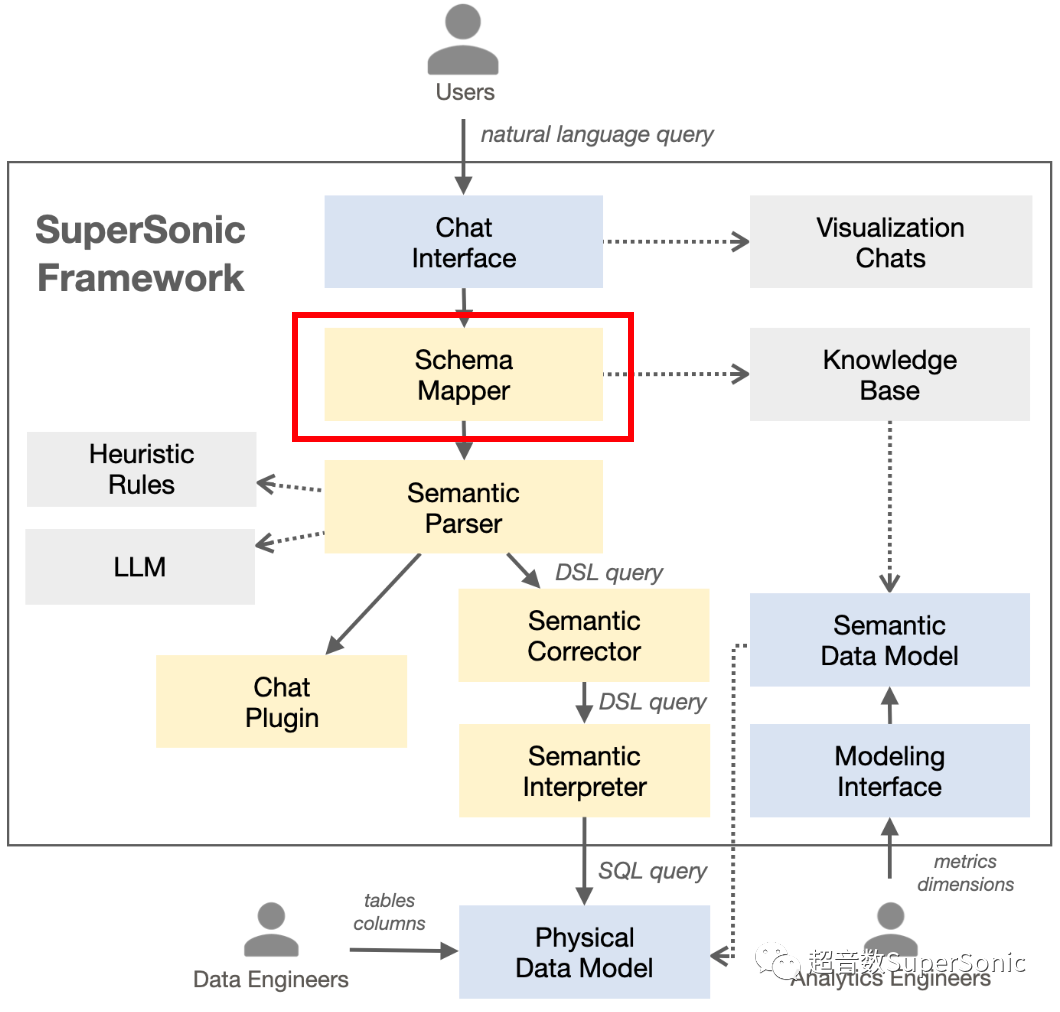

一、Mapper功能总体介绍 从SuperSonic的架构图,可以看到Schema Mapper处在一个很重要位置;主要功能是从输入文本中,解析所有可能存在的SchemaElement;并将这些SchemaElement数据将传递到下一步的Parser中,作为后续Parser解析识别使用;

其中SchemaElement主要分为几个类型:model(模型)、metric(指标)、dimension(维度)、value(维度值)、entity(实体名);那么Mapper是如何识别文本成SchemaElement呢?

二、Mapper实现解析

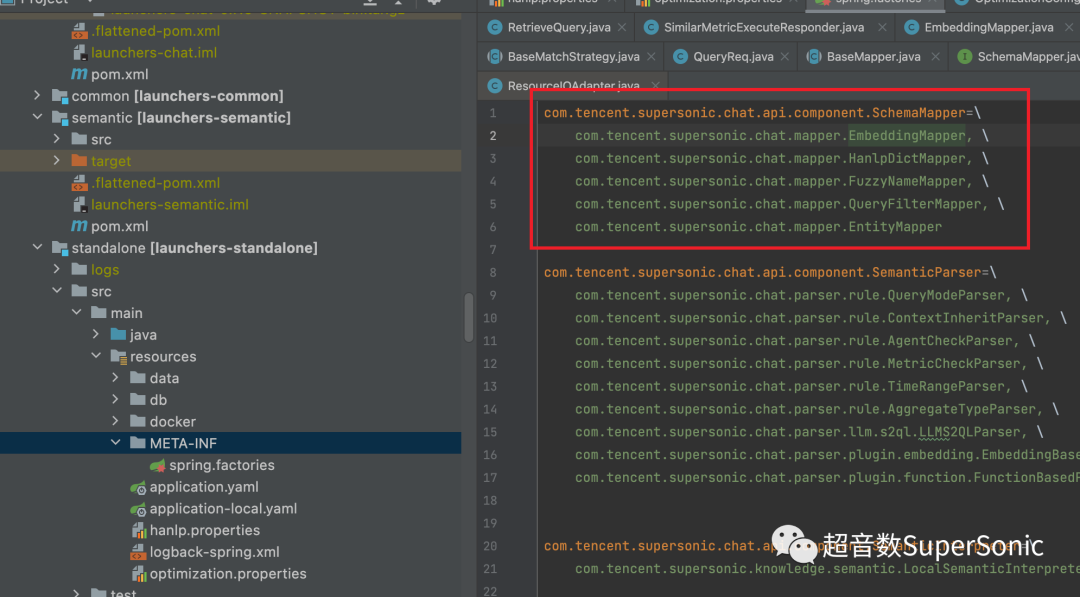

SuperSonic中的Mapper主要分为三类:基于Embedding的语义识别(EmbeddingMapper)、前后缀识别(HanlpDictMapper)、模糊识别(FuzzyNameMapper);Mapper支持灵活支持扩展;可在META-INF / spring.factories中动态修改; 每个mapper将自身识别到的SchemaElement按model进行分类,统一添加至QueryContext中的mapInfo中;各个mapper识别后的SchemaElement都是相互进行补充,并在添加时进行对数据去重处理;

2.1、词典数据 目前SuperSonic中的词典数据主要存储:1、借助hanlp中的BinTrie组件存储在Trie树;2、探测加速时使用的精确匹配的双数组Trie树; 2.1.1、词典格式 词典主要由word、nature、frequency,三类组成,其中nature构造如下;同一个word,如果frequency不同,可以选取frequency较大的作为识别的内容; Element类型 | 支持后缀查询 | 支持模糊查询 | nature | 示例(word nature frequency) | model | 否 | 否 | _{modelId} | 超音数 _1 10000 | metric | 是 | 是 | _{modelId}_{metircId}_metric | 访问次数 _1_2_metric 10000 | dimension | 是 | 是 | _{modelId}_{dimensionId}_dimension | 部门 _1_1_dimension 10000 | value | 否 | 否 | _{modelId}_{dimensionId} | marketing _1_1 310 | entity | 否 | 否 | _{modelId}_{dimensionId}_entity | _1_1 310 |

2.1.2、词典构造 com.tencent.supersonic.knowledge.listener.ApplicationStartedListener

com.tencent.supersonic.knowledge.dictionary.builder.ModelWordBuildercom.tencent.supersonic.knowledge.dictionary.builder.MetricWordBuildercom.tencent.supersonic.knowledge.dictionary.builder.DimensionWordBuildercom.tencent.supersonic.knowledge.dictionary.builder.ValueWordBuildercom.tencent.supersonic.knowledge.dictionary.builder.EntityWordBuilder

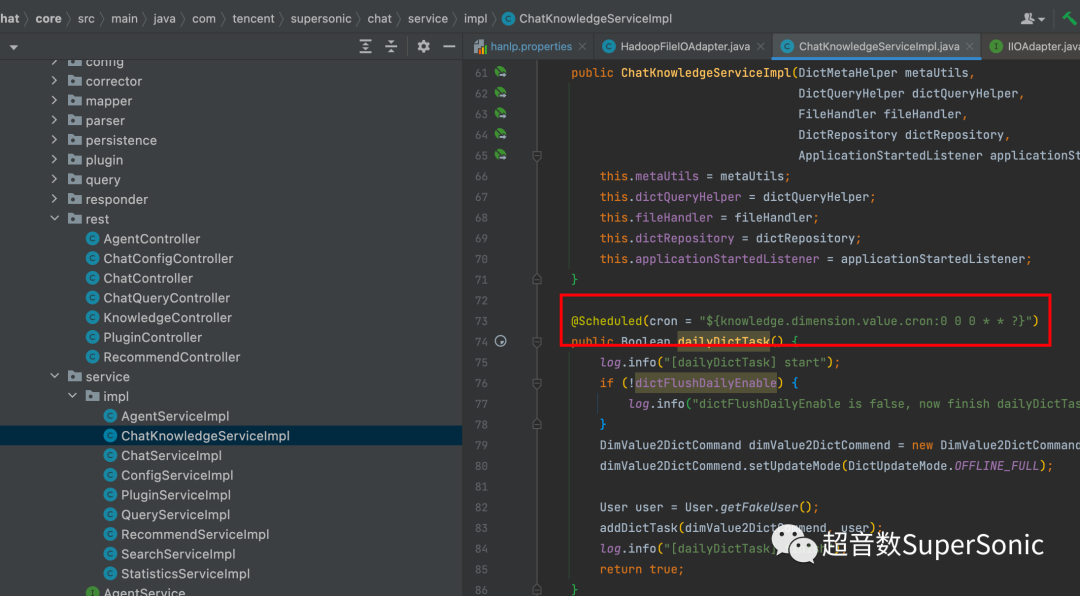

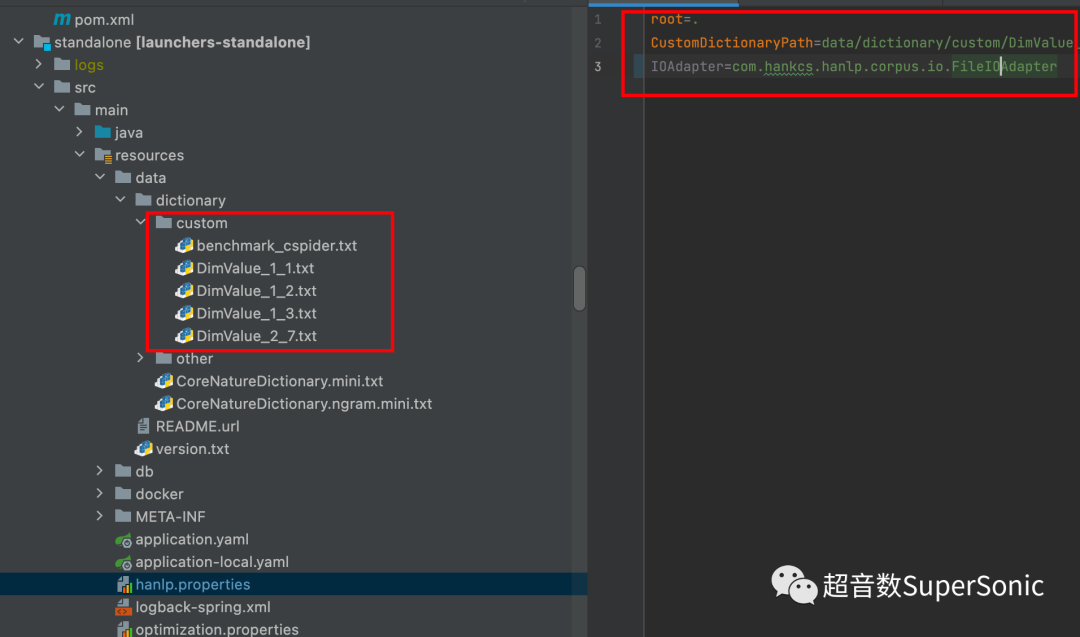

2、监听model、metric、dimension、value、entity元数据变更事件,从而实时重新更新词典; com.tencent.supersonic.knowledge.listener.DictUpdateListener 一般生产环境下,维度值数据量大且不像维度名、指标名等可以实时获取变更;因此,对于维度值的构造,采用离线方式; 主要实现方式:定期或主动触发离线构造任务,该任务则通过查询语义层,获取该维度的维度值,并按词典格式写入到文件中;文件存储方式可支持本地文件、hdfs等文件;生产环境可配置成hdfs;hanlp.properties中修改配置; IOAdapter=com.tencent.supersonic.knowledge.dictionary.HadoopFileIOAdapter

注意: 2 .2、EmbeddingMapper 该Mapper主要功能是通过Embedding方式,支持语义层面映射,获取到输入文本中更多的语义相似的词匹配;说明:HanlpDictMapper、FuzzyNameMapper这些只能做到单纯文本层面的映射,无法支持语义层面的映射。

实现原理: 系统定期/实时,将metirc、dimension、model等元数据信息导入向量数据库; 通过探测方式,两层循环获取探测所有文本; 按照指定批次大小,批量查询向量数据库,获取文本的最相似数据; 按model过滤、相似度过滤查询数据,数据按model分类构造,将SchemaElement并写入到MapInfo中;

探测方式:对输入文本进行探测,两层for循环,支持单步、批量查询;并采用hanlp的识别到的词进行探测加速;主要是借助hanlp的精确识别能力,调用segment.seg方法,可以一次性将文本中所有在词典的词查询出来;识别到这些词后,两层for循环在识别到的词基础上,进行探测加速,减少不必要的探测开销;

com.tencent.supersonic.chat.mapper.BaseMatchStrategy中

public List<T> detect(QueryContext queryContext, List<Term> terms, Set<Long> detectModelIds) {Map<Integer, Integer> regOffsetToLength = getRegOffsetToLength(terms);String text = queryContext.getRequest().getQueryText();Set<T> results = new HashSet<>();

Set<String> detectSegments = new HashSet<>();

for (Integer startIndex = 0; startIndex <= text.length() - 1; ) {

for (Integer index = startIndex; index <= text.length(); ) {int offset = mapperHelper.getStepOffset(terms, startIndex);index = mapperHelper.getStepIndex(regOffsetToLength, index);if (index <= text.length()) {String detectSegment = text.substring(startIndex, index);detectSegments.add(detectSegment);detectByStep(queryContext, results, detectModelIds, startIndex, index, offset);}}startIndex = mapperHelper.getStepIndex(regOffsetToLength, startIndex);}detectByBatch(queryContext, results, detectModelIds, detectSegments);return new ArrayList<>(results);}

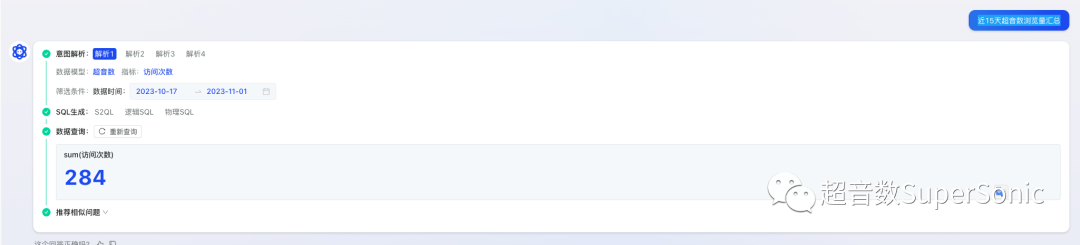

效果如下图所示: 1、输入"近15天超音数浏览量汇总",其中"浏览量"和"访问次数"在文本上相似度很低,但是在语义上相似,也可以识别到;

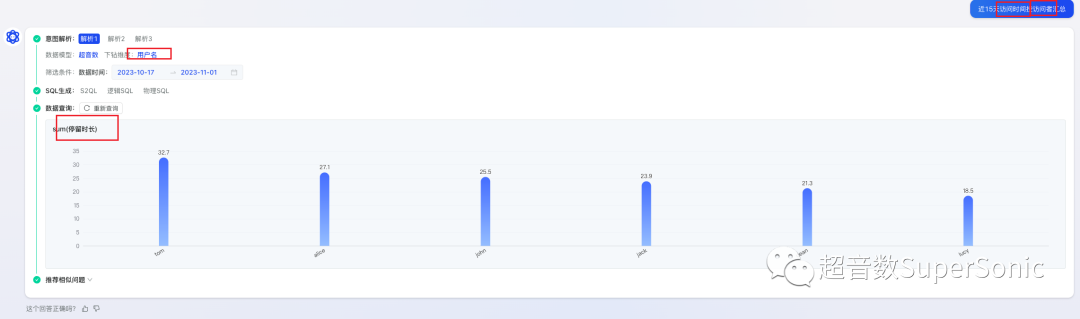

2、输入"近15天访问时间按访问者汇总",其中"访问者"可以识别到"用户名";"访问时间"可以识别到"停留时长";

说明:Github master最新代码已包含Embedding mapper功能,release版本预计在0.8.0中发布;

2.3 、HanlpDictMapper 该Mapper主要功能是通过借用Hanlp词典能力,从纯文本角度按前后缀方式识别文本中的相似词;

实现原理: 探测方式和EmbeddingMapper一致,通过两层for循环获取探测文本,然后调用Trie树,进行前后缀搜索; 探测文本与搜索后的文本进行编辑距离计算相似度,按配置的相似度阈值过滤; 然后同EmbeddingMapper一样,按model分类构造SchemaElement写入到MapInfo中;

2.4、FuzzyNameMapper 背景:由于HanlpDictMapper只支持前后缀的搜索,不支持模糊搜索;以指标"访问次数"为例说明: 文本中输入"访问",HanlpDictMapper可识别:访问次数、访问人数;--前缀搜索 文本中输入"人数",HanlpDictMapper可识别:访问人数;--后缀搜索 文本中输入"问次",HanlpDictMapper无法识别;--模糊搜索

该Mapper主要功能借助db中的模糊搜索能力,通过模糊搜索识别更多的词,以解决HanlpDictMapper不支持模糊的缺点;由于db中只存储了指标名、维度名信息,因此暂时只支持维度名、指标名的模糊搜索;

实现原理: 探测方式和EmbeddingMapper一致,通过两层for循环获取探测文本,从db中模糊搜索维度名、指标名; 探测文本与模糊搜索后的文本进行编辑距离计算相似度,按配置的相似度阈值过滤; 然后同EmbeddingMapper一样,按model分类构造SchemaElement写入到MapInfo中;

|