|

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">AI是如何“记住”你说过的话的?揭开模型上下文协议的神秘面纱。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;color: rgb(63, 63, 63);"> ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">在与AI交互时,你是否好奇它为什么会记住你的需求,甚至在对话中主动提供个性化建议?这种“记忆力”的背后,依赖于一种叫做模型上下文协议的技术。本篇文章将用浅显的语言解读这项协议的核心逻辑,探讨它如何提升用户体验,同时也分析它的局限性与未来发展方向。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;padding-left: 12px;color: rgb(63, 63, 63);">从咖啡店点单开始:AI如何理解你 ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">在与AI交互时,你是否好奇它为什么会记住你的需求,甚至在对话中主动提供个性化建议?这种“记忆力”的背后,依赖于一种叫做模型上下文协议的技术。本篇文章将用浅显的语言解读这项协议的核心逻辑,探讨它如何提升用户体验,同时也分析它的局限性与未来发展方向。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;padding-left: 12px;color: rgb(63, 63, 63);">从咖啡店点单开始:AI如何理解你想象你在一家智能咖啡店点单。你告诉服务员:“我要一杯拿铁,少糖,多奶。”几分钟后,你改变主意:“算了,换成浓缩咖啡吧。”服务员顺利完成更改,并提醒你:“加奶还是少糖?”你会惊讶于她记得之前的细节。这种体验与AI模型上下文协议的工作原理如出一辙。

ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;color: rgb(63, 63, 63);"> ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">模型上下文协议的作用就在于在特定范围内“记住”用户提供的信息,并根据上下文生成合适的回复或执行操作。这不仅提升了交互效率,还让AI看起来更加“智能”。但它究竟是如何实现的?ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;padding-left: 12px;color: rgb(63, 63, 63);">AI如何“记住”你的上下文:技术原理与挑战ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;color: rgb(183, 110, 121);">1. 上下文的本质是什么?ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">上下文是一段对话中的历史信息,例如用户的需求、问题或偏好。模型通过输入这些信息来形成对当前任务的理解,但这并不是“记住”信息的全部过程。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">上下文的载体主要包括: ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">模型上下文协议的作用就在于在特定范围内“记住”用户提供的信息,并根据上下文生成合适的回复或执行操作。这不仅提升了交互效率,还让AI看起来更加“智能”。但它究竟是如何实现的?ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;padding-left: 12px;color: rgb(63, 63, 63);">AI如何“记住”你的上下文:技术原理与挑战ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;color: rgb(183, 110, 121);">1. 上下文的本质是什么?ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">上下文是一段对话中的历史信息,例如用户的需求、问题或偏好。模型通过输入这些信息来形成对当前任务的理解,但这并不是“记住”信息的全部过程。ingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">上下文的载体主要包括:这种记忆是临时的,模型本身并不会保存用户的个人信息,除非通过明确设计实现持久化存储。 2. 技术实现:模型上下文协议的核心要点•窗口机制:上下文有“窗口”大小限制。只最近的对话数据会被纳入参考,旧的内容会被舍弃。 •令牌权重:某些关键信息(如用户意图)在对话中被赋予更高的优先级,从而更容易影响后续交互。 •优化目标:协议的设计在于提升模型对短期目标的专注力,而非保存大规模的长期记忆。

以下是一个实现模型上下文协议的一个基础的架构图  看看代码 classContextManager{

constructor(windowSize){

this.windowSize=windowSize;//上下文窗口大小

this.contextHistory=[];//用于存储上下文

}

//添加新上下文

addContext(userInput){

this.contextHistory.push(userInput);

if(this.contextHistory.length>this.windowSize){

this.contextHistory.shift();//超出窗口大小则移除最早的上下文

}

}

//获取当前上下文

getContext(){

returnthis.contextHistory.join("");

}

//清除上下文

clearContext(){

this.contextHistory=[];

}

}

classAIModel{

constructor(){

//模拟一个简单的模型

}

generateResponse(context,userInput){

//模拟生成基于上下文的响应

return`Basedon"${context}",myresponseto"${userInput}"is:OK!`;

}

}

//主流程逻辑

constcontextManager=newContextManager(3);//定义窗口大小为3

constmodel=newAIModel();

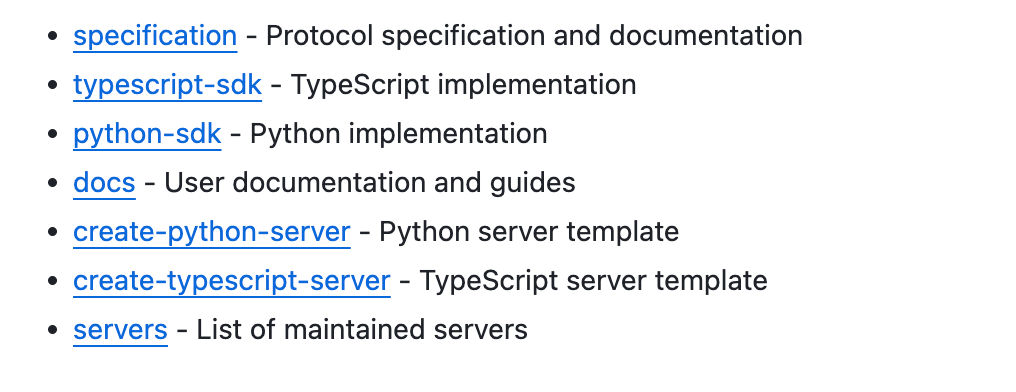

聪明的你是不是想得到可以在加一点 LRU 呢?当然,这些都不用你想了,因为 GitHub 有开源的更好的了。 https://github.com/modelcontextprotocol 各种 sdk 都有。  3. 挑战与局限尽管模型上下文协议有效提升了交互体验,但它也有一些显著的限制:

让上下文协议更实用:设计与优化建议1. 场景化技术设计在特定场景中(如客服、学习助手),可以有针对性地优化上下文协议。例如: •课程学习:强化用户目标的短期记忆。 •产品推荐:适当延长交互记忆的窗口时间。

2. 优化上下文管理方式3. 借助技术补足窗口局限结合外部存储系统(如知识库)或引入多轮推理机制,帮助AI在上下文丢失的情况下依然提供可靠答案。

|