|

发布会中,主要说了 o1支持了Function Call Realtime API的 SDK 模型新增支持:偏好微调

但是 仔细翻阅文档,会发现

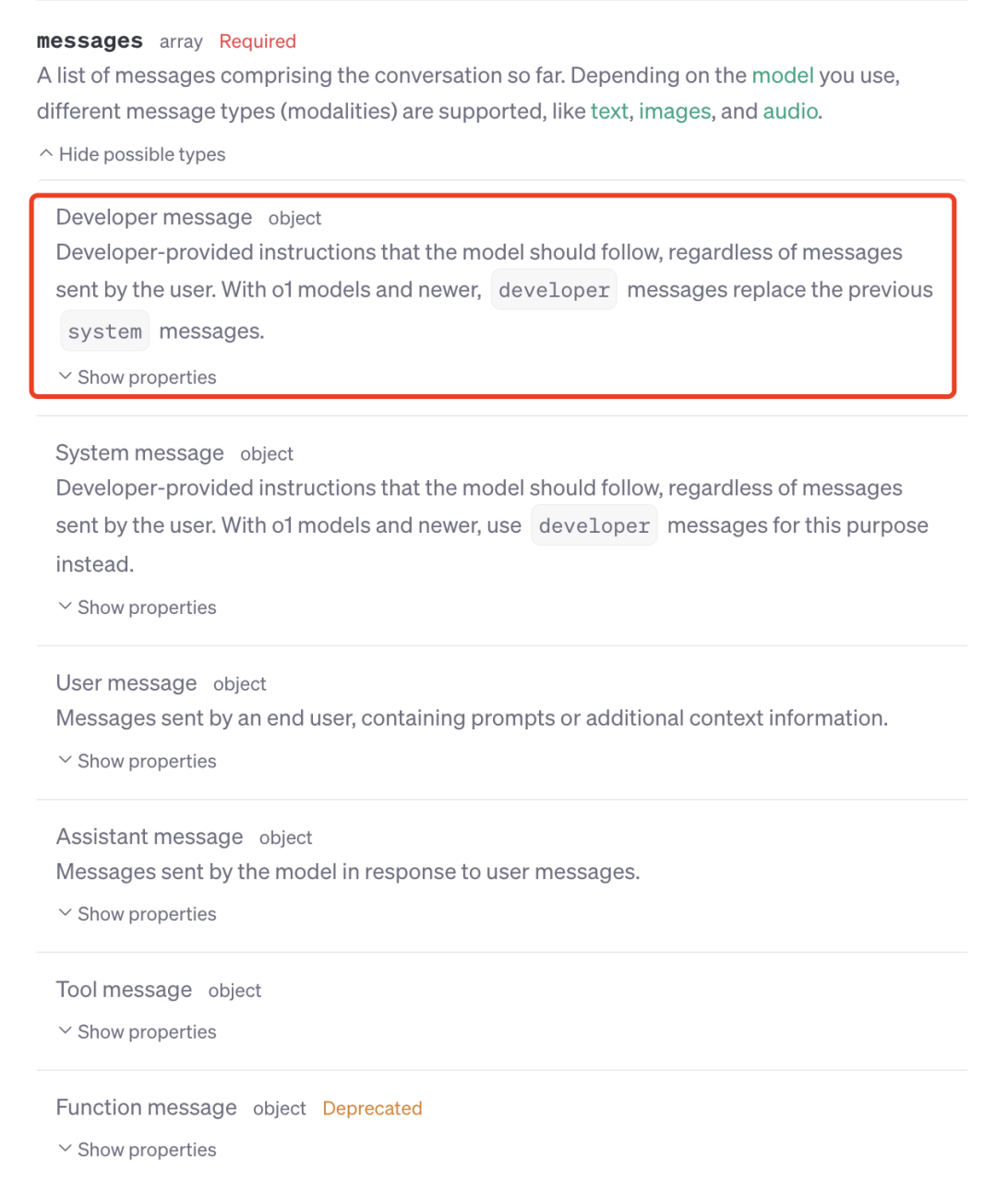

本次更新不止这些 很多都没说,比如 o1 的 reasoning_effort 参数 o1 的developer 角色信息

等等

容我细细道来

o1 有了正式版

模型名称就是 "o1"

取代之前的 "o1-preview" 对应模型代号 "o1-2024-12-17" 上文 200k,下文 100k

最核心更新 新增:结构化输出

这也就意味着

之后可以 function call 联网了 当然,还可以做更多有趣的事情

参考这个

看完这篇,你也能做 AI 搜索:论「结构化输出」

在 o1 中 新增developer 角色 等同于 4o 的 system 角色

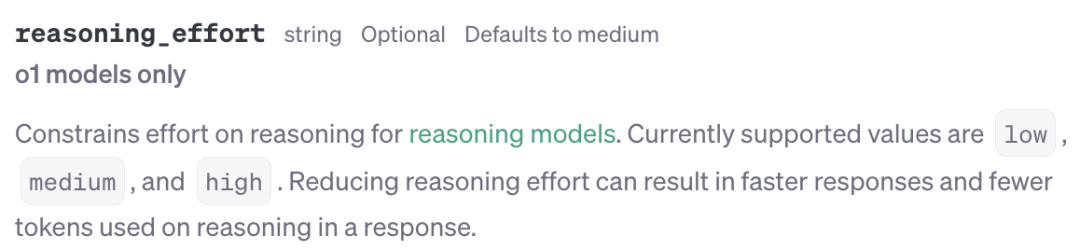

新增reasoning_effort字段

可以调整推理强度 有low, medium 和 high 可选

另需注意 最新的 o1 模型 支持图片、文字输入,并支持结构化输出 而 o1-mini只支持纯文本的输入输出

这个东西之前介绍过

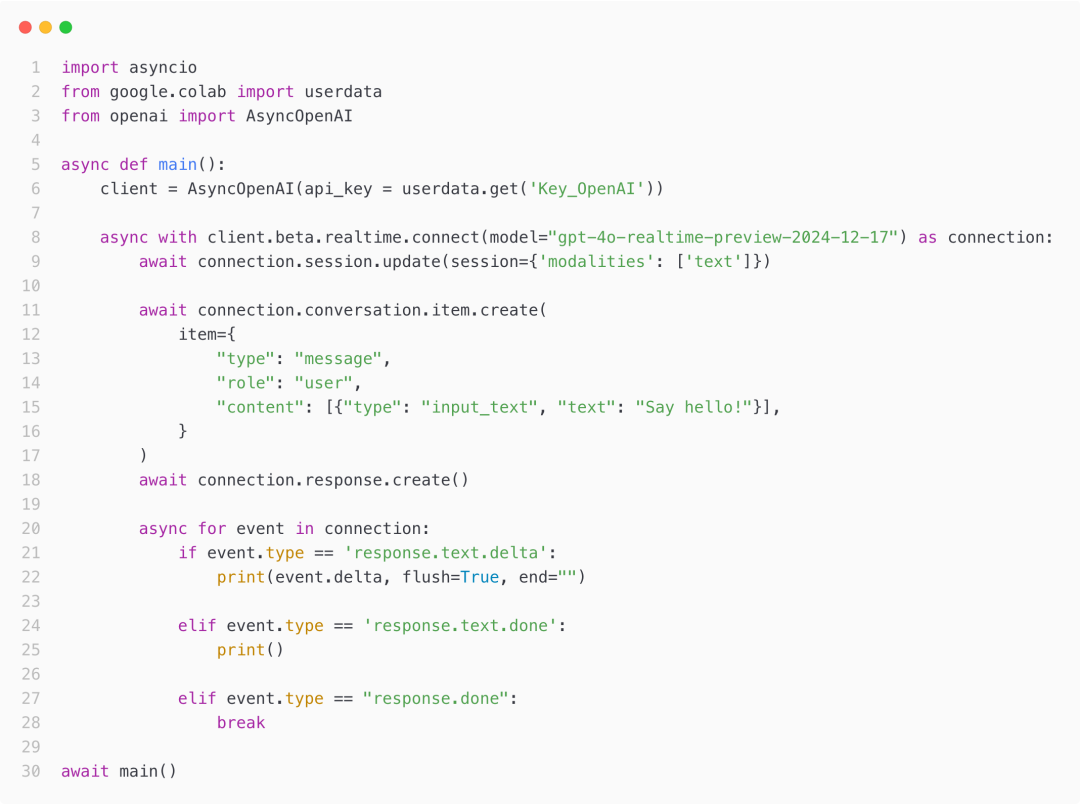

OpenAI 凌晨发布:Realtime 实时多模态 API,及其他

先是模型升级 gpt-4o-realtime-preview-2024-12-17

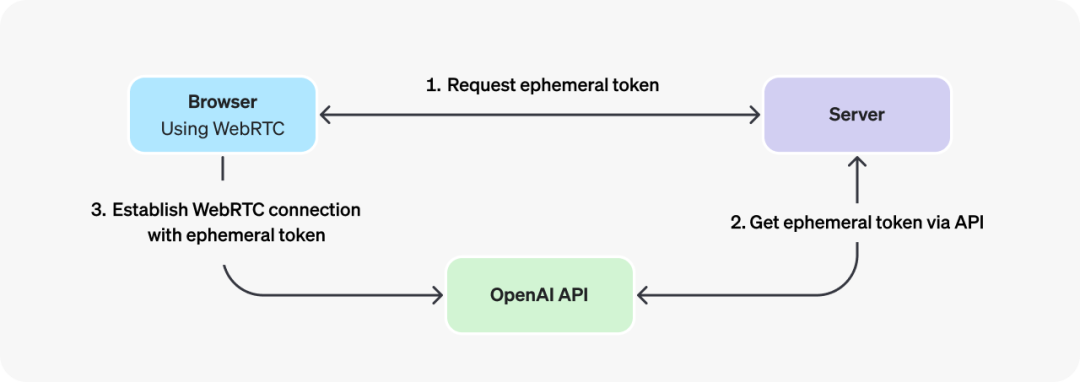

支持了 WebRTC

文档在这 https://platform.openai.com/docs/guides/realtime-webrtc

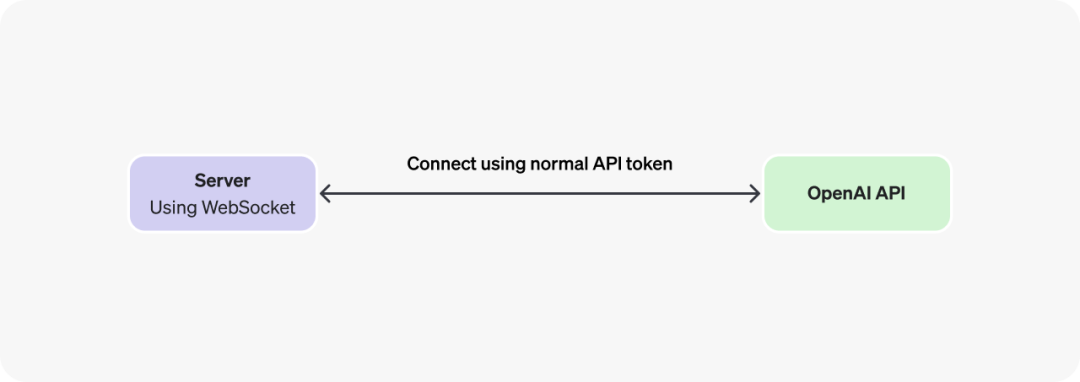

也可继续使用 WebSocket

文档在这

https://platform.openai.com/docs/guides/realtime-websocket

同时 Realtime API 现已支持 SDK 调用 文档在 Github 的 ReadMe 里

https://github.com/openai/openai-python

但注意 这个文档疑似有问题

老模型 2024-10-01 会频繁出错

原因未知,故请使用新模型 可参考我写的示例

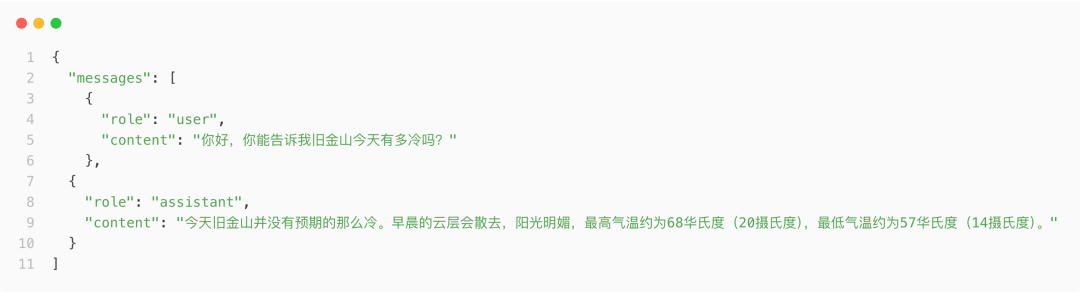

之前微调(Fine-tuning)的时候 是告诉模型:你应该怎么输出

就像这样

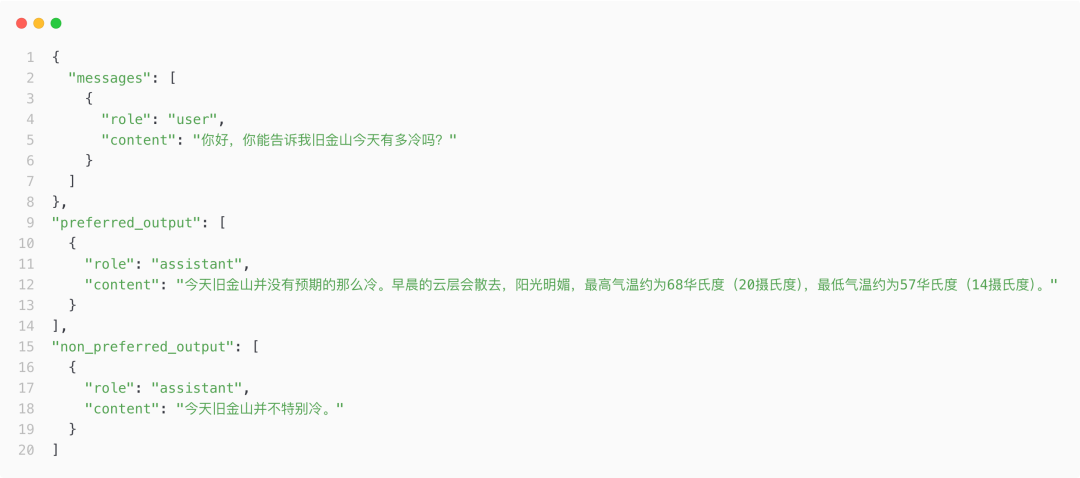

这次来了个新的 新增:偏好微调 (Preference Fine-tuning) 要告诉模型 你要什么,同时不要什么

就像这样

可以看到

语料需要 3 个内容 提问,希望的输出,不希望的输出

具体的文档,看这里

https://platform.openai.com/docs/guides/fine-tuning#preference

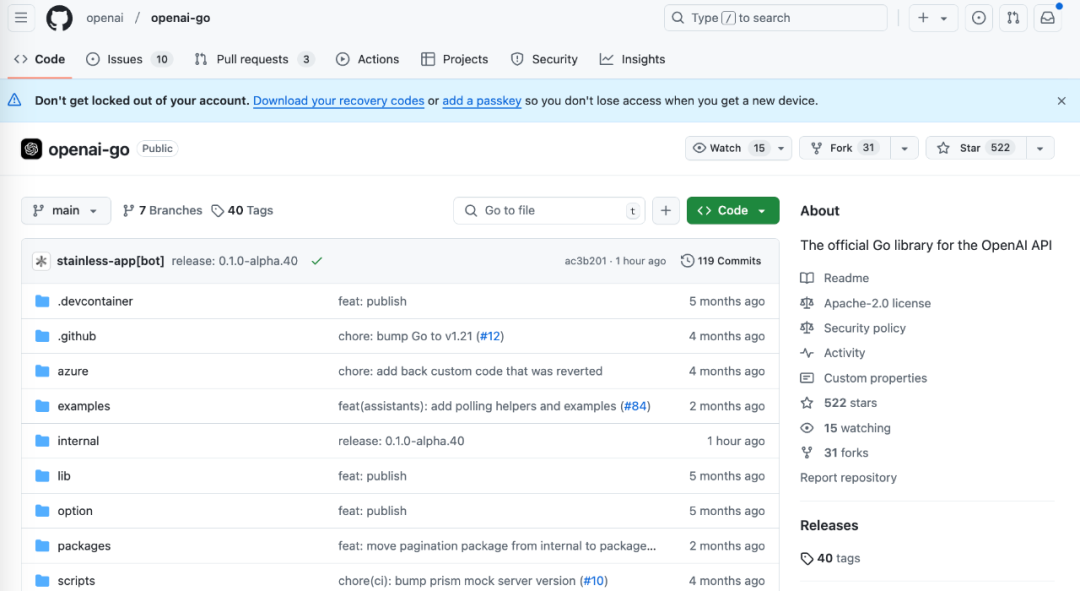

这次的更新 新增:Go 和 Java 的 SDK 终于不需要用第三方库了

Go:GitHub

https://github.com/openai/openai-go

Java:Maven Central https://central.sonatype.com/artifact/com.openai/openai-java

评价非常有用 这些更新,都是会用到的 (之前都特麻烦) Claude 在 OpenAI 发布时 尝试偷袭

给开发者发了封邮件

|