|

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;display: table;padding: 0px 0.2em;color: rgb(255, 255, 255);background: rgb(250, 81, 81);">qwen3ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;padding-left: 8px;color: rgb(63, 63, 63);">概览

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;color: rgb(63, 63, 63);" class="list-paddingleft-1">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;text-indent: -1em;display: block;margin: 0.2em 8px;color: rgb(63, 63, 63);">1. 分为密集模型架构 (0.6B/1.7B/4B/8B/14B/32B) 和混合专家架构 (30B-A3B/235B-A22B)ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;text-indent: -1em;display: block;margin: 0.2em 8px;color: rgb(63, 63, 63);">2. 混合思维模式:支持开启/关闭推理能力即架构密集模型 MoE 模型 | | | # Experts (Total / Activated) | | | | | | | | | | | |

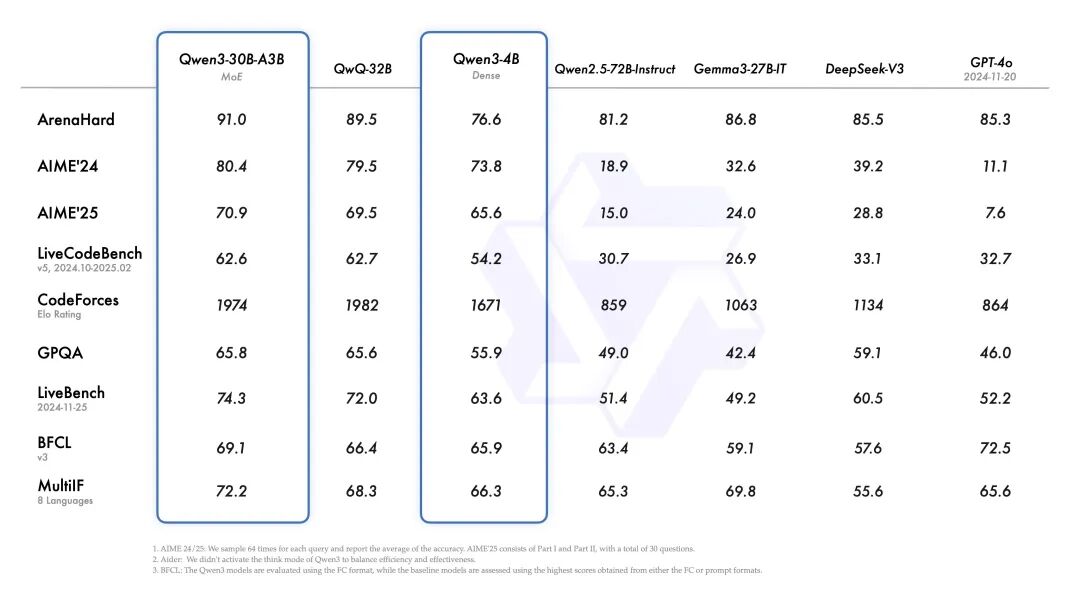

基准测试从官方公布的基准测试看, 旗舰模型Qwen3-235B-A22B在代码、数学、通用能力等基准测试中,与 DeepSeek-R1、o1、o3-mini、Grok-3 和 Gemini-2.5-Pro 等顶级模型相比,表现出极具竞争力的结果。此外,小型 MoE 模型Qwen3-30B-A3B的激活参数数量是 QwQ-32B 的 10%,表现更胜一筹,甚至像 Qwen3-4B 这样的小模型也能匹敌 Qwen2.5-72B-Instruct 的性能。

训练Qwen3 使用约 36 万亿 Token,在预训练阶段分为 3 步: - 1. 模型在超过 30 万亿个 token 上进行了预训练,上下文长度为 4K token。这一阶段为模型提供了基本的语言技能和通用知识

- 2. 增加知识密集型数据(如 STEM、编程和推理任务)的比例来改进数据集,随后模型又在额外的 5 万亿个 token 上进行了预训练

- 3. 使用高质量的长上下文数据将上下文长度扩展到 32K token

在后训练分为 4 步 - 1. 长思维链冷启动:使用多样的的长思维链数据对模型进行了微调,涵盖了数学、代码、逻辑推理和 STEM 问题等多种任务和领域。这一过程旨在为模型配备基本的推理能力

- 2. 长思维链强化学习:重点在

大规模强化学习,利用基于规则的奖励来增强模型的探索和钻研能力 - 4. 通用强化学习:在 20 多个通用领域的任务上应用了强化学习,以进一步增强模型的通用能力并纠正不良行为

使用 qwen3升级 Ollamaqwen3 模型需要 ollama v0.6.6 或更高版本,先把 Linux 上的 ollama 升级到 v0.6.6: wget https://github.com/ollama/ollama/releases/download/v0.6.6/ollama-linux-amd64.tgz

sudo systemctl stop ollama

sudo rm -rf /usr/lib/ollama

sudo tar -C /usr -xzf ollama-linux-amd64.tgz

sudo systemctl start ollama

升级完后,下载qwen3:8b模型,大小在 5.2G $ollama pull qwen3:8b

pulling manifest

pulling a3de86cd1c13: 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 5.2 GB

pulling eb4402837c78: 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 1.5 KB

pulling d18a5cc71b84: 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 11 KB

pulling cff3f395ef37: 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 120 B

pulling 05a61d37b084: 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 487 B

verifying sha256 digest

writing manifest

success

配置好模型后,在 LobeChat 中使用qwen3:8b看下实际效果: 在内容分类方面,DeepSeek-R1:14B 和 qwen3:8b 旗鼓相当。   在内容分类方面,DeepSeek-R1:14B 吊打 qwen3:8b。   总的来说各有千秋,要根据实际效果选择模型。 |