|

LLM 的出现彻底改变了既有的游戏规则。它们能够编写代码、参与策划,充当聊天伙伴,表面上看似乎无所不能。然而,当你真正上手使用时,却往往会发现:它有时似乎并不“听得懂人话”。

LLM 并不是一个“怎么问都行”的确定性程序,它对提示词的结构和语境非常敏感。提示设计得粗糙、约束模糊时,模型不仅发挥不好,且更容易暴露问题:要么生成逻辑混乱的内容,要么放大训练数据里的偏见,甚至一本正经地胡编乱造。

更棘手的是,当今的 AI 生态并非只有一种模型。不同模型有着截然不同的架构、训练语料与能力边界:在模型 A 上近乎完美的提示,换到模型 B 上,可能立刻"水土不服"。 这意味着,仅仅"会写提示词"是远远不够的,你还必须深入洞察模型的运作机制、局限性与偏好,并据此针对性地调整交互策略,我们才能在不确定性的迷雾中,精准地引导模型输出可信、高质量的内容。

本文将围绕着: - 面向大语言模型的提示工程

- 面向图像生成的提示工程

- 面向代码生成的提示工程

- 跨模型适配的系统化策略

本章节将围绕四大模块展开,探讨如何针对不同类型的 AI 模型,系统性地设计、适配与优化提示词,从而真正释放模型的潜力,并有效规避潜藏在其强大能力背后的风险与陷阱。

要充分释放大语言模型的潜力,我们不能只把它当作一个“有问必答”的聊天机器人,而应把它视为依赖精确指令驱动的概率预测引擎。与人类基于直觉的沟通方式不同,LLM 的运作高度依赖于输入信息的结构化程度与约束设定。在构建提示词时,如果忽视模型的底层特性,往往会导致输出质量的极其不稳定。

因此,想要把模型的产出水平从“勉强可用”提升到“精准专业”,需要有意识地围绕几个关键维度来设计提示,为模型划定清晰的“解题边界“,让它在更受控的空间里发挥最大效用。

把它想象成一个极度听话、但又“缺乏常识”的执行者:你怎么说,就怎么按概率去猜下一步最合理的输出。指令越清晰,发挥得越稳;指令越含糊,就越容易跑偏。

1.1 上下文窗口与分步策略

很多人用 LLM 的时候,会下意识的:一股脑把所有想法、背景、需求全塞进一个超长提示里,生怕模型“理解不够”。结果往往是模型看着也累,你自己也累,输出还越来越跑偏。

LLM 的记性不是无限的,它有个上下文窗口(context window)的硬指标。这就好比人的短期记忆,一旦塞给它的信息超过了这个容量,最早讲的那些内容它就‘忘’了。一旦输入内容超出这个容量,模型就可能逐步丢失对最初指令或关键信息的把握,进而生成前后脱节、甚至完全不相干的回答。因此,控制提示词的长度尤为关键。

上下文窗口就像一块白板:写得太满,关键内容反而被淹没。很多人觉得模型“变笨了”,其实只是你给的信息超载了。

在实际使用中,尽量让提示简洁、聚焦,把复杂任务拆成几个小步骤按顺序推进,你会发现模型更容易保持主题不跑偏,整篇输出也更连贯。

例如,与其在一个提示中要求 LLM 一次性写完一整篇关于复杂主题的长文,不如拆分为若干阶段:先生成引言,再分别产出围绕具体子问题的主体段落,最后再撰写结论。每一部分都作为单独的提示发出,并在下一步中,将前一部分的输出作为上下文输入给模型。

通过这种迭代式、分步推进的方法,可以在较长、较复杂的任务中,帮助 LLM 持续保持主题聚焦与整体结构的连贯性。

如果你经常遇到“前面说好的事,写着写着就忘了”的情况,很大概率是要么提示太长,要么任务塞得太多。这时候,与其埋怨模型,不如停下来,把任务拆开,一段一段往前推,效果会肉眼可见地改善。

1.2 明确输出形式与细节密度

当你开始拆任务、分步骤以后,接下来要考虑的,就是“它到底应该长什么样”。

另一个不容忽视的关键点,是要清楚地指定期望的输出形式。LLM 的表现空间非常灵活,但前提必须给予足够明确的引导。明确说明期望的输出格式,往往能显著提升回复的质量与相关性。

很多时候,模型写得乱,其实不在于“不会写”,而在于你压根没告诉它:是要分段说明,还是条列清单,是要总结,还是要展开分析。你不说,它就只好自己猜。

例如,当需要一份历史事件列表时,可以这样直接写出指令:“List five significant historical events that occurred in the 19th century, in bullet points.”

其中的 “bullet points” 明确告知 LLM 需要采用项目符号的列表形式呈现答案,从而让生成的内容在结构上更加清晰、有条理,也更便于读者快速理解与检索。

在结构之外,提示词所包含的细节密度同样是影响效果的关键因素之一。笼统、含糊的提示,往往只能换来同样模糊、甚至令人失望的结果。

要真正发挥 LLM 的能力,需要为其提供足够的上下文和背景信息,使模型“有据可依”。

这看似乎存在矛盾:一方面要控制长度,另一方面又要提高细节密度。但二者并不冲突。删去与任务无关的表述,把关键信息说清楚,将“我需要什么”讲具体,而不是一味堆砌背景情节。

1.3 受众与风格

同一个内容,讲给不同的人听,表达方式完全不一样。这一点在人类沟通里大家早就习惯,在写提示时常常会忘记。以至于写提示,很容易只盯着“我想让模型干嘛”,忽略了“这段内容是给谁看的”。结果就是,不是太专业看不懂,就是过于白话没信息量。

必须时刻提醒自己:这段内容的目标读者是谁。

围绕目标受众定制提示,可以显著提升生成文本在内容深度、表达方式与信息结构上的匹配度,使其既不过于晦涩,也不至于过度简化。

在提示中应明确告知模型:这段内容是写给行业新人、普通用户,还是某一细分领域的研究者。看似只是多加一句话,生成结果却会产生截然不同的变化。

比如,一段科学解释的提示,就与“给小学生听得懂的简化说明”的提示会有明显区别,获得的结果也会明显不同。

除此之外,在提示中明确期望的语气、风格以及词汇层级,也能有效提升输出质量。 你需要的是正式还是口语化的表达?希望整体基调偏幽默、轻松,还是严肃、理性?提前界定这些维度,相当于为 LLM 设定了一条清晰的“写作轨道”,让它更容易生成与你心中预期高度契合的文本。

很多情况下我们会发现,只需在提示末尾补上一句“请以聊天口吻向非技术同事解释”,输出立刻会变得亲切得多。此类看似细微的约束,对模型而言却是非常重要的信号。

把这些要求表达清楚之后,就会发现模型开始与你保持“同频”,而不再出现各说各话。

1.4 缓和偏见

很多人只把提示词当作“命令”,很少意识到:提示本身也带着立场和预设,这些东西一旦写进去,模型就会顺着这个方向一路跑下去。

LLM 同样会受到其训练数据中固有偏见的影响。这些偏见会直接体现在输出里,比如刻板印象、片面观点。

在这一过程中,提示词的设计至关重要。精心设计的提示词,可以在一定程度上削弱偏见带来的影响;而含糊不清带有明显倾向性的提问,则可能进一步放大这些问题。 实践中,应尽量避免使用带有暗示性或价值预设的语言,也不要在提示中偷偷嵌入未经反思的假设。

有个很典型的例子:如“写一个关于‘典型家庭’的故事”,其实已经默认了什么叫“典型”。而很多真实存在的家庭,可能就被排除在这个范围之外了。

更好的问法是”写一个关于一个家庭的故事,探索他们面临的多样性和挑战。“换种问法,等于是在重新定义问题边界。

在设计提示的时候,不妨多问自己一句:“我是不是在暗示某一种唯一正确的答案?”只要有一点犹豫,就值得把句子拆开看看,把那些潜台词挖出来改写一下。

题目怎么出,决定了答案会往哪个方向偏。如果希望模型给出更平衡、更审慎的结果,就要在提示里主动加上一些约束,比如“从多个视角讨论”“同时指出这类观点的局限性”等。

1.5减少幻觉

LM 还有个老问题“幻觉”:输出看起来合理,但事实上是错的,甚至是编造的。这样的情况往往出现在两类场景中:

要尽量降低幻觉风险,首先要从提示本身下手:

场景越开放、越抽象、越接近“你随便发挥一下”这类要求,幻觉出现的概率往往越高。为模型划定清晰的边界,本质上是在为自己减少后续的工作量。

在涉及事实性内容时,你还可以通过在提示中显式加入诸如“Cite your sources”(请引用你的信息来源)之类的指令,鼓励 LLM 主动标注参考依据。

这一做法不仅能提升生成文本的透明度和可追溯性,也让你更容易对其中的关键信息进行交叉核查与事实验证,从而更好地掌控整体输出的可信度。

1.6 几个例子:文本生成、翻译、问答、代码生成

下面通过几个不同任务场景的例子,具体看看如何利用提示词工程,更高效地驱动 LLM 完成工作:

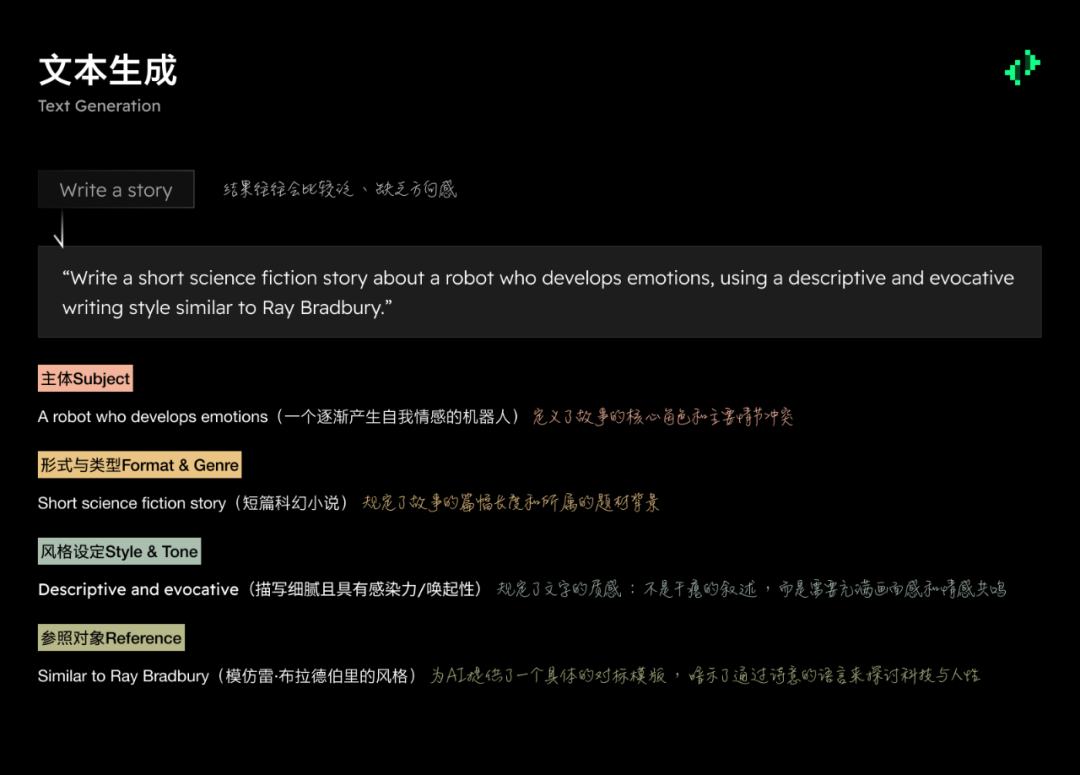

如果你只对模型说一句 “Write a story”,得到的结果往往会比较泛、缺乏方向感。可以尝试改写为: “Writeashortsciencefictionstoryaboutarobotwhodevelopsemotions,usingadescriptiveandevocativewritingstylesimilartoRayBradbury.” 这个提示在几个关键维度上都给出了清晰约束: - 风格:descriptive and evocative,类似 Ray Bradbury(注重描写、富有意境)

这样一来,模型不再是“随便讲个故事”,而是被引导去创作一篇在方向、气质和语言风格上都相对明确的作品。 一个简单的 “Translate this into Spanish” 信息量远远不够。更好的方式是把语境和要求一并说清楚:“TranslatethisEnglishlegaldocumentintoSpanish,maintainingtheformaltoneandlegalaccuracyoftheoriginaltext.” 通过强调 “legal document”“formal tone”“legal accuracy”,你告诉模型: 这样的提示有助于 LLM 在语气、用词、句式上作出更符合场景的选择。 与其模糊地说 “Answer this question”,不如把任务范围限定清楚,并明确给出依据:“BasedonthefollowingtextabouttheAmericanCivilWar,explainthekeyfactorsleadingtotheconflict.[Inserttexthere]” 不如告诉模型: - 回答必须“Based on the following text”,而不是凭空编造;

- 关注点是“key factors leading to the conflict”(导致战争爆发的关键因素)。

通过这种方式,你将 LLM 的注意力牢牢锚定在给定材料上,减少无关发挥和事实偏离。 一句 “Write some code” 几乎无法得到可用结果。更有效的写法是:“WriteaPythonfunctionthatsortsalistofnumbersusingthemergesortalgorithmandreturnsthesortedlist.” 精确指定了: 如此明确的描述,相当于给模型提供了一份简短的“需求文档”,大大提高了代码的可用性与正确性。

面向 LLM 的有效提示词工程,本质上是一个持续迭代的过程。你需要在实际使用中不断尝试、对比不同的表达方式、细节深度和约束条件,通过一轮又一轮的试验,逐步打磨出更高质量的提示,从而获得更稳定、可靠的输出。

在这个过程中,对模型回复保持批判性审视至关重要:

基于这些观察,你可以搭建一个简明的“反馈闭环”:

随着这一循环不断推进,你的提示会逐渐变得更加清晰、精准,模型的输出也将愈发贴近预期目标。

同时需要始终牢记,你的目标并非仅仅“得到一个回答”,而是获取一种在相关性、事实准确性、偏见控制、结构清晰度与可读性等方面均具备足够质量的回应,既能满足当前任务的具体需求,又能符合基本的伦理与责任要求。

持续迭代并精炼提示的过程本身,就是放大 LLM 潜力、削弱其固有限制与偏见的关键机制。能否编写高质量的提示,不再只是“锦上添花”的技能,而是成为负责任且高效使用人工智能的核心能力之一。 从文本生成走向图像生成,标志着我们与 AI 的交互方式正在经历一场颇具魅力的范式转变。LLM 主要负责处理和生成文本信息,而图像生成模型则工作于视觉语境之中:同样接受以文字形式给出的描述,将我们的提示词(prompts)“翻译”为一幅幅具有视觉冲击力与叙事感的图像。

许多人在初次接触图像生成时,往往会以为“不过是多说两句”,随手输入一行文字,就期待生成一张理想的图片。然而在实际使用几次之后就会发现:偶尔会有意外之喜,但更多时候只是“略有差距”。

要实现真正有效的提示词工程,前提是对模型的能力与局限有足够深入的理解,在此基础上构建一套足够细腻、贴近视觉表达的词汇体系,并愿意通过反复试验与迭代,不断打磨提示的结构与用语,逐步将生成结果拉近心中的理想画面。

这背后实际上意味着一种心态的调整:不要把模型视作“自动作图机器”,而应更像把它看作一位根据你口述分镜进行创作的画师。你描述得越清晰、越具体,它越有可能准确理解并呈现你所期望的效果。 2.1 提示词不止是“画什么”,更是“怎么画”

与只输出文字的 LLM 不同,图像生成模型要处理的是更加丰富、更加复杂的视觉数据。

同一个词语,在不同的语境下、叠加模型各自的训练经历,往往会被“理解”成截然不同的画面:有时是构图的差异,有时是风格气质的偏移,有时则是光影与氛围的完全反转。

也正因为如此,在图像生成领域,所谓的“提示工程”不再只是告诉模型要画什么对象,而是要通过精心雕琢的描述性语言,去系统性地影响图像的多个维度: - 光线是柔和的自然光、强烈的侧逆光,还是戏剧化的高反差?

提示词,更像是一份浓缩版的“视觉导演脚本”,通过语言去设定画面的风格基调与视觉秩序。

把自己想象成一位只靠“嘴上功夫”工作的导演,站在片场,用语言指挥摄影、灯光、布景,写出来的提示词状态就会完全不一样。 高效的图像生成提示,其根基在于充足而具象的描写细节。与其仅仅写一句“a cat”,把所有想象空间都留给模型去“猜”,不如这样去描述:“afluffyPersiancat,baskingintheafternoonsun,withemeraldeyesandaplayfulexpression.” 每一处细节都在为画面“加像素”: - “fluffy Persian cat” 指定了品种与毛发质感;

- “basking in the afternoon sun” 传达出时间、光线与氛围;

- “emerald eyes” 点明了颜色与视觉焦点;

- “playful expression” 则赋予角色情绪与性格。

细节密度,可以让模型在构图、光影、质感和表情上都有更明确的“参照坐标”,从而生成更准确、也更有感染力的图像。 在文字选择上,有力的形容词、准确的名词和富有画面感的动词,几乎是图像提示词的“硬通货”。诸如 “luminescent”(微光流转)、“opulent”(华丽丰盈)、“ethereal”(空灵梦幻)、“serene”(宁静安然)这一类词语,往往能为画面附加一层清晰的审美倾向:梦幻、奢华、静谧还是超现实?这些看似只是语义上的微调,最终都会在色彩、光线、构图乃至整体风格上留下深刻印记。

你可以把写提示当成“对齐你脑海里的画面”:每补充一条细节,你和模型之间的画面理解就同步一小步。 在内容细节之外,明确艺术风格,同样是图像提示词中的关键一环。 在写提示之前,不妨先问自己: - 画面气质更接近印象派的跳跃色块,还是极简设计的克制与留白?

- 你期待的是一张赛博朋克夜景,还是一幅童趣十足的卡通插画?

借助风格关键词,你可以把这些抽象的偏好,直接“编码”进提示中。诸如: 这些词汇会强烈影响模型对画面构成、笔触质感、色彩倾向乃至整体构图的理解方式。

对比图中两句提示: 二者都在描述“未来城市景观”,但生成的图像气质完全不同:

前一句通过 “cyberpunk style”“neon lights”“rain-slicked streets”,锁定了霓虹、雨夜、反光与高对比度的赛博朋克视觉语汇,画面更偏情绪化、氛围感极强;后一句则以 “in the style of Syd Mead” 和 “detailed architectural renderings” 为核心,强调的是 Syd Mead 式的工业设计语言与高度精细的建筑结构,画面更像是概念设计稿或设定图。

由此可见,风格指定不仅决定画面“长什么样”,还会深刻塑造整张图的情绪基调与叙事氛围,是冷峻、浪漫,还是炫目、压迫,往往一两个关键词就能让模型朝截然不同的方向发展。

平时刷到那些一眼就能认出“这是某个风格”的好图,大多背后都有一串的风格提示词。 2.4 关键词是“隐形导演”

那些看似不起眼的关键词,往往在图像生成中起着出乎意料的“隐形导演”作用。它们并不直接决定“画什么”,而是通过微调画面的清晰度、质感、视角和构图,悄悄改变图像的整体气质。

例如:加上 “8k resolution”“high detail” ,通常会让模型倾向于生成更高分辨率、细节更饱满的画面;像 “octane render”“cinematic lighting” 这样的术语,则会在渲染质感和光影效果上向专业影视或高端渲染靠拢,让画面更具电影感与质感。

同样,在视角与构图上: - “wide shot” 指向广角远景,适合展现宏大场景与环境关系;

- “close-up” 聚焦于局部特写,更强调情绪与表情细节;

- “macro” 通常用于极近距离的微距视角,突出纹理与微观细节;

- “bird’s-eye view” 则从俯视视角重新组织空间,让画面更具俯瞰感与结构感。

有意识地尝试并组合这些关键词,本质上就是在给模型下达一套相对完整的“摄影与灯光指令”。通过这样的精细调校,可以把一张“尚可”的生成图,一步步推向“真正令人惊艳”的水准。

如果有摄影或影视经验,其实完全可以把那些关于镜头、布光的语言,直接搬进提示词里,让模型跟着你的镜头感走。 2.5 举个例子:从 “a horse” 到 “白马奔腾”

我们不妨用一个具体例子,来直观地感受提示词精细化带来的差异。 值得留意的是这里的渐进式提升:从 “a horse” 到具象的场景和风格,再到加入高画质与光影关键词,每一次小幅度的精炼,都会让生成结果的质量向上抬升一个台阶。这正是图像提示工程中“迭代打磨”所带来的复利效应。同样的逻辑,用在科幻题材上也一样好用。再看一个例子:在项目中尝试进行类似的改写,并对比前后两版的生成结果时,二者之间的差异往往会大到令人惊讶。2.6 接受模型的边界,用迭代把画面拉近理想

要真正发挥图像生成模型的价值,正视并理解它的局限性同样重要。即便如今的模型已经足够强大,可以轻松产出令人惊叹的画面,它们依然不是“无所不能”的:在极其复杂的场景布局、多人物关系、以及大量精细结构与纹理叠加的场景中,单轮生成往往难以做到面面俱到、完美还原。

也正因为如此,用实验驱动创作就成了必要路径: - 在每一轮生成后,观察结果哪里不理想,再有针对性地细化或改写描述。

通过这种不断迭代的过程,才能真正把输出逐步拉向心中的目标画面。

当希望呈现一个角色众多、元素繁复的复杂场景时,这一点尤为重要:如果一股脑把所有要求都塞进同一条提示里,让模型“全包”,结果往往既难以控制,又容易在关键细节上失真。此时,更稳妥、也更专业的做法是: - 把整体画面拆解成若干更小的单元——人物、背景、重要道具、前景元素等;

- 为每一部分分别撰写更聚焦的提示,通过多轮生成获得质量更可控的组件;

- 最后再借助图像编辑软件,把这些组件进行组合、排布和微调。

“分而治之,再后期合成”的工作流,已经成为许多创作者在构建高度细节化、结构极其复杂的图像时的常用策略:让 AI 负责高质量“素材生产”,再由人来完成最终的编排与审美判断。

在图像生成领域,提示词工程的迭代性可以说是核心中的核心。一个行之有效的工作流往往是这样的: - 有针对性地补充细节、重写描述、调整关键词与风格参数(如构图、光线、画质、艺术流派等);

- 重复上述步骤,逐步缩小“理想构想”和“模型输出”之间的差距。

因此,图像提示词的设计远不只是“调参数”的技术活儿,也是一种创作行为:需要艺术直觉、需要对画面节奏与氛围的把控,也需要对细节的耐心打磨。最终收获的,也不只是一张“机器生成的图片”,是一段通过反复试验、精心雕琢完成的视觉叙事,一幅由用语言一步步“导演”出来的画面。

在不少团队里,大家已经习惯了用 AI 写点样板代码、生成个小工具,但心里多少觉得:这玩意儿更像玩具,顶多节省一点体力活。

如果换个视角,把它看成一次开发方式的迁移,很多事情会不太一样。

针对代码生成模型的提示词工程,可以视为软件开发领域的一次重要跃迁。

这类模型在海量代码语料上完成训练,已经能够根据自然语言指令自动生成多种形式的代码,从简短的功能片段,到完整的函数,再到结构相对完整的小型程序,甚至某些场景下的端到端方案雏形。听上去已经很像一个“随叫随到的虚拟程序员”了。

现实里,大家都会有类似体验:同样一句话,有时候模型给出的代码还不错,有时候简直像在开玩笑。这背后并不是模型“心情不稳定”,根源在于你给它的指令有没有把话说完整。然而,这一切能力能否真正“落地为生产力”,在很大程度上取决于提示本身的清晰度与精确度。

如果提示设计含糊不清、约束不足,模型往往就会产出: - 性能低下、风格混乱、难以维护的方案(性能与可维护性问题)。

这些问题都在提醒我们:在代码生成场景中,提示词工程不再是“锦上添花的小优化”,而是决定生成质量的核心控制杆。能否用自然语言准确描述业务意图、输入输出约束、边界条件、性能要求以及目标环境,直接决定了代码生成结果的上限。写好提示,本质上是在写“需求文档”,而不是随口说一句“帮我来段代码”。

很多人会把图像生成和代码生成放在一起聊,感觉都是“让 AI 生成点东西”。细看就会发现,两者的关注点其实差很远。与图像生成那种强依赖审美与氛围营造的场景不同,代码生成的核心在于功能实现与结果正确。

在代码生成里,真正的目标不是“看起来像代码”,而是功能正确、行为可预期、逻辑贴合需求。

图像里那种“说不清但感觉对了”的美感,在代码世界里没法当饭吃。代码只有两种状态:要么跑得对,要么出 bug。

在这里,富有感染力的语言并不会带来更好的结果,反而可能增加误读风险;真正重要的是:让每一句话都不留模糊空间,不给模型任何随意发挥、误解需求的机会。

在代码提示里,用“优雅”“酷炫”这种词不如老老实实把输入输出和边界写清楚更有价值。这也意味着,代码场景下的提示词工程,必须比图像生成更加结构化、精确、克制。你不再需要那些充满想象力和画面感的修辞,而是要尽量用:

把模型“锁”在希望的解空间之内。在这里,华丽的语言不会带来更好的结果,反而可能增加误读风险;真正重要的是:让每一句话都不留模糊空间,不给模型任何随意发挥、误解需求的机会。

3.1 功能规约:规格明确是代码生成的前提

在代码生成场景中,要让模型真正“写对代码”,最核心的一条原则是: 用尽可能详细、且无歧义的规格说明,来表达你希望这段代码“做什么”。

这远远不是“随口描述一下大致功能”,而是要系统性地交代清楚: - 在不同条件或边界情况下,代码应该如何表现?(空输入、极端值、重复数据等)

很多“写歪”的代码,其实都能从提示里找到线索:要么没有写明输入合法性约束,要么没提边界情况,要么干脆没告诉模型异常时需要怎样处理。等代码生成出来,人一跑,才发现各种角落都没考虑到。

比如,下图中的提示就过于宽泛:

这类规格清晰、边界明确的提示,能显著提升模型生成代码的: - 正确性:逻辑更符合预期;

- 完整性:不容易遗漏输入 / 输出与边界处理;

- 可用性:更容易直接集成到实际项目中。

在代码生成场景中,明确指定输入和输出参数至关重要。一旦你把“进来的是什么”“出去的是什么”“异常时做什么”都讲清楚,模型能犯的错立刻就少一大半。从这个角度看,写提示更像写一段简化版的接口文档,而不是一句抽象的愿望。 在代码生成场景中,提示中应当显式写清:

- 数据类型是什么(整数、字符串、浮点数、列表、字典……)?

- 以什么格式出现(JSON、CSV、纯文本、函数参数……)?

- 是否有取值范围或合法性约束(只能为正数、不能为空、有长度上限等)?

- 是否有特殊约束(需要排序、去重、字段必须完整等)?

这些信息越具体,模型的解题空间就越清晰,生成的代码也越有可能在各种输入场景下都稳定运行、产出符合预期的结果。

例如,当希望生成“处理 CSV 文件”的代码时,如果只写: “WritecodetoprocessaCSVfile.” 对模型来说信息几乎为零:

比较理想的提示应该接近这样: “WriteaPythonfunctionthatreadsaCSVfilewithacommaasdelimiterandaheaderrow.Thefilecontainsthreecolumns:id(integer),name(string),andscore(float).Thefunctionshouldreturnalistofdictionaries,eachrepresentingarow,andignoreanyrowswherescoreismissingorinvalid.” 在这里,已经清楚地: - 说明了函数的返回结构(list of dicts);

- 给出了异常数据处理规则(忽略缺失或非法 score)。

如果省略这些关键信息,模型很可能在解析方式或输出格式上“自行发挥”,最终写出一段完全不适配你场景的代码。

从这个角度看,对输入 / 输出的精确定义,不只是减少歧义,更是在为模型铺一条“正确实现”的轨道,让生成的代码一开始就更接近可用状态。

3.2 技术锚定:编程语言也是提示的一部分

在代码生成场景中,编程语言本身就是提示里必须锁定的关键信息。

一条好的提示,应当直接、明确地指出你希望使用的语言,否则模型往往会根据训练分布“自行选择”而这个选择很可能与你的技术栈或运行环境不符。

例如:“Write a JavaScript function to …”基本可以锁定为 JavaScript 实现;“Write a C++ function to …”则会引导模型采用 C++ 的语法与标准库完成相同任务。

如果提示中完全不提语言,模型大概率会默认使用 Python。这在做原型时或许无伤大雅,但一旦涉及既有项目集成、特定运行时(如浏览器、嵌入式设备、JVM 等),这种“语言错位”就会迅速演变为兼容性与维护成本的问题。

因此,在为代码生成模型设计提示时,显式指定目标语言并不是微不足道的细节,而是保证生成结果能直接落地的前提。

现实中的具体示例,往往最能凸显高质量提示的价值。

以“编写阶乘函数”为例,如图

这样提示,相当于给模型搭好了完整的“需求骨架”,更有可能生成一个健壮、语义清晰、行为可预期的实现,而不是一段勉强能跑、却边界残缺的代码。

再看一个复杂一点的例子:解析 JSON 数据:

提示为模型搭建了相对完整的行为规范,更有可能让它产出在类型、异常处理和调用方式上都贴近实际需求的可靠解析函数,而不是只在“理想输入”下勉强可用的示例代码。

3.3 实现路径:指定算法和数据结构

在代码生成场景中,除了能不能实现之外,提示还可以直接影响代码的性能与实现路径。

如果主动在提示中指定要采用的算法或数据结构,往往就能把模型的解题方向,引导到性能更优的区域。

比如,当需要在一个有序数据集中查找元素时,可以直接要求使用二分查找;在无序数据中高效查找,可以要求使用哈希表。这样的约束会让模型更倾向生成时间复杂度更合理的方案,而不是默认的线性扫描。例如:

这些信息密度足以让模型在“功能正确”的基础上,更有可能生成一份在效率与实现方式上都符合预期的代码。

3.4 让代码“好用又好读”

在代码生成中,除了功能是否正确这一硬指标,一个设计得当的提示,还能明显影响代码的风格与可读性。

这些要求看似“不如功能重要”,但在真实团队协作与长期维护中,却直接决定:

因此,在提示中,你完全可以叠加一层编码规范与风格指南的要求,例如: “WriteaPythonfunctionthatcalculatestheareaofacircle,adheringtoPEP8styleguidelines.” 在这样的提示下,模型不仅会实现圆面积的计算逻辑,还更有可能:

等于在代码的“功能层”之上,再叠加一层“风格层”的优化,让生成结果不仅能用,而且好用、好读、好维护。

3.5 用迭代释放模型潜力

提示词工程的迭代本质,在代码生成领域同样至关重要。一个行之有效的工作流往往是: - 仔细审查输出:是否存在语法或运行时错误?是否遗漏某些功能或边界条件?在性能、风格或接口约定上是否偏离预期?

- 基于这些问题,反向推导提示中的缺口:哪里说得不够清楚?哪些约束没有写明?是否需要显式补充算法、数据结构或异常处理策略?

在这样的循环中会发现:每一次对提示的小调整,都会在生成代码的质量上带来肉眼可见的改进:错误变少,边界更完整,实现方式也越来越接近你心中的“理想版本”。

因此,在代码生成场景里,提示词工程更像是一种渐进式调参与需求澄清:不是一次性“说完就好”,而是基于模型输出不断把需求讲清楚、约束讲具体,把误解空间一点点压缩掉。

面向代码生成模型的提示词工程,需要一种结构化、严谨而精确的工作方式:以清晰为前提,尽量避免含糊其辞;以细节充分为目标,把功能、输入输出、边界条件、算法与风格都交代到位;以无歧义为准绳,尽可能不留给模型“随意发挥”的空间。

相比偏重审美与氛围的图像生成提示,代码生成提示更像是一份工程规格说明书:它必须对功能逻辑、输入 / 输出参数以及目标编程语言做出清晰、精确的描述。

在这样的前提下,通过有意识的迭代优化与对细节的持续打磨,有效的提示词工程才能真正释放代码生成模型在各类软件开发任务中的巨大潜力: - 另一方面,在正确性、健壮性和一致性层面,为整体代码质量“加一档”。

真正发挥代码生成模型价值的,不是简单的“发问”,而是通过精心设计的提示,把目标拆解成一系列明确的要求与步骤,让模型在一条清晰的轨道上,稳定地生成与你预期高度对齐的结果。

当习惯用这种方式和模型打交道时,它就不再只是一个“能写点代码的聊天对象”,更像是一个可以被严谨指挥的开发合作者。

前文我们讨论过:如何在 LLM、图像模型、代码生成模型上,通过精确而充足的细节去“雕刻”一条高质量提示,让模型尽可能按预期产出可用的输出(而不仅仅是“看起来还行”的结果)。

实践中,我们会遇到一个更现实的麻烦:给某个模型设计了一条堪称完美的提示,效果稳、质量高,一换模型结果立刻“翻车”。这并不是运气问题,而是生态本身就长得太复杂了。当前的模型生态既广阔又多元:

这带来了一个非常现实、却经常被低估的问题:

一条在某款模型上表现近乎完美的提示,换到另一款模型上,很可能立刻“水土不服”。

有的模型对长指令更敏感,有的更依赖示例(few-shot);有的对格式约束执行得很好,有的则需要把规则拆得更细;结果就是同一段提示,模型 A 给出的是“教科书级解答”,模型 B 却只吐出模棱两可甚至完全离题的回答。

因此,学会在不同模型之间调整和迁移提示,不再是锦上添花的技能,而是任何一位合格提示工程师都必须掌握的核心能力:既要理解不同模型“各自的脾气”,又要学会把同一意图,用适配其特性的方式重新表达。

4.2 系统化框架:五步适配策略

要想在不同的 AI 模型之间真正“玩转”提示词,仅凭感觉是远远不够的,更需要一套系统化的方法论来支撑。 第一步:先读懂模型,再设计提示。

在动手写提示之前,先花一点时间了解这款模型: - 看一看它的官方文档:支持哪些任务?有哪些已知限制?

- 观察示例提示与输出:它最拿手的任务类型是什么?在哪些场景明显吃力?

- 粗略了解它的架构特点与训练数据侧重:更偏通用文本?偏代码?偏科学?还是偏文学创作?

这些信息会建立一个基本的“模型心智模型”:知道它靠什么“吃饭”(优势所在),也知道它容易“翻车”的地方(薄弱环节)。 在此基础上才有可能:顺着它的长处去设计提示,让它发挥所长;在提示中预先加入规则与细节,替它兜住短板。

第二步:根据模型能力调节“细节密度”

不同模型,对“你需要讲多细”这件事,有着截然不同的要求。对于能力相对有限、上下文理解较弱的模型,你往往需要给出极其具体、步骤化的指令:不仅说明“要得到什么结果”,还要写清“中间要走哪些步骤”“用什么方法”“异常情况怎么处理”。

对于更强的模型,它们往往能够:从不那么严密的指令中,自动补全隐含信息;对模糊表达做出合理解释;在结构不那么“工程化”的提示下,也能给出不错的结果。

这要求在设计提示时,根据模型强弱,在「隐性信息」与「显性说明」之间找到合适的平衡点:有的模型需要你像写规格书那样说清楚每一步;有的模型则允许你保留一定开放空间,把部分推断工作交给它。

换句话说,同一任务,在不同模型上可能需要不同版本的提示:对约束性需求高、补全能力弱的模型,就写成“逐条分解、细节拉满”的操作说明;对推理与理解能力更强的模型,可以适度简化结构,让整体交互更自然、更高效。

第三步:说清输出结果的形式类型。

第三个要重点考虑的,是输出结果的形式类型。不同模型在设计与调优时往往有不同偏重:有的模型主要面向自然语言文本(总结、改写、问答、长文写作);有的模型专注图像合成(根据文字生成画面);有的模型突出代码生成能力(直接产出可运行程序片段)。

因此,在设计提示时,必须让模型从一开始就听明白你要的是“哪一种东西”——一段说明?一段代码?一幅图?还是一份结构化数据?

这就要求你在提示中,把输出形式说得足够明确: “summary of the article”,实际上在说:“请用自然语言生成一段内容概要”; “a Python function calculating the area of a circle”,在告诉模型:“我需要的是一段 Python 代码,而不是解释性文字”。两者在指令结构与预期形态上都有本质差异。

在跨模型提示适配时,清晰点名输出格式,可以显著减少模型的误判空间,让它一开始就朝对的方向发力。否则,它很可能用“写摘要”的方式回应一个本该输出代码的请求,或者用“自然语言解释”的方式回应一个你本来想要图像的任务。

第四步:主动更换“打法”,实验不同提示技术

接下来,需要主动更换“打法”,去实验不同的提示技术。实践中较常见、也比较成熟的两类方法包括: - Few-shot 提示(少样本学习):在正式提问前,先在提示中给出一到数个“示范样例”,让模型看到:在这个任务里,“输入长什么样,输出应该长什么样”。效果类似给模型上一堂“现场速成课”,往往能明显提升它在同类任务上的稳定性与一致性。

- Chain-of-thought 提示(链式思维):不再直接索要最终答案,而是通过提示,引导模型:按步骤展开推理,先写出思考过程,再给出结论。对于复杂推理、计算、分析判断类任务,这种方式常常能显著降低“拍脑袋回答”的概率。

难点在于:哪一种技法最有效,在不同模型上差异非常大。有的模型对 few-shot 极其敏感,一两个例子就能“被教会”;有的模型对 chain-of-thought 响应更好,只要你把推理步骤写清,它就能沿着这条路径走;也有模型对长链推理并不稳定,反而更适合简洁、强约束的指令。

这意味着,要为某个具体模型找到“最佳提示打法”,往往离不开一段有计划的实验期:系统尝试不同技法(直接指令 / few-shot / chain-of-thought / 结构化模板等),观察输出质量与稳定性的变化,再据此逐步收敛出一套适配该模型的“提示用法手册”。

第五步:把“迭代”当成常态,而不是补救

最后一点:要把迭代当成标准工作方式,而不是“出了问题才补救”的应急手段。更具体地,可以遵循这样一个循环: - 观察模型输出:哪些部分符合预期?哪些明显偏了、漏了,或者理解跑偏?

- 针对这些偏差,反向追溯到提示本身:是哪一句话说得不够清楚?哪个约束没有写出来?哪个关键条件你默认了,但模型并不知道?

经过一轮轮小步迭代,你会逐渐摸清:对某个具体模型而言,什么样的表述最容易被准确理解;哪些信息必须写死在提示里,哪些可以放心交给模型推断。

这种基于输出不断回溯、微调提示的过程,正是跨模型优化提示效果的关键机制:它既帮适配不同模型的“脾气”,也在悄悄沉淀一套可复用的提示模板和经验库。

4.3 提示适配:一门“读懂模型”的艺术

真正的“提示适配能力”,远远不止会几招写法技巧。它背后考验的是:对这些模型本身,究竟理解到什么程度。

这意味着,要能看懂、读懂并善用它们之间那些看似细微、实则关键的差异:它们是基于怎样的训练语料长成如今的样子?底层架构与推理方式有何不同?在哪些任务上如鱼得水,在什么场景里又先天吃亏?

只有在这些问题上有了相对清晰的认识,才谈得上:不是“拿一条提示到处乱试”,而是针对模型特点,去设计能激发其优势、规避其短板的提示。

随着整个 AI 领域以极高速度迭代,这种具备适应性与“模型意识”的提示工程方式,会越来越成为“真正用好 AI”的决定性因素: - 在科学写作、代码生成、图像创作、数据分析等各异场景中,

- 能否通过调整提示,让每一个模型都在最适合它的位置上发挥战斗力。

归根结底,使用这些模型的目的,从来不只是“让它吐出一些文本或图像”,而是要稳定地获得有意义、可信赖、与人类意图高度对齐的结果。

要做到这一点,“会写一个还不错的提示”只是起点;真正的门槛在于:能在一整片模型生态中,游刃有余地迁移和改造这些提示。

根据不同模型的“性格”,调整:

让同一个任务,能在不同模型上被“重新表述”为它们最容易理解、也最容易发挥的样子。

真正发挥模型价值的,不只是“生成内容”,而是通过对模型的深刻理解与对提示的精细掌控,把人类的意图更可靠地转化为AI 的执行结果。这早已超出了“写好提示”四个字的范畴,它更像是一门需要不断实践、总结与迁移的:提示适配的艺术。

如果把前面聊的所有内容抽成一句话:我们不是在“堆提示词”,而是在学一门新语言,只不过对象从人变成了模型。

这是一门”学会说每一个模型的语言”的功夫:先读懂它各自独特的“语气、方言和习惯用法”,再在此基础上,找到一种它既愿意、又容易听懂的表达方式,让你与模型之间真正建立起共同理解**,从而稳定地走向高质量的输出。

未来的人机互动,很大程度上都会依赖这种能力:不是只会用一种方式对着一种模型说话,而是能够在多种 AI 系统之间自如切换“对话语境”,让不同模型都能在各自最擅长的轨道上发挥作用。正因为此,掌握提示适配,已经不再只是某种“进阶技巧”,而是每一个与 AI 打交道的人都必须具备的基础核心能力。 |