|

记忆(Memory)已成为基础模型驱动的Agent的核心能力,它支撑着长周期推理、持续适应和与复杂环境的有效交互。然而,随着Agent记忆研究的快速扩展,该领域也变得日益碎片化——不同工作在动机、实现、假设和评估协议上差异巨大,而大量松散定义的记忆术语更是模糊了概念边界。传统的"长期/短期记忆"分类已经无法捕捉当代Agent记忆系统的多样性和动态性。

为何需要新的分类框架 论文指出现有分类体系存在两个核心问题:(1) 已有综述的分类框架在2025年的快速方法论进展之前制定,无法涵盖新兴方向,如从过去经验中提炼可复用工具的记忆框架,或记忆增强的测试时扩展方法;(2) 随着记忆相关研究的爆炸式增长,概念本身变得愈发松散——研究者发现声称研究"Agent记忆"的论文在实现、目标和底层假设上可能截然不同。

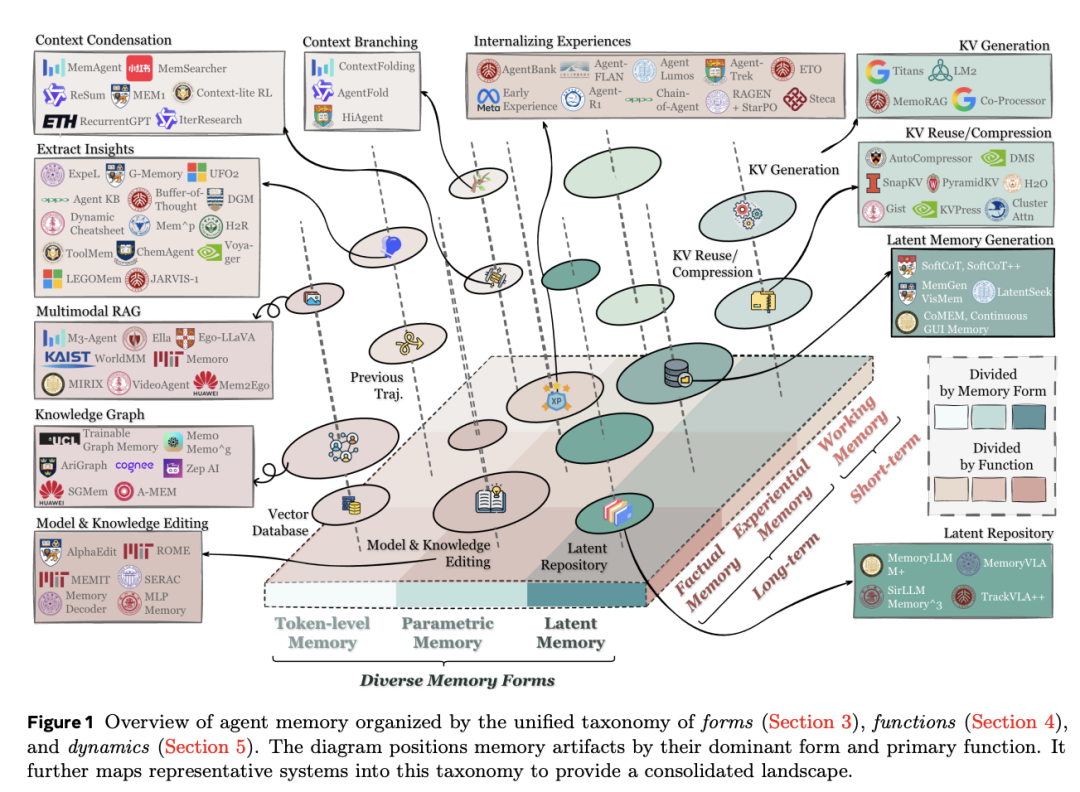

Forms-Functions-Dynamics三维框架 论文提出了一个统一的"形式-功能-动态"(Forms-Functions-Dynamics)三维分类框架来理解Agent记忆。

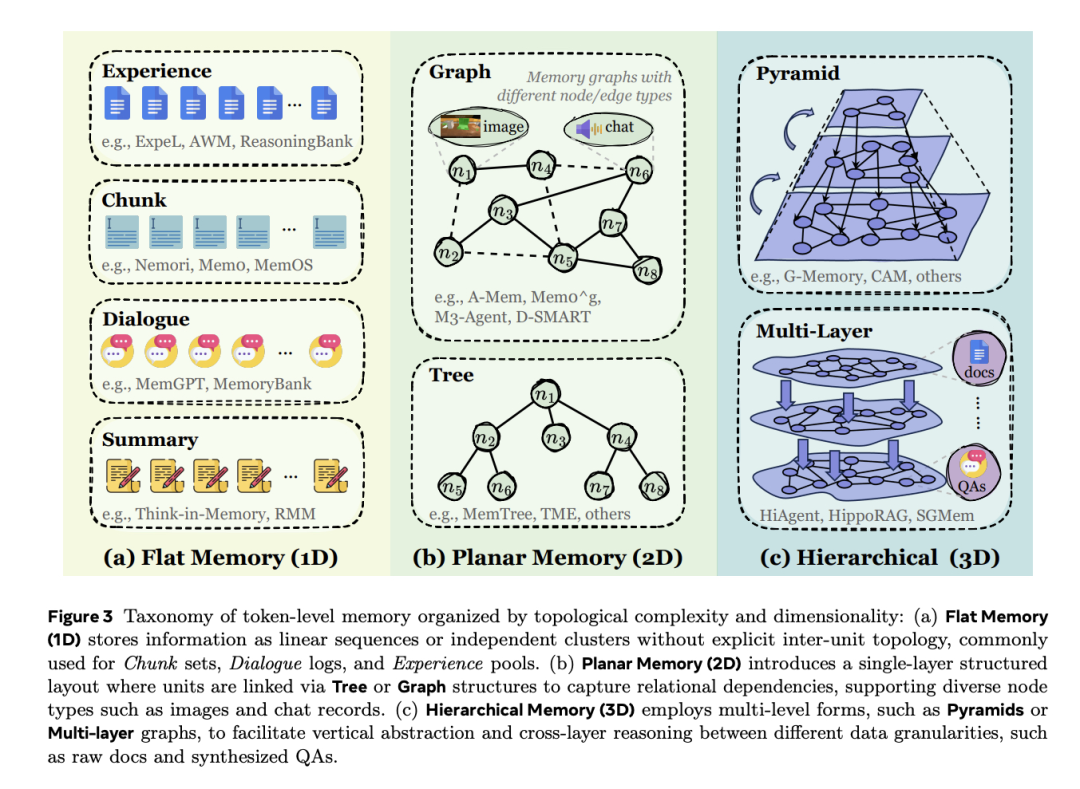

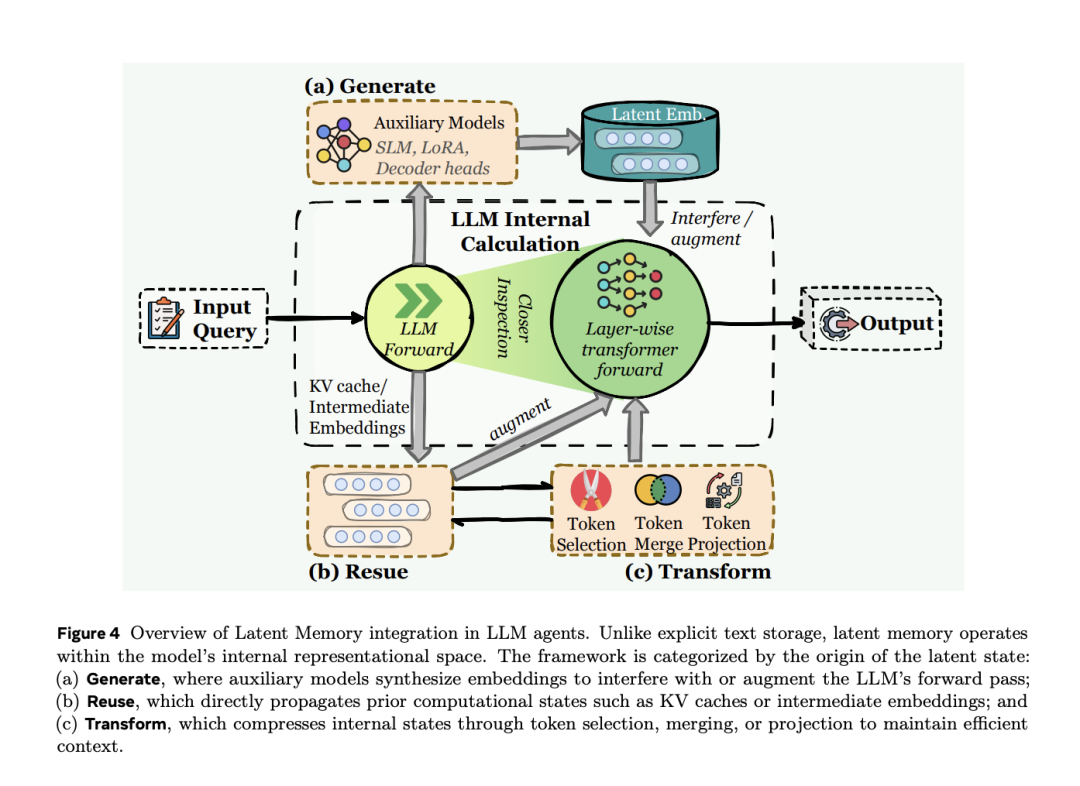

形式维度(Forms):记忆的存储方式:论文识别出三种主流的记忆实现形式:(1)Token级记忆(Token-level Memory):将记忆存储为可直接拼接到上下文中的token序列,是最直观的实现方式;(2)参数化记忆(Parametric Memory):将信息编码到模型参数中,通过微调或持续学习更新;(3)潜在记忆(Latent Memory):将记忆表示为连续向量空间中的嵌入,介于token级和参数化之间。 功能维度(Functions):记忆的用途:论文摒弃了粗粒度的时间分类,提出更细粒度的功能分类:(1)事实记忆(Factual Memory):记录Agent与用户和环境交互中获得的知识;(2)经验记忆(Experiential Memory):通过任务执行逐步增强Agent的问题解决能力;(3)工作记忆(Working Memory):管理单个任务实例执行期间的工作空间信息。 动态维度(Dynamics):记忆的生命周期:论文将记忆的操作抽象为三个生命周期算子:形成(Formation)——从交互产物(工具输出、推理轨迹、自我评估等)中选择性提取有未来效用的信息;演化(Evolution)——将形成的记忆候选整合到现有记忆库中,可能涉及合并冗余条目、解决冲突、丢弃低效用信息或重构以提高检索效率;检索(Retrieval)——构建任务感知查询并返回相关记忆内容供LLM策略使用。 关键澄清:Agent记忆与RAG、上下文工程的区别

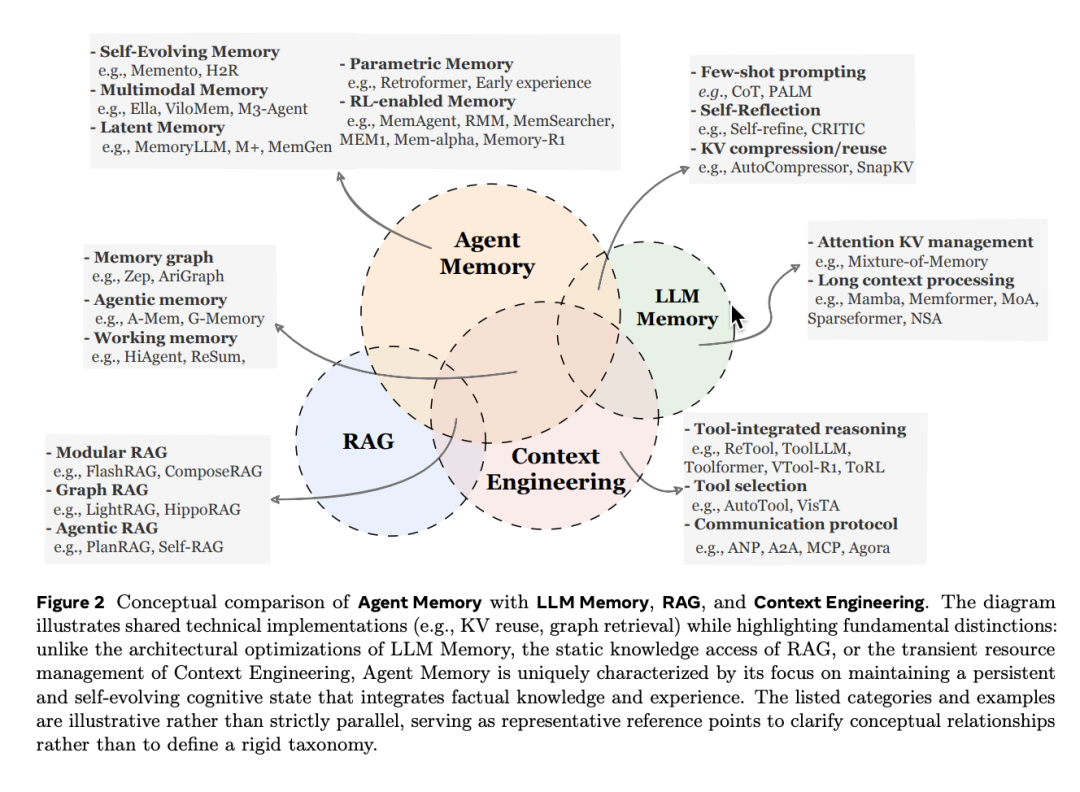

论文明确区分了Agent记忆与几个相关概念。与LLM记忆相比,Agent记忆关注信息的存储与管理,而非模型内部的记忆能力本身。与检索增强生成(RAG)相比,传统RAG主要关注从静态外部语料库检索知识以增强单轮生成,而Agent记忆强调动态积累和管理来自Agent自身交互的信息,具有更强的时间性和自适应性。与上下文工程(Context Engineering)相比,Agent记忆是上下文工程的一个子集,但更聚焦于持久化和演化的信息管理。 论文总结了五个值得关注的新兴方向:(1) 面向自动化的记忆设计——自动发现最优记忆架构;(2) 强化学习与记忆系统的深度融合;(3) 多模态记忆——处理文本以外的视觉、音频等信息;(4) 多Agent系统的共享记忆;(5) 可信赖性问题——记忆的准确性、隐私和安全。 这篇综述最大的贡献在于概念澄清。当前Agent记忆领域的一个核心困境是:不同研究者使用相同的术语却指代完全不同的东西。"Forms-Functions-Dynamics"框架提供了一个共同语言,让研究者能够精确定位自己的工作在整个版图中的位置。尤其值得注意的是,论文明确指出"长期/短期记忆"的二分法已经过时——这种认知或心理学借用的分类无法捕捉现代Agent系统中记忆的复杂性。对于正在构建Agent系统的工程师来说,这个框架也提供了实用的设计指导:根据任务需求选择合适的记忆形式,根据功能目标设计记忆内容,根据动态需求配置生命周期操作。

|