|

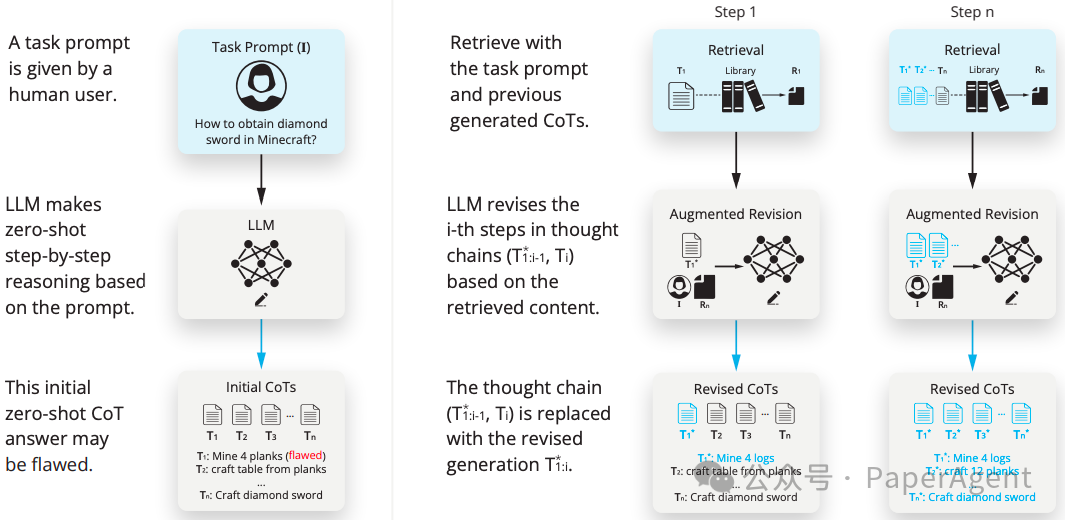

检索增强思维(Retrieval Augmented Thoughts, RAT)通过迭代修订思维链来显著提高大型语言模型(LLMs)在长期生成任务(代码生成、数学推理、创意写作和具身任务规划等)中的推理和生成能力,同时大幅减轻幻觉现象。RAT方法通过检索与任务查询、当前和过去思维步骤相关的信息来逐个修订每个思维步骤,从而在初始零次CoT(链式思维)生成后进行修订。 检索增强思维(RAT)流程。给定一个任务提示(图中表示为I),RAT从LLM生成的初始逐步思考(T1, T2, ..., Tn)开始进行zero-shot(“让我们一步步思考”)。一些思考步骤(如图中的T1)可能因幻觉而存在缺陷。RAT使用来自外部知识库(表示为图书馆)的RAG迭代修订每个思考步骤(T★1, T★2, ..., T★i-1, Ti)。

RAT的提示策略包括以下几个步骤:

ingFang SC", "Microsoft YaHei", SimHei;font-size: 14px;letter-spacing: 0.5px;text-align: start;text-wrap: wrap;background-color: rgb(49, 49, 58);" class="list-paddingleft-1">生成初始CoT:首先,LLM根据任务提示进行零次射击处理,生成一系列逐步的思考(CoT),这些思考代表了解决问题的中间步骤。 查询生成:然后,将任务提示和已经生成的CoT作为查询,用于从外部知识库中检索相关信息。 信息检索:使用检索到的信息,LLM对每个CoT步骤进行修订,以纠正可能存在的错误或幻觉。 逐步修订:LLM按照CoT的顺序逐步生成响应,每一步都基于检索到的信息和之前修订过的思考步骤进行。 最终生成:在所有CoT步骤都经过修订后,LLM将这些修订后的思考步骤整合起来,生成最终的输出。 ingFang SC", "Microsoft YaHei", SimHei;font-size: 14px;letter-spacing: 0.5px;text-align: start;background-color: rgb(49, 49, 58);white-space-collapse: preserve !important;word-break: break-word !important;">

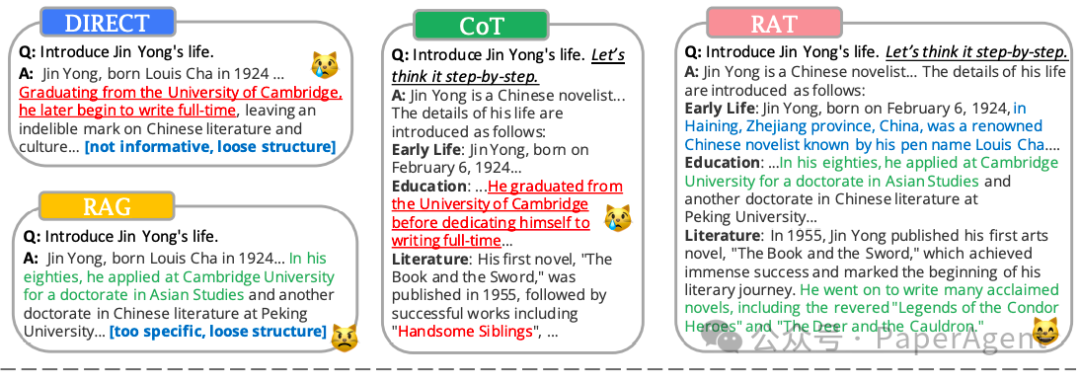

不同大型语言模型(LLM)在创意生成任务中的推理方法示例。红色文本表示LLM生成文本中的错误或幻觉,而绿色文本代表正确的生成。没有使用RAG的方法通常会产生带有幻觉的错误信息,传统的RAG与检索到的内容高度相关但结构松散,而RAT生成的文本在准确性和完整性方面表现最佳。

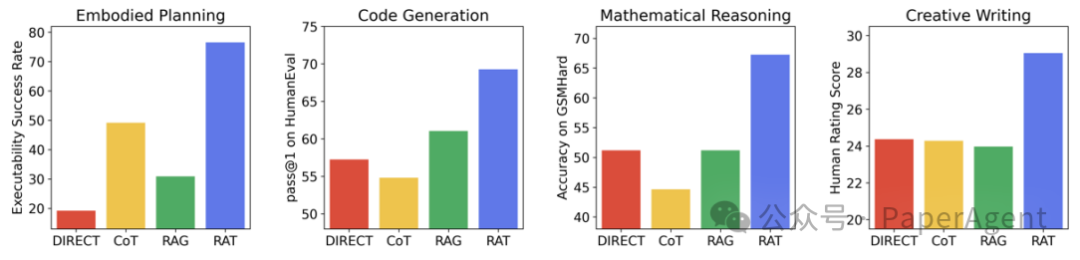

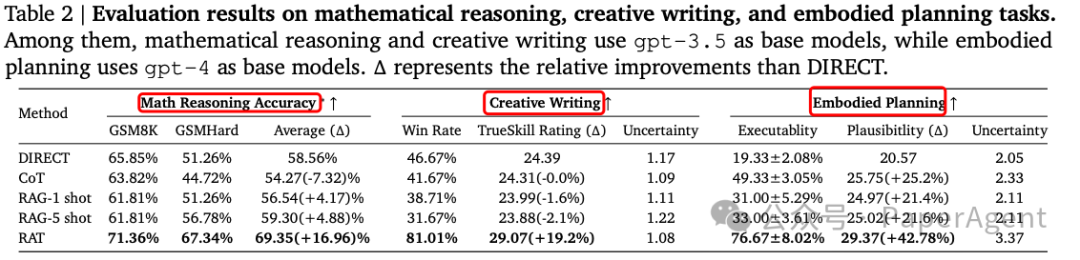

将RAT应用于GPT-3.5、GPT-4和CodeLLaMA-7b等模型,在代码生成、数学推理、创意写作和具身任务规划等各种长期生成任务上显著提高了性能。例如,在代码生成任务中,RAT相对于直接方法(DIRECT)的平均评分提高了13.63%,在数学推理任务中提高了16.96%,在创意写作任务中提高了19.2%,在具身任务规划中提高了42.78%。不同LLM推理方法在复杂具身规划、数学推理、代码生成和创意生成任务上的定量性能比较。RAT在所有任务上都超越了所有基线方法。

|