|

上线一周, gemini-2.0-flash-exp、gemini-2.0-flash-thinking-exp 已经成为了我日常对话频率最高的模型之一。 看着名字很长,其实就是对标 GPT-4o 和 o1。 2.0-flash 在 SWE-bench(代码能力评估) 得分超过 Claude-Sonnet-3.5,2.0-flash-thinking 在 LMArena 所有类别拿到冠军,且速度比 o1 快 5 倍! 重要的是,他们还把思考过程公开了(o1每次都会因为这点被吐槽) 还有还有,不同于贵到肉疼的 o1 API, 也区别于“升级版封号斗罗pro-max-plus-ultra”的 Claude(额度是上午充的,号是中午没的。。。) Gemini 它免费啊! 这就能做很多事了,翻译、编程、日常对话、联网搜索、中文视频聊天、视频剪辑、屏幕共享,把我其他AI应用的活也抢了。 之前用别家模型的 API 是为了节约成本,这次是真的离不开 Gemini 了。  上一次,我是因为 API 价格跳水,梳理了在日常工作流里面如何搭配不同模型的 API 和网页版。 当时我的选择是: - 本地:qwen-7b-instruct-q5_K_M

使用OpenAI API的最后一条路断了,我连夜组合出了新的平价方案

但经过这两周的反复尝试后,这几个应用都被 Gemini 取代了,好处就是不需要自建服务集合十来个API,也不需要担心费用了。 官方的羊毛好暖好贴心~

一、日常对话 & 联网搜索 先来简单说说,如何获取 Gemini 的 API Key: - 访问 https://makersuite.google.com/

- 用账号登录,点击 Get API Key -> Create API key in new project

- 得到的 Key 就是我们后面所有的设置里的“万能钥匙”了

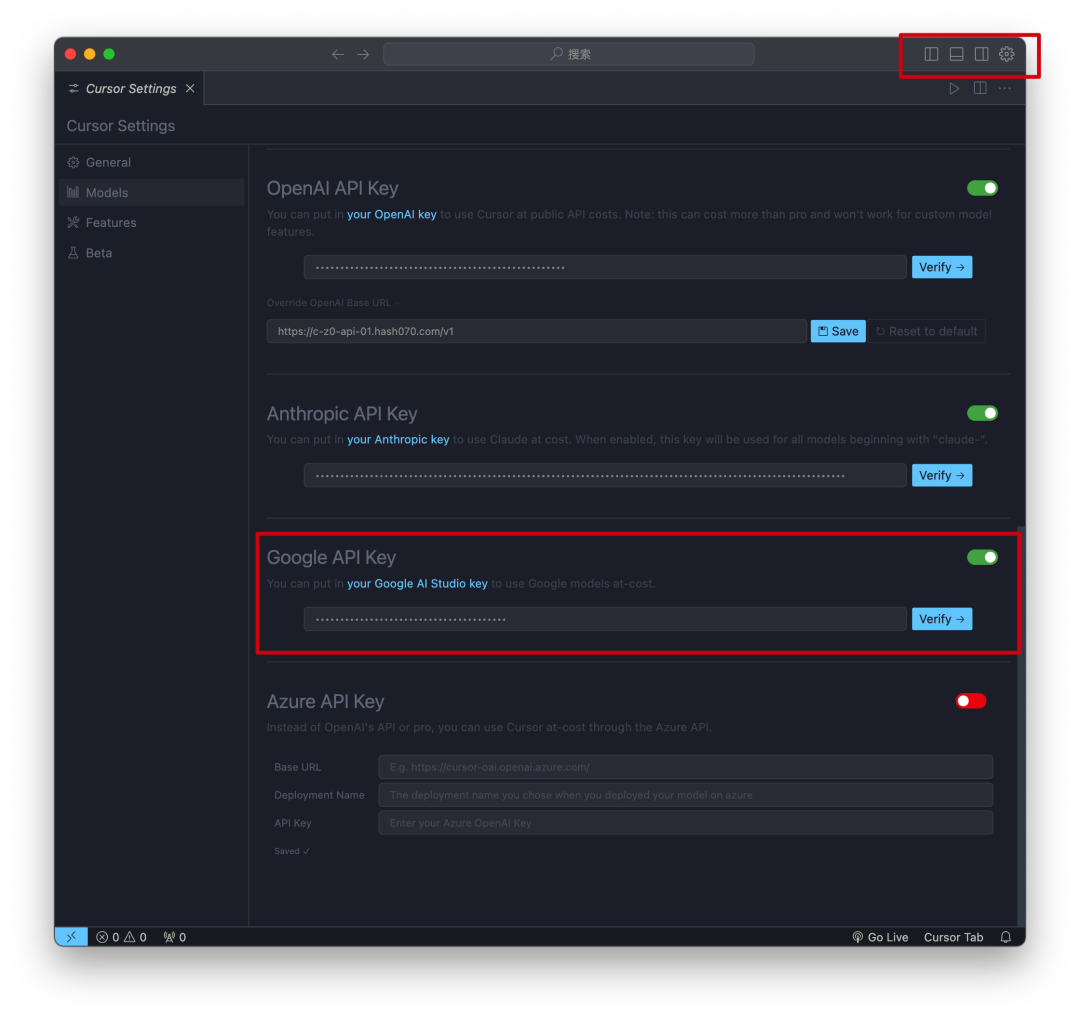

本地的大模型对话端我还是推 Chatbox,作者的更新是真的快,我是自来水?  软件操作界面的右下角“设置”里面就可以选择 Gemini,Chatbox 支持了几乎是全系列的模型,单单是Gemini 系列足足有30个。 再分享一下我的默认设置:上下文消息上限保留12-18个、Temperature保留0.5~0.7。  能回答“9.11跟9.9哪个大”的推理模型免费用上了! 再来就是高频的使用场景 - 代码生成了。 Cursor已经算是半取代我的 vscode,我的 vscode 现在只出现在云端了。  给大家看看实际生成的速度:

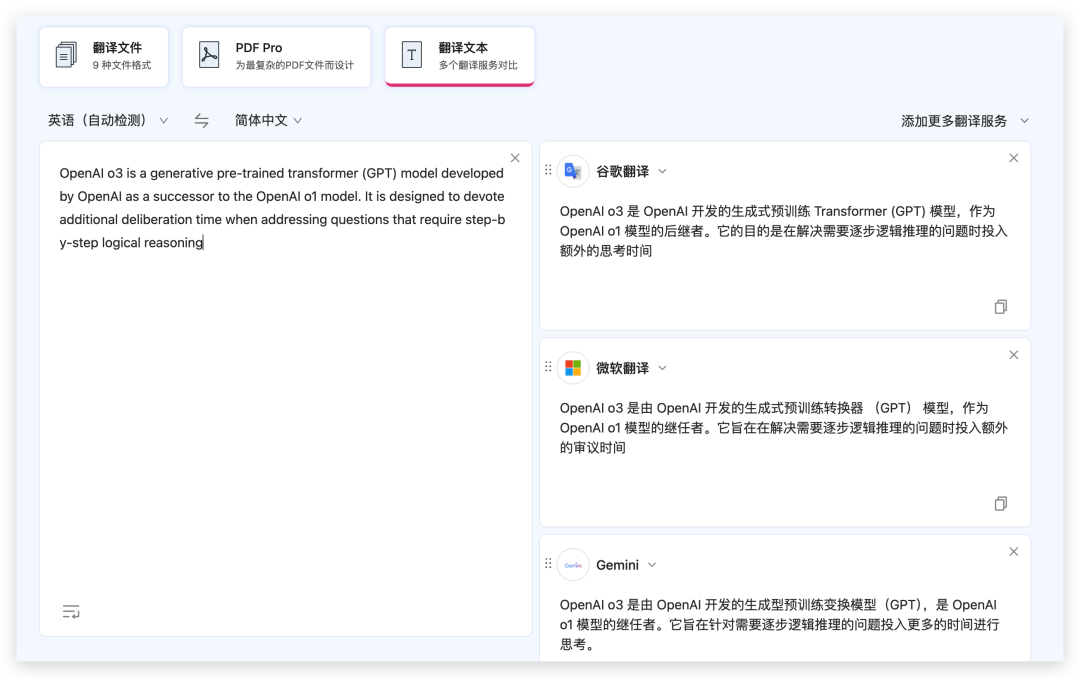

二、网页 & PDF翻译 沉浸式翻译,也是老朋友了, 基本上网页、PDF翻译都已经是主力工具,我额外会搭配一个 Bob 来满足更灵活的划词翻译和图片翻译。 因为这两款软件原生就支持 Gemini API Key, 设置上基本没有难度:   1.5-flash 的翻译速度还是蛮快的,虽说比不上非大模型的翻译接口,但胜在翻译质量是真的高。

视频聊天 & 屏幕共享 不得不说,Gemini 2.0 这个实时语音加屏幕获取太有用了。体验感比 GPT mac 应用的实时屏幕更加丝滑。 这次用的是这款软件:https://www.dinopal.ai, 跟官网相比的话,多支持了中文聊天。 视频里我就尝试让 Gemini 帮我调整生成的图片风格,整体感觉可以充当聊天助理,要用在实时辅助的话,还是有一段距离的。 也期待后续能跟 AI 眼镜、AI 耳机联动起来,搞点新花样。

|