|

本地运行DeepSeek R1 + RAG系统 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;color: rgb(63, 63, 63);"> ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;margin: 0.1em auto 0.5em;border-radius: 8px;box-shadow: rgba(0, 0, 0, 0.1) 0px 4px 8px;" title="null"/>ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;display: table;padding: 0.3em 1em;color: rgb(255, 255, 255);background: rgb(15, 76, 129);border-radius: 8px;box-shadow: rgba(0, 0, 0, 0.1) 0px 4px 6px;">基本概念ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">? OllamaingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">Ollama 是一个用于在计算机上ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">本地运行大型语言模型 ()LLMs 的框架。它允许您ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">下载、运行 AI 模型并与之交互,而无需基于云的 API。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">?ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">示例: ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;margin: 0.1em auto 0.5em;border-radius: 8px;box-shadow: rgba(0, 0, 0, 0.1) 0px 4px 8px;" title="null"/>ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;display: table;padding: 0.3em 1em;color: rgb(255, 255, 255);background: rgb(15, 76, 129);border-radius: 8px;box-shadow: rgba(0, 0, 0, 0.1) 0px 4px 6px;">基本概念ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">? OllamaingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">Ollama 是一个用于在计算机上ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">本地运行大型语言模型 ()LLMs 的框架。它允许您ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">下载、运行 AI 模型并与之交互,而无需基于云的 API。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">?ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">示例:ollama run deepseek-r1:1.5b– 在本地运行 DeepSeek R1?为什么要使用它?免费、私密、快速且离线工作。 ? LangChain 语言链 LangChain 是一个Python/JS框架,用于通过与数据源、API 和内存集成LLMs来构建 AI 驱动的应用程序。 ?为什么要使用它?它有助于连接到LLMs实际应用程序,如聊天机器人、文档处理和 RAG。 ? RAG(检索增强一代) RAG 是一种 AI 技术,可检索外部数据(例如 PDF、数据库)并增强LLM的响应。 ?为什么要使用它?通过引用实际文档来提高准确性并减少幻觉。 ⚡ DeepSeek R1 模型 DeepSeek R1 是一个开源 AI 模型,针对推理、问题解决和事实检索进行了优化。 ?为什么要使用它?强大的逻辑功能,非常适合 RAG 应用程序,并且可以使用 Ollama 在本地运行。 入门? 它们如何协同工作? - •Ollama在本地运行 DeepSeek R1。

- •LangChain将 AI 模型连接到外部数据。

示例用例:一个问答系统,允许用户上传 PDF 并提出有关它的问题,由Ollama上的DeepSeek R1 + RAG + LangChain提供支持!? ? 为什么在本地运行 DeepSeek R1? ? 第 1 步:安装 Ollama? 下载 Ollama Ollama 适用于macOS、Linux 和 Windows。请按照以下步骤进行安装: - 3. 选择您的作系统(macOS、Linux、Windows)

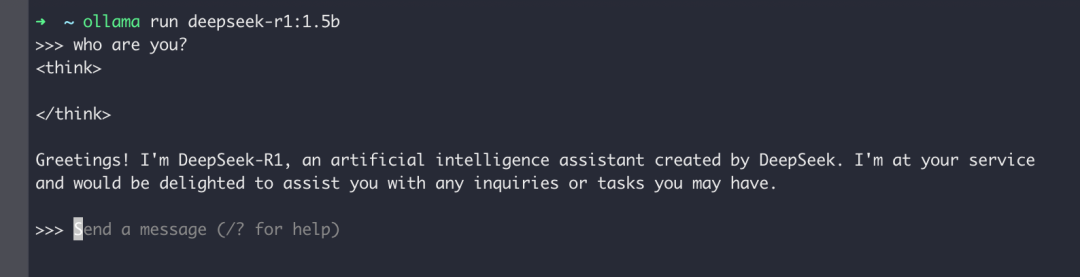

? 第 2 步:在 Ollama 上运行 DeepSeek R1安装 Ollama 后,您可以运行 DeepSeek R1 模型。 ? 运行 ollama 服务 $ollamaserve ? 提取 DeepSeek R1 模型 $ollamapulldeepseek-r1:1.5b ? 运行 DeepSeek R1 $ollamarundeepseek-r1:1.5b 它将初始化模型并允许您发送查询。  ? 第 3 步:使用 Streamlit 设置 RAG 系统现在您已经运行了DeepSeek R1,让我们使用Streamlit将其集成到检索增强生成 (RAG) 系统中。 ? 先决条件 在运行 RAG 系统之前,请确保您已: $ pip install -U langchain langchain-community

$ pip install streamlit

$ pip install pdfplumber

$ pip install semantic-chunkers

$ pip install open-text-embeddings

$ pip install faiss

$ pip install ollama

$ pip install prompt-template

$ pip install langchain

$ pip install langchain_experimental

$ pip install sentence-transformers

$ pip install faiss-cpu

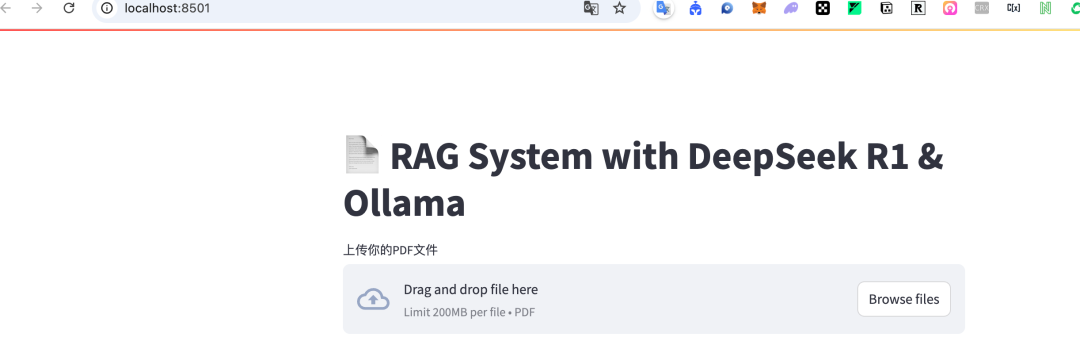

? 第 4 步:运行 RAG 系统? 创建项目 1️⃣ 创建新的项目目录 $mkdirrag-system&&cdrag-system 2️⃣创建 Python 脚本 (app.py),粘贴以下基于 Streamlit的脚本: 完整的代码文件:app.py[2] ? 第 5 步:运行应用程序脚本准备好后,启动Streamlit 应用程序: $streamlitrunapp.py  使用- 1. 启动之后浏览器访问:http://localhost:8502/

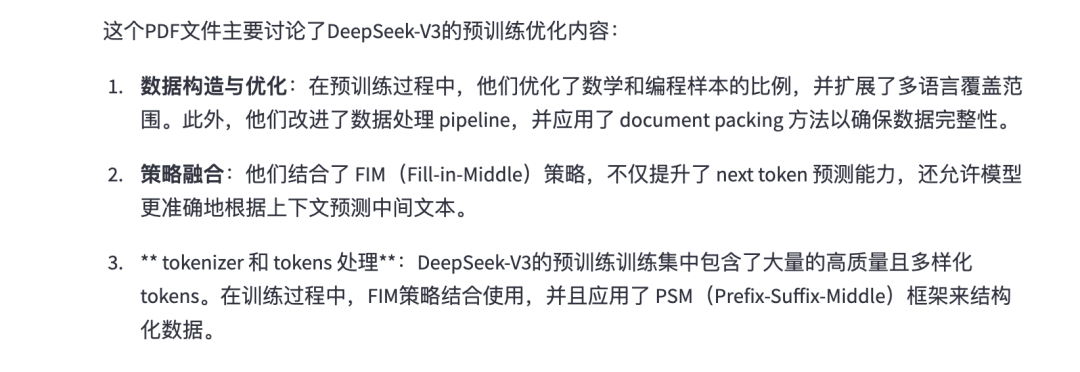

- 2. 然后上传一个PDF文件,然后在输入框中输入问题,如下是我上传了一个DeepSeek_V3.pdf的文件,我让他给我总结。

上面的 Demo 是在我本地 Macos M3 电脑上运行成功,如果要运行改案例,需要保障有足够的内存。

|