|

【项目概述】 关于DeepSeek 本地化部署、搭建个人知识库(资料库)、联网搜索及本地化可视化管理。共分享了三套部署方案。这一篇着重介绍了局域网访问及异地公网访问本地DeepSeek知识库的方法。 演示环境:Windows11 24H2

(一)、DeepSeek本地部署基础环境

1.、安装Ollama框架 2、下载DeepSeek模型 3、可视化界面配置 4、配置本地知识(数据)库 关于本地如何部署DeepSeek、可视化界面及配置知识(数据)库,请前往前面发布的关于本地部署方案,涵盖(个人小白、小团队或企业)不同方法: 本地部署DeepSeek+知识库(可视化)视频版

(二)、局域网共享大模型配置

同一局域网下,一台主机本地部署了DeepSeek-r1 (或其他模型)以及数据(知识)库后,供局域网下其他主机进行访问大模型和数据库。 操作步骤: 第一步、启动局域网访问权限 默认Ollama仅允许本地访问,需修改环境变量实现局域网共享: 创建用户环境变量: 1、WIN+R打开输入cmd,以管理身份启动CMD终端,执行如下两个命令创建用户和系统变量,系统多个“/m”。 setxOLLAMA_HOST"0.0.0.0"setxOLLAMA_ORIGINS"*"

创建系统环境变量: 1、在电脑设置中搜索找到“编辑系统环境变量”并打开编辑系统环境变量。

2、在系统属性面板中点击环境变量,点击 新建系统变量。

3、新建系统变量名为:OLLAMA_HOST,值设置为0.0.0.0 。

4、再次新建系统变量名称为:OLLAMA ORIGINS,值设为:“*” 。

5、电脑右下角右键退出Ollama 程序后重新手动启动Ollama程序。

第二步;局域网访问本地大模型配置 在同一局域网下的其他用户访问当前本地部署。无论是使用Page Assist、Anything LLM、Chatbox或Cherry Studio进行部署,都需要在主机与被访问主机上安装对应用的部署工具。 注意:主机ip 地址查询,在CMD中 直接输入:ipconfig回车即可显示。

部署一:浏览器插件 浏览器Page Assist Web UI插件部署的,设置Ollama地址为http://[主机IP]:11434。 1、被访问主机设置:使用Page Assist浏览器插件本地部署的,被访问主机默认本地访问:http://127.0.0.1 : 端口:11434 即可。

2、访问主机设置:访问主机将127.0.0.1 改为被访问主机IP 地址,如:192.168.50.80,端口默认11434 即可。

部署二:客户端工具 如Anything LLM、Chatbox或Cherry Studio进行部署,配置API地址为http://[主机IP]:11434/v1,选择对应模型即可交互。 1、被访问主机设置:默认Api :http://localhost:11434,保持默认即可。

2、访问主机设置:访问主机将localhost 改为被访问主机IP 地址,如:192.168.50.80,端口默认11434 即可。

3、Anything LLM工具设置同上。

(三)、异地公网访问大模型 一台主机本地部署了DeepSeek-r1 (或其他模型)以及数据(知识)库后,通过公网(外网)异地访问这台主机的大模型和数据,进行内网穿透设置,工具cpolar或路由侠。 操作步骤: 第一步:被访问主机安装路由侠 1、这里以路由侠为例,选择适合自己系统下载安装。 #路由侠地址:https://www.luyouxia.com/#cpolar地址:https://www.cpolar.com/

2、启动安装程序进行安装。

3、注册路由侠账户,并登录账户。

第二步:路由侠配置 1、启动软件后,设置点击内网映射。

2、点击 添加映射 ,并进行配置。

3、选择 选择原生端口——开始创建。

4、配置公网地址:设置端口为Ollama端口,然后点击创建。

5、创建完成后即显示创建的映射内容,右键复制地址,接下来将复制的地址粘贴到对应部署的工具中。

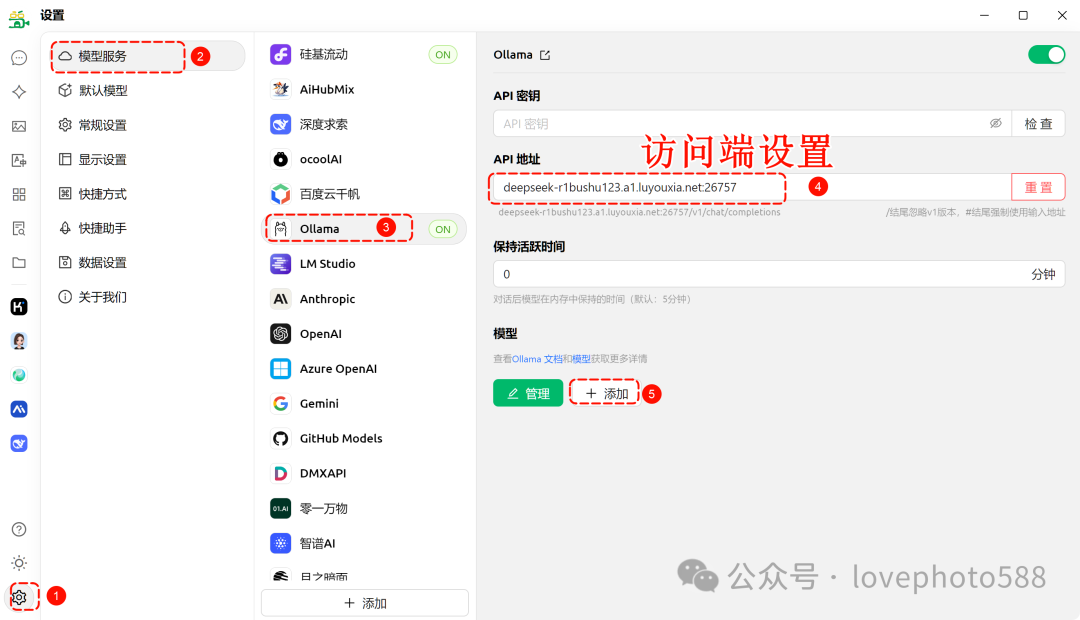

(四)、访问端设置 部署一:浏览器插件部署 1、Page Assist访问端设置:将复制的地址粘贴在Ollama 设置——Ollama URL 中保存,重启浏览器。

部署二:客户端工具 1、Cherry studio访问端设置:在设置——模型服务——Ollama——API地址 中粘贴地址,再添加模型设置后重启Cherry studio。

2、AnythingLlm访问端设置:首选项——Ollama——Ollama URL 中粘贴复制的地址,设置完成后设置后重启AnythingLlm。

注意事项:

1、提示错误 Ollama call failed with status code 403: l检查环境变量——用户变量及系统变量是否有Ollama的变量设置。

|