|

大模型推理为什么又长又啰嗦? 想象一下让学霸解题:明明第一步就得出答案,却非要反复验算十遍,还写满整张草稿纸——这就是当前大模型(如GPT-4、DeepSeek)的痛点!  论文:Optimizing Length Compression in Large Reasoning Models

链接:https://arxiv.org/pdf/2506.14755

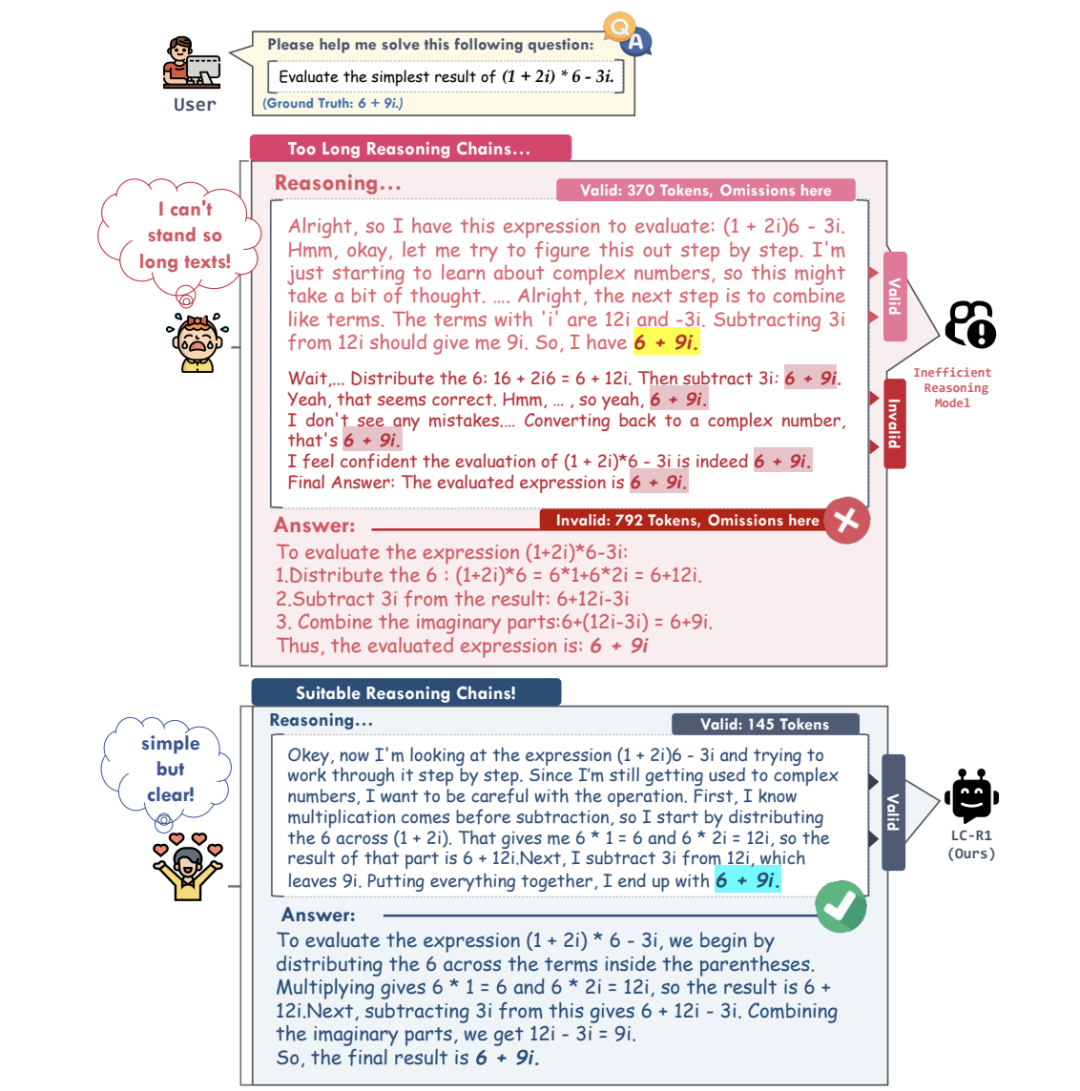

论文发现:模型在简单题目上过度推理,生成大量无关步骤。比如解方程时,答案早出现了,后面全是"让我再检查一下..."的废话。 如图对比:普通模型像写小作文,LC-R1训练后像发微博  关键发现:模型在"无效思考"上浪费45%时间!作者提出"无效思考"(Invalid Thinking)概念: 定义:模型得出正确答案后继续的冗余验证步骤

量化指标 VT率:有效推理长度 ÷ 总推理长度

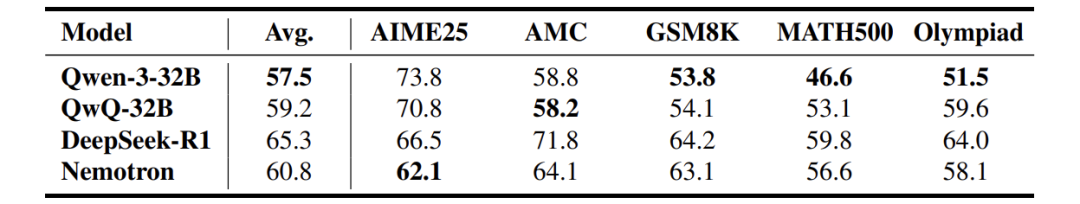

惊人数据:当前顶尖模型的平均VT率仅58-65%,意味着35-45%的计算资源在空转! 好比打车去3公里外吃饭,司机绕路开了6公里

解决原则:"简短"和"够用"的平衡术传统方法粗暴砍长度可能误伤关键步骤。本文提出两大原则: - Brevity(简短):只保留必要推理,答案一出立刻停笔

- Sufficiency(够用):确保关键逻辑步骤不丢失

类比烹饪: - 普通厨师:煮面10分钟,再煮5分钟"确保熟透" →冗余

- 智能厨师:煮面10分钟,筷子一夹就关火 →Brevity+Sufficiency

LC-R1方法:双奖励机制的训练魔法核心方法:用强化学习给模型"植入条件反射" - 压缩奖励:精准识别"无效思考"并删除(防过度检查)

关键操作:

当模型首次输出正确答案时,立刻给</think>标记发"红包"(奖励),训练它养成答完即停的习惯! 公式示意:

压缩奖励 = 1 - (有效长度 / 原始长度)

提前终止时罚分 -1(避免偷工减料)

效果验证:砍掉一半长度,精度只掉2%在7大测试集(数学/编程/逻辑题)中,LC-R1碾压其他压缩方法: - 平均缩短50%长度:从1万token→5千token

- 精度仅下降1.8-2.1%(其他方法降幅4-12%)

如图:LC-R1稳居帕累托前沿最优位置

案例对比:同一道数学题   彩蛋:压缩后模型反而更"专注"?"删掉的真是纯废话,留着的全是干货!" 结语LC-R1的价值不仅是技术突破,更揭示了模型推理的本质规律:

更多步骤≠更好结果,精准思考才是王道。 |