最强的 AI 模型都在云端,最安全的数据都在本地。这个矛盾困扰了所有想用 AI 处理敏感信息的人。

Freysa 团队提出了一个有趣的解法:既然不能让模型变本地,那就让数据变“假”的。

现有方案都有什么问题

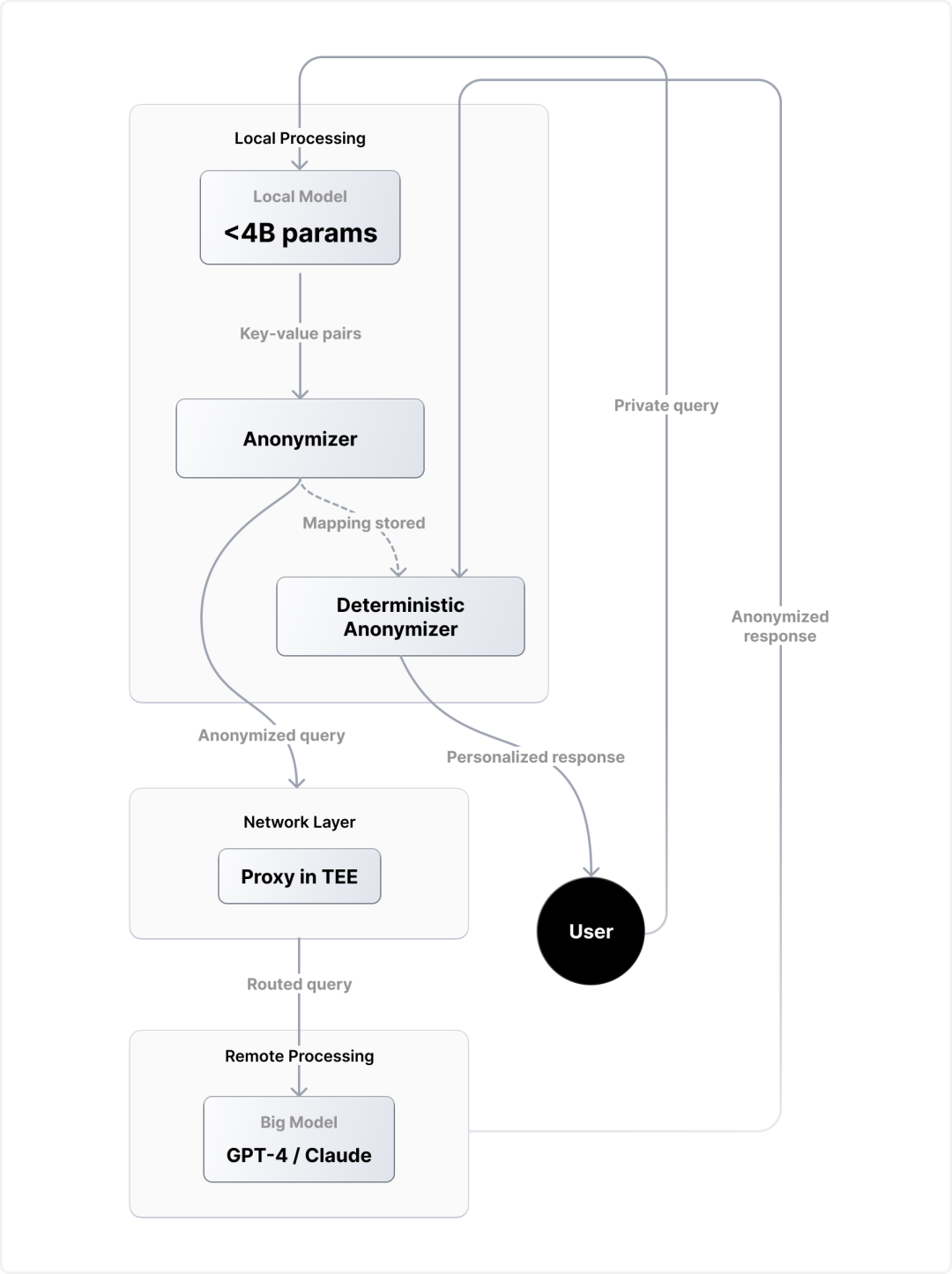

TEE(可信执行环境)听起来很美好,但最好的模型都是闭源的,你根本跑不了。开源模型?Qwen3-Coder 这种 100B+ 参数的模型,单张 H100 都撑不住。

PAPILLON 系统试过用本地模型重写查询再发给云端,结果是灾难性的:准确率掉到 85%,还有 7.5% 的概率直接泄露隐私。问题出在它想重写整个提示,经常画蛇添足或者理解错意思。

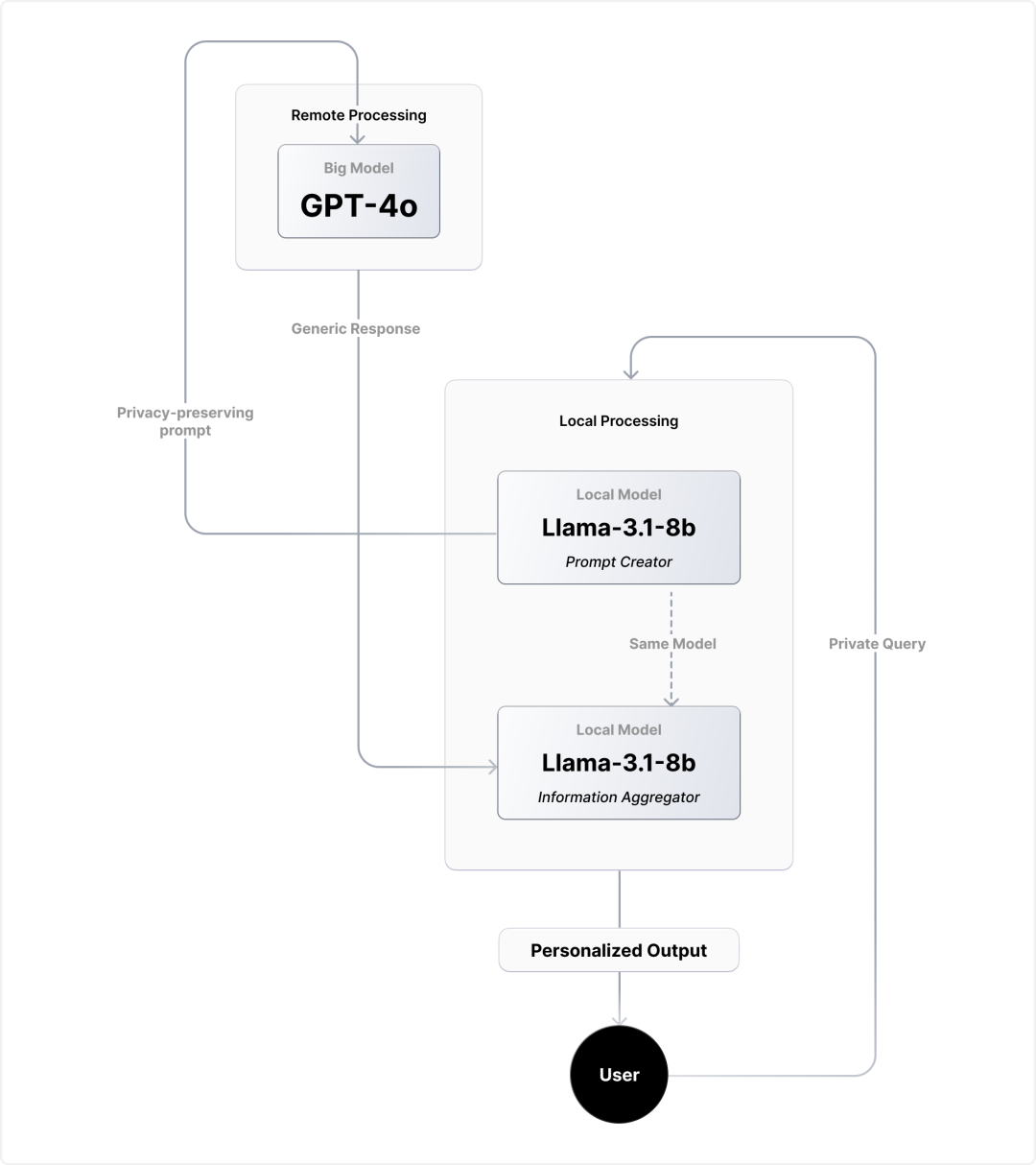

Freysa 的“替身术”

他们的思路很直接:不重写提示,只替换敏感信息。

想象你要问“我在 Google 工作,发现经理在虚报云基础设施的销售数据,该怎么办?”

模型提供商看到的是“我在 TechCorp 工作,发现经理在虚报企业软件的销售数据,该怎么办?”

核心问题保留,敏感信息被替换。Google 变 TechCorp,云基础设施变企业软件,但咨询的本质不变。

更狠的是,如果你连续问几个相关问题,系统会确保每次替换都不同,让模型提供商无法关联这些查询来自同一人。

技术挑战:训练“精准外科医生”

关键是如何训练一个足够小的模型,能在你的设备上跑,还能准确识别和替换 PII。

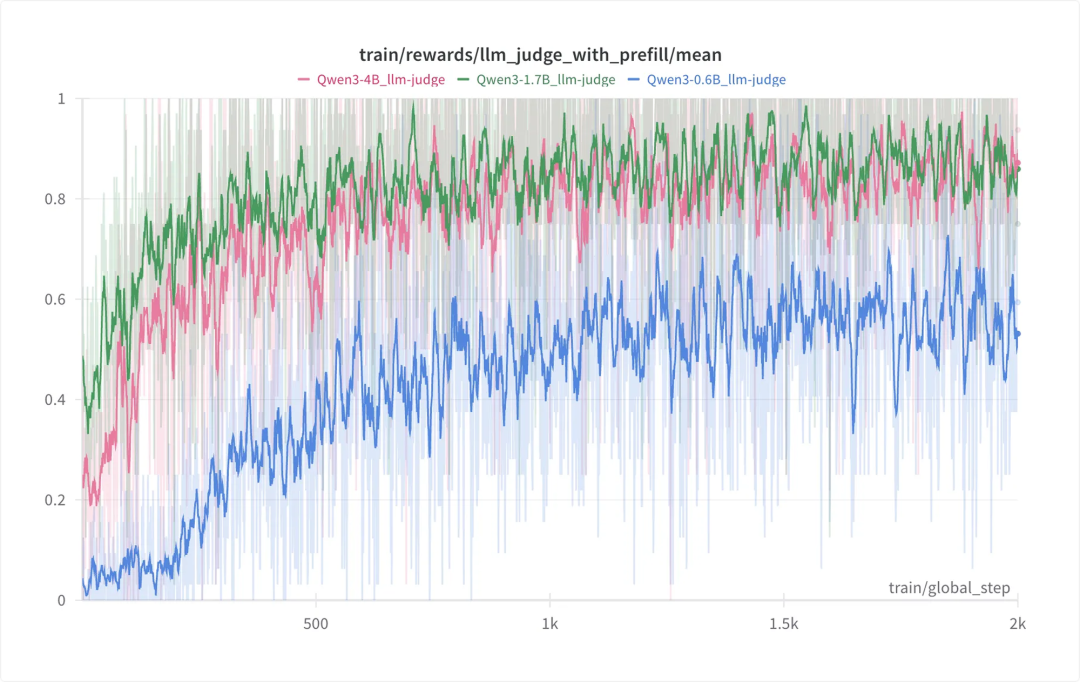

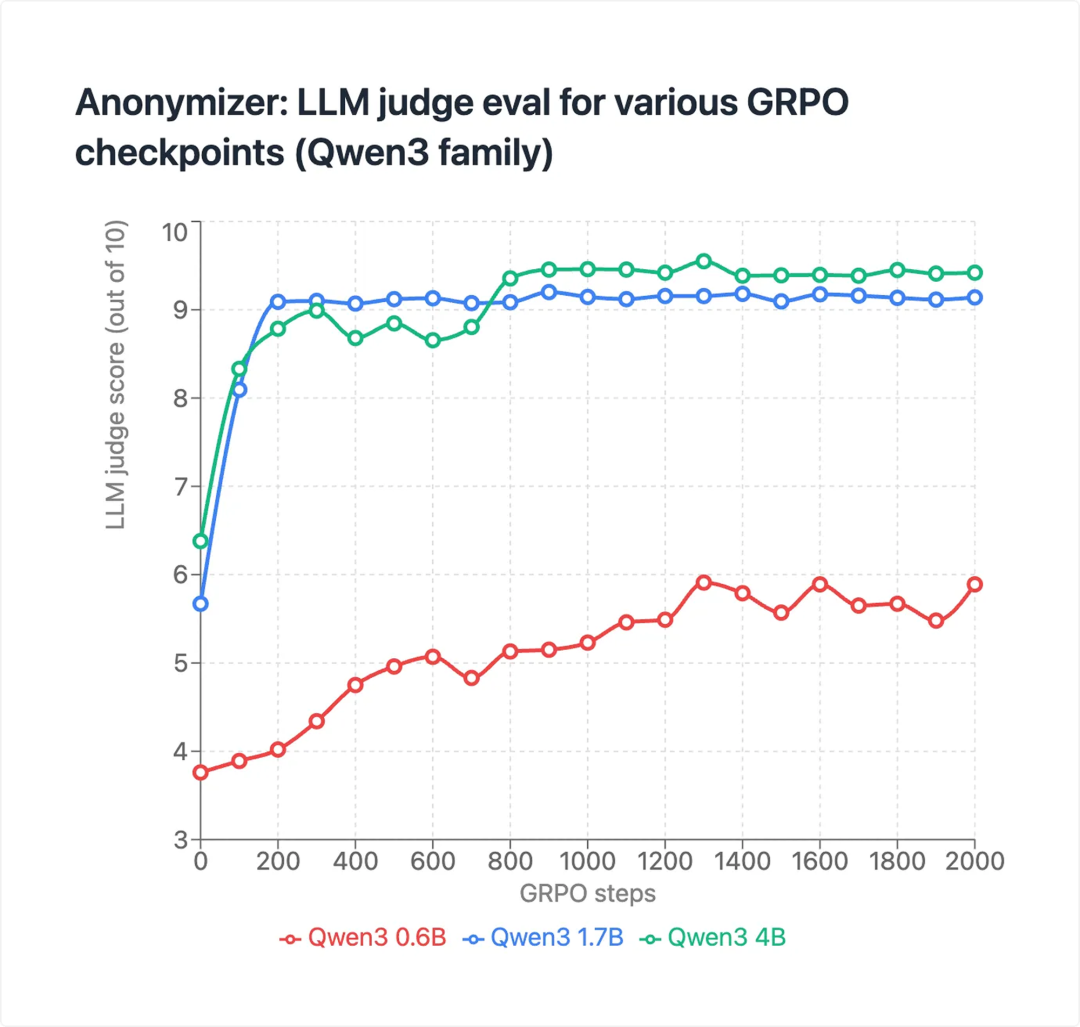

他们用了 3 万个样本训练 Qwen3 系列模型,初始效果一般:

真正的突破来自 GRPO(群体相对策略优化)+ LLM 评判器的组合。因为 PII 替换往往有多个正确答案,GRPO 特别适合这种场景。

最终结果让人惊喜:

一个比 GPT-4.1 小 1000 倍的模型,达到了几乎相同的匿名化效果。

实用性如何

延迟控制在 500ms 以内,准确率超过 99%。支持任何文本 API,从 MacBook 开始部署,最终目标是手机。

保护范围包括身份、关系、位置、时间、财务数据。但一般话题(比如你在问编程问题)、语言结构、公共信息仍然可见。

这个思路的价值

不是所有问题都需要完美解决方案。对大多数人来说,“足够好的隐私 + 强大的能力”比“完美的隐私 + 受限的能力”更实用。

Freysa 没有试图重新发明 AI,而是在现有技术栈上加了一层巧妙的“变装术”。这种渐进式创新往往比革命性方案更容易落地。

当然,这仍然需要信任他们的基础设施,对于极度敏感的查询可能还是有风险。但作为一个过渡方案,已经足够有趣了。

至少,它提供了第三种选择:既不用牺牲 AI 能力,也不用完全裸奔隐私。