最近,来自斯坦福大学、UC Berkeley和SambaNova Systems的研究团队,提出了一个颠覆性方案——Agentic Context Engineering(ACE)。 它让模型的成长,不再靠重新训练,而是靠上下文自我进化。

这不是又一个Prompt技巧,而是一个完整的、自循环的“智能体自我改进框架”。 更令人震惊的是:在多个基准测试中,ACE在**性能提升超10%、推理延迟下降高达86.9%**,甚至用开源模型打平了GPT-4.1的成绩。

一、从“微调”到“上下文进化”:ACE到底改了什么?

我们先看清楚ACE的核心理念。 在传统方法里,要让大模型在某个领域变强,常见做法是:

收集数据 → 调参微调 → 部署新版本

但ACE提出:不改模型参数,只改“输入上下文”。 这听起来像“Prompt工程”的升级版,但ACE更进一步:它把上下文当作一个会成长的记忆系统(playbook)。

📘ACE的哲学:上下文是“活”的

ACE把模型使用的上下文拆成了一个“活的知识库”,由三种角色持续维护:

Generator(生成者)负责执行任务,产出推理轨迹、工具调用过程与结果。

Reflector(反思者)复盘生成者的行为,总结出“哪些策略有效、哪些无效”。

Curator(策展人)把这些经验加工成一个个带标签的“小增量片段(delta item)”,再合并进“上下文手册”中。

每一次任务的执行,都会让上下文变得更聪明。 这就像一个人不断记录自己的成功与失败,形成独特的决策经验。 而模型的“能力提升”,其实就是它的上下文不断被优化的过程。

二、Generator→Reflector→Curator:模型的“自我学习闭环”

ACE的工作机制可以看作一个小型的智能生态系统。 它不靠反复训练,而是靠信息循环和增量积累。

1️⃣ Generator:行动者

Generator负责执行具体任务,比如代码生成、财务推理、信息检索等。 在执行过程中,它会记录下自己的推理路径(Reasoning Trace),包括:

这些轨迹数据就是后续反思的“原材料”。

2️⃣ Reflector:复盘者

Reflector的角色相当于一个“分析师”。 它阅读这些执行轨迹,总结出具体经验,比如:

它提炼出的这些经验被称为“lessons”,是模型理解世界的基础单元。

3️⃣ Curator:策展者

Curator会把Reflector的经验转化为结构化的“delta items”。 这些小片段带有类型(如策略、风险、偏好)和计数器(帮助/损害次数)。 再通过去重、合并、剪枝等机制,构建出一个不断演化的“上下文手册”。

这一步是ACE的关键创新:

- 从而避免上下文崩塌(context collapse)。

最终,ACE形成了一个“持续学习”的闭环系统—— 模型自己用经验更新上下文,用更新后的上下文指导下次行动。

三、性能数据:ACE用开源模型挑战GPT-4.1

这套框架到底效果如何? 研究团队在多个真实环境中测试了ACE,结果令人震撼。

🧠 AppWorld(智能体任务)

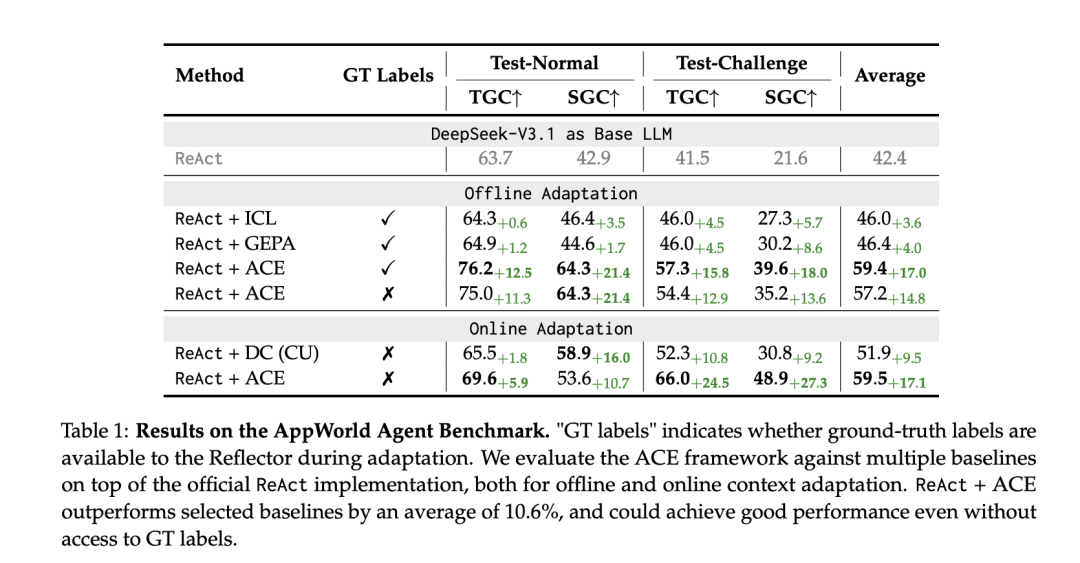

在AppWorld智能体基准中,ACE基于ReAct框架构建(即ReAct+ACE),与多个强力基线模型对比:

📈结果显示:ReAct+ACE达到了59.4%的分数,仅次于GPT-4.1的60.3%,但用的是开源的DeepSeek-V3.1。而在“挑战集(test-challenge split)”上,ACE甚至超过了GPT-4.1的表现。

这意味着:模型不必升级版本,只要上下文不断自我优化,就能逼近SOTA性能。

四、在金融推理任务中,ACE依然强势

除了智能体任务,团队还在金融数据集(FiNER、XBRL Formula)上测试了ACE的适应性。

结果显示:

- 但性能会随反馈质量波动,体现出ACE对“信号质量”的敏感性

这表明,ACE不仅适合交互型智能体,还能迁移到结构化推理、金融分析等高价值场景。

五、速度与成本:省下90%的计算开销

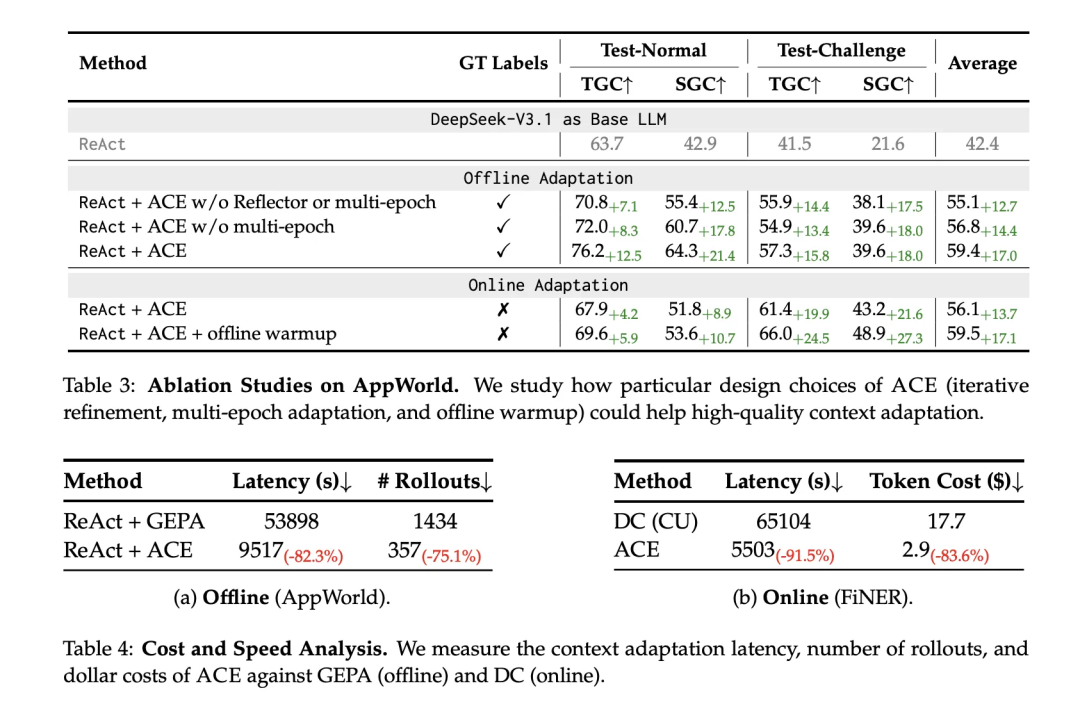

在适应速度和成本上,ACE展现了惊人的效率。

换句话说,ACE几乎把适应成本砍掉了九成。 原因在于它的合并与更新机制都不依赖模型推理,只是简单的“结构化上下文操作”。 这让它非常适合本地化部署、低资源场景,甚至可用于企业私域Agent系统。

六、ACE的真正意义:从“训练模型”到“养成模型”

ACE的提出,标志着一个重要转变:

AI能力不再来源于算力堆叠,而是上下文的持续进化。

它让模型像一个有记忆的个体,通过行动—反思—整理的循环,自我生长。 这不仅意味着模型可以“自养”,也预示着一种新的AI架构哲学:

未来的智能体,可能会像人类一样,靠经验而非训练变强。

七、局限与展望

当然,ACE并非万能。 它的表现依赖于任务反馈的质量,如果反思阶段得到的信号不准,就可能积累错误经验。 此外,随着上下文不断增长,如何在保持效率的同时维持信息密度,也将成为新的研究方向。

但它的启发意义无疑是深远的: 在模型参数越来越难更新、数据越来越私有化的当下,ACE提供了一条让模型自我演化的“轻路径”。