GPT-5 热度还没降,马斯克家的 Grok 4 又放大招:直接支持 2M token 上下文窗口,打破 LLM 吞不下整本书、整仓代码的「咀嚼限制」。

#YutoAPI上线一天 API 市占飙升至 26.4%,xAI 背后这波组合拳能否真正改变 AI 推理格局?今天就给你一次性理清楚! 什么是 Grok 4 Grok 4 是由马斯克旗下 xAI 推出的多模态大模型,其中Grok 4 Fast 版本重点突破了以下两点: ✅上下文窗口:200万 tokens ✅推理模式完成率跃升至 94.1%(非推理模式 97.9%) 这意味着,它可以一次处理整本《战争与和平》的两倍内容(原为 80 万 tokens 左右),且逻辑保持稳定,不“断片”,老马这次又成了游戏规则制定者了。

那为什么说「上下文窗口」是 AI 模型的核心战力? 所谓上下文窗口,就是模型一次能“记住”的最大内容体积。 以往我们用 GPT 处理长文件,常常要「切片—输入—拼凑」,不仅痛苦,还容易造成信息丢失。 Grok 4 Fast 的 200万 token 能力直接跳级! 一口吃掉几本书,逻辑能统一输出; 还能直接读取大型代码库,理解函数调用链; 实现多文档喂入,整合观点、生成总述。

Grok 4 长文工作流实操指南(建议收藏) 场景:论文综述 / 代码库精读 / 政策文档摘要 准备材料: 文件总内容 ≤ 200万 tokens(约合 150 万英文词 / 6000 页文档); 可为纯文本、markdown、代码注释;图片暂不适用。 提示词模板(推荐) 请从以下内容中提取:1.三段摘要(背景/要点/潜在问题);2.列出文中引用的数据来源(附位置说明);3.输出一组结构化问题用于后续深入推理。 如果喂入多文档,可让 Grok 自动生成目录树,再单章节深挖。据 xAI 团队口径,Grok 4 Fast 的推理完成率达到: 推理任务:94.1%(原为 77.5%) 非推理任务:97.9%(原为 77.9%) 虽然这些数据暂未公开模型卡验证,但从#YutoAPI调用量暴增可见开发者对其真实能力的认可度不低。

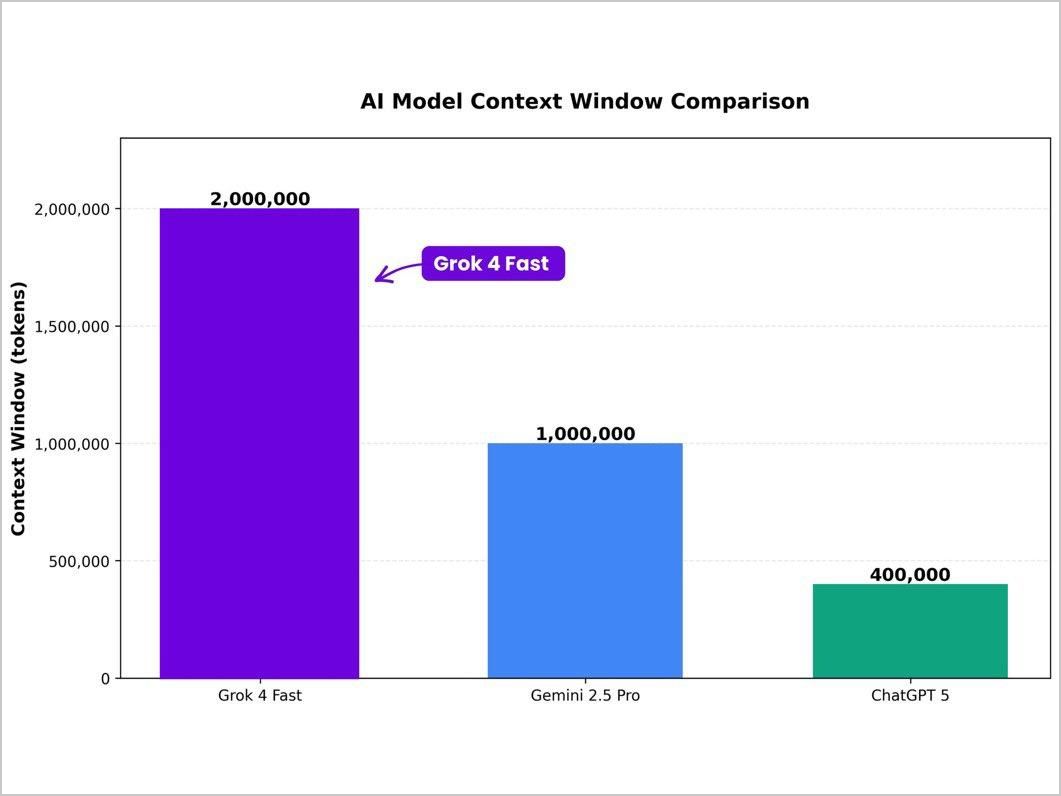

Grok 4 与其他主流模型上下文对比 模型 | 上下文窗口 | 发布者 |

|---|

Grok 4 Fast | 2M tokens | xAI (Elon Musk) | Gemini 2.5 Pro | 1M tokens(计划扩展至 2M) | Google DeepMind | Claude 2.1 | 200k tokens | Anthropic | GPT-5 | 400k tokens | OpenAI |

立刻上手 Grok 4 教程

方法一、前往yutogpt.com免费试用,无需魔法,很友好。 方法二:前往grok.com免费试用,需魔法,不友好。 方法三:开发者调用#YutoAPI gptapi.asia 接入,可用于构建自己的长文总结系统、代码助手、学术综述机器人。 好了,各位精英们,长文处理的下一个时代来了! 因为 Grok 4 Fast 的 2M token 并不只是参数大,它真正改变了: 就像当年你用上了 iPhone,iOS系统的丝滑让你再也离不开了。 |