Cog-RAG: Cognitive-Inspired Dual-Hypergraph with Theme Alignment Retrieval-Augmented Generation

西交、清华、西电联合团队

https://arxiv.org/pdf/2511.13201

一、当 RAG 陷入“实体孤岛”Retrieval-Augmented Generation(RAG)已经成为大模型落地垂直领域的“标配外挂”——把私域文档切成 chunk,做向量索引,回答时召回最相似的片段喂给 LLM,简单粗暴却有效。

但扁平的向量相似度检索天生有两个缺陷: - 跨 chunk 语义割裂:无法显式建模 chunk 之间的依赖或主题演化,导致召回内容“碎片化”。

- 高阶关系缺失:基于向量的方法只能做“点对点”匹配,难以刻画“多实体联合”的复杂语义。

近两年,GraphRAG、LightRAG 等工作把实体级知识图谱搬进 RAG,用“边”把实体串起来,一定程度上缓解了割裂问题。

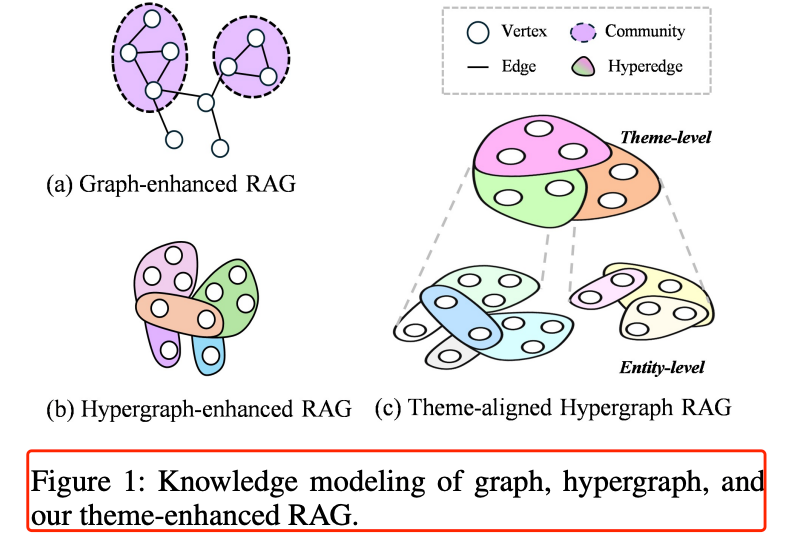

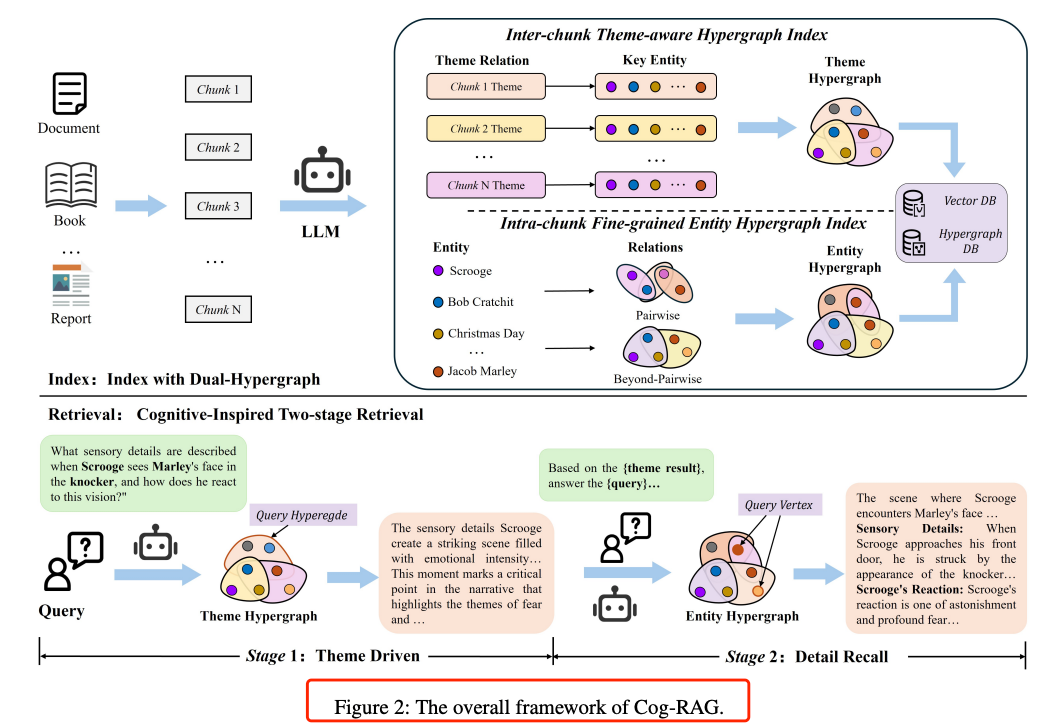

然而,图谱仍然只关注“成对关系”,对于“多个实体共同构成一个事件/主题”的高阶依赖束手无策,如图 1(a)(b) 所示。 二、双超图 + 两阶段检索,模拟“人脑自上而下”的阅读过程2.1 总体框架Cog-RAG 的核心思想一句话概括:先找主题,再找细节,像人一样先快速浏览目录把握主旨,再定位到关键段落精读。

为此,作者设计了两张互补的超图 + 两阶段检索,见图 2。  2.2 双超图索引 | | | |

|---|

| Theme Hypergraph | | 一条超边 = 一个主题(narrative outline)(由 LLM 自动摘要生成) | | | Entity Hypergraph | | 一条超边 = 多个实体的高阶关联(事件、因果、共现等) | |

- 文档滑窗分段 → LLM 抽取主题描述+关键实体→ 主题超图

- 每段内部再抽取实体+低阶/高阶关系→ 实体超图(低阶=成对,高阶≥3 元组)

|