|

之前提及了如何用ollama本地部署模型,模型的来源都是ollama的官方库,这期将探讨如何跨平台使用大模型。

把大模型装进笔记本里:Ollama+Open Web UI

首先肯定需要ollam(目前最好用的一体化部署、配置模型工具)作为模型部署工具,然后从huggingface(世界上最大的自然语言社区)或者modelscope(国内的hf社区)来获取gguf格式的大模型文件。

GGUF(GPT-Generated Unified Format)是一种二进制文件格式,特别为提高模型加载和保存的效率而开发,尤其适用于推理过程中。这种格式优化了与llama.cpp等执行框架的兼容性,这些框架支持GGUF格式。GGUF不仅包含张量数据,还包含了一组标准化的元数据,这有助于执行框架在不需要繁琐配置的情况下理解模型的结构和设置 。

一、部署GGUF文件

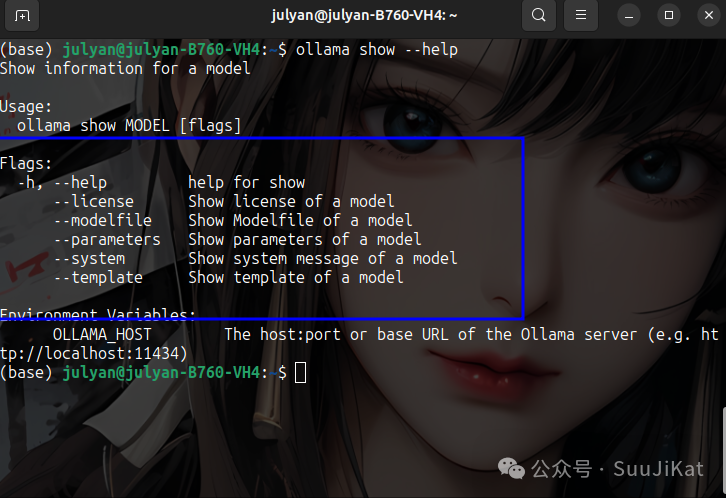

首先我们用ollama show --help来查看ollama演示的命令,其实尤为重要的是modelfile,这是模型的设置文件,里面有模型路径及提示词的信息,而我们从外部导入模型就需要配置其他模型的modelfile。

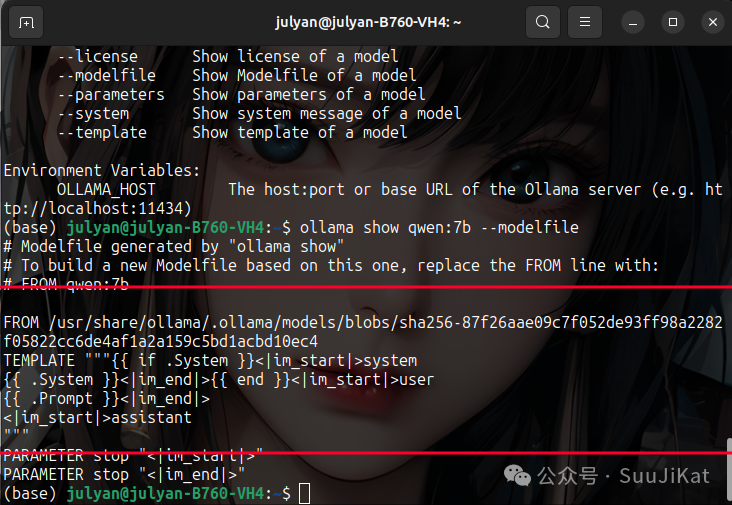

下图就是qwen:7b的模型配置信息,From+路劲就是模型地址,template就是提示词(每个模型默认都不同)。

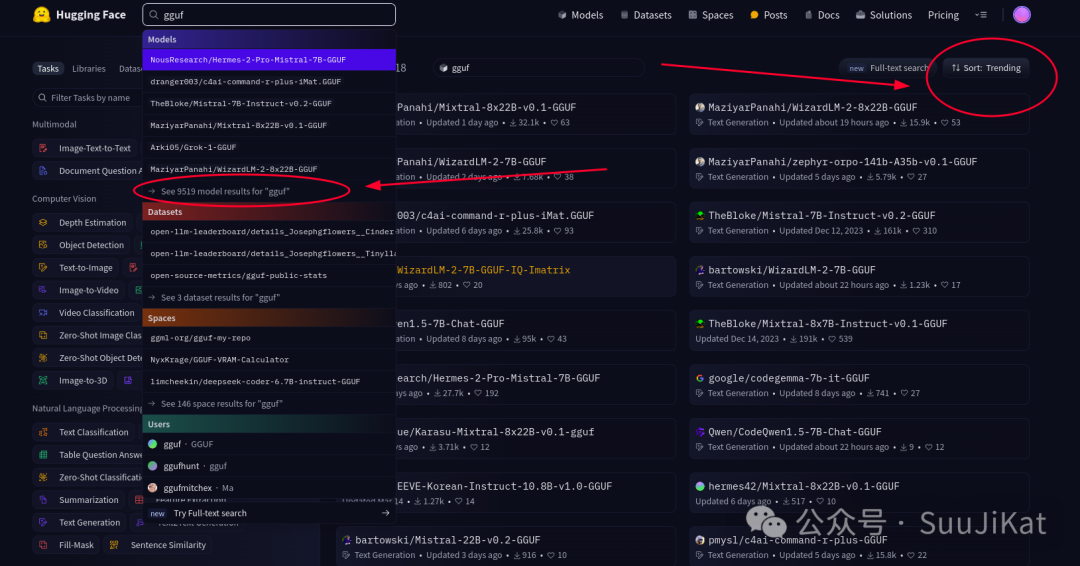

首先我们到hf社区(modelscope社区也行),在搜索框中输入gguf并获取最受欢迎的模型。这里挑选个小点的模型下载做演示。

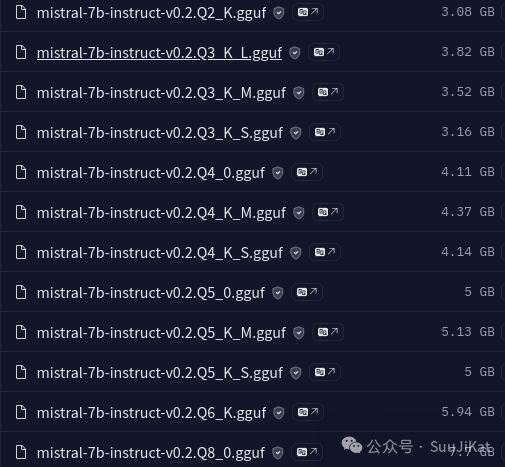

在这个模型清单中,一般来说,量化级别越高(数字越大),模型文件越小,运行时占用的内存和磁盘空间也越少,但可能会略微牺牲精度或响应速度。最底下的那个模型就是性能发挥最完整的,但这里演示我选最上面的那个了。

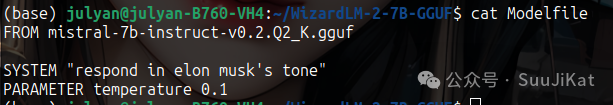

二、客制化大模型

这里客制化大模型的主要操作就是在模型配置文件中进行参数修改。模型下载完后我们在模型的文件路径中创建Modelfile文件,按照上面qwen:7b的模型配置文件格式填写,而提示词样例可以到刚才模型的官网复制示例提示词,这里我们不按照模板填写,我们自己设置提示词模板,给定模型一些先决条件或参数,比如temperature(控制模型输出的随意性),下面是一个模板:

FROM: qwen:7b

PARAMETER:

- temperature: 0.1

- num_ctx: 4096

TEMPLATE: "提示词模板"

SYSTEM:

message: "把英文翻译成中文"

那么接下来我就让这个新模型弄成一个马斯克聊天机器人:

模型配置文件弄好后保存并输入以下命令把模型加载到ollama中:

# 这里myModel是你要给你新建模型取的名字,-f是读取后面的Modelfile文件,包括地址和模型提示词。

ollama create myModel -f Modelfile

# 然后运行这个客制化模型

ollama run MyModel

感觉效果不那么明显,可能是提示词没到位or知识库有限、模型体量,anyway这就是大模型跨平台载入ollama和客制化本地模型的方法。 感觉效果不那么明显,可能是提示词没到位or知识库有限、模型体量,anyway这就是大模型跨平台载入ollama和客制化本地模型的方法。

这里就演示到这了,现在我们可以随意部署本地大模型了,hf社区的更新资源是最快的。

|