|

OpenAI 在北京时间5月14日发布了GPT-4o  - GPT-4o("o"代表"omni"全能)是一个能够实时处理音频、视觉和文本的模型。 - GPT-4o("o"代表"omni"全能)是一个能够实时处理音频、视觉和文本的模型。

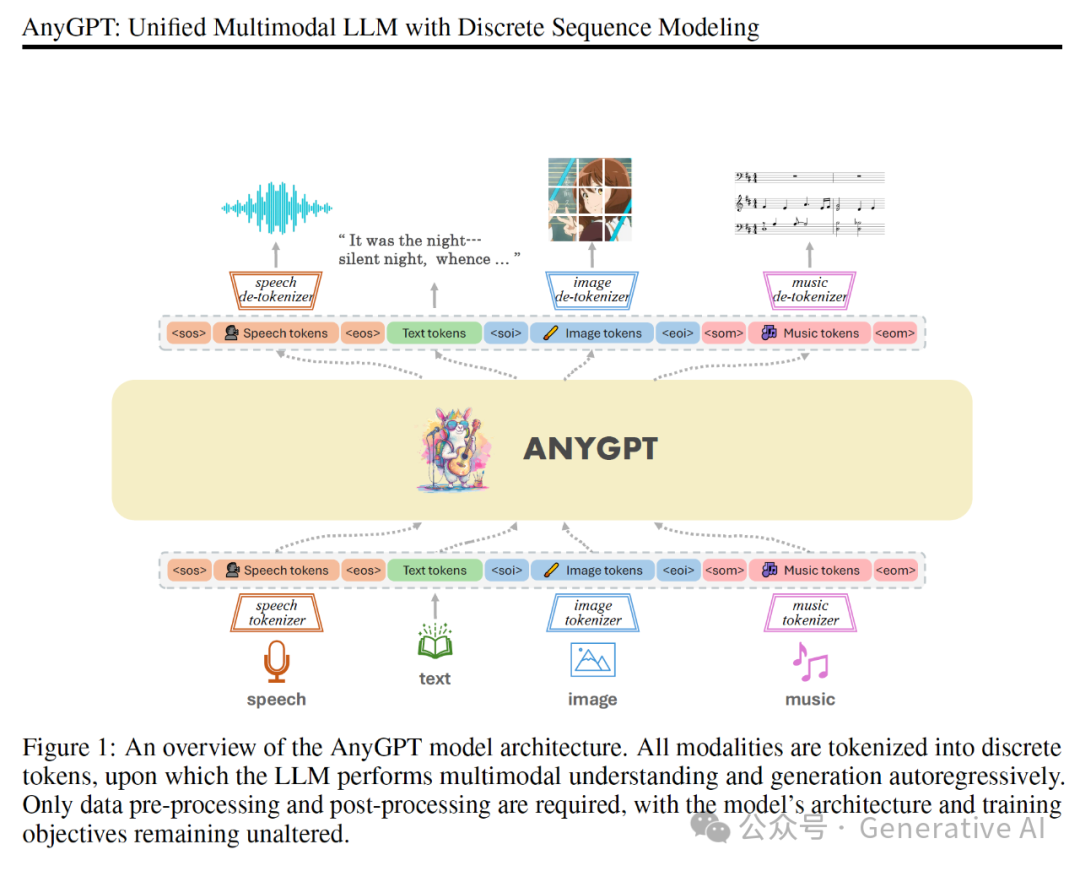

- 它可以接受文本、音频、视觉作为输入,并生成文本、音频和图像的任一模态作。 - GPT-4o对音频输入的响应时间平均为320毫秒,与人类对话的响应时间相近。 - 与之前的Voice Mode相比,GPT-4o通过一个神经网络处理所有输入和输出,提高了信息处理的效率和质量。 - 计划在未来几周内向一小群受信任的合作伙伴推出GPT-4o的音频等模态支持。 截至目前(6月6日) GPT-4o 仍然没有开放语音相关 API。 GPT-4o 语音交互强在哪里? GPT-4o 演示环节除了展示出语音交互的丝滑低延迟之外,而且在输出语音上可以很好地遵循指令(如:你可以要求声音更 emotional、更 drama,maximal emotional、语速更快等),相比之前固定的单一机械音频输出,这显著提升了“智能性”,说 4o 颠覆语音交互一点都不为过。 GPT-4o模型 在官方介绍中明确说到: With GPT-4o, we trained a single new model end-to-end across text, vision, and audio, meaning that all inputs and outputs are processed by the same neural network. 输入输出可以是:文本、音频、视觉,也就是说 <输入,输出> 可以有 3x3 种组合,可以:文本对话、文生图、文字到语音、语音到文字、语音到语音等等。 这里引用 AnyGPT 的配图来展示:

纽约时报去年曾报道,OpenAI 耗尽了有用的数据供应,并在耗尽其他资源后讨论了转录 YouTube 视频、播客和有声读物的可行性。 想必 OpenAI 通过精细化的数据清洗、打标来构造了大量的多模态数据集用于模型训练。 GPT-4o 语音交互如何做到低延迟? 端到端建模方式消除了模块之间的衔接延迟(如:speech-> ASR -> LLM -> TTS -> speech)。 GPT 天然FirstToken 低延迟 将全双工交互融入模型、提高打断智能性/灵敏性,GPT 持续接收 InputSpeech,在输出端通过添加多个 Head 的方式用来做 VAD、语意是否结束、是否主动打断等方面的任务,可在恰当位置开始音频理解、生成回复音频等任务。

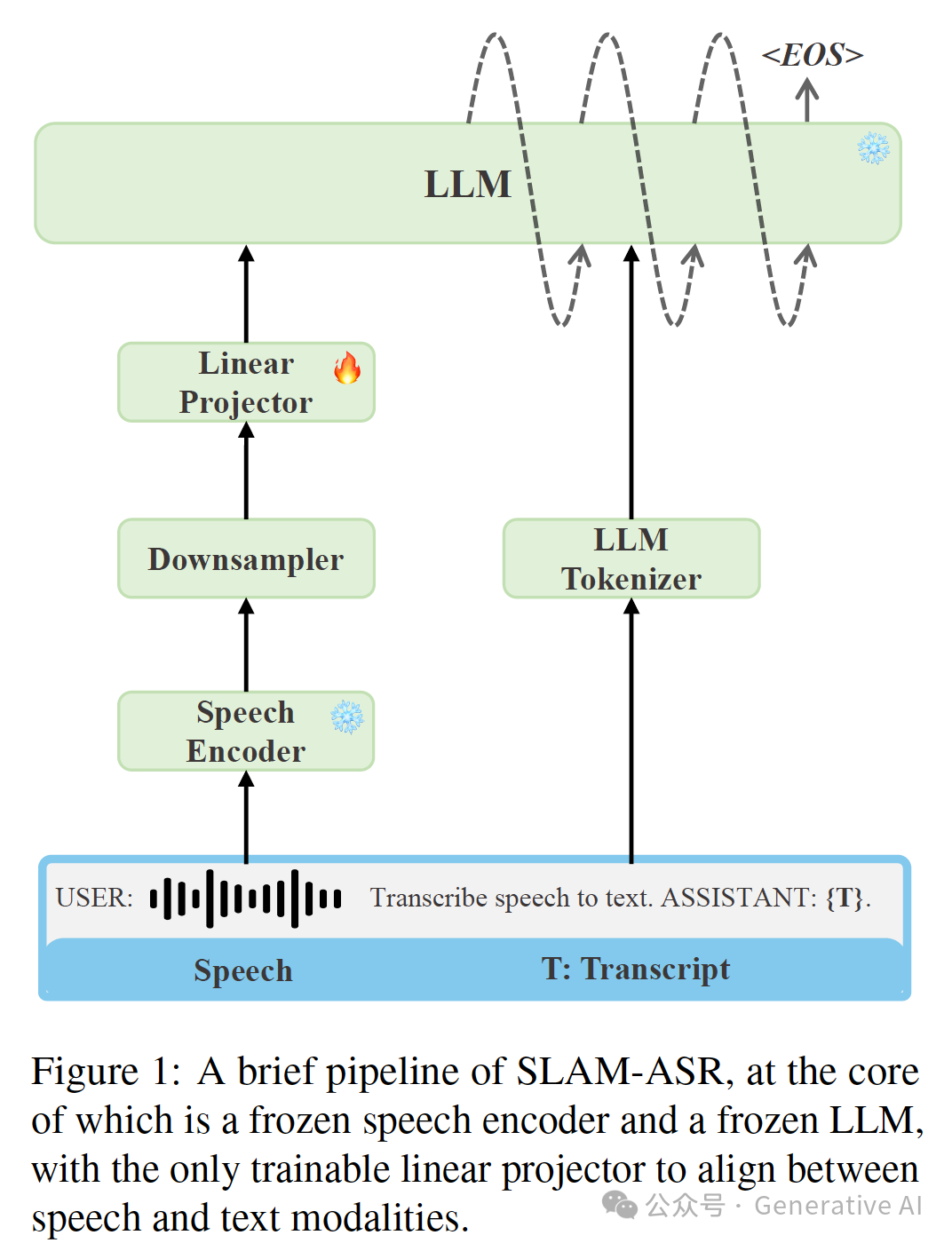

事实上,通过添加 SpeechEncoder + Adaptors 到预训练Llama 模型可以完成许多语音任务,早期研究工作有SpeechGPT,AudioFlamingo,Qwen-Audio 等: 语音识别已经做到了效果极佳的水平。 音频理解 AudioCaptioning 等

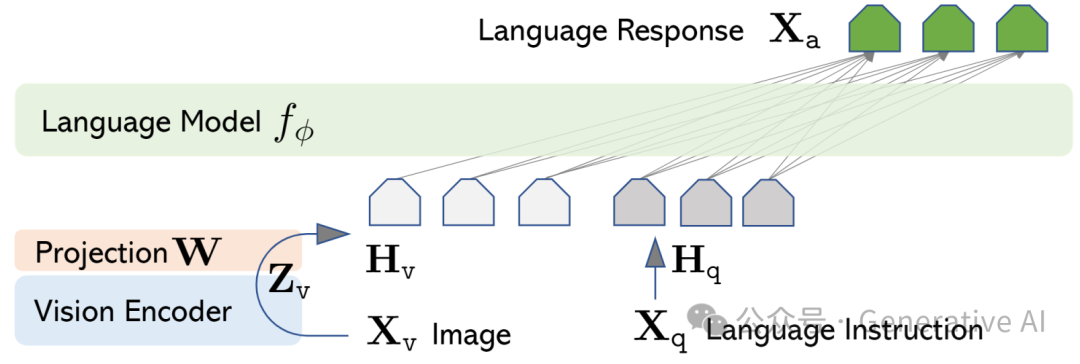

LLaVA(Llama 的 vision 扩展)也是相同的方式:

在 Speech 领域 SSL(SelfSupervisedLearning)和 Codec 都已经被广泛研究,可以用于形成统一的 SpeechTokenizer。 基于大模型的传统语音全双工交互:ASR+智能语音语义打断 ->LLM->TTS,如果做好流式 ASR、流式 LLM、流式 TTS 的话,延迟同样可以做到 1s 上下,缺点是缺少情感识别与无法传递情感/指令到语音生成模块,所以有 Hume.AI 等在补这块空白。 我把 OpenAI demo(链接 https://www.youtube.com/watch?v=DQacCB9tDaw&t=2s)下载下来看,语音交互的延迟大部分在 800-1000ms 之间,远高于所说的平均延迟 320ms,可能 RTC 等部分还没优化到位吧。

GPT-4o 如何做到情感丰富、指令遵循的语音输出? 单纯从 TTS 的发展来说,使用 GPT 做 TTS 任务已经成为主流,也可以自然扩展到 Text Prompted TTS,国内常说的“捏声音”其实是一种简陋版的 PromptTTS。 可以输入给模型:以高兴中透露悲伤的方式生成“这是需要合成的文本”。这需要在数据准备阶段做好AudioCaptioning。 有人将 TorToies-TTS 的“Text -> GPT -> Diffusion -> Vocoder” 奉为至宝,也束缚了手脚。 从 GPT PromptTTS 到端到端多模态语音生成是自然的。 GPT-4o 演示中有表现出,比之前更情绪化更Drama ...,这种指令应该需要在数据准备阶段做一些度量以在训练阶段构建指令体现“更”以及 LongContext 建模。

GPT-4o 之后的语音交互? GPT-4o 拔高了预期,有多少能跟进,又能跟进多少。又有哪些领域/方向是差异化的呢? 大模型成本显著降低,以 GPT-4o 为代表的多模态大模型会覆盖更多的场景,能够更好地推动商业化落地,构建在多模态之上的应用必将在移动端产生巨大能量、乃至辐射到新的硬件载体。 参考:

|