|

1、attention中QKV的含义和作用?

本质计算当前文本中哪个词更重要对输出就应该增加影响力。通过计算每个词和当前文本中其他词之间的相关性(注意力分数矩阵),进而度量出当前词在整个文本更重要进而对输出应该加权影响更大。

进而将当前文本信息的压缩矩阵进行新一轮考虑语义影响的压缩变换,强化文内语义关联 1 原始语义有embedding获得 . 2上下文语义靠Attention获得. 3 低维压缩表达靠LLM最后输出.

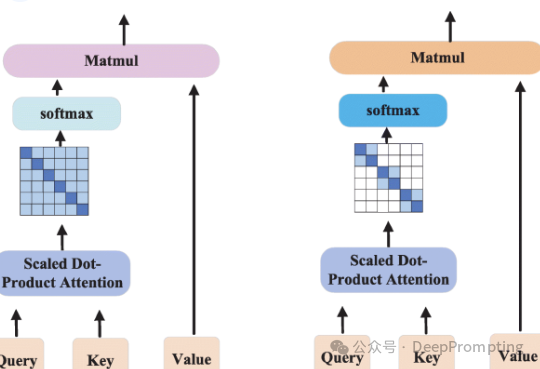

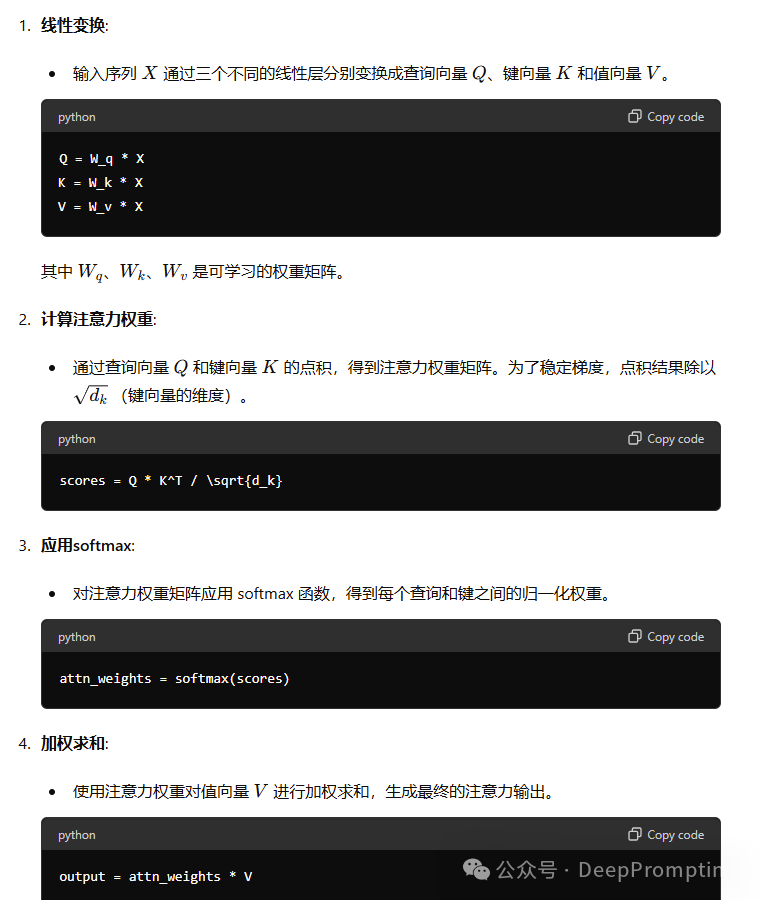

Self-Attention机制简介首先,回顾一下自注意力机制(self-attention)的作用: 自注意力机制的核心在于计算序列X 对自身的注意力权重,即序列中每个时间点与其他时间点之间的相关性(通过相似度来体现)。通过这种方式,我们能够得到一个注意力矩阵。 得到注意力矩阵后,我们将其应用于序列X,从而计算出各个时间点的加权和。这意味着每个时间点的信息都会融合来自其他时间点的信息。 Q、K、V的作用为了实现上述过程,我们需要引入查询(Q)、键(K)和值(V)三个矩阵。它们的作用如下: **查询(Q)和键(K)**用于计算注意力权重:

首先,对序列X 进行线性变换,得到三个新的表示矩阵:查询矩阵Q、键矩阵K 和值矩阵V。 查询矩阵Q 和键矩阵K 用于计算相似度(或相关性)。这种相似度可以通过点积、MLP(多层感知器)等方式计算。 计算相似度后,应用 softmax 函数将其转化为注意力权重矩阵,使得权重和为1,从而确保数据的尺度在后续计算中保持稳定。 **值(V)**用于生成最终的注意力输出: 1. Query (Q)含义: 查询向量。 作用: 查询向量用于在注意力机制中查找相关信息。对于每个查询向量,注意力机制会根据键向量计算注意力权重,从而选择相应的值向量。 2. Key (K)含义: 键向量。 作用: 键向量与查询向量一起用于计算注意力权重。键向量表示所有可能的参考信息的位置或特征,通过与查询向量的点积计算相似度,决定每个值向量的重要性。 3. Value (V)含义: 值向量。 作用: 值向量是实际被选择和加权的对象。通过与注意力权重相结合,值向量生成最终的输出。权重越高的值向量,对最终输出的影响越大。 注意力分数矩阵(attention score matrix)在注意力机制中起着核心作用,决定了如何加权输入序列中的不同元素,以生成最终的注意力输出。它通过衡量查询向量(Query)与键向量(Key)之间的相似度,来计算每个元素的重要性。下面详细解释注意力分数矩阵的作用和计算过程。 注意力分数矩阵的作用衡量相似度:

注意力分数矩阵中的每个元素表示查询向量与键向量之间的相似度。相似度越高,表示查询向量与对应的键向量越相关。 确定权重:

注意力分数矩阵通过softmax函数归一化,转化为权重矩阵。这个权重矩阵用于加权值向量(Value),决定了最终输出中不同输入元素的贡献。 捕捉依赖关系:

通过计算注意力分数矩阵,模型能够捕捉到序列中元素之间的依赖关系,特别是在处理自然语言时,能够识别单词与上下文之间的关系。

报名多模态课程把握前沿趋势,成为多模态工程师:

|