|

"Making AI work well requires architecture/data piping/model fine tuning that virtually no one is doing."要使 AI 正常工作,需要架构/数据管道/模型微调,而几乎没有人这样做。by Norman Vaughan(CEO@BloomTech)

随着本地部署跑的AI项目越来越多,部署环境打架问题愈发严重,经笔者的多次踩坑,给想体验的朋友几点注意事项(面向非开发者):- ⭐️⭐️⭐️优先推荐docker部署(一开始虽然麻烦,搞几个项目后就很轻松了),可惜不是每个项目都提供了docker部署方式

- ⭐️⭐️其次如果是python环境,推荐用conda创建一个新的纯净的指定版本的python环境,版本严格按照项目标定的来,python3.12对很多组件不友好

- ⭐️⭐️同一个python环境下,也推荐为不同项目创建虚拟环境venv

真遇到问题,就随便找个大模型问,大都能解决,至少找到解决思路。

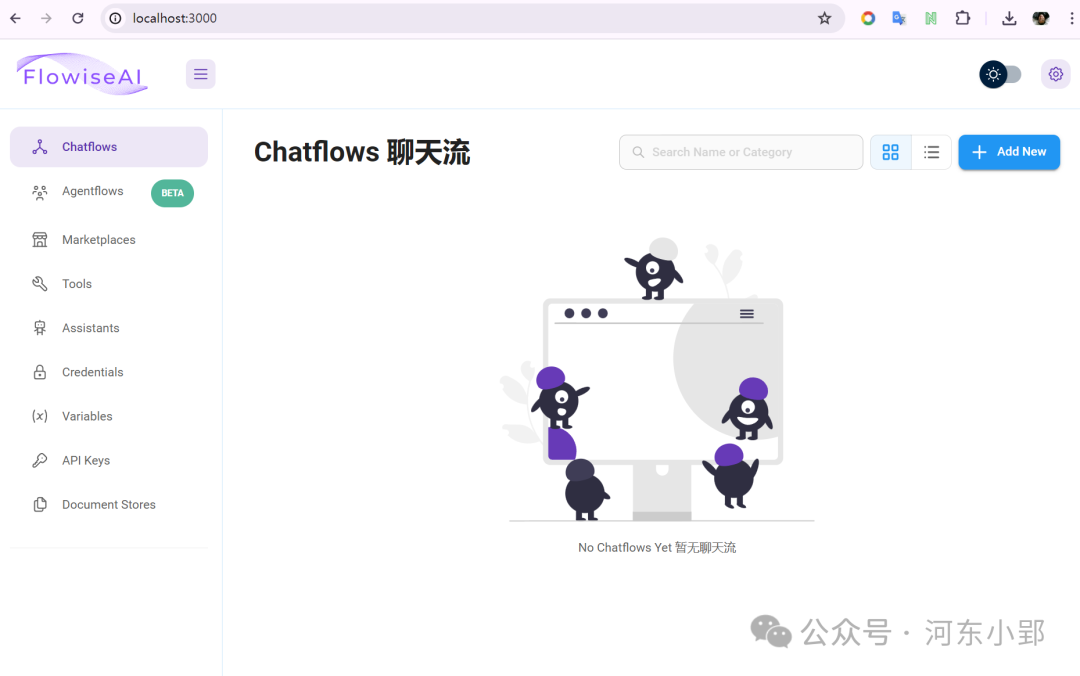

┃AI应用介绍Flowise

Flowise 是一个国内团队开源的一个项目,专为开发基于大型语言模型(LLM)的应用程序而设计。它是一个无代码工具,允许用户轻松构建自定义的LLM流程。Flowise的主要特点是其开放源代码的框架,这使得开发者可以利用社区构建的项目来加速开发进程。- 零代码界面:Flowise提供了一个直观的无代码界面,允许用户通过拖放组件来构建和自定义基于大型语言模型(LLM)的应用程序。

- 开源框架:作为一个开源项目,Flowise的代码对所有人开放,这使得开发者可以自由地查看、修改和贡献代码。

- 社区支持:Flowise受益于社区的贡献,用户和开发者可以共享和改进项目,从而加速开发进程。

- 灵活性:Flowise的设计允许用户根据自己的需求定制LLM流程,无论是简单的文本生成还是复杂的交互式应用。

- 易于使用:即使是缺乏编程经验的用户也可以使用Flowise来构建和部署自己的LLM应用,降低了使用大型语言模型的门槛。

- 可扩展性:Flowise的架构支持扩展,用户可以根据需要添加新的功能和组件,以适应不断变化的需求。

通过这些特性,Flowise旨在让开发者和非开发者都能够更容易地利用大型语言模型的能力,创建各种应用程序。搭建一个最简单的本地聊天工作流,实现根据上下文对话↑

┃部署环境 OS:Windows 11 docker:须有(不用docker部署,则不需要,但就需要另外的环境了,具体参考官方项目介绍) ollama:须有(我这里演示的是基于本地ollama的大模型环境,所以需要。如果是链接外面的LLM API接口,则不需要。) 部署方式:docker部署(官方提供的其他两种部署方式我都尝试过,在我本机环境全部失败,万幸docker部署成功) Github项目地址:https://github.com/FlowiseAI/Flowise

┃部署过程 1.通过CMD命令窗口下载项目仓库到本地(需要爬梯)

gitclonehttps://github.com/FlowiseAI/Flowise.git 2.进入已经下载下来的本地项目仓库(文件夹)

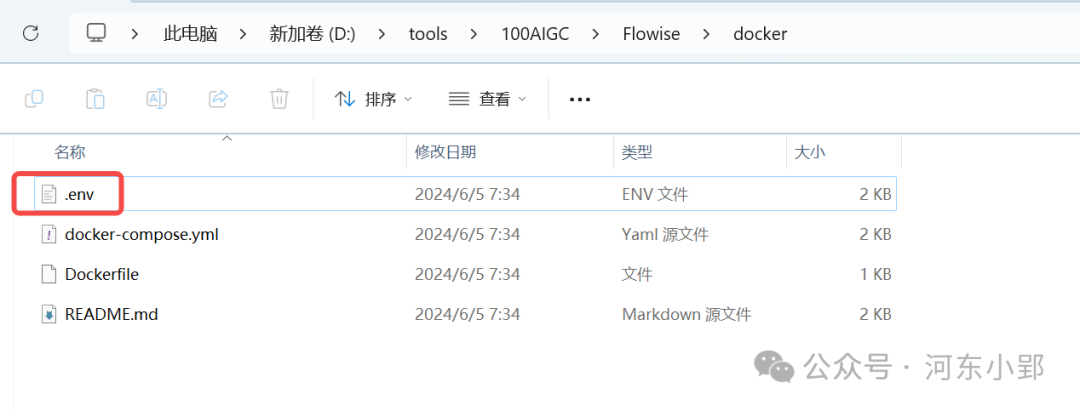

3.修改Flowise项目下docker文件夹中的.evn.example文件,直接把example去掉不修改其他配置也可以,默认有基础配置,也可以。

4.进入项目的docker文件夹

5.通过docker安装 6.安装成功后,打开浏览器,拷贝输入:http://localhost:3000/(使用体验和效果见文中视频)

又多了一种AI体验!Beautiful!

|