|

大型语言模型(LLM)的创建并非一蹴而就。值得注意的是,语言模型的第一个概念始于被称为自然语言处理的基于规则的系统。这些系统遵循预定义的规则,根据文本输入做出决策并推断结论。这些系统依赖于 if-else 语句处理关键字信息并生成预定的输出。想象一下决策树,如果输入包含 X、Y、Z 或无,则输出是预定的响应。例如:如果输入包含关键字“母亲”,则输出“你母亲怎么样?”否则,输出“你能详细说明一下吗?”

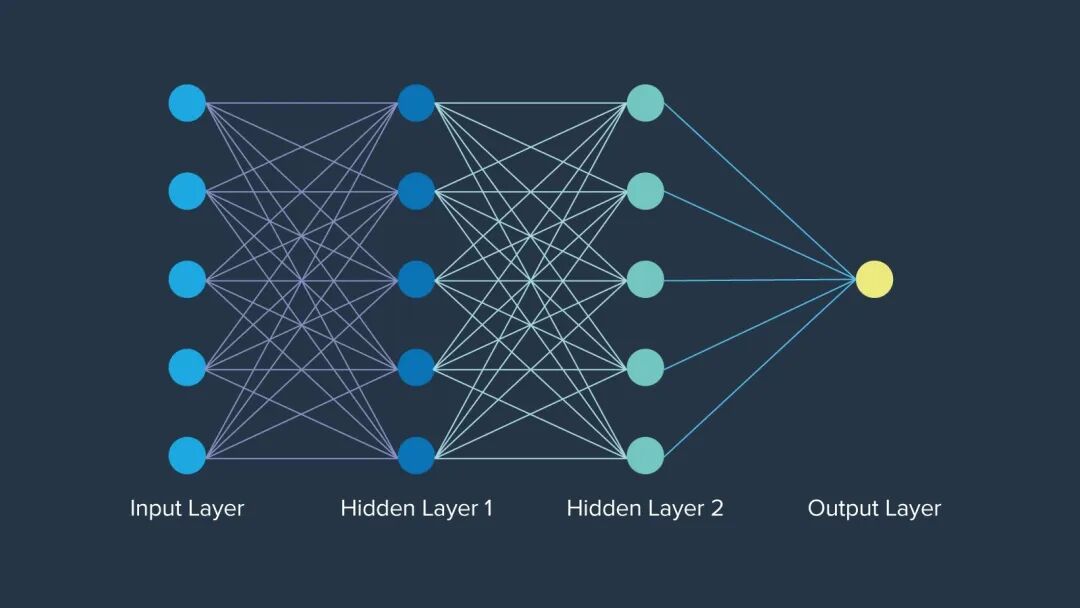

早期最大的进步是神经网络,1943 年,数学家沃伦·麦卡洛克 (Warren McCulloch) 受人类大脑神经元的启发,首次提出了神经网络。神经网络甚至比“人工智能”一词的出现早了大约 12 年。每层的神经元网络都以特定的方式组织,其中每个节点都具有决定其在网络中重要性的权重。最终,神经网络打开了紧闭的大门,为人工智能的永久发展奠定了基础。 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;background-color: rgb(255, 255, 255);">

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;background-color: rgb(255, 255, 255);">

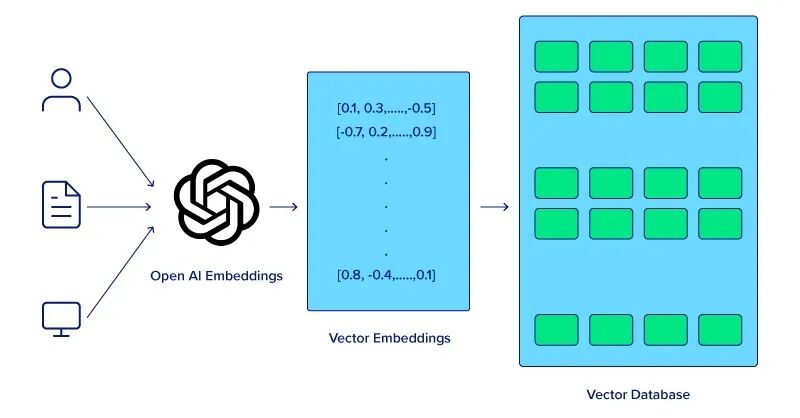

计算机无法像人类一样理解句子中单词的含义。为了提高计算机对语义分析的理解能力,必须首先应用词嵌入技术,该技术允许模型捕捉相邻单词之间的关系,从而提高各种 NLP 任务的性能。然而,需要有一种将词嵌入(word embedding)存储在内存中的方法。

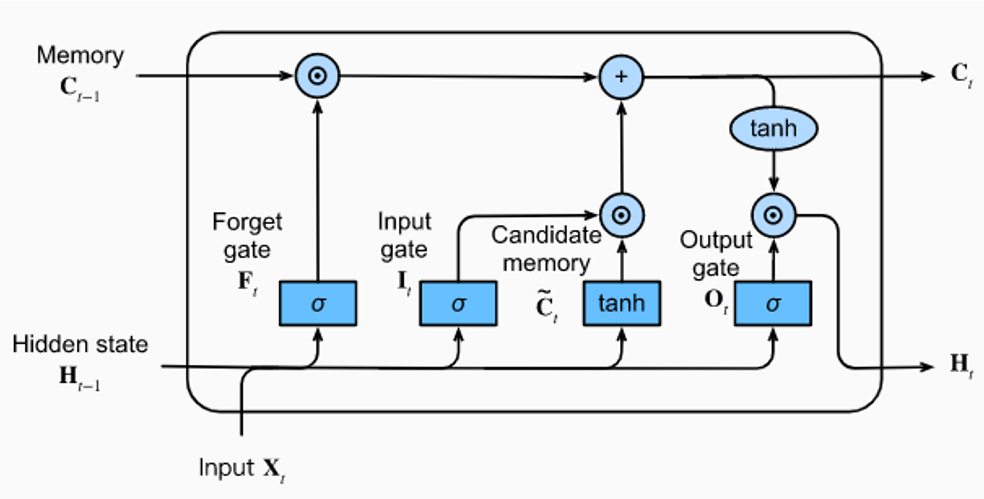

长短期记忆 (LSTM) 和门控循环单元 (GRU) 是神经网络的重大飞跃,能够比传统神经网络更有效地处理顺序数据。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;background-color: rgb(255, 255, 255);">

现代 LLM:注意力 & Transformers

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;outline: 0px;">虽然 LSTM 不再使用,但这些模型为更复杂的语言理解和生成任务铺平了道路,最终催生了 Transformer 模型。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;outline: 0px;">

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;outline: 0px;"> ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;background-color: rgb(255, 255, 255);width: 100%;height: auto;"/> ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;background-color: rgb(255, 255, 255);width: 100%;height: auto;"/>

注意力机制的引入改变了游戏规则,使模型在进行预测时能够专注于输入序列的不同部分。Transformer 模型于 2017 年在开创性的论文《Attention is All You Need》中引入,利用注意力机制同时处理整个序列,大大提高了效率和性能。八位谷歌科学家没有意识到他们的论文会对当今的人工智能产生如此大的影响。

论文发表后,谷歌的 BERT (2018) 被开发出来,并被吹捧为所有 NLP 任务的基线,作为开源模型用于众多项目,使人工智能社区能够构建项目并成长。它在上下文理解方面的天赋、预训练性质和微调选项以及 Transformer 模型的演示为更大的模型奠定了基础。

除了 BERT,OpenAI 还发布了 GPT-1,这是他们的 Transformer 模型的第一个迭代。GPT-1(2018 年)最初有 1.17 亿个参数,随后 GPT-2(2019 年)大幅跃升至 15 亿个参数,而 GPT-3(2020 年)则继续发展,拥有 1750 亿个参数。OpenAI 基于 GPT-3 的开创性聊天机器人 ChatGPT 于两年后的 2022 年 11 月 30 日发布,这标志着一股巨大的热潮,真正实现了对强大 AI 模型的民主化访问。

硬件的进步、算法和方法的改进以及多模态的集成都有助于大型语言模型的进步。随着行业找到有效利用 LLM 的新方法,持续的进步将适应每个应用程序,并最终彻底改变计算格局。

硬件方面的进步

改进 LLM 最简单、最直接的方法是改进模型运行的实际硬件。图形处理单元 (GPU) 等专用硬件的开发显著加速了大型语言模型的训练和推理。具有并行处理能力的 GPU 已成为处理 LLM 所需的大量数据和复杂计算的关键。

OpenAI 使用 NVIDIA GPU 为其 GPT 模型提供支持,并且是首批 NVIDIA DGX 客户之一。他们的关系从人工智能的出现一直延续到人工智能的延续,首席执行官亲手交付了第一台 NVIDIA DGX-1,以及最新的 NVIDIA DGX H200。这些 GPU 集成了大量内存和并行计算,用于训练、部署和推理性能。

算法和架构方面的改进

Transformer 架构因极大促进 LLM 发展而闻名。该架构的引入对于 LLM 的进步至关重要。它能够同时处理整个序列,而不是按顺序处理,这极大地提高了模型效率和性能。

话虽如此,我们对 Transformer 架构以及它如何继续发展大型语言模型仍抱有更多期待。

多模态输入的集成 LLM 的未来在于它们处理多模态输入的能力,集成文本、图像、音频和其他潜在的数据形式,以创建更丰富、更具情境感知的模型。OpenAI 的 CLIP 和 DALL-E 等多模态模型已经展示了结合视觉和文本信息的潜力,从而实现图像生成、字幕等应用。

这些集成使 LLM 能够执行更复杂的任务,例如从文本和视觉提示中理解上下文,这最终使它们更加通用和强大。

进步并未停止,随着 LLM 创建者计划将更多创新技术和系统融入到他们的工作中,进步还在继续。LLM 的改进并非都需要更苛刻的计算或更深入的概念理解。一项关键的改进是开发更小、更用户友好的模型。

虽然这些模型可能无法与 GPT-4 和 LLaMA 3 等“庞大的 LLM”的有效性相匹配,但重要的是要记住,并非所有任务都需要大量复杂的计算。尽管规模庞大,但像 Mixtral 8x7B 和 Mistal 7B 这样的先进小型模型仍然可以提供令人印象深刻的性能。以下是一些有望推动 LLM 开发和改进的关键领域和技术:

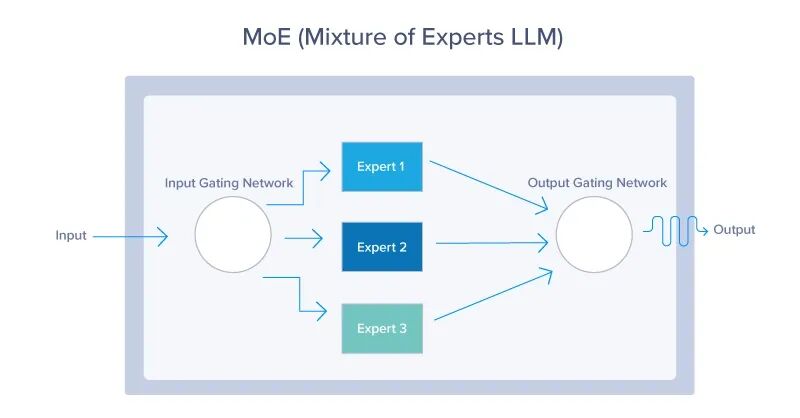

1. 混合专家(MoE)

MoE 模型使用动态路由机制为每个输入仅激活模型参数的子集。这种方法允许模型有效扩展,根据输入上下文激活最相关的“专家”,如下所示。MoE 模型提供了一种在不按比例增加计算成本的情况下扩展 LLM 的方法。通过在任何给定时间仅利用整个模型的一小部分,这些模型可以使用更少的资源,同时仍提供出色的性能。

你可以参考:为什么最新的LLM采用 MoE(混合专家)架构?

2. 检索增强生成 (RAG) 系统

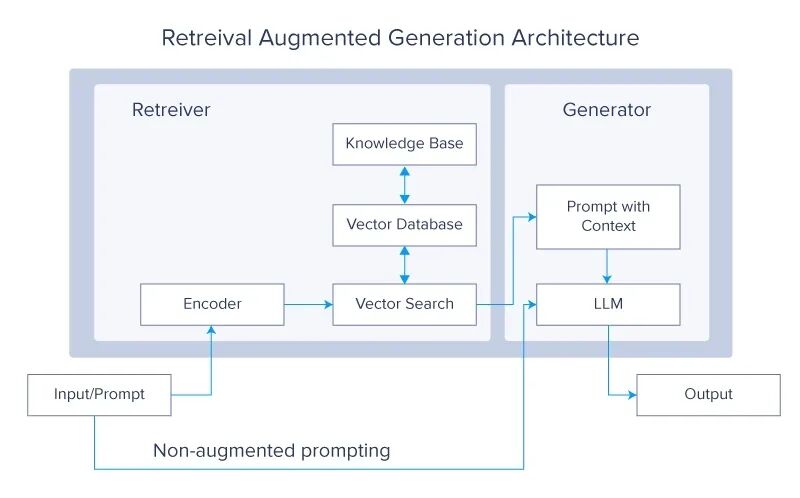

检索增强生成系统是目前 LLM 社区的一个热门话题。这个概念质疑为什么你应该在更多数据上训练 LLM,而你可以简单地让它从外部源检索所需的数据。然后,这些数据用于生成最终答案。

RAG 系统通过在生成过程中从大型外部数据库检索相关信息来增强 LLM。这种集成允许模型访问和整合最新的和特定领域的知识,从而提高其准确性和相关性。将 LLM 的生成能力与检索系统的精确度相结合,可以产生一个强大的混合模型,该模型可以生成高质量的响应,同时随时了解外部数据源的信息。

3. 元学习

元学习(meta learning)方法允许 LLM 学习如何学习,使他们能够以最少的训练快速适应新任务和领域。

元学习的概念取决于几个关键概念,例如: 少样本学习:通过这种方式,LLM 只需几个示例即可理解和执行新任务,从而大大减少了有效学习所需的数据量。这使得它们在处理各种场景时具有高度的通用性和效率。 自监督学习:LLM 使用大量未标记的数据来生成标签和学习表示。这种学习形式允许模型对语言结构和语义进行丰富的理解,然后针对特定应用进行微调。 强化学习:在这种方法中,LLM 通过与环境交互并以奖励或惩罚的形式接收反馈来学习。这有助于模型优化其行为并随着时间的推移改进决策过程。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;background-color: rgb(255, 255, 255);">文章来源:PyTorch研习社ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 14px;letter-spacing: 0.6px;text-wrap: wrap;background-color: rgb(255, 255, 255);">

LLM 是现代技术的奇迹。它们功能复杂、规模庞大、进步具有开创性。在本文中,我们探讨了这些非凡进步的未来潜力。从它们在人工智能领域的早期开始,我们还深入研究了神经网络和注意力机制等关键创新。

然后,我们研究了增强这些模型的多种策略,包括硬件的进步、内部机制的改进以及新架构的开发。到目前为止,我们希望你已经对 LLM 及其在不久的将来的光明发展轨迹有了更清晰、更全面的了解。

|