|

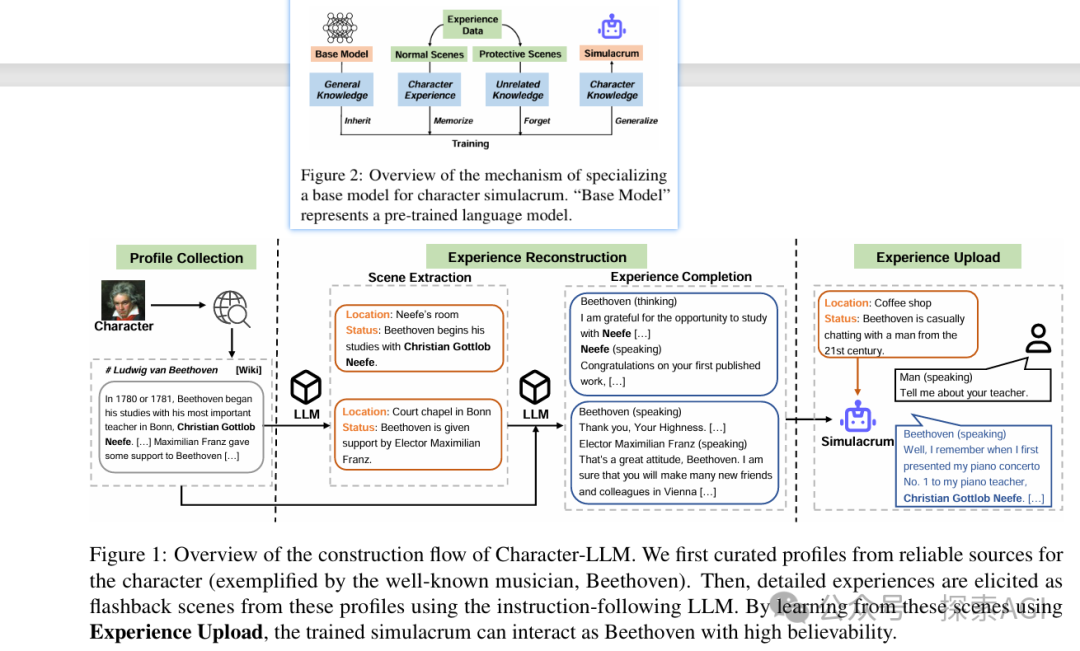

今天我们来聊聊LLM Agent背后的记忆机制,特别是记忆的形式。你可能听说过,LLM就像一个厉害的不得了的聊天助手,它可以记住之前的对话内容,还能学习新知识。但你知道它是怎么做到的吗?这就要说到记忆的形式了。 记忆可以是文本形式的,就像我们平时说话那样,直接明了。这种方式的好处是易于理解和实现,而且读写速度都很快。但是,如果记忆太长,就会占用很多空间,影响处理速度。想象一下,如果你要记住一整本书的内容,那得多费劲啊! 文本形式的记忆可以进一步细分为几种类型: 至于用哪种类型,各有利弊,比如存储完整的交互信息可以保留所有细节,但可能会因为信息量太大而影响效率;而只存储最近的交互信息则可以快速访问,但可能会遗漏一些重要的历史信息。 下图为MemGPT研究中的示意图,分别体现出了短期和召回记忆;至于完整的交互记忆,大家经常使用的ReAct就是,在Qwen-Agent中,通过chatml特有的多轮的格式<im_start> <im_end>进行分割历史的会话,最后一轮才加上ReAct的prompt。 另一种形式是参数形式,这种方式更高级一些。它不是直接存储文字,而是把记忆转换成模型参数,就像是把知识压缩成精华。这样做的好处是不会受到文本长度的限制,而且存储效率更高。但是,这种形式的记忆在写入时可能需要更多的计算,而且解释起来也不如文本形式直观。 参数形式的记忆则涉及到一些更复杂的技术,比如fine-tuning和editing。微调可以帮助模型快速学习特定领域的知识,而知识编辑则可以精确地更新或删除某些记忆,避免影响其他无关的知识。 经典的Character-LLM: A Trainable Agent for Role-Playing,就是使用的微调的方式,如下图: 文本形式的记忆和参数形式的记忆同样也是各有千秋,它们适合不同的应用场景。比如,如果你需要快速回忆最近的对话,文本形式可能更合适;而如果你需要存储大量的知识,或者需要一个稳定可靠的知识库,参数形式可能更有优势。 同样这里提供一份经典的Agent系统,他们关于记忆的形式的汇总表格如下: |