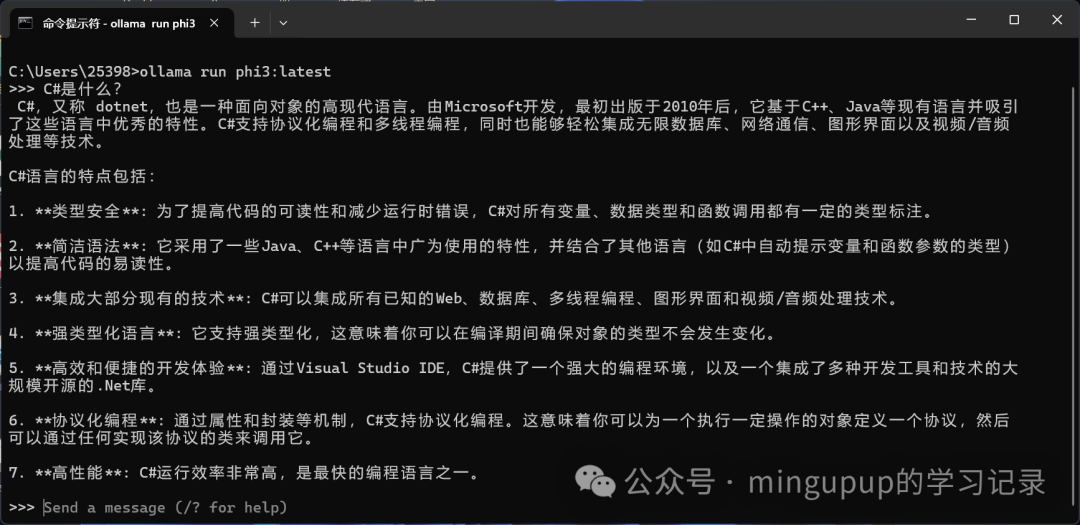

Ollama介绍用于启动并运行大型语言模型。  GitHub地址:https://github.com/ollama/ollama 官方网站:https://ollama.com/ 实践根据README的指引,安装对应系统的Ollama。 由于我的电脑比较旧了,配置如下:  所以就选择一个参数小一点的大模型,我选择的是phi3 3.8b的版本。  在控制台输入: ollamarunphi3:latest

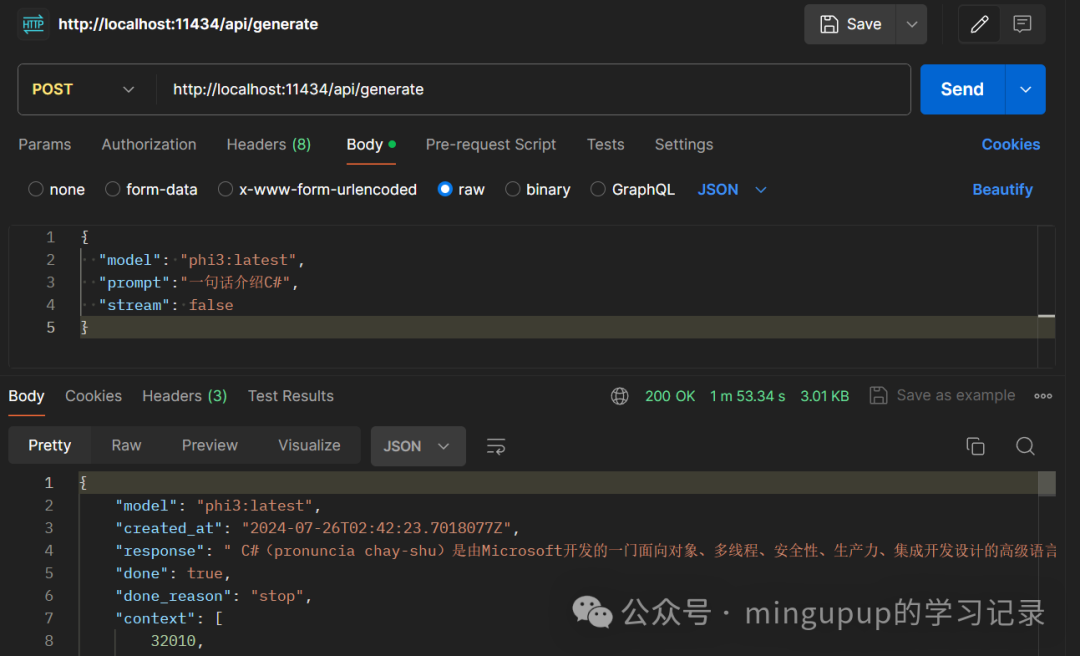

即可。 没下载这个模型会自动下载,下载好了就可以开始对话。  对于开发者而言,还可以通过Ollama提供的接口来接入自己的应用:  3.8b参数的大模型在我这台电脑上就已经跑的很慢了,尝鲜是可以的,真要使用如果没有离线的需求并且没有显卡还是使用云平台比较好,现在也有很多免费的模型使用了,而且收费的话个人使用也花不了多少钱。如果有显卡资源并且有离线使用的需求,可以考虑使用Ollama本地离线运行大模型。

|