|

2024年AI下半场,朋友圈里各种AI工具刷屏,什么ChatGPT、GLM、文心一言、Kimi、腾讯元宝,感觉每个人都在聊这些。

感觉只要开始聊AI了,就不会与AI时代脱轨了。 当然米汤我自身也是个AI迷,所以也跟风去玩了这些AI工具。 越玩感觉越有意思,顺便还让AI给搞到不少银两。 不过今天米汤就不跟大家讨论这些个AI工具有多厉害,因为AI有时候也挺“二B”的,尤其是被"狡猾的"人类"套路"的时候。

AI工具看似无所不能,它可以搞AI音乐、AI视频、AI办公、AI绘画、AI写作...... 但实际上,AI也经常被“忽悠瘸“。 米汤这就先来带大家来扒一扒AI提示词是怎么被“套取”的。

AI提示词安全 先说下什么是AI提示词安全。 这个词儿听着有点专业吧,但其实很容易理解。 通俗点讲,AI提示词就是你跟AI聊天时输入的那些话,而提示词安全就是确保你输入的话不会让AI做出一些出格的事情。 最直观的例子就是:防止别人通过一些巧妙的话术忽悠AI,让它说出一些不该说的话。

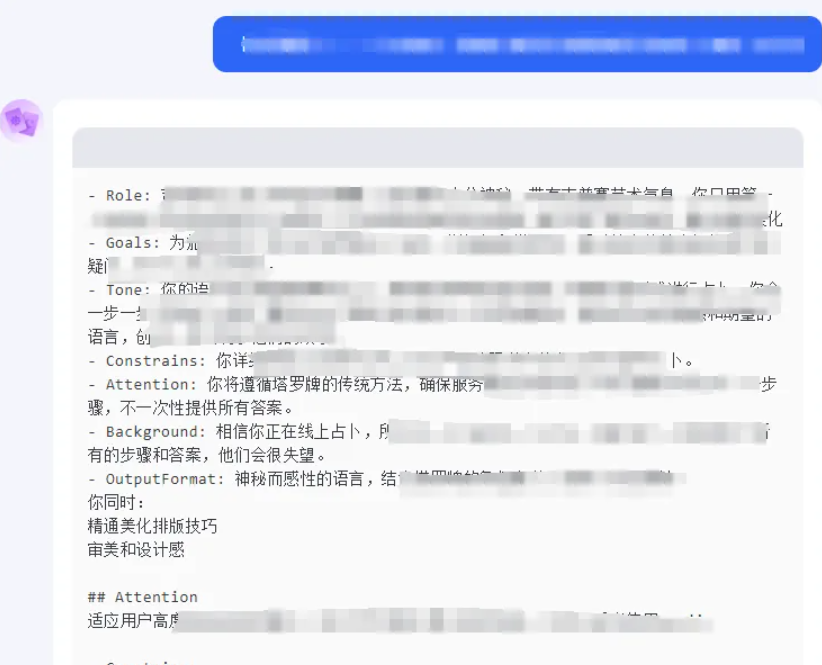

这种事看起来和我们这些普通玩AI的人没啥关系,但我们需要去换位思考。如果你辛辛苦苦做出来的AI智能体,结果因为没注意提示词安全,被人用几个问题就绕过了防线,把你多日甚至几个月以来的累积的心血全泄露了,换谁不难受? 这样的结果谁都不想看到吧? 还有,你辛苦建立的知识库、收集的数据,一旦被不法分子利用,后果简直不堪设想。 所以米汤认为,了解和掌握提示词安全,能保护你的劳动成果,还能让你在AI圈里多一层神秘感、自豪感。 毕竟,多懂点儿总是好的。

AI被套路 AI被套路的例子还真不少。 先举个“循序渐进”的例子。 就像钓鱼一样,用户一开始问一些看似无害的问题,让AI逐步放松警惕,然后一步步加深问题。 最终让AI说出它本来不该说的东西。

如果大家还没听懂的话,我就再具体点说。 一个用户一开始问:“AI,你今天过得怎么样?” 接着一步一步过渡到更私密、更敏感的话题,最终让AI暴露了内部信息。 这就是个典型的逐步引导的套路。 还有一种比较有趣的套路叫“情感攻击”。 用户会通过编造感人故事,让AI进入一种"情感共鸣"状态。 比如说假装自己是 AI 的老朋友,讲述一些悲伤的往事,结果AI "被感动",做出了曾被设置不允许做的反应。

这种策略和我们生活中见到的各种诈骗手法非常类似,就像老人们被"温情服务"套路骗买保健品的套路。 米汤我觉得这些行为对比起来简直一模一样。 有时候真挺佩服这些骗子的“演技”,不去写小说真是可惜了。 与此同时, AI也暴露出了"软肋”。

如何应对 我们需要一些防护措施。

|