|

你是否也曾好奇,那些能自主执行任务、调用工具的 AI “agent” 是如何运作的?2024 年,我们见证了 AI 技术从简单的聊天机器人向更复杂的智能体转变。但当我们深入研究这些 agent 时,会发现它们背后的技术栈与我们熟悉的 LLM 技术栈截然不同。

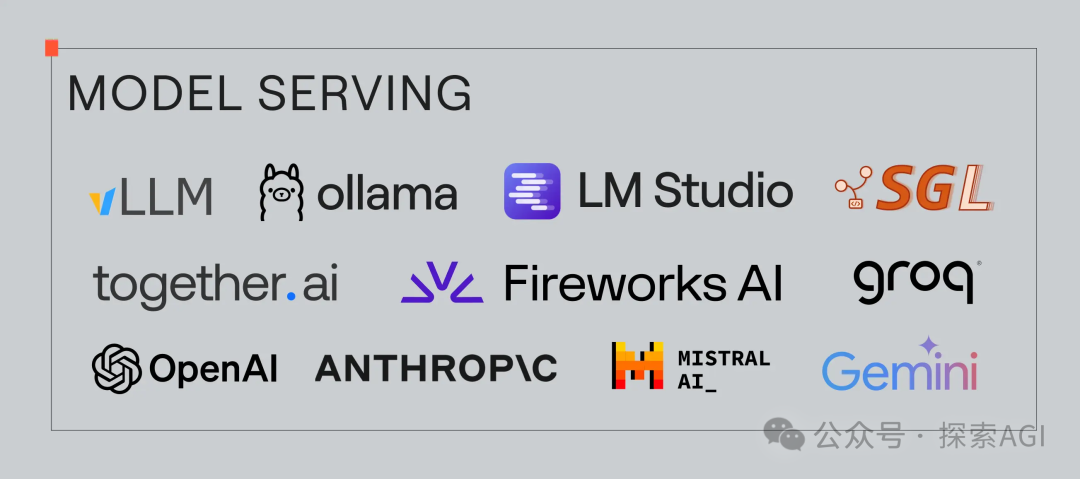

今天,我们就来揭开 AI agent 技术的神秘面纱,为你梳理这个快速发展的领域,让你不再雾里看花。 从 LLM 到 Agent:一场深刻的进化在 2022 和 2023 年,我们见证了 LLM 框架和 SDK 的爆发,如 LangChain 和 LlamaIndex。与此同时,LLM 的使用也变得更加方便,无论是通过 API 调用还是自行部署(比如 vLLM 和 Ollama)。 然而,到了 2024 年,大家的目光开始转向更高级的 AI “agent”。这个概念虽然早在 AI 领域就存在,但在 ChatGPT 时代,它有了新的内涵:能够自主行动、执行任务,并与外部工具交互的 LLM。 这种转变意味着,我们需要一套全新的技术栈来支撑 agent 的发展。 agent 技术栈:核心差异在哪里?Agent 不仅仅是一个会聊天的大模型,它们更像是具备一定自主性的智能体。它们需要管理自己的状态(例如,对话历史和记忆)、调用各种工具,并且安全执行。这使得 agent 的技术栈和传统的 LLM 技术栈有很大的不同。 让我们从底层到顶层,逐一剖析 agent 技术栈的关键组成部分:  1. 模型服务:AI 的大脑  - 核心:LLM。这是 AI agent 的核心动力。

- 服务方式:通过推理引擎提供服务,通常是付费/自己部署 API。

- 闭源模型:OpenAI 和 Anthropic 领跑。

- 开源模型:Together.AI、Fireworks 和 Groq 等提供商开始崭露头角,提供基于 Llama 3 等模型的服务。

- 本地部署:vLLM 成为生产级 GPU 服务的主流选择,而 Ollama 和 LM Studio 则深受个人爱好者的喜爱。

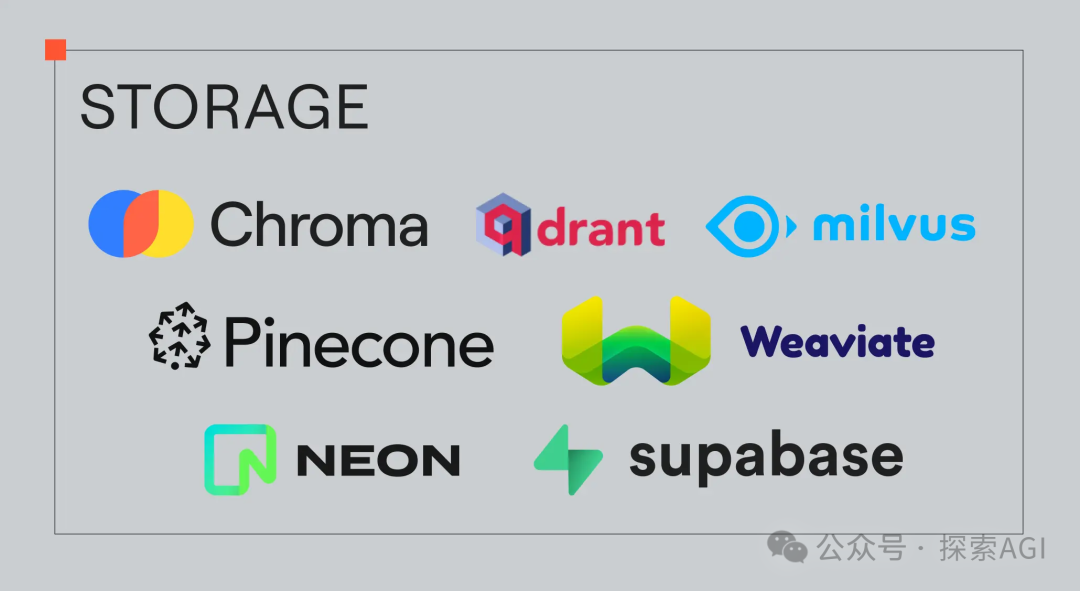

2. 存储:记忆的基石  - 向量数据库:Chroma、Weaviate、Pinecone、Qdrant 和 Milvus 等用于存储 agent 的“外部记忆”,应对大容量数据。

- 传统数据库:Postgres 通过 pgvector 扩展也开始支持向量搜索。

- 为何重要?Agent 是有状态的,需要长期存储和检索信息。

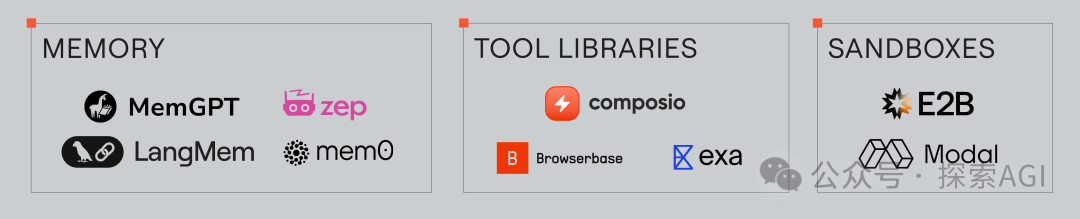

3. 工具与库:能力的扩展  - 核心:使 agent 能够执行各种任务的“工具”(或“函数”)。

- 调用方式:通过 LLM 生成的结构化输出(例如,JSON 对象)指定要调用的函数和参数。

- 安全执行:使用沙箱(如 Modal 和 E2B)来确保工具执行的安全性。

- 专用工具:Browserbase(网页浏览)、Exa(网页搜索)等。

- 为何重要?工具扩展了 agent 的能力边界,让它们能够完成更复杂的任务。

4. Agent 框架:编排智能的指挥中心  - 核心:负责编排 LLM 调用,管理 agent 状态。

- 状态管理:如何保存和加载 agent 状态,例如对话历史和记忆。

- 上下文窗口:如何将状态信息“编译”到 LLM 的上下文窗口中。

- 跨 agent 通信:如何实现多 agent 之间的协作。

- 内存管理:如何应对 LLM 有限的上下文窗口,管理长期记忆。

- 开源模型支持:如何让 agent 更好地利用开源模型。

- 热门框架:Llama Index、CrewAI、AutoGen、Letta、LangGraph 等。

- 为何重要?框架决定了 agent 的运行方式和效率。

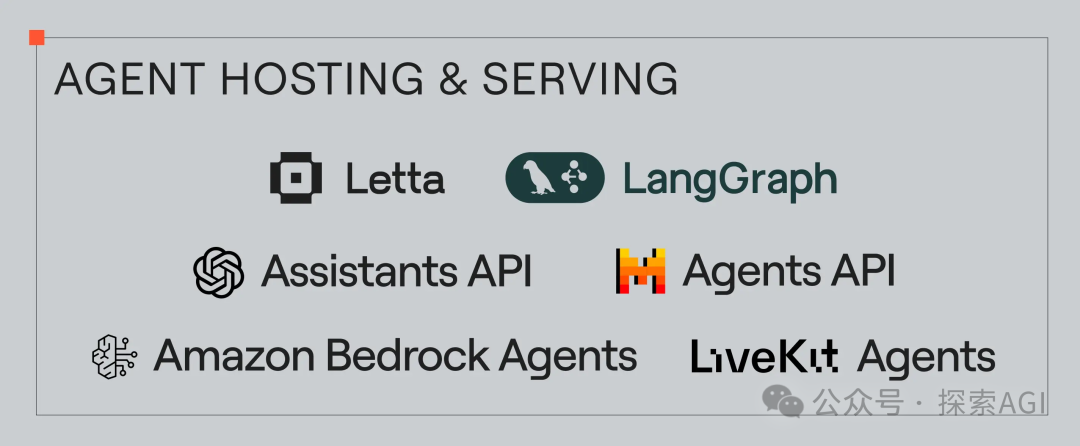

5. Agent 托管与服务:未来趋势  - 核心:将 agent 作为服务进行部署,通过 API 进行访问。

- 当前痛点:状态管理、安全工具执行以及规模化部署是难题。

- 未来展望:未来将会出现标准化的 Agents API,让 agent 的部署更加便捷。

- 为何重要?这将使 agent 从原型走向真正的应用。

未来已来:agent 技术栈正在高速发展Agent 技术栈整体仍然非常年轻,但它正在以惊人的速度发展。未来的 agent 将会更加智能、更加自主,它们将会在各行各业发挥重要的作用。 |