DeepSeek 凌晨又搞事情了。

这一次,不是发布新的 V4 模型,也不是开源某个 100B 的权重,而是直接对 Transformer 的底层架构“动刀”了。

DeepSeek 开源了名为Engram的新架构,并附带了一篇信息量极大的论文《Conditional Memory via Scalable Lookup》。

简单来说,他们给 Transformer 加了一个“查字典”的能力。

长期以来,我们的大模型都在“死记硬背”。无论是历史知识还是固定搭配,模型都需要消耗珍贵的计算资源(Attention 和 FFN)去“算”出来。

DeepSeek 提出的问题很犀利:既然有些东西是死的(比如“中华人民共和国”这个固定词组),为什么非要用神经网络去“推理”它?直接查表不行吗?

于是,Engram 诞生了。这可能预示着大模型架构的一个新方向:从“纯计算”走向“计算+记忆”的混合体。

想象一下,你正在做一道复杂的数学题。但是,你的大脑不仅要处理逻辑运算,还要同时在脑子里默写一遍《新华字典》。

这就是现在 Transformer 的处境。

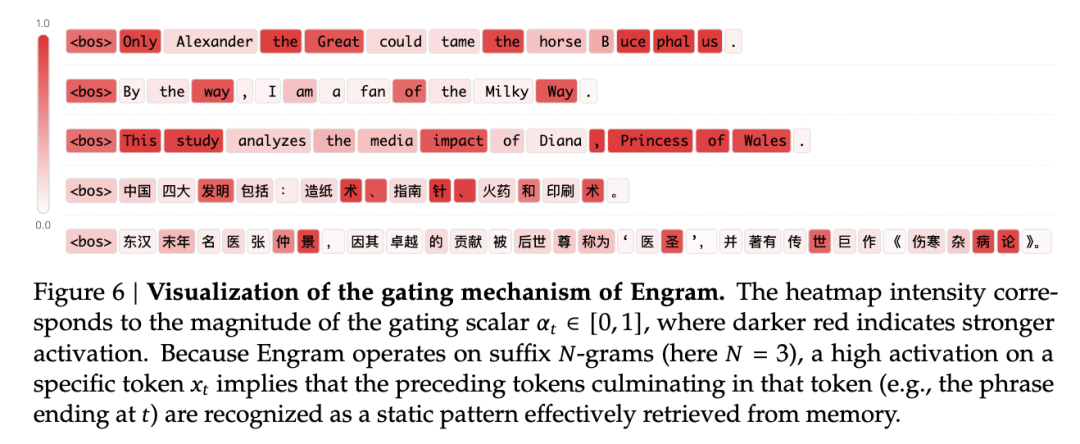

论文中举了一个非常直观的例子:当模型需要输出 "Diana, Princess of Wales"(戴安娜王妃)这个实体时,它需要消耗整整 6 层神经网络:

- 2. 再识别出 Princess of Wales 是个头衔;

这简直是“杀鸡用牛刀”。对于这种固定的、静态的知识,动用昂贵的 GPU 算力去层层推导,极其浪费。

DeepSeek 的思路是:把“死记硬背”的工作交给“字典”(Engram),把“大脑”(Transformer)腾出来处理真正的逻辑推理。

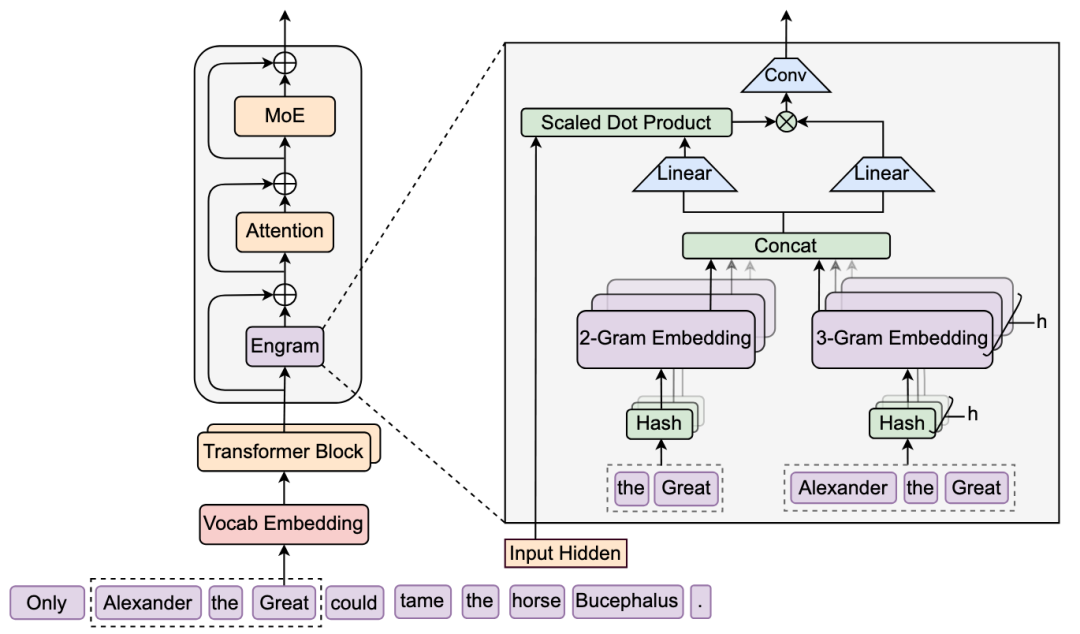

Engram 的核心机制其实非常复古——它复活了经典的N-gram(N元组)概念,但用了现代化的手段。

它的工作原理可以简化为三步:

- 1.识别:当你输入一段文本,模型会自动识别出其中的固定搭配(比如“人工智能”、“深度求索”)。

- 2.查表:直接在一个巨大的向量表中,通过哈希(Hash)算法找到这些词组对应的向量。这个过程是的,速度极快,不消耗什么计算量。

- 3.融合:把查出来的向量,通过一个门控机制(Gating)“喂”给神经网络。

这就好比考试的时候,允许模型带一本“小抄”。遇到死记硬背的知识点,直接看小抄;遇到需要分析的题目,再动脑子。

你可能会觉得:加个字典,无非就是让模型背书更厉害呗?

DeepSeek 的论文结果让人大吃一惊:Engram 不仅提升了知识类任务的效果,还大幅提升了推理能力!

在同等参数量(27B)和同等计算量(Iso-FLOPs)的对比下,DeepSeek 比较了标准的 MoE(混合专家模型)和 Engram 模型:

- •知识更渊博:MMLU(知识问答)提升了3.4分,CMMLU 提升了4.0分。这在预料之中。

- •逻辑更强了:这是最反直觉的。BBH(综合推理)提升了5.0分,ARC-Challenge(挑战性推理)提升了3.7分,就连数学(MATH)和代码(HumanEval)都有显著提升。

为什么查字典能提高数学成绩?

论文给出了极具洞察力的解释:LogitLens 分析显示,Engram 让模型在更浅的层数就完成了“特征组合”。

也就是说,因为不需要在底层网络里浪费时间去拼凑“单词”和“短语”,深层网络的“脑容量”被释放了出来,可以专注于处理更复杂的逻辑和长距离的依赖关系。

这也解释了为什么 Engram 在长上下文(Long Context)任务上表现极佳——把局部依赖交给了字典,Attention 就可以专心看全局了。

DeepSeek 的工程能力一向是业界的标杆,这次也不例外。

大模型最贵的资源是什么?是 GPU 的显存(HBM)。如果我们要存一个巨大的 N-gram 字典,显存爆了怎么办?

Engram 的设计非常精妙,它是确定性查表(Deterministic Lookup)。

与 MoE 这种“走到哪步算哪步”的动态路由不同,Engram 在拿到输入文本的一瞬间,就知道需要查哪些表。

这就意味着:我们可以把这个巨大的字典存放在便宜的 CPU 内存(DRAM)里!

当 GPU 还在计算第 1 层网络的时候,系统就已经通过 PCIe 带宽,把第 10 层需要用到的“字典条目”从 CPU 内存预取(Prefetch)过来了。

DeepSeek 实测:即使外挂一个100B(一千亿)参数的超大字典,对推理速度的影响也微乎其微(小于 3%)。

这是什么概念?这意味着未来的模型,可以用极低的成本,通过堆 CPU 内存来无限扩展“知识库”,而不需要堆昂贵的 H100 显卡。

在 Github 已开源