ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: normal;text-wrap: wrap;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: normal;text-wrap: wrap;text-align: center;">

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: normal;text-wrap: wrap;">将大型文档拆分为较小的部分是影响检索增强生成 (RAG) 系统性能的一个基本但关键的因素。用于开发 RAG 系统的框架通常提供多种选项可供选择。在本文中,我想介绍一种新的选项,该选项尝试借助句子嵌入来识别主题的变化,以便在这些点进行细分。这为 RAG 系统的嵌入步骤奠定了基础,可以为编码主题而不是多个主题混合的文本部分找到向量。我们在主题建模的背景下的一篇论文中介绍了这种方法,但它也适用于 RAG 系统。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: normal;text-wrap: wrap;">RAG 系统ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: normal;text-wrap: wrap;">检索增强生成 (RAG) 系统是一种机器学习模型,它结合了基于检索的方法和基于生成的方法,以提高其输出的质量和相关性。它首先根据输入查询从大型数据集中检索相关文档或信息。然后,它使用生成模型(例如基于 Transformer 的语言模型)来使用检索到的信息生成连贯且上下文合适的响应或内容。这种混合方法增强了模型提供准确和信息丰富的响应的能力,尤其是在复杂或知识密集型任务中。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: normal;text-wrap: wrap;">其他拆分选项ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: normal;text-wrap: wrap;">在我们更详细地研究该过程之前,我想介绍一些用于文档拆分的其他标准选项。我将使用广泛使用的 Langchain 框架来展示示例。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: normal;text-wrap: wrap;">LangChain 是一个强大的框架,旨在协助完成各种自然语言处理 (NLP) 任务,主要侧重于应用大型语言模型。其基本功能之一是文档拆分,它使用户能够将大型文档分解为更小、更易于管理的块。以下是 LangChain 中文档拆分的关键功能和示例:ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: normal;text-wrap: wrap;">LangChain 中文档拆分的关键功能

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: normal;text-wrap: wrap;" class="list-paddingleft-1">递归字符文本拆分器:此方法通过基于字符递归划分文本来拆分文档,确保每个块都低于指定的长度。这对于具有自然段落或句子中断的文档特别有用。 标记拆分器:此方法使用标记拆分文档。在处理具有标记限制的语言模型时,这很有用,可确保每个块都符合模型的约束。 句子拆分器:此方法在句子边界处拆分文档。它非常适合维护文本的上下文完整性,因为句子通常代表完整的思想。 正则表达式拆分器:此方法使用正则表达式来定义自定义拆分点。它提供了最高的灵活性,允许用户根据特定于其用例的模式拆分文档。 Markdown 拆分器:此方法专为 Markdown 文档量身定制。它根据 Markdown 特定的元素(如标题、列表和代码块)拆分文本。 LangChain 中文档拆分的示例1. 递归字符文本拆分器from langchain.text_splitter import RecursiveCharacterTextSplitter

text = "Your long document text goes here..."

splitter = RecursiveCharacterTextSplitter(chunk_size=1000, chunk_overlap=50)

chunks = splitter.split_text(text)

for chunk in chunks:

print(chunk)

2. 标记拆分器from langchain.text_splitter import TokenSplitter

text = "Your long document text goes here..."

splitter = TokenSplitter(max_tokens=512)

chunks = splitter.split_text(text)

for chunk in chunks:

print(chunk)

3. 句子拆分器from langchain.text_splitter import SentenceSplitter

text = "Your long document text goes here..."

splitter = SentenceSplitter(max_length=5)

chunks = splitter.split_text(text)

for chunk in chunks:

print(chunk)

4. 正则表达式拆分器from langchain.text_splitter import RegexSplitter

text = "Your long document text goes here..."

splitter = RegexSplitter(pattern=r'\n\n+')

chunks = splitter.split_text(text)

for chunk in chunks:

print(chunk)

5. Markdown 拆分器from langchain.text_splitter import MarkdownSplitter

text = "Your long markdown document goes here..."

splitter = MarkdownSplitter()

chunks = splitter.split_text(text)

for chunk in chunks:

print(chunk)

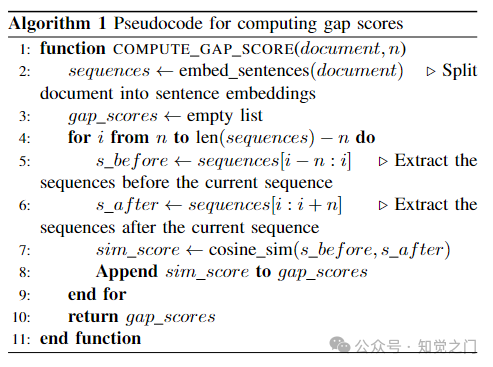

介绍一种新方法在数字内容分析中,将大型文档分割成连贯的基于主题的部分是一项重大挑战。上述传统方法通常无法准确检测主题发生变化的微妙 juncture。在人工智能、计算机、数据科学和应用国际会议 (ACDSA 2024) 上发表的一篇论文中,我们提出了一种解决此问题的创新方法。 核心挑战大型文档(例如学术论文、冗长的报告和详细的文章)非常复杂,包含多个主题。传统的分割技术,从简单的基于规则的方法到高级机器学习算法,都难以识别主题转换的精确点。这些方法通常会遗漏微妙的过渡或错误地识别它们,从而导致片段化或重叠的部分。 我们的方法利用句子嵌入的力量来增强分割过程。该方法利用 Sentence-BERT (SBERT) 生成单个句子的嵌入,从而定量地测量它们的相似性。随着主题的变化,这些嵌入反映了向量空间的变化,表明了潜在的主题转换。 查看该方法的每个步骤:1. 使用句子嵌入生成嵌入: 相似度计算: 2. 计算间隔分数定义参数 n: 计算余弦相似度:

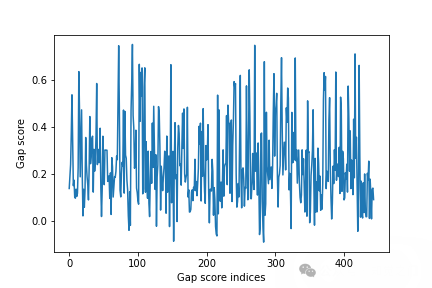

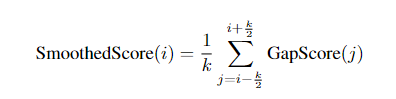

间隔分数示例 / 图片由作者提供 3. 平滑处理解决噪声问题: 选择窗口大小 k:

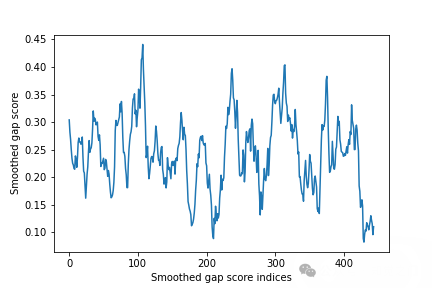

平滑处理后的间隔分数示例 / 图片由作者提供 4. 边界检测识别局部最小值: 设置阈值 c:

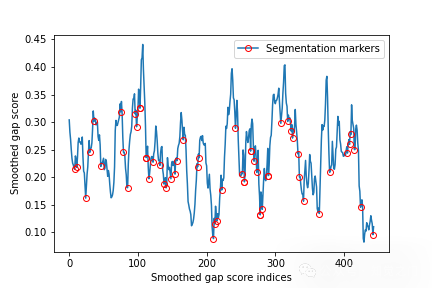

分割示例 / 图片由作者提供 5. 聚类段落处理重复的主题: 减少冗余: 算法伪代码间隔分数计算:

间隔分数平滑:

边界检测: 未来方向该研究概述了进一步增强该方法的几个研究方向: 自动参数优化:使用机器学习技术动态调整参数。 更广泛的数据集试验:在多样化的大型数据集上测试该方法。 实时分割:探索动态文档的实时应用。 模型改进:集成更新的 Transformer 模型。 多语言分割:使用多语言 SBERT 将该方法应用于不同的语言。 层次分割:研究多级分割,以进行详细的文档分析。 用户界面开发:创建交互式工具,以便更轻松地调整分割结果。 与 NLP 任务的集成:将算法与其他自然语言处理任务相结合。

结论我们的方法提出了一种复杂的文档分割方法,将传统原理与尖端的句子嵌入相结合。通过利用 SBERT 以及先进的平滑和聚类技术,该流程为大型文档中的准确主题建模提供了一种强大而有效的解决方案。

|