|

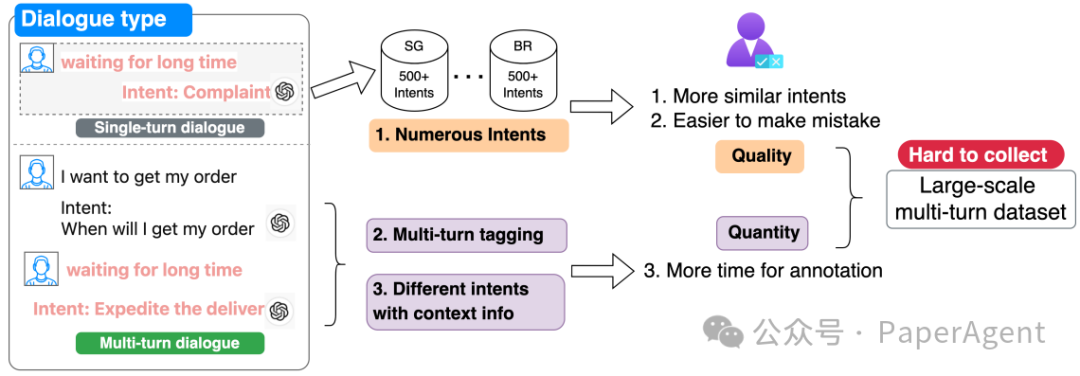

随着大型语言模型(LLMs)在文本分类任务中取得显著成就,研究者开始探索上下文学习(in-context learning)在单轮分类任务中的应用。然而,这些研究主要集中在单一语言和单轮分类任务上。多轮意图分类任务由于对话上下文的复杂性和不断演变的特点而具有挑战性,尤其是在跨多种语言的聊天机器人交互中。此外,多轮数据集的收集和注释成本高昂,且在现实世界中难以获得。 多轮意图分类数据集的注释挑战

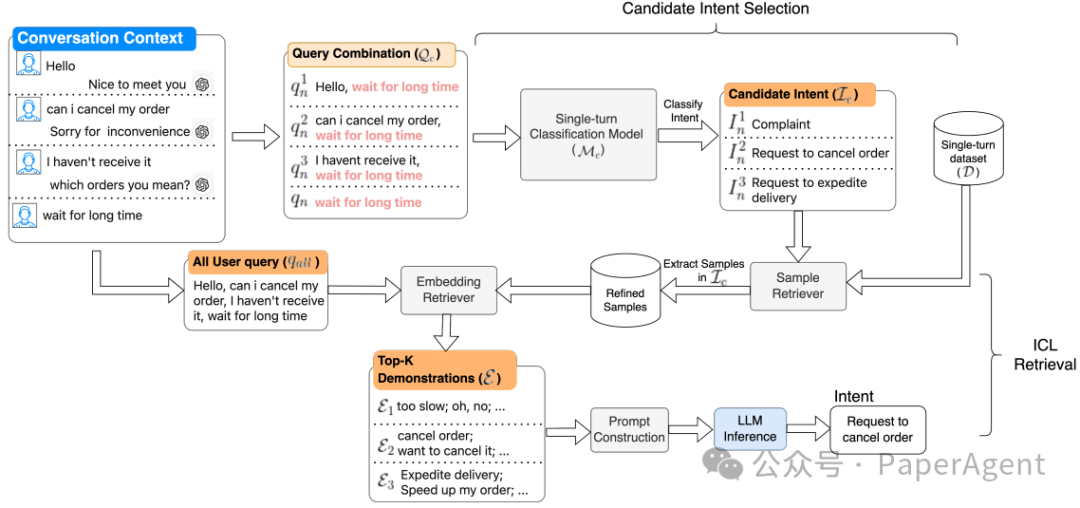

LARA框架通过结合微调的小型模型和检索增强机制,解决了多轮意图分类的挑战。LARA首先使用基于XLM的模型对单轮分类数据集进行训练,然后利用检索增强机制,通过检索与多轮测试样本语义相似的单轮示例来构建提示,从而促进ICL。这种方法允许LARA动态地利用过去的对话和相关意图,提高了对上下文的理解。LARA还包括自适应检索技术,增强了LLMs的跨语言能力,而无需进行广泛的重新训练和微调。它通过以下几个关键步骤来提高分类任务的准确性和效率:

ingFang SC", "Microsoft YaHei", SimHei;font-size: 14px;letter-spacing: 0.5px;text-align: start;text-wrap: wrap;background-color: rgb(49, 49, 58);" class="list-paddingleft-1">单轮意图识别模型(Mc):LARA使用一个基于XLM(Cross-lingual Language Model)的文本分类模型,该模型在单轮对话数据集上进行训练。这个模型用于将用户的查询映射到预定义的意图类别中。 候选意图选择:在多轮对话中,LARA首先确定可能的候选意图。这是通过将当前查询与历史查询结合起来,并使用Mc模型来预测每个组合的意图来完成的。 检索增强:LARA利用预训练的XLM模型来检索与测试查询在语义上相似的单轮示例。这些示例作为演示(demonstrations),为大型语言模型(LLMs)提供决策依据,并在上下文学习(ICL)期间指导模型输出格式。 提示构建和LLM推理:LARA构建一个输入提示(P),结合了任务指令、检索到的演示、对话上下文和最终的用户查询。这个提示用于指导LLM进行推理,以识别多轮对话中的意图。

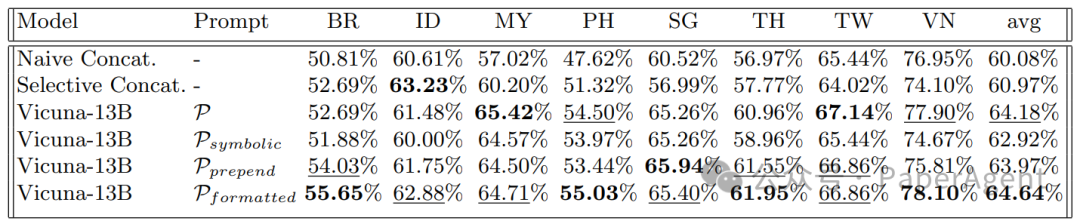

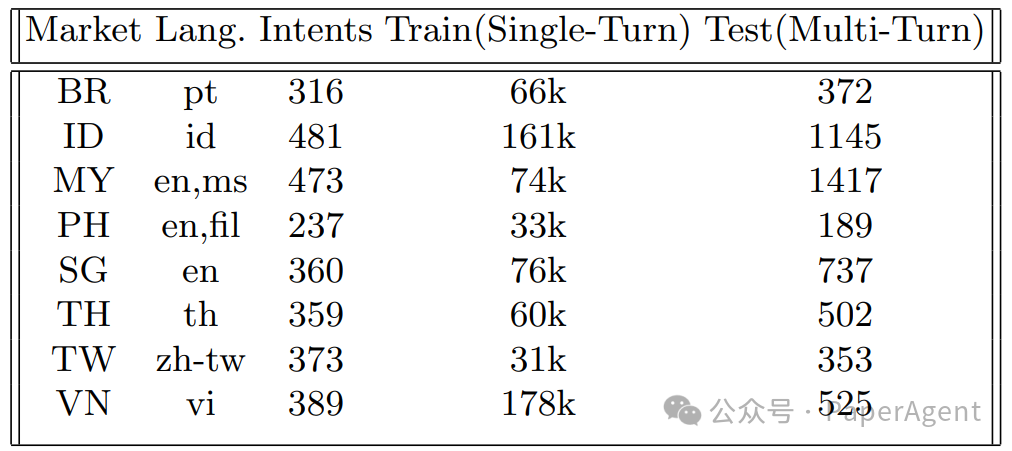

LARA在六个语言的电子商务多轮数据集上进行了实验,结果显示其在多轮意图分类任务上取得了最先进的性能。与现有方法相比,LARA平均提高了3.67%的准确率,并且在ICL期间减少了推理时间。LARA在处理复杂多轮对话中的有效性,并展示了其在实时应用中的适应性。LARA的性能与基线相比,平均值是根据每个市场中测试样本的数量加权计算的。每个数据集的最佳性能用粗体表示,而次佳性能用下划线表示。

|