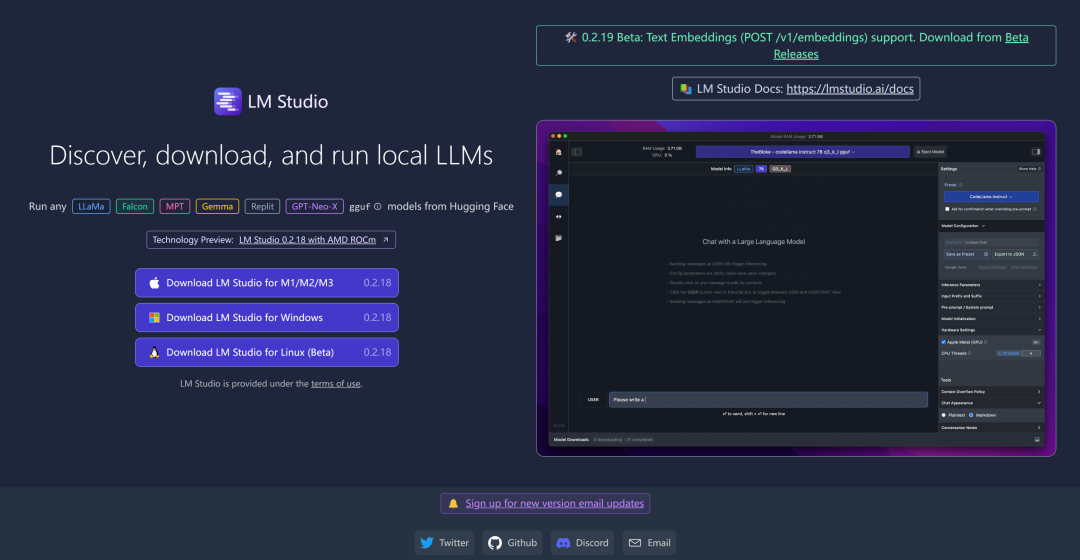

LM Studio 是支持本地开源大语言模型的最简单方法,开箱即用,不需要编码,非常简单,界面华丽,今天也来介绍一下这个应用。

1. LM Studion可以做什么

- ?通过应用内聊天 UI 或兼容 OpenAI 的本地服务器使用模型

- ?从 HuggingFace ? 存储库下载任何兼容的模型文件

- LM Studio 支持 Hugging Face 上的任何 ggml Llama、MPT 和 StarCoder 模型(Llama 2、Orca、Vicuna、Nous Hermes、WizardCoder、MPT 等)

最低要求:M1/M2/M3 Mac 或带有支持 AVX2 处理器的 Windows PC。Linux 目前处于测试阶段。

2.安装

目前支持Windows PC和Mac、Linux,Windows安装方法,直接到项目主页(https://lmstudio.ai/)下载windows对应版本,打开即用。下载包比较大,多留空余磁盘空间。

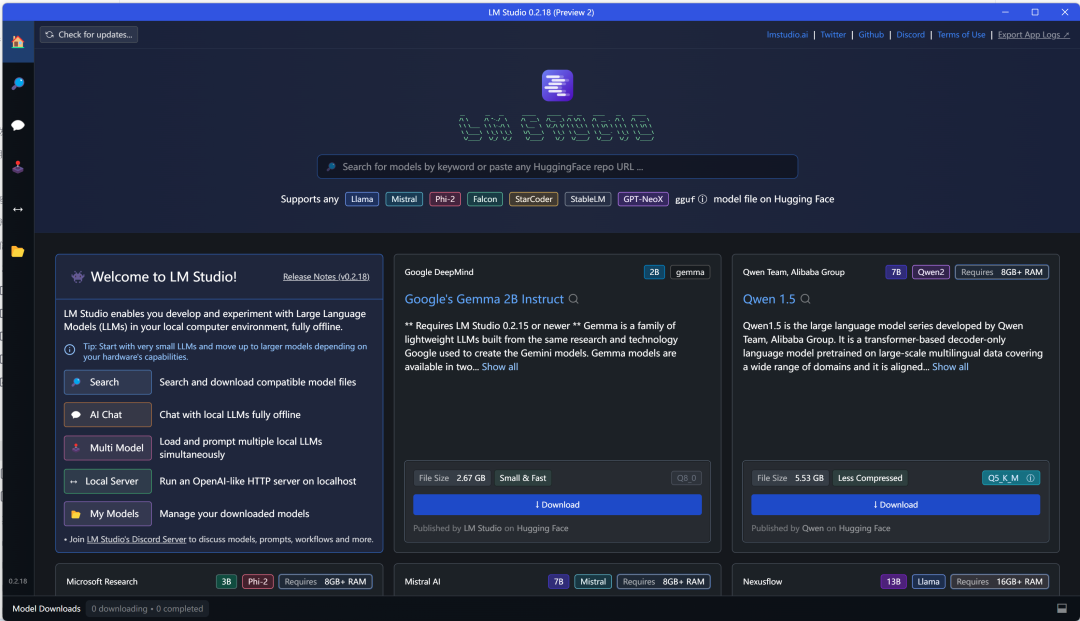

3.模型下载

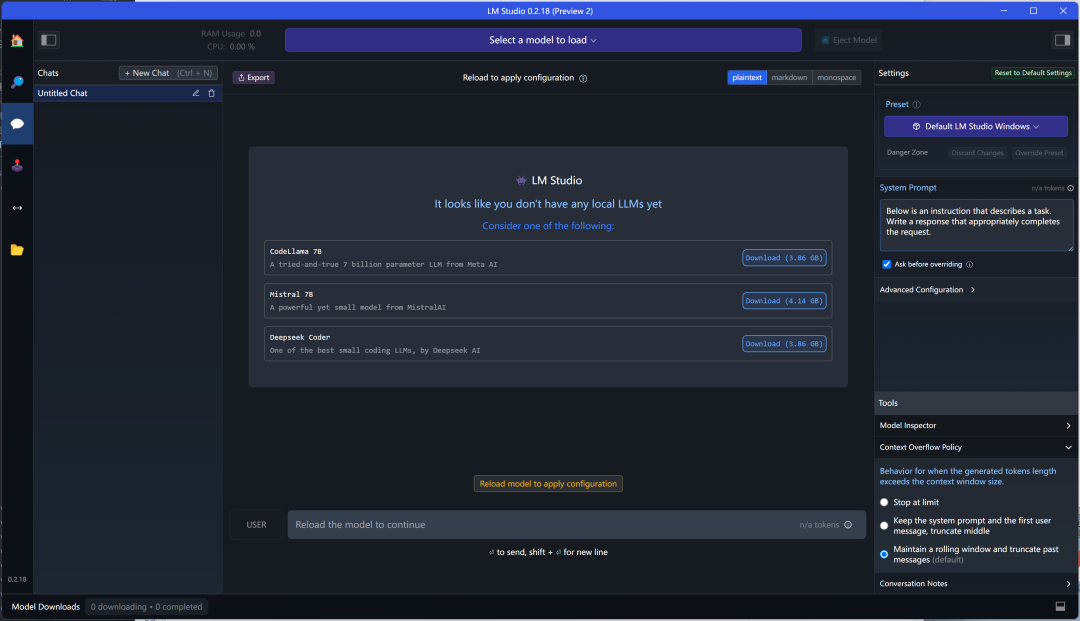

左侧是侧边工具栏,中间是模型下载区域,支持huggingface模型直接下载。

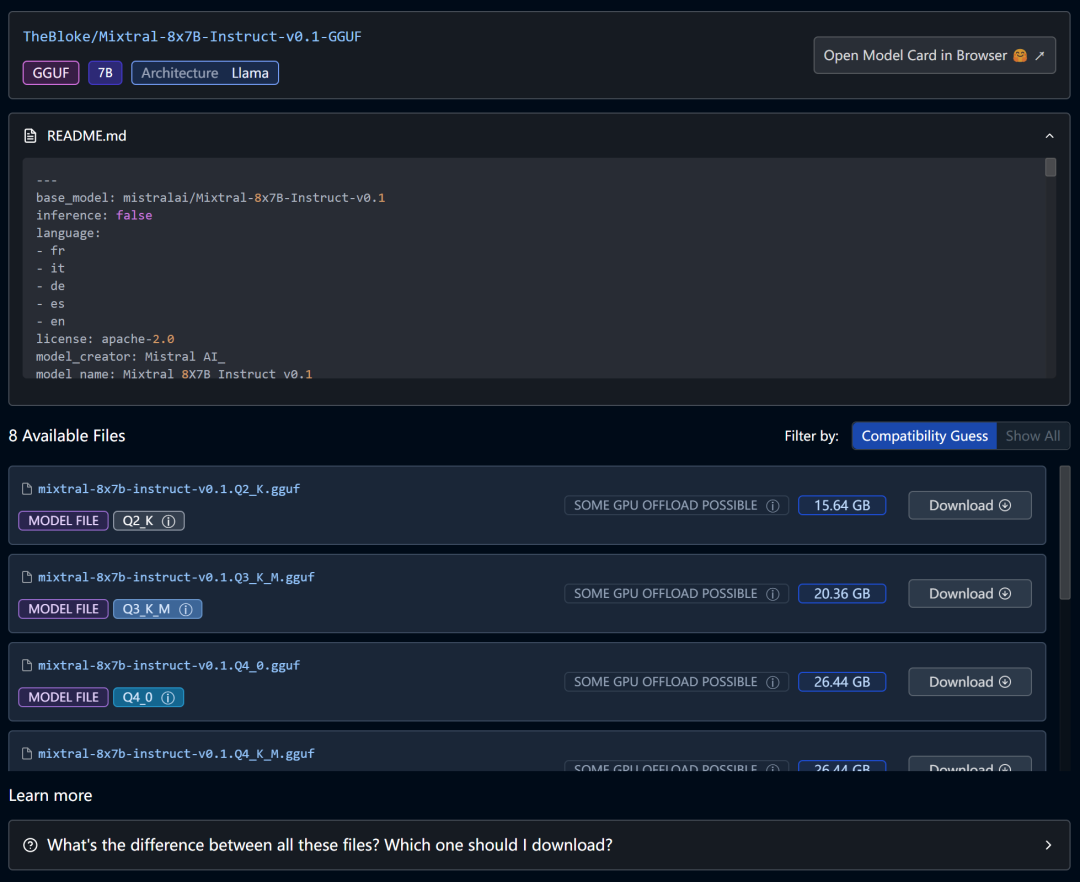

下载方法,输入正确的模型名称,比如下载mixtral

左侧是搜索到所有的模型,左上部有一个筛选框,默认是筛选本地兼容的模型,还可以选择显示全部模型。下面是每一个模型的提供者,模型名称,点赞数,下载量等。

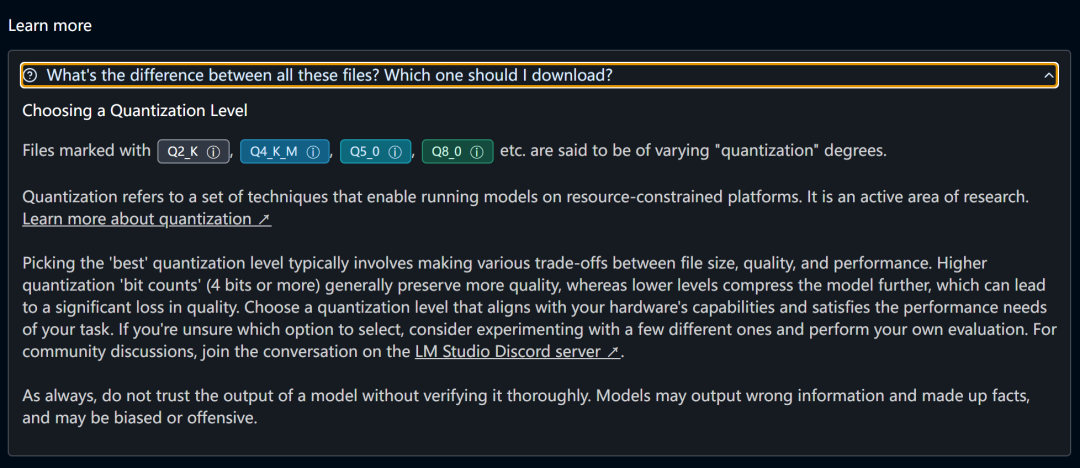

右侧是点选模型后的详细信息,下部该模型各个不同量化版本的信息,包括名称,模型的大小,点击即可下载。右上角是这个模型在HuggingFace上的模型卡片。最下面有个Learn More,是有关于模型各个版本的区别:

点选# mixtral-8x7b-instruct-v0.1.Q2_K.gguf可进行下载,最下面是下载的进度条,可以随时取消下载。

4.Chat聊天

侧边栏第二气泡图标,就是Chat功能区。 在顶部可以选择已下载好的模型进行对话聊天,还有推荐的模型,点击直接下载,进行聊天。右侧是关于聊天的参数预设置。比如GPU使用设置,聊天上下文的长度,temperature的设置,分配CPU的线程数量等。还有关于聊天的角色设置,系统角色,用户角色,助手角色等,可以进行修改。

在顶部可以选择已下载好的模型进行对话聊天,还有推荐的模型,点击直接下载,进行聊天。右侧是关于聊天的参数预设置。比如GPU使用设置,聊天上下文的长度,temperature的设置,分配CPU的线程数量等。还有关于聊天的角色设置,系统角色,用户角色,助手角色等,可以进行修改。

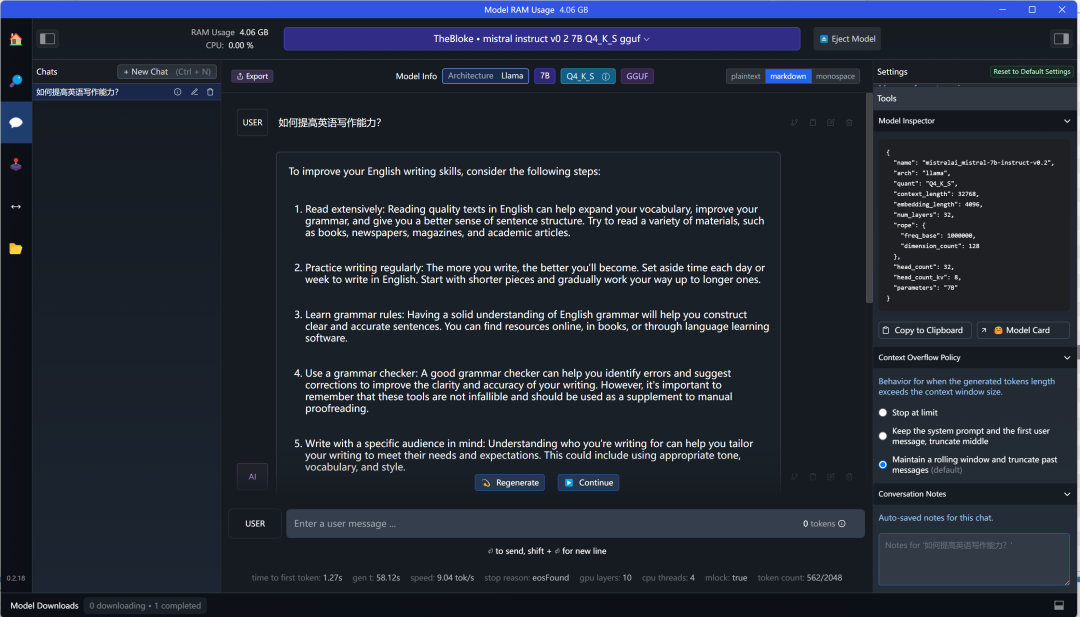

选择TheBloke/Mistral-7B-Instruct-v0.2-GGUF这个模型,进行简单的聊天。

对话的下面是本次用时多时间,消耗多少token,token速度等信息。

另外GPU是一个选项,使用GPU硬件加速,可以提高推理速度,有GPU,还是开启使用GPU。

5.多模型推理

左侧第三个侧边栏按钮,是多模型推理聊天,就是一次加载多个模型,问一个问题,多个模型同时回答。

上面界面情况,左侧区域是使用过的模型,直接点加载,就可以载入模型,如果未使用过的模型,在上面的模型选择中进行模型的选择,可以对模型的名称,预设参数进行设置,设置好就可以载入模型。

如果你的硬件配置足够高,可以同时加载更多的模型,最上面显示的CPU和GPU的使用情况。我加载了2个模型,需要使用10g显存,已超过我的8g显存范围,差的部分,用cpu补充。

加载好模型,可以在右侧进行聊天对话,在右下角进行提问,它依次按左侧模型的排列序列,对这个问题进行回答。目前看加载2个模型,响应速度还是比较快的。默认是字符格式输出,也可以选择json格式输出。

这个界面还有另一个功能,就是提供一个web服务:

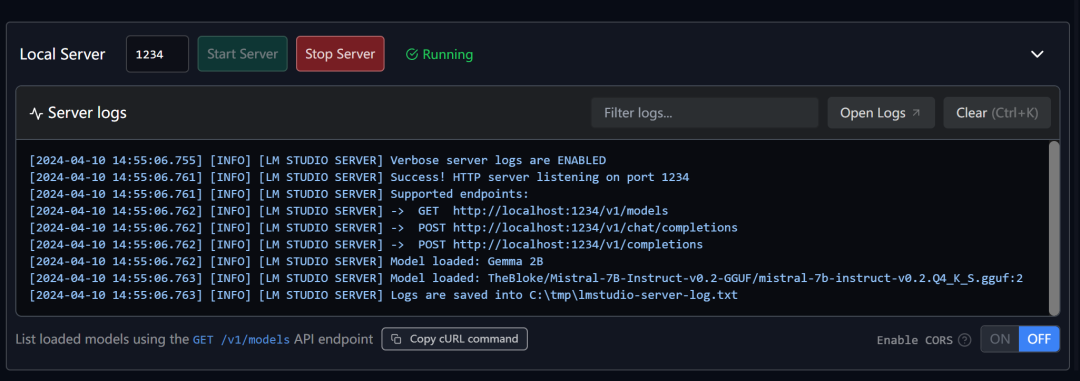

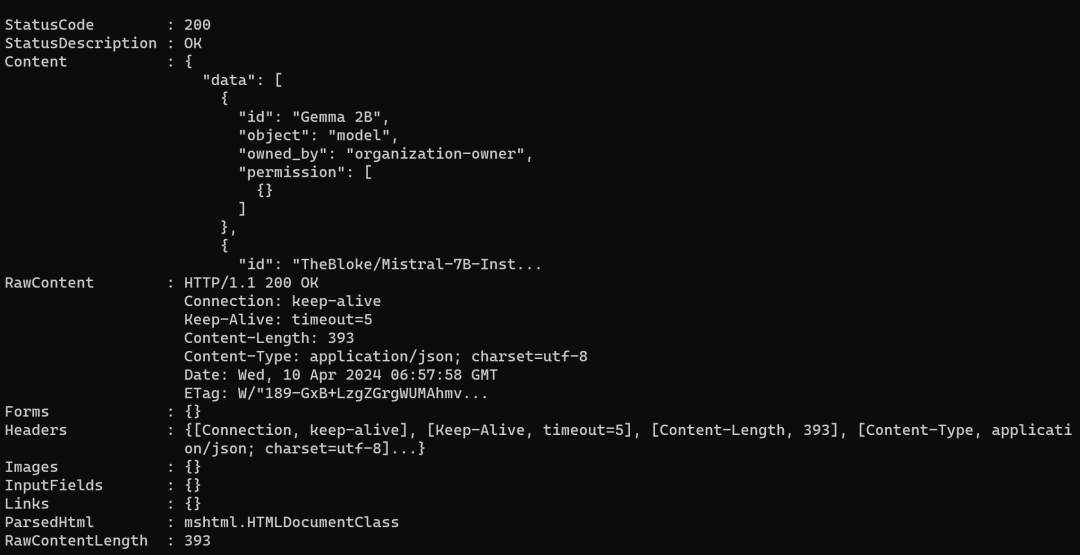

可以自己定义端口,启动服务后,可以通过curl http://localhost:1234/v1/models进行访问:

这个接口兼容openai接口,可以通过Python,js,LangChain来访问这个接口进行测试。

使用结束,点击模型旁边的Eject,退出模型的加载。停止服务。

6.本地接口服务

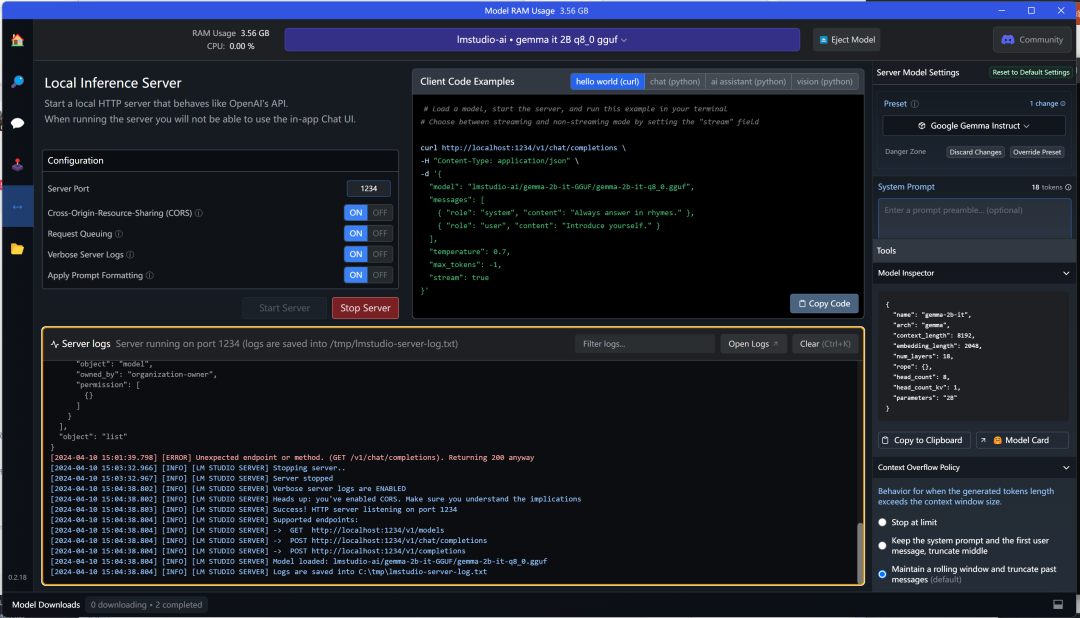

侧边栏第5个按钮,是本地接口服务。 这个服务相当于ollama serve,区别是ollama serve是提供服务,没有指定模型,而LM Studio需要指定模型,才能提供服务。

这个服务相当于ollama serve,区别是ollama serve是提供服务,没有指定模型,而LM Studio需要指定模型,才能提供服务。

比如上面的示例,最上面是加载的模型,这里没有gpu选项,显示占用内存3.56g,把Gemma 2b提供本地服务,端口是1234,中间部分,按不同的应用场景,给了示例代码,比如curl,可以复制进行测试:

curlhttp://localhost:1234/v1/chat/completions-H"Content-Type:application/json"-ddata.json

这个代码没跑出来,不弄明白curl在windows下如何使用。

试一下python chat代码:

#Example:reuseyourexistingOpenAIsetup

fromopenaiimportOpenAI

#Pointtothelocalserver

client=OpenAI(base_url="http://localhost:1234/v1",api_key="lm-studio")

completion=client.chat.completions.create(

model="lmstudio-ai/gemma-2b-it-GGUF/gemma-2b-it-q8_0.gguf",

messages=[

{"role":"system","content":"Alwaysanswerinrhymes."},

{"role":"user","content":"Introduceyourself."}

],

temperature=0.7,

)

print(completion.choices[0].message)

再试一下ai assistant助手模式:

#Chatwithanintelligentassistantinyourterminal

fromopenaiimportOpenAI

#Pointtothelocalserver

client=OpenAI(base_url="http://localhost:1234/v1",api_key="lm-studio")

history=[

{"role":"system","content":"Youareanintelligentassistant.Youalwaysprovidewell-reasonedanswersthatarebothcorrectandhelpful."},

{"role":"user","content":"Hello,introduceyourselftosomeoneopeningthisprogramforthefirsttime.Beconcise."},

]

whileTrue:

completion=client.chat.completions.create(

model="lmstudio-ai/gemma-2b-it-GGUF/gemma-2b-it-q8_0.gguf",

messages=history,

temperature=0.7,

stream=True,

)

new_message={"role":"assistant","content":""}

forchunkincompletion:

ifchunk.choices[0].delta.content:

print(chunk.choices[0].delta.content,end="",flush=True)

new_message["content"]+=chunk.choices[0].delta.content

history.append(new_message)

print()

history.append({"role":"user","content":input(">")})

所有服务和访问都写入日志信息中,如果有不明原因错误,可以查看日志文件。

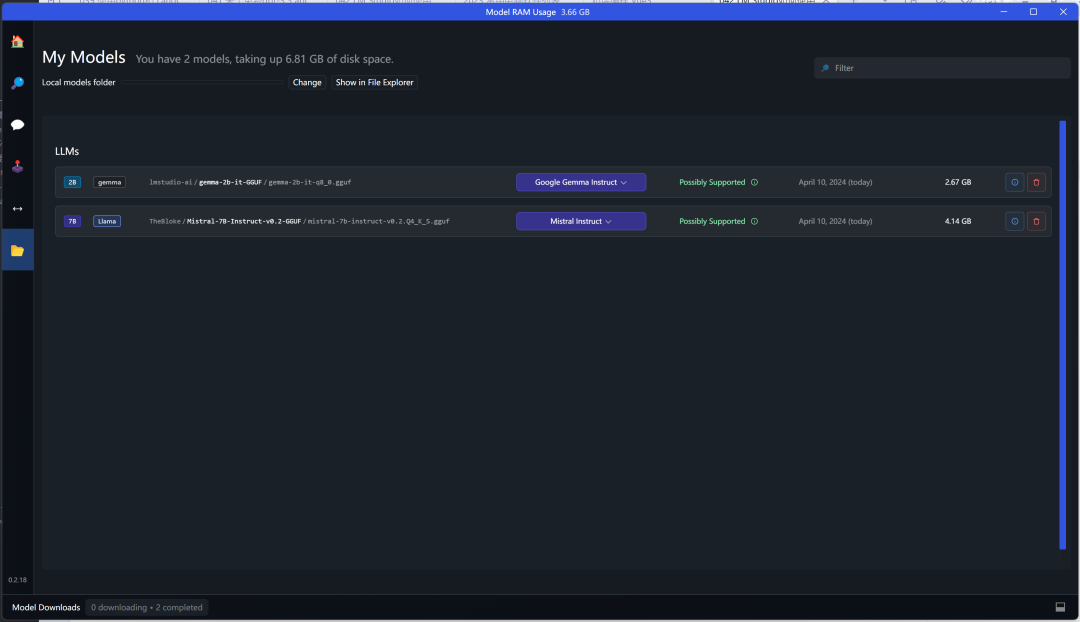

7.模型管理

左侧边栏第6个按钮是模型管理,可以下载,删除模型,还可以打开模型目录。

目录下格式:

├─lmstudio-ai

│└─gemma-2b-it-GGUF

└─TheBloke

└─Mistral-7B-Instruct-v0.2-GGUF

最上一层目录是模型提供者名称,第二层目录是模型名称,其下放置gguf模型文件。由于网络原因,huggingface下载模型很不稳定,可以手动下载模型,按这种目录格式进行模型的放置,算是手动下载模型。

8.LM Studio 与Ollama的区别

LM Studio支持HuggingFace上的gguf模型,它不支持ollama的模型,ollama有自己的模型格式,自己的模型下载平台,模型数量比较多。ollama通过modelfile方式可以导入gguf模型。两个平台有点像ps5和switch,各家都有独占模型,又有共有模型。ollama之前也介绍过几期,他们对比各有公有优缺点。除去模型因素,从管理和日常使用上讲,LM Studio似乎更灵活一些,容易上手,所有操作均在图形界面中完成,而ollama的一些配置,需要在命令行中完成,这算是他们的一点区别吧。

关于ChatOllama,它是ollama的一个壳,目前兼容了openai,等一些其他接口,如果是使用ollama,可以使用这个壳应用,来使用ollama,同时兼顾openai等。

这两个平台的稳定性没有测试,如果需要稳定持续的服务,可能需要linux版的软件,我没有使用过,无法提供具体建议。

今天就这么多吧,欢迎大家留言,进群讨论。

9.文本嵌入

目前我使用的0.2.18版,还不支持文件嵌入,将在0.2.19版提供文本嵌入的支持。在本地服务中提供POST /v1/embeddings,通过post请求,实现嵌入。

curlhttp://localhost:1234/v1/embeddings\

-H"Content-Type:application/json"\

-d'{

"input":"Yourtextstringgoeshere",

"model":"model-identifier-here"

}'

嵌入模型支持 nomic-embed-text-v1.5和bge-large-en-v1.5。

10.模型下载

HuggingFace提供了huggingface-cli进行模型的下载,安装cli工具,下载qwen模型。

pipinstall'huggingface_hub[cli,torch]'

huggingface-clidownloadQwen/Qwen1.5-7B-Chat-GGUFqwen1_5-7b-chat-q5_k_m.gguf--local-dir.--local-dir-use-symlinksFalse

下载速度比较快,平均速度1M以上,如果使用LM Studio不能下载模型,可以试一下这个方法。

huggingface换源,设置环境变量HF_ENDPOINT=https://hf-mirror.com,可以用三方的镜像进行加速下载。换源这部分待测试,如果使用了的,可以给个反馈。

另外还有一款开源工具,也是下载huaggingface模型的方式。

gitclonehttps://github.com/LetheSec/HuggingFace-Download-Accelerator.git

cdHuggingFace-Download-Accelerator

pythonhf_download.py--modellmsys/vicuna-7b-v1.5--save_dir./hf_hub

接下来操作你的代码就好了

fromtransformersimportpipeline

pipe=pipeline("text-generation",model="./hf_hub/models--lmsys--vicuna-7b-v1.5")