|

Mistral在他们的博客文章中更新了磁力链,以及他们的8x22B MoE模型的指令微调版本

Mixtral 8x22B是一个采用稀疏专家混合(SMoE)架构的模型,它在141亿个参数中仅使用了39亿个活跃参数,这一创新使其在保持模型规模的同时,提供了前所未有的成本效益。 该模型支持英语、法语、意大利语、德语和西班牙语等多种语言,能够流畅地进行语言理解和生成。 此外,它还具备强大的数学和编码能力,以及天生的函数调用能力。 特别值得一提的是,Mixtral 8x22B拥有64K令牌的上下文窗口,这使得它能够从大型文档中精确地回忆和处理信息。

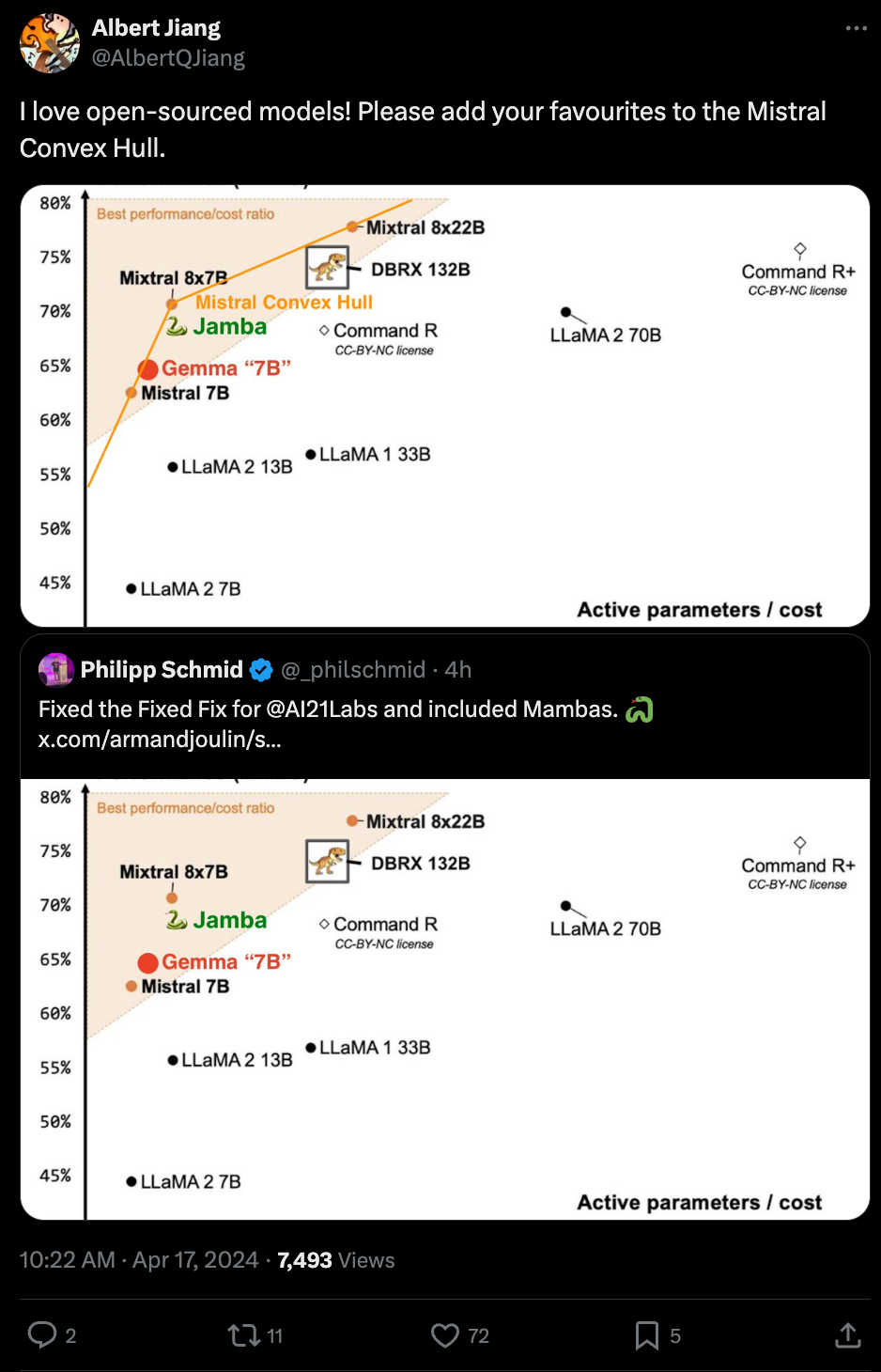

这张图片对比了Databricks、Google和AI21之间的竞争,它们都只是强调Mixtral在激活参数和MMLU性能之间创造了一种新的权衡。但是需要注意的是,激活参数数量与模型运行的成本大概率正相关,但可能并不是线性相关的。

|