|

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;visibility: visible;">

LLama3 & GPT-5 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.544px;text-wrap: wrap;background-color: rgb(255, 255, 255);visibility: visible;">当我们回顾Transformer三大变体的第一阶段发展历程时,一个不容忽视的事实是:Decoder-Only结构似乎在这场竞赛中脱颖而出,赢得了初步的胜利。 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.544px;text-wrap: wrap;background-color: rgb(255, 255, 255);outline: 0px;"> ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.578px;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;text-indent: 0em;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.544px;text-align: center;text-wrap: wrap;background-color: rgb(255, 255, 255);outline: 0px;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.578px;">模型发展历史ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;text-wrap: wrap;background-color: rgb(255, 255, 255);font-size: 16px;letter-spacing: normal;caret-color: rgba(0, 0, 0, 0.9);visibility: visible;text-size-adjust: inherit;text-align: center;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;text-align: justify;visibility: visible;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;visibility: visible;">Transformer ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.578px;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;text-indent: 0em;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 15px;letter-spacing: 0.544px;text-align: center;text-wrap: wrap;background-color: rgb(255, 255, 255);outline: 0px;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.578px;">模型发展历史ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;text-wrap: wrap;background-color: rgb(255, 255, 255);font-size: 16px;letter-spacing: normal;caret-color: rgba(0, 0, 0, 0.9);visibility: visible;text-size-adjust: inherit;text-align: center;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;text-align: justify;visibility: visible;">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: var(--articleFontsize);letter-spacing: 0.034em;visibility: visible;">TransformerTransformer遵循编码器-解码器总体架构,使用堆叠的自注意力机制和逐位置的全连接层,分别用于编码器和解码器,如图中的左半部分和右半部分所示。

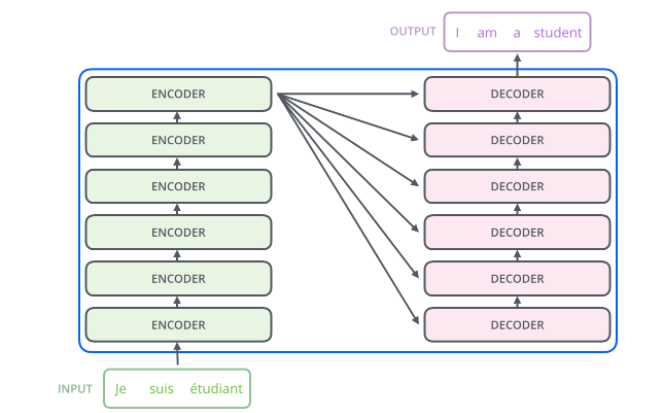

Transformer架构 编码器 - 解码器架构:将现实问题转化为数学问题(Encoder编码器),通过求解数学问题来得到现实世界的解决方案(Decoder解码器)。

编码器 - 解码器架构 Transformer模型:将整个Transformer模型视为一个黑盒,在机器翻译任务中,它可以将句子从一种语言翻译成另一种语言。 打开这个黑盒,左边是N个编码器,右边是N个解码器,Transformer中的N为6。

详细了解看这篇:神经网络算法 - 一文搞懂Encoder-Decoder(编码器-解码器) Transformer的编码器与解码器的本质区别:在于Self-Attention的Mask机制。

Encoder负责将输入序列转换为隐藏表示,通过多层自注意力和全连接层,捕捉序列中所有位置的依赖关系,无需使用Mask。 Decoder生成输出序列,利用Encoder输出和已生成部分序列作为输入。在Decoder的Self-Attention中,使用Mask防止当前位置受到未来信息影响,确保生成顺序和准确性。 详细了解看这篇:神经网络算法 - 一文搞懂Transformer中的三种注意力机制 Transformer中的编码器部分一共6个相同的编码器层组成。 每个编码器层都有两个子层,即多头自注意力层(Multi-Head Self-Attention)层和前馈神经网络(Feed-Forward Network)。 在每个子层后面都有残差连接(图中的虚线)和层归一化(LayerNorm)操作,二者合起来称为Add&Norm操作。 Transformer的编码器 Transformer中的解码器部分同样一共6个相同的解码器层组成。 每个解码器层都有三个子层,即因果自注意力层(Masked Self-Attention)、交叉注意力(Encoder-Decoder Attention)、前馈神经网络(Feed Forward)。 同样,在每个子层后面都有残差连接(图中的虚线)和层归一化(LayerNorm)操作,二者合起来称为Add&Norm操作。 Transformer的解码器 Transformer的三大变体 Transformer的三大变体:Decoder-Only专注生成文本,Encoder-Only擅于分析文本,Encoder-Decoder融合编解码实现文本生成和文本分析。 Transformer的三大变体 蓝色分支Decoder-Only模型:随着时间的推移,越来越多的Decoder-Only模型被推出,如LLama、GPT等,显示了这一分支的活跃度和发展势头。 粉色分支Encoder-Only模型:这些模型主要用于编码和表示输入序列,如BERT、RoBERTa等。绿色分支Encoder-Decoder模型:结合了前两者的特点,既能够编码输入序列,又能生成输出序列,如T5、GLM(清华)。Decoder-Only模型就如同一位即兴演讲者。你为他提供一个话题或者一个开头,比如“未来城市的模样”,他便能根据这个引子,滔滔不绝地展开演讲,描述出他心中的未来城市景象,直至演讲结束。 模型特点:擅长创造性写作,具备出色的文本生成能力。它能够根据已有信息,灵活扩展出新颖、连贯的内容,如自动生成文章、续写故事等。 典型代表:OpenAIGPT、Meta LLama,用于文本生成,通过捕捉文本中的语言模式和风格,使生成的文本更加自然、流畅。 OpenAI GPT 详细了解看这篇:神经网络算法 - 一文搞懂GPT(Generative Pre-trained Transformer)Meta LLama 详细了解看这篇:国内“百模大战”,大部分都是套壳LLaMA?Encoder-Only模型则像是一个侦探,它接收一段文字或信息(案件线索),然后深入解析、理解其内在含义(破案)。 模型特点:擅长分析和理解文本,捕捉文本中的关键信息,如情感、主题或实体。这种模型在文本分类、情感分析、信息抽取等任务中表现出色。 典型代表:GoogleBERT,用于处理输入数据,专注于理解和编码信息,而不是生成新的文本。 GoogleBERT 详细了解看这篇:神经网络算法 - 一文搞懂BERT(基于Transformer的双向编码器)Encoder-Decoder模型就像是一位精通多种语言的翻译家。当你给它一段源语言文本时,它不仅能够理解并捕捉这段文本中的关键信息和语义,还能够将其精准地翻译成另一种目标语言。模型特点:结合了编码与解码的功能,能够同时处理输入和输出序列,并在两者之间建立有效的联系,擅长文本生成和文本分析。 Encoder部分:负责文本分析,将输入序列(源语言文本)转化为一个固定长度的内部表示,这个表示包含了输入序列的所有关键信息。 Decoder部分:负责文本生成,根据这个内部表示来生成目标序列(目标语言文本)。 典型代表:清华GLM,在机器翻译、文本摘要和对话生成等任务中取得了显著的成果。清华GLM |