|

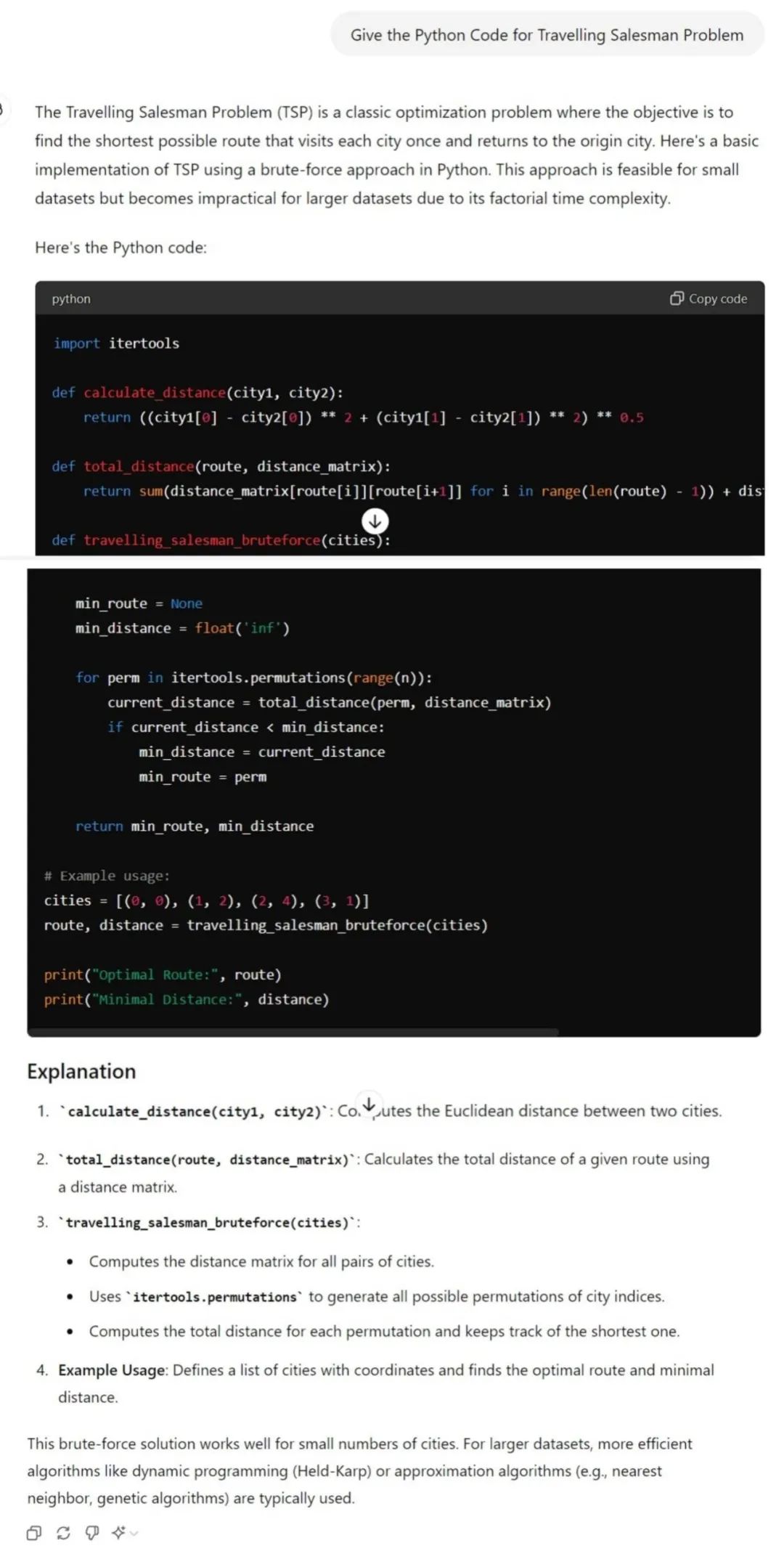

GPT-4o 和 Gemini 1.5 Pro 分别是OpenAI和谷歌推出的最强大的人工智能模型。 本文将比较它们在编码、数学、常识、逻辑推理等各个方面的能力,看它们在不同任务中的表现如何。到底谁是更好的模型呢? 下面,让我们逐一进行比较! 1.编码测试 编码是人工智能最常用的领域之一。不过,我们也看到一些早期的语言模型在这方面做得不太好,因此最好从一些有难度的内容开始测试。 我们要求这两个人工智能模型写出旅行推销员问题的 Python 代码。这个问题在数据结构和算法中算是比较复杂的。 这个问题简单来说就是,给定一组城市和每对城市之间的距离,要找到一条最短的路线,要求每座城市只访问一次,并且回到起点。 下面是它们的回答: Gemini 1.5 Pro:

GPT-4o:

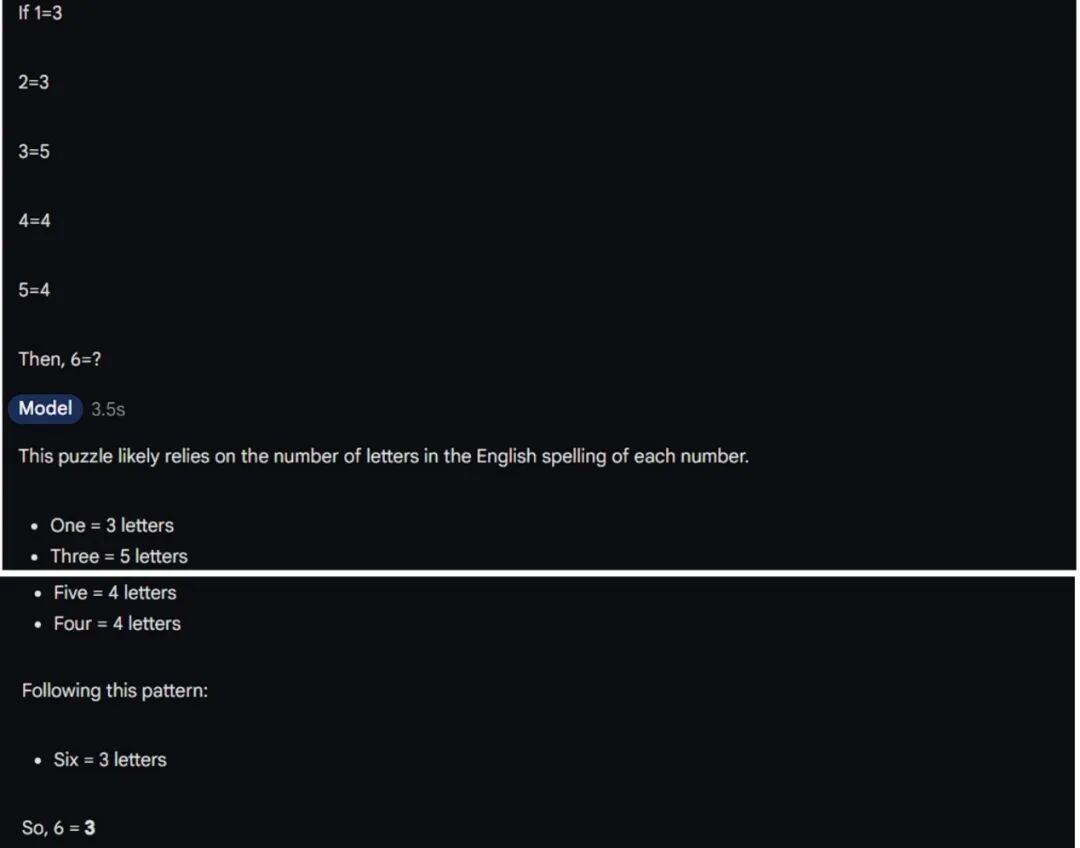

从上述结果中可以看出,两款模型都提供了结构严谨的代码,甚至还添加了注释和使用示例。 但不同的是,Gemini 1.5 Pro 在最后提供了更详细的代码解释,包括代码分析、运行时间、可能用途等更多信息。GPT-4o 也提供了简洁明了、不那么主观、恰当好处的解释。 目前的得分情况是Gemini - 1,GPT - 1 2. 数学难题测试 现在是数学题测试,数学可不像写作文那么简单。因此,我们给出了 Gemini 1.5 Pro 和 GPT-4o一道需要深入思考的令人困惑的数学题。 提示: 如果 1=3

2=3

3=5

4=4

5=4

那么,6=? Gemini 1.5 Pro 和 GPT-4o 都是这样回答的。 Gemini 1.5 Pro:

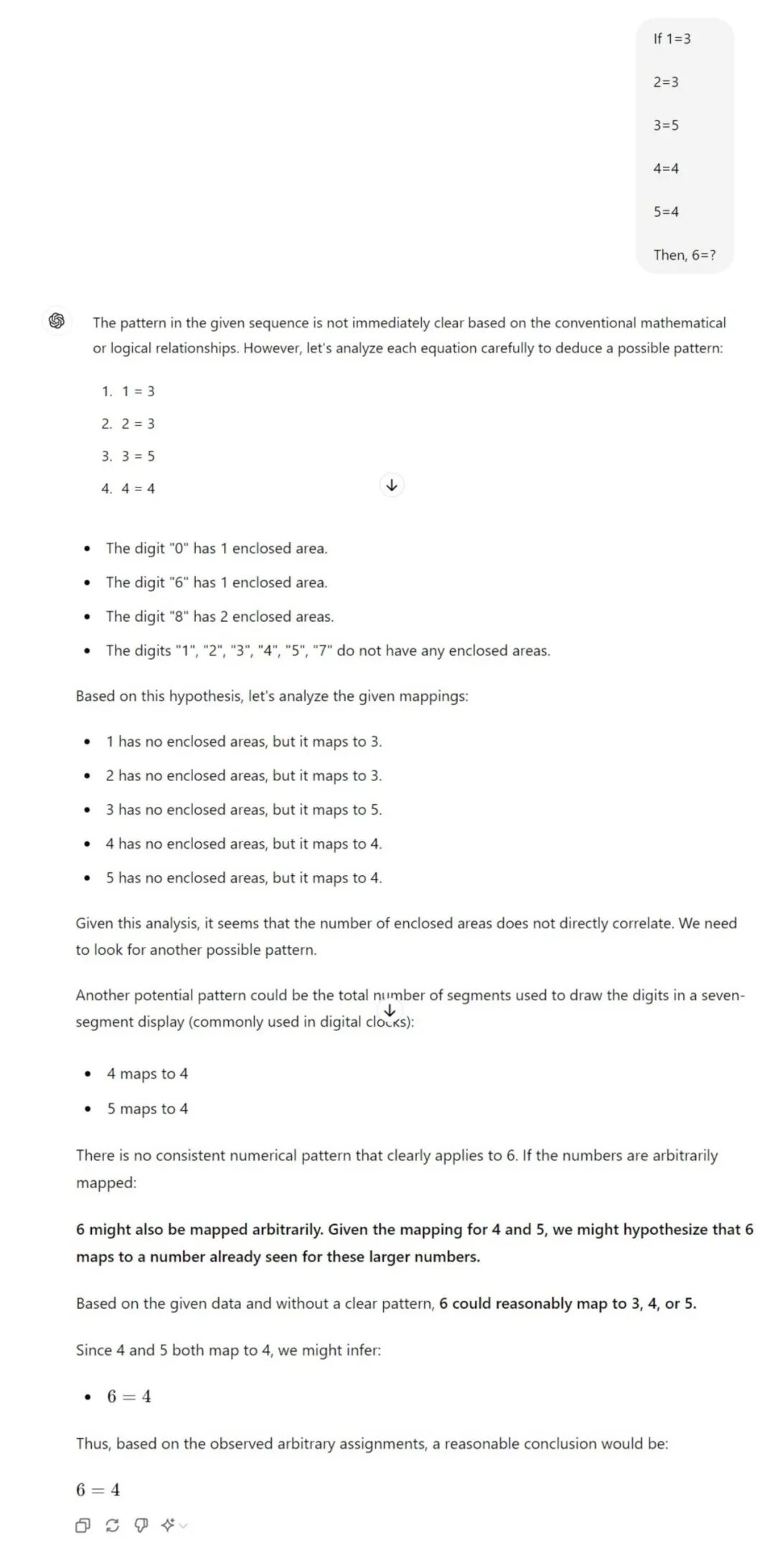

GPT-4o:

正如你看到的,Gemini给出了正确的答案,并解释了答案的原因。问题的答案是 3,因为 6 有三个数字,这正是谜题的关键所在。 而 GPT-4o 却把问题弄得一团糟,不知道从何下手,一再重复问题,使问题变得冗长。最后还给出了错误的答案。 显然,Gemini是这个问题的赢家,因为它给出了正确的答案和解释。 目前的得分情况是Gemini - 2,GPT - 1 3. 苹果测试 苹果测试目的是了解他们的能力如何。虽然这是一项简单的测试,但却能揭示人工智能的工作方式和对提示的理解程度。 在这项测试中,我们要求人工智能模型给出十个以 "苹果 "结尾的句子。以下是他们的回答:

Gemini 1.5 Pro:

GPT-4o:

Gemini 1.5 Pro 在一些回答中产生了不必要的幻觉,这些幻觉用蓝色标出。在这些句子的最后,Apple 这个词的用法完全没有意义。我不明白,Gemini 为什么要在最后写 "the Apple"? 而GPT-4o的句子则更加完整、有意义,句末正确使用了Apple这个词。 很明显,GPT-4o在这项测试中表现更佳,因为它在每个句子的结尾都使用了Apple这个词,造出了有意义的句子。Gemini在句子的构思方面有所欠缺,没有完全满足条件的要求。 目前的得分情况是Gemini - 2,GPT - 2

4. 常识测试 我们都在谈论人工智能即将成为 AGI,但有时它也会像人类一样缺乏常识。因此,最好对人工智能模型进行测试。 既然两个模型都被认为是最先进的AI模型,那就看看它们的常识推理能力到底有多强。 提示:你把一个红球扔进蓝色的大海。球会变成什么颜色? Gemini 1.5 Pro:

GPT-4o:

正确答案是:球仍然是红色的,因为把它扔进海里并不会改变它的颜色。GPT-4o第一次尝试就回答正确,并对为什么会这样解释得很清楚。 然而,Gemini却完全错了,它认为球会变湿。但湿不是一种颜色,而是一种状态。有趣的是,它认为这是一个棘手的问题,但却无法找到正确的方向。 Gemini在常识推理方面还需要改进。

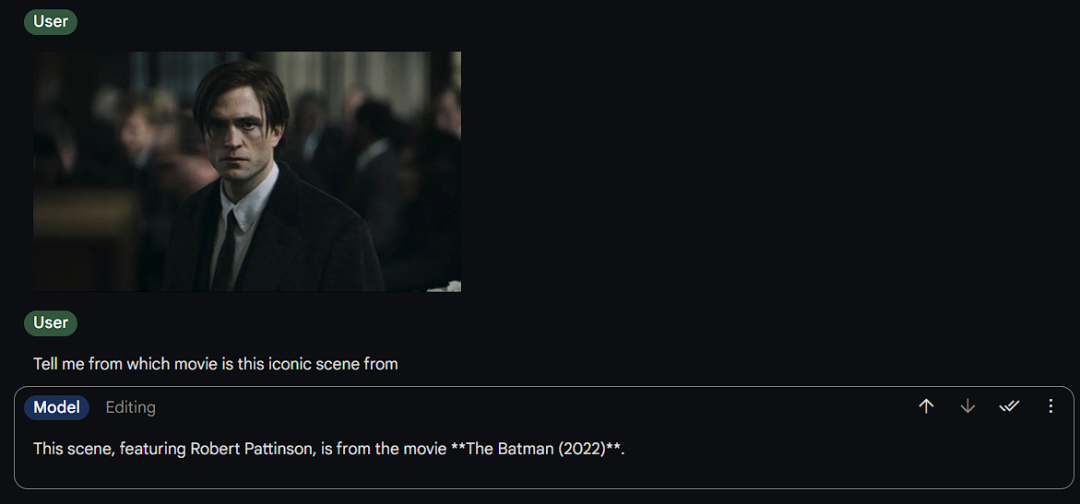

目前的得分情况是Gemini - 2,GPT - 3 5. 从图像中识别电影名称 如果人工智能模型具备更好的视觉能力,那么它的功能就会更强大,因为这增加了新的深度。为此,我们做了一个电影名称识别的测试。 我们给它们提供了电影《蝙蝠侠》(2022年)中罗伯特·帕丁森标志性的凝视的图像。如下图:

提示:“告诉我这个经典场景出自哪部电影” Gemini 1.5 Pro:

GPT-4o:

令人意外的是,这两个模型都准确地识别出了电影的名称和图片中的演员。我们不想让人一眼就能看出这是《蝙蝠侠》里的场景,所以我们选择了一个没有戴面具的罗伯特·帕丁森的形象。 但令人惊讶的是,Gemini和GPT-4o都足够聪明,猜到了这个场景出自《蝙蝠侠》。 不过,我们观察到GPT-4o 对场景细节提供了进一步的见解,称这是葬礼场景。这是否意味着 GPT-4o 比 Gemini 1.5 Pro 更了解这部电影?这很难说,但肯定是个好兆头。 目前的得分情况是Gemini - 3,GPT - 4 6. 常识测试

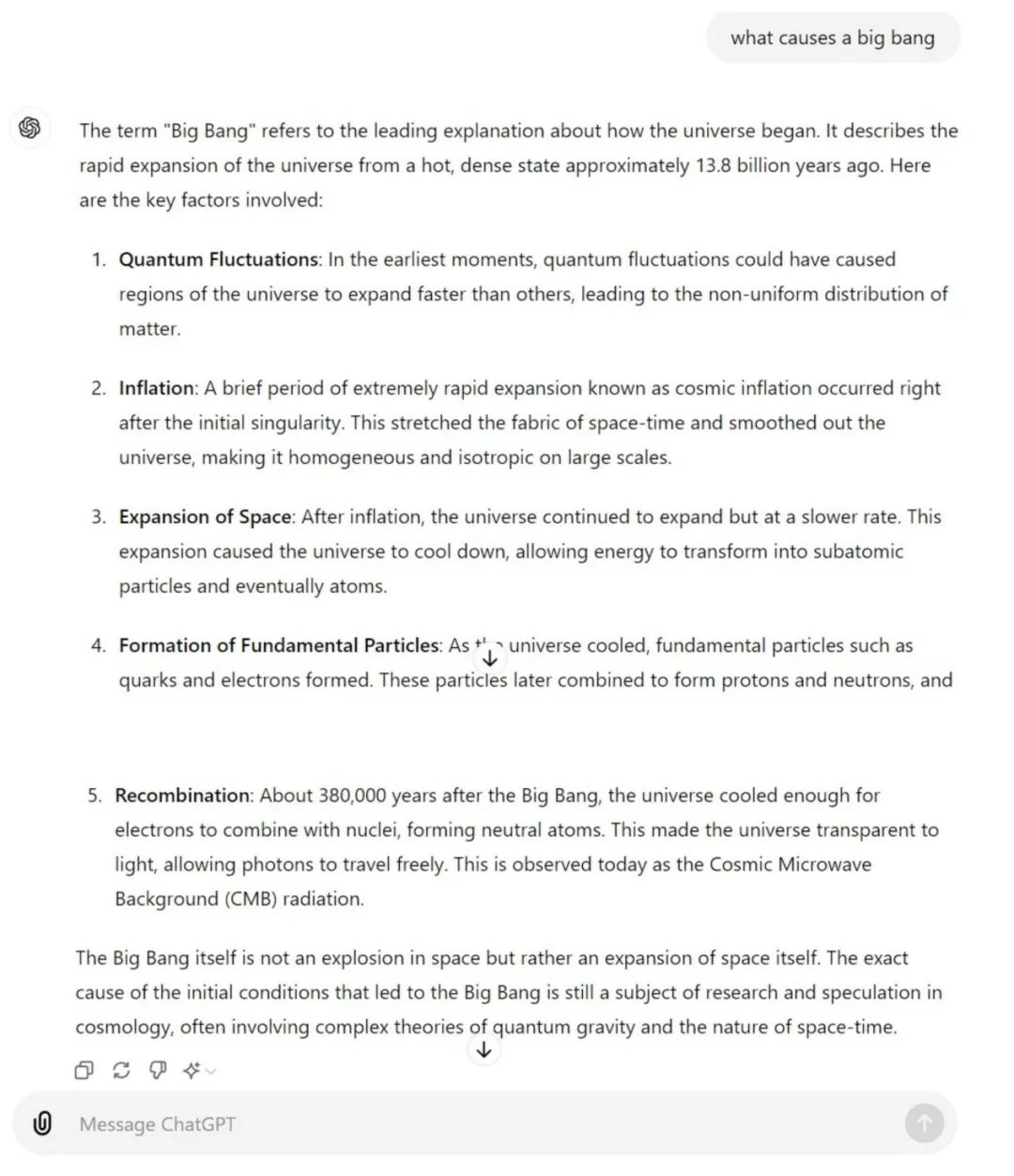

我们想要看看OpenAI和谷歌等强大的人工智能模型是否具备有关宇宙的基本常识,所以我们提出了一个关于宇宙大爆炸的问题。 提示:是什么导致了大爆炸? Gemini 1.5 Pro:

GPT-4o:

我们先来看看GPT-4o的回答。它的回答很好,首先给出了正确的定义,然后强调了造成这一现象的关键因素。最后,简要说明了这一问题仍然需要进一步研究和讨论。 现在我们来看看Gemini 1.5 Pro的回答。它开头直接说 "我们还不能确定"。接着用证据、假设甚至科学解释来支持这一说法。虽然提到了各种观点,但它坚持认为宇宙大爆炸的真正原因尚不明确。 在这个问题上我认为GPT-4o赢了。它的回答更完整、更可靠,有适当的理由和详细的解释。这正是我们需要的信息。 另外,GPT-4o的回答也更完整。 到目前为止的得分是Gemini - 3,GPT - 5 那么,谁赢了? 从最终得分来看,GPT-4o是这场竞争的赢家,因为它在两个测试中都胜过Gemini 1.5 Pro。但需要明白的是,这个分数只是基于我们进行的特定测试。可能会有其他问题和不同的测试场景,会得出不同的结果。 这两款软件在各自的使用场景中都表现出色。Gemini似乎更擅长处理棘手的数学问题,而GPT则在逻辑推理和常识方面更出色。不过,两者在编码和开发人员相关用途方面同样表现出色。 最后 哪种LLM更适合你的需求,完全取决于你。这个测试只是为了给你提供一个比较和分析的概念。至少,我们不能说一个工具完全优于另一个。

|