|

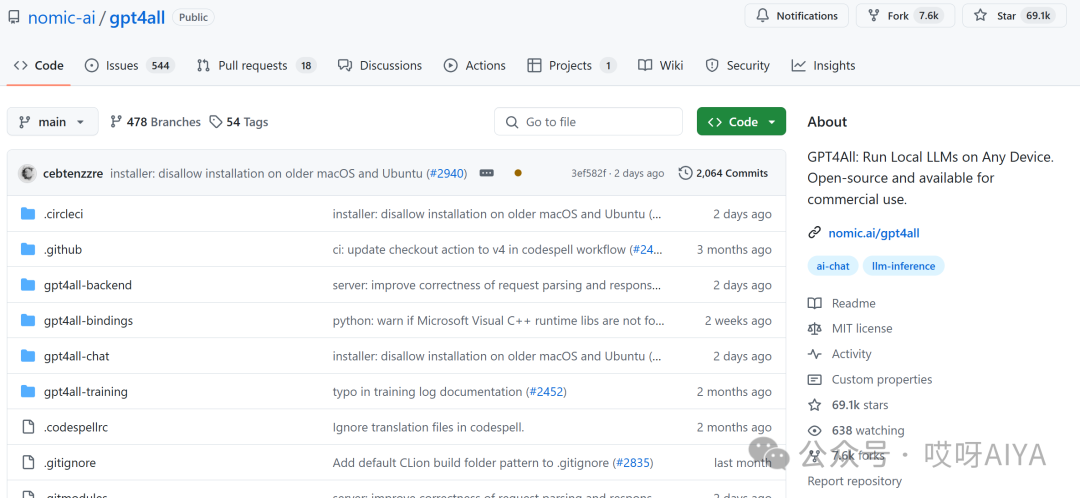

本篇文章我们要介绍的是一个开源项目GPT4All,它是由 nomic-ai 团队精心打造的开源项目,已经在 GitHub 上赢得了超过 69.1k 颗星星,人气爆棚!

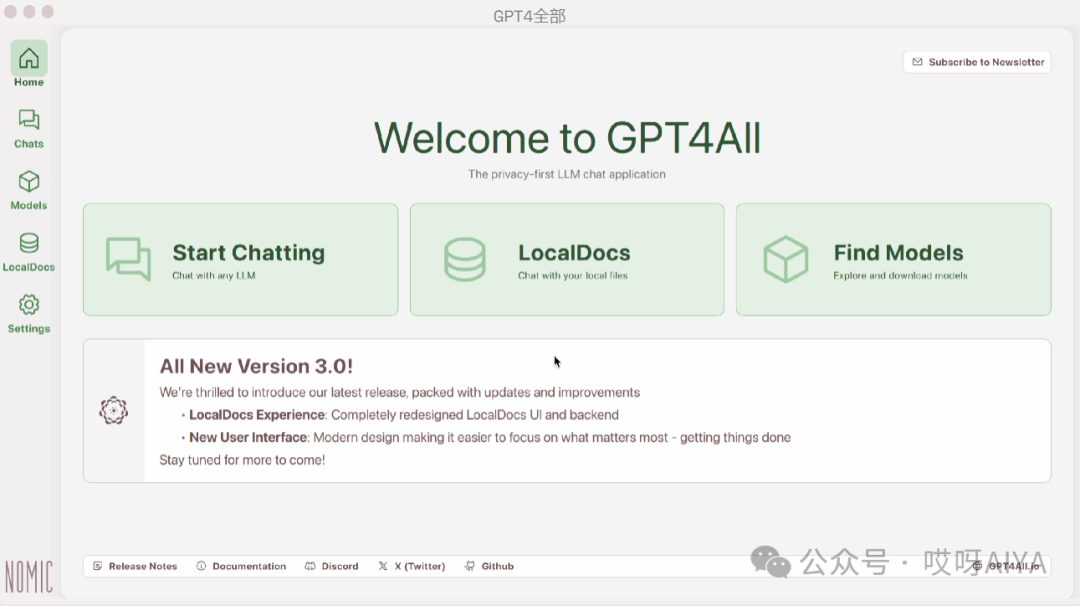

GPT4All 不仅仅是一个应用,通过图形化界面帮你在日常的桌面和笔记本电脑上私下运行大语言模型(LLM)。无需 API 调用或 GPU,你只需下载应用程序即可开始使用。GPT4All 提供了 Python 客户端,让你可以方便地访问 LLM。Nomic 团队为了让 LLM 对所有人都易于访问和高效,贡献了开源软件,如 llama.cpp。

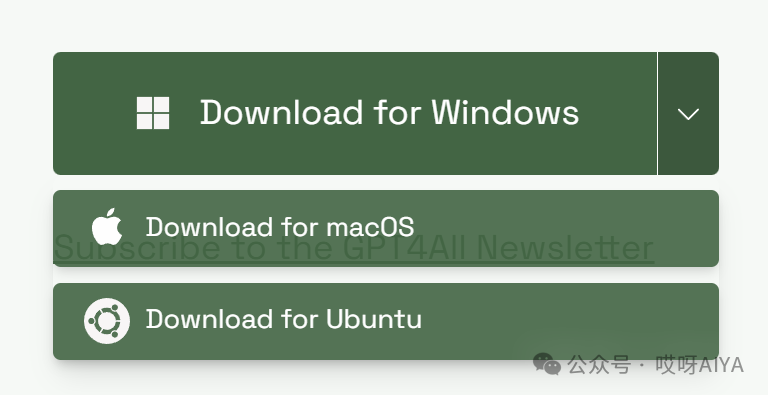

工具特征 ① 跨平台兼容:无论是 Windows、macOS、Ubuntu,GPT4All 都能完美适配,让你的聊天随时随地触手可及。 ② 数据安全:GPT4All 使用 Python 客户端,让你的聊天数据安全又自由。

GPT4All 首先以隐私和安全为先。将 LLM 与敏感的本地数据一起使用,而无需离开您的设备。GPT4All 允许您在 CPU 和 GPU 上运行 LLM。它完全支持 Mac M 系列芯片、AMD 和 NVIDIA GPU。

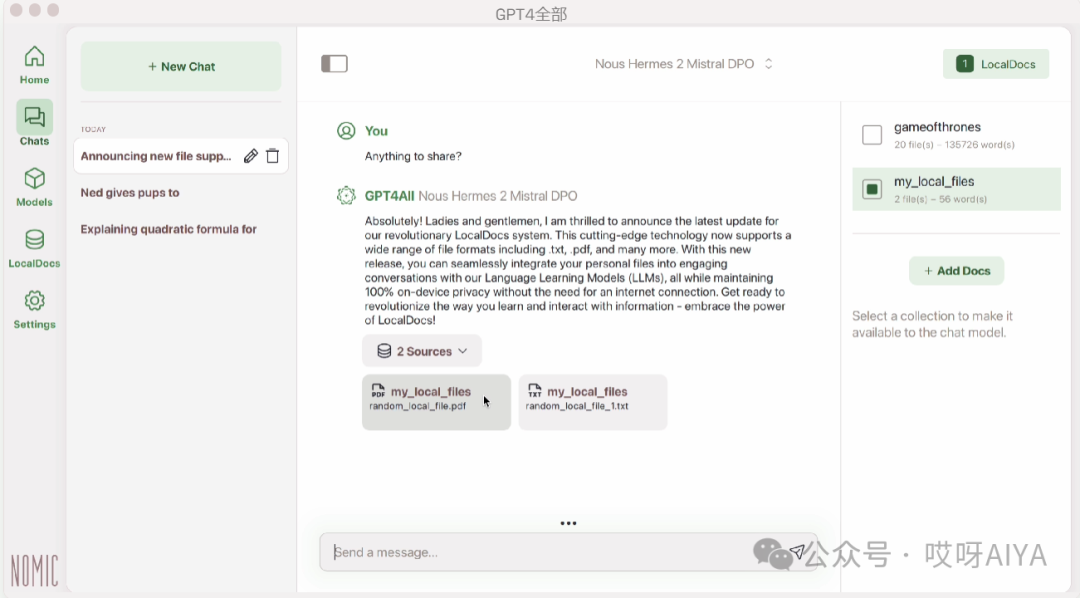

使用 LocalDocs 授予您的本地 LLM 访问您的私有敏感信息的权限。它可以在没有互联网的情况下工作,并且不会有数据离开您的设备。

探索 1000 多种开源语言模型GPT4All 支持 LLaMa、Mistral、Nous-Hermes 等数百种流行模型。

https://www.nomic.ai/gpt4all Windows 和 Linux 需要 Intel Core i3 第 2 代 / AMD Bulldozer 或更高版本。仅限 x86-64,无 ARM。 macOS 需要 Monterey 12.6 或更高版本。使用 Apple Silicon M 系列处理器获得最佳效果。gpt4all允许您使用我们的 Python 客户端访问 LLMllama.cpp实现。fromgpt4allimportGPT4Allmodel=GPT4All("Meta-Llama-3-8B-Instruct.Q4_0.gguf")#downloads/loadsa4.66GBLLMwithmodel.chat_session():print(model.generate("HowcanIrunLLMsefficientlyonmylaptop?",max_tokens=1024))要使用 GPT4All 包装器,您需要提供预训练模型文件的路径和模型的配置。#下载GPT4All模型并将其放置在您想要的目录中https://www.nomic.ai/gpt4all 模型调用 from langchain_community.llms import GPT4All

# Instantiate the model. Callbacks support token-wise streamingmodel = GPT4All(model="./models/mistral-7b-openorca.Q4_0.gguf", n_threads=8)

# Generate textresponse = model.invoke("Once upon a time, ")

流式调用 from langchain_community.llms import GPT4Allfrom langchain.callbacks.streaming_stdout import StreamingStdOutCallbackHandler

# There are many CallbackHandlers supported, such as# from langchain.callbacks.streamlit import StreamlitCallbackHandler

callbacks = [StreamingStdOutCallbackHandler()]model = GPT4All(model="./models/mistral-7b-openorca.Q4_0.gguf", n_threads=8)

# Generate text. Tokens are streamed through the callback manager.model.invoke("Once upon a time, ", callbacks=callbacks)

想要完整掌握使用方法,可访问GitHub开源地址:https://github.com/nomic-ai/gpt4all ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;letter-spacing: 0.544px;text-wrap: wrap;background-color: rgb(255, 255, 255);">如果对内容有什么疑问和建议可以私信和留言,也可以添加我加入大模型交流群,一起讨论大模型在创作、RAG和agent中的应用。 |