|

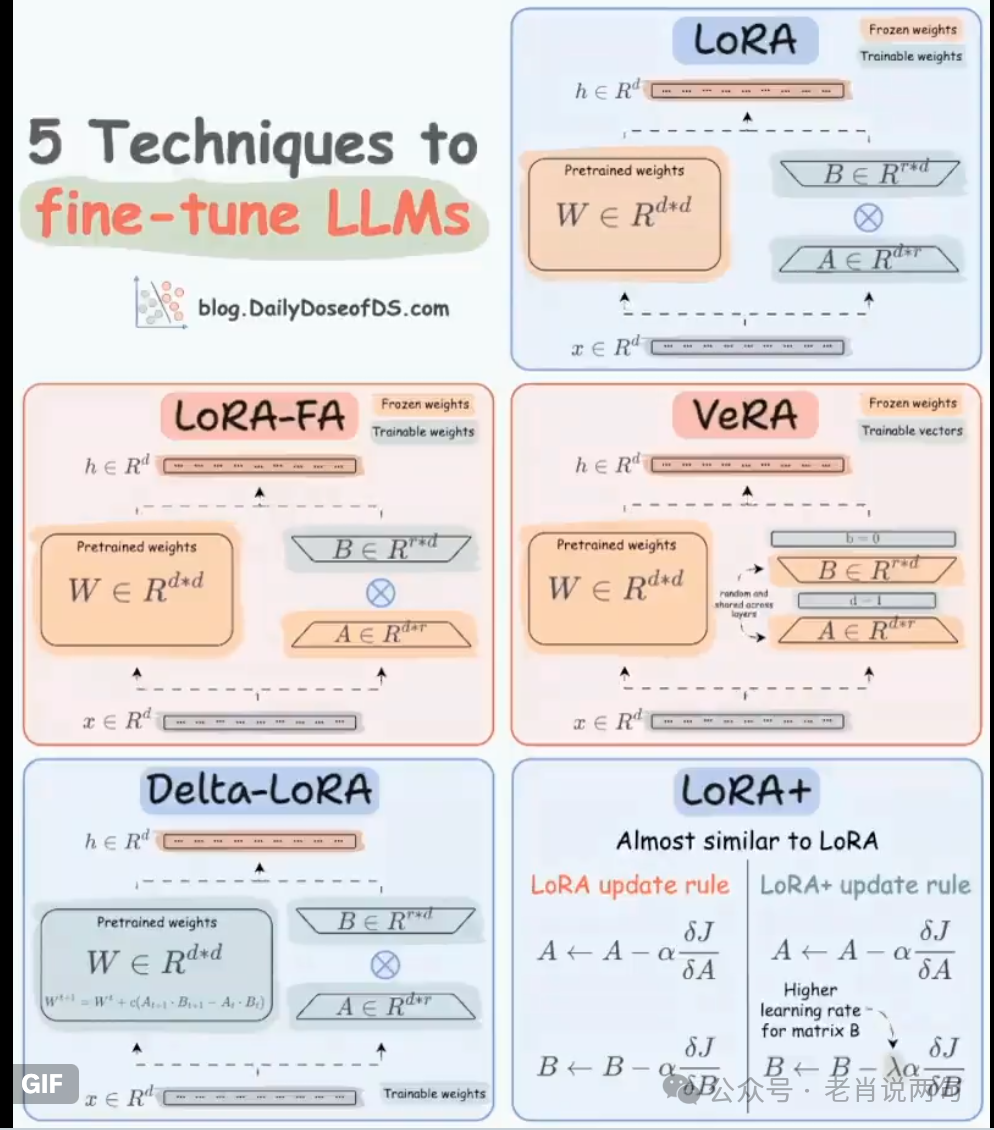

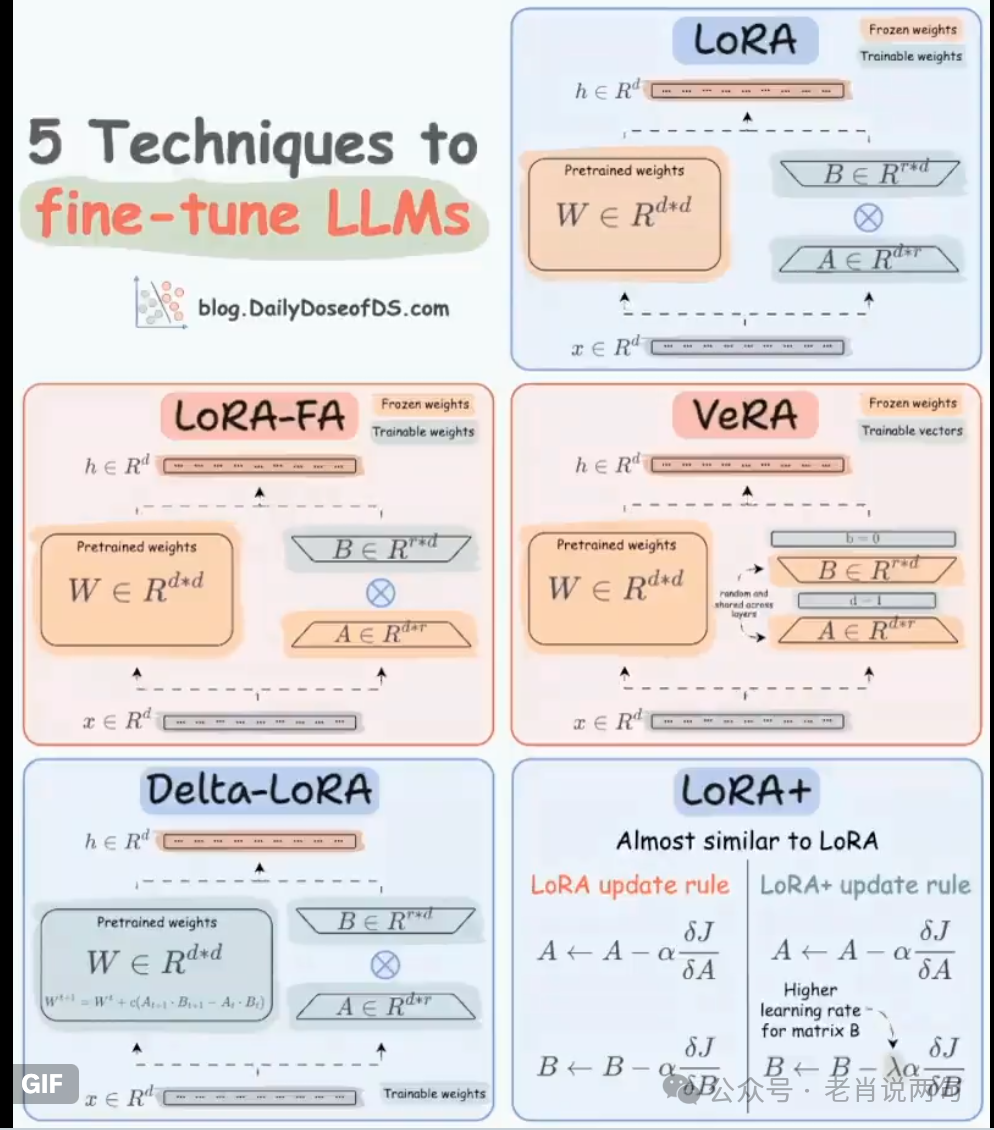

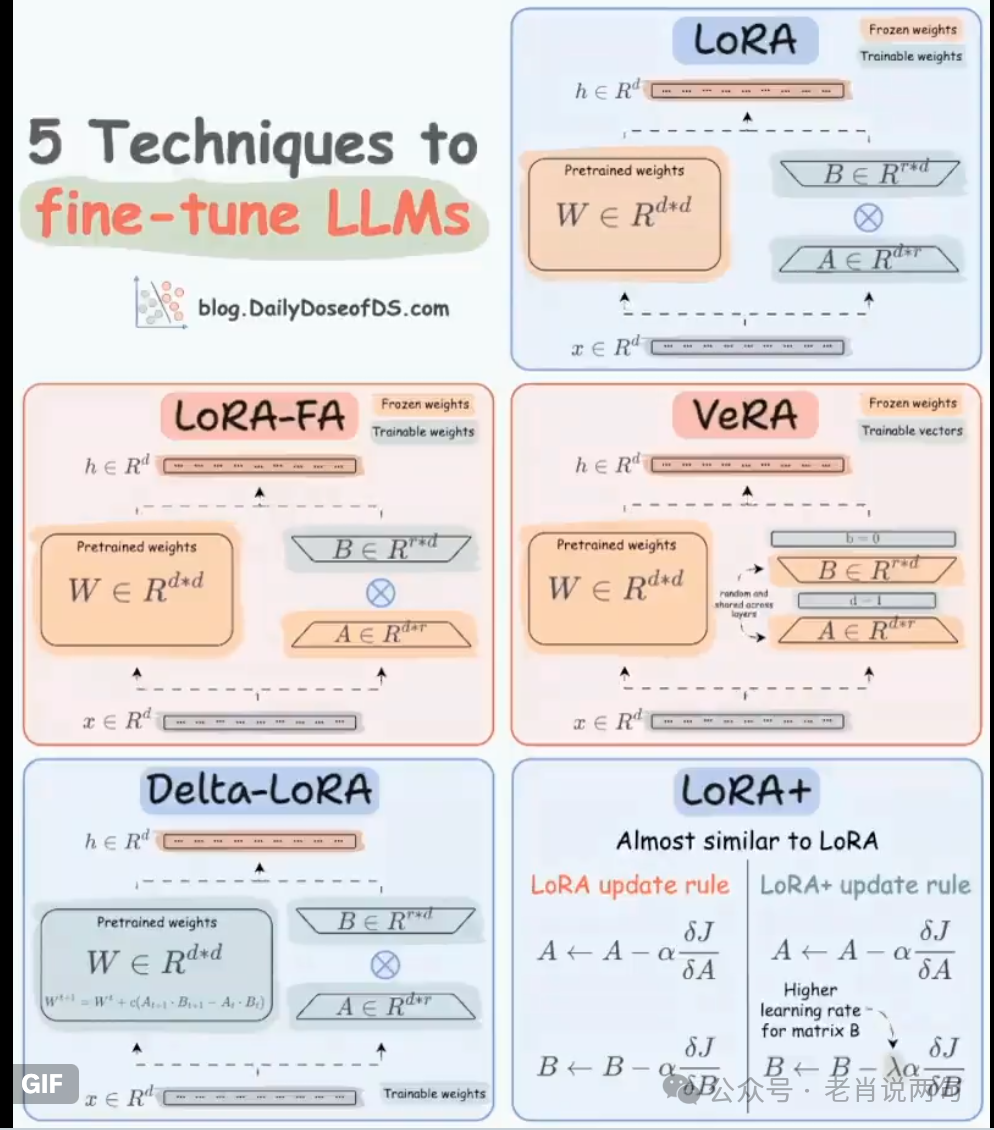

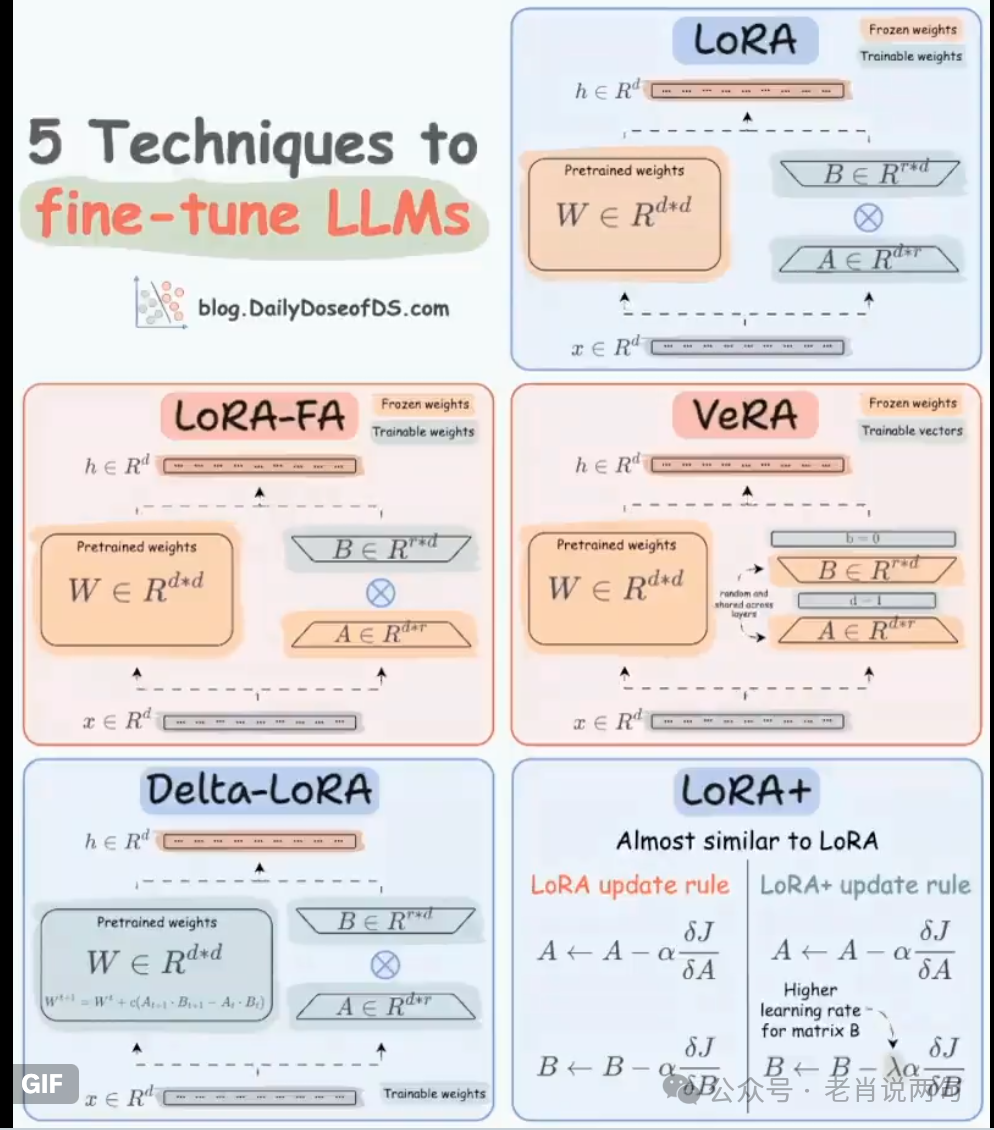

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">在人工智能领域,微调大语言模型(LLMs)一直是提升模型性能的重要手段。传统上,微调LLMs意味着要调整数十亿个参数,这不仅需要强大的计算能力,还需要大量的资源。然而,随着一些创新方法的出现,这一过程已经发生了革命性的变化。ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">今天,我们将通过视觉化的方式,为你介绍五种最新的LLMs微调技术,让你轻松理解这些复杂的技术概念。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;color: rgb(15, 76, 129);">1️⃣ LoRA(低秩适应)ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">LoRA引入了两个低秩矩阵A和B,与主权重矩阵W协同工作。通过调整这两个较小的矩阵,而不是直接调整庞大的矩阵W,微调过程变得更加高效和易于管理。这种方法不仅减少了计算量,还降低了存储需求。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;color: rgb(15, 76, 129);">2️⃣ LoRA-FA(冻结A的LoRA)ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;color: rgb(15, 76, 129);"> ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">LoRA-FA是LoRA的进一步发展,它通过冻结矩阵A来减少计算需求。在这个方法中,只有矩阵B被调整,这不仅降低了激活内存的需求,还保持了模型的稳定性。这种方法特别适用于资源有限的环境。 ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: 16px;letter-spacing: 0.1em;color: rgb(63, 63, 63);">ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;font-size: inherit;color: rgb(15, 76, 129);">LoRA-FA是LoRA的进一步发展,它通过冻结矩阵A来减少计算需求。在这个方法中,只有矩阵B被调整,这不仅降低了激活内存的需求,还保持了模型的稳定性。这种方法特别适用于资源有限的环境。

ingFang SC", "Hiragino Sans GB", "Microsoft YaHei UI", "Microsoft YaHei", Arial, sans-serif;color: rgb(15, 76, 129);">3️⃣ VeRA(向量化的LoRA)

VeRA专注于效率,其核心思想是固定并共享所有层中的矩阵A和B。该方法通过在每一层中使用微小的、可训练的缩放向量来实现微调,这使得它在内存使用上非常友好。VeRA特别适合需要快速微调和低内存消耗的应用场景。

4️⃣ Delta-LoRA(增量LoRA)

Delta-LoRA是LoRA的一个变体,它通过在训练步骤中增加矩阵A和B的乘积之差(增量)到主权重矩阵W中来动态调整参数。这种方法提供了一种动态但受控的参数更新方式,能够在保持模型稳定性的同时实现快速适应。

5️⃣ LoRA+(增强型LoRA)

LoRA+是LoRA的一个优化版本,其中矩阵B被赋予更高的学习率。这种调整使得学习过程更快、更有效。LoRA+特别适用于需要快速收敛和高性能的应用场景。

总结随着这些创新技术的出现,微调大语言模型变得更加高效和可行。LoRA、LoRA-FA、VeRA、Delta-LoRA和LoRA+各自提供了独特的优势,适用于不同的应用场景和资源限制。通过这些方法,研究人员和工程师可以更灵活地调整和优化他们的模型,从而在各种任务中实现更好的性能。

|