|

AI菩萨OpenRouter连发两大招宣布推出两项重大更新。 一个是专为写代码的100k免费模型,另一个则是为所有的模型增加了联网功能,包括免费提供的 类似于deepseek v3这种。 OpenRouter首次推出代号为"Quasar Alpha"的隐秘模型。据官方介绍,这是来自某模型实验室的下一代长上下文基础模型的预发布版本,具有以下特点: - 100万token上下文长度,能处理超长文本

- 专为代码优化,同时保持通用能力

- 完全免费使用

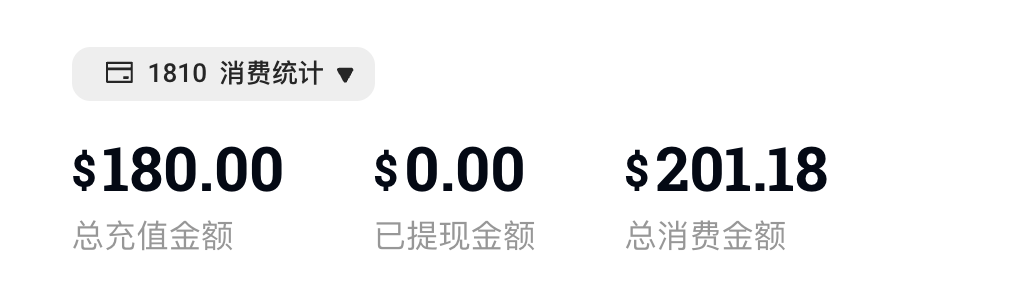

不过,官方表示会记录使用数据并限速,为了收集反馈和防止滥用。 Quasar Alpha是一个提供给社区收集反馈的隐藏模型。本身就是一个功能强大的通用模型,支持长上下文任务,包括代码生成。 使用步骤很简单。 访问openrouter.ai并创建账户。OpenRouter就允许免费使用,当然你可以购买更多积分来使用高级模型,比如Claude3.7,GPT4.5,最最重要的一点是纯官方的体验但是完全不用担心连接和封号问题。 充值的话,我试过国内的普通visa信用卡就行,可以办一张,如果不想办,也可以使用一些虚拟卡直接支持支付宝的充值,比如:https://yeka.ai/i/GPTOPENAI 我使用了大概一年,上面消费了200多刀,还比较稳。

注册后,前往https://openrouter.ai/keys创建API密钥。

OpenRouter提供与OpenAI兼容的API,可以直接调用或使用OpenAI SDK。通过API调用Quasar Alpha模型,可以使用以下格式: {

"model":"openrouter/quasar-alpha",

"messages":[

{"role":"user","content":"你好,请帮我写一个Python函数..."}

]

}如果是在其它客户端使用,按这样来:

使用免费模型变体(ID以:free结尾),则限制为每分钟20个请求,每天200个请求。

这个模型比较擅长代码生成和长上下文任务,各位有这些场景下可以尝试,反正白嫖。 下面是这个是最重要的更新,让OpenRouter家所有的任意的模型支持联网! 后面请求任意的OpenRouter家的模型,都可以开启联网 ,让AI先搜索再根据搜索内容返回,可以构建具有事实依据的AI应用,让AI回答包含来源引用,大大提高了可信度和透明度。 如何使用么?只需要在模型标识后附加 nline nline {

"model":"openai/gpt-4o nline"

} nline"

}以免费的DeepSeek-V3为例子。

配置如下:

配置完成后,直接显示可联网。

测试:

网络搜索插件由Exa提供支持,使用其"auto"方法(关键词搜索和基于嵌入的网络搜索的组合)找到最相关的结果,并增强/支持提示。 {

"message":{

"role":"assistant",

"content":"以下是我找到的最新消息:...",

"annotations":[

{

"type":"url_citation",

"url_citation":{

"url":"https://www.example.com/web-search-result",

"title":"网络搜索结果的标题",

"content":"网络搜索结果的内容",//由OpenRouter添加(如可用)

"start_index":100,//URL引用在消息中的第一个字符的索引

"end_index":200//URL引用在消息中的最后一个字符的索引

}

}

]

}

}自定义Web插件,可以自定义web插件允许的最大结果数和用于将它们附加到消息流的提示: {

"model":"openai/gpt-4o nline",

"plugins":[

{

"id":"web",

"max_results":1,//默认为5

"search_prompt":"一些相关的网络结果:"//查看下面的默认设置

}

]

} nline",

"plugins":[

{

"id":"web",

"max_results":1,//默认为5

"search_prompt":"一些相关的网络结果:"//查看下面的默认设置

}

]

}默认情况下,web插件使用以下搜索提示,使用当前日期: 已于`日期`进行了网络搜索。将以下网络搜索结果纳入您的回复中。重要:使用以源域名命名的markdown链接引用它们。示例:[nytimes.com](https://nytimes.com/some-page)。 最后是定价,web插件使用的OpenRouter积分,收费为每1000个结果4美元。默认情况下,max_results设置为5,这相当于每个请求最多0.02美元,此外还有搜索结果提示令牌的LLM使用费用。 |