Ollama+Chatbox部署法安装Ollama访问官网:打开浏览器,前往Ollama官方网站。页面如下:  下载安装包:- 在官网页面,依据电脑操作系统类型,如Windows、MacOS或Linux,选择对应的安装包进行下载。

点击下面的按钮,这里选择自己的电脑的版本,我这里是windows的  之后就会进行下载了。 当然,如果官网下载比较慢的话,可以通过百度网盘获取 链接:https://pan.baidu.com/s/1970Py8uuLmCLWMozRV0UJw?pwd=chuv提取码: chuv 安装Ollama:下载完成后,双击安装包启动安装程序。按照安装向导的提示逐步完成安装。 验证安装:打开电脑的命令提示符(CMD)或终端,输入“ollama help”并按下回车键。若软件安装成功,将不会显示任何错误信息。 下载DeepSeek模型- 访问Ollama官网模型页面:再次回到Ollama官网。https://ollama.com/search

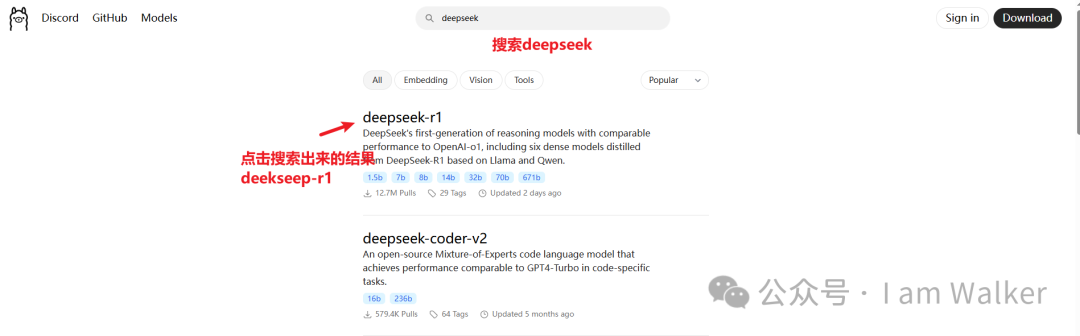

- 搜索Deepseek-r1:在网页上方的搜索框中输入“Deepseek-r1”进行搜索。

- 选择模型规模:点击搜索结果中的Deepseek-r1进入详情界面,根据电脑的硬件配置,参考模型大小配置参考表格,选择合适的模型规模,范围从1.5b到671b。

这里的 “1.5b”“7b” 等中的 “b” 通常代表 “billion”(十亿),指的是模型的参数数量。 参数数量是衡量语言模型规模的一个重要指标,参数越多,模型通常能够学习和表示更复杂的知识和语言模式,但同时对计算资源的需求也更高。以下是不同参数规模对应可能的电脑配置(仅供参考,实际可能因具体应用场景等有所不同): | | | | |

|---|

| 多核高性能 CPU(如 Intel Core i7 及以上或 AMD Ryzen 7 及以上) | 显存 4GB 及以上的中低端 GPU(如 NVIDIA GeForce GTX 1050Ti 等) | | | | 多核高性能 CPU(如 Intel Xeon 系列或 AMD EPYC 系列等) | 显存 8GB 及以上的中高端 GPU(如 NVIDIA GeForce RTX 2070 等) | | | | 多核高性能 CPU(如 Intel Xeon 系列或 AMD EPYC 系列等) | 显存 8 - 12GB 的中高端 GPU(如 NVIDIA GeForce RTX 3070 等) | | | | 多核高性能 CPU(如 Intel Xeon Platinum 系列或 AMD EPYC 7000 系列等) | 显存 16GB 及以上的高端 GPU(如 NVIDIA A10 等) | | | | 多核高性能 CPU(如 Intel Xeon Platinum 系列或 AMD EPYC 7000 系列等) | 显存 32GB 及以上的高端 GPU(如 NVIDIA A100 等) | | | | 多核高性能 CPU(如 Intel Xeon Platinum 系列或 AMD EPYC 7000 系列等) | 多块显存 32GB 及以上的高端 GPU(如多块 NVIDIA A100 等) | | | | | 大规模 GPU 集群(如多组 NVIDIA A100 组成的集群) | | |

- 复制下载命令:在选定的模型规模右侧,复制页面提供的下载命令。

- 下载模型:回到命令提示符窗口或终端,将刚刚复制的命令粘贴到窗口中,然后按下回车键,模型便会开始下载。

在windows搜索命令提示符,  然后执行刚刚复制的:ollama run deepseek-r1:1.5b  等待下载完成即可。  之后就可以进行提问了  配置可视化图文交互界面Chatbox- 访问Chatbox官网:打开浏览器,访问Chatbox官方网站。

- 选择使用方式:Chatbox提供本地客户端和网页版两种使用方式,可按需选择。

不过我们还是选择下载到本地的方式,放在桌面方便我们的使用。 下载成功之后,双击进行安装  选择安装路径,这里忘记截图了。 下一步之后,就安装完成了,点击完成即可。  如果下载比较慢的话,可以从百度链接获取 通过网盘分享的文件:Chatbox-1.9.1-Setup.exe 链接:https://pan.baidu.com/s/1ldrrMsjHiY_GHilkzMdOIw?pwd=4db4提取码: 4db4

- 选择模型提供方:在Chatbox中,点击“使用自己的API Key或本地模型”,进入模型提供方选择界面后,选择“Ollama API”。

- 配置Ollama远程链接:根据Chatbox提供的教程进行配置,对于Windows操作系统,通常需要配置环境变量并重启Ollama程序。

选择DeepSeek模型:重启Ollama程序后,关闭并重新打开Chatbox设置界面,在设置界面中选择DeepSeek模型,然后点击保存。 新建对话并使用模型:在Chatbox中新建对话,即可开始使用DeepSeek模型。

|